VTformer: L’IA che Prevede il Futuro Guardando Tempo e Variabili Insieme!

Ragazzi, diciamocelo, prevedere il futuro è il sogno di tutti, no? Che si tratti del meteo, del traffico, dei mercati finanziari o persino della diffusione di una malattia, sapere cosa succederà dopo è fondamentale. Nel mondo dei dati, questo si traduce nella sfida della previsione di serie storiche multivariate (MTSF). In pratica, abbiamo un sacco di variabili che cambiano nel tempo (come temperatura, umidità, pressione per il meteo, o diversi sensori del traffico) e vogliamo prevedere come si comporteranno in futuro.

Negli ultimi anni, l’intelligenza artificiale, e in particolare i modelli Transformer, hanno fatto faville in questo campo. Nati per capire il linguaggio umano, si sono rivelati bravissimi a gestire sequenze di dati, cogliendo dipendenze a lungo termine che altri modelli faticavano a vedere. Sembrava la soluzione perfetta, vero?

Il Problema: Non è Tutto Oro Quello che Luccica

E invece no, o almeno, non del tutto. Recentemente, alcuni ricercatori hanno iniziato a sollevare dubbi. “Ma siamo sicuri che questi Transformer complessi siano davvero meglio di un semplice modello lineare?”, si sono chiesti. E in effetti, a volte modelli più semplici ottenevano risultati simili o persino migliori, con molta meno fatica computazionale!

Il punto debole? Molti Transformer si concentravano troppo sulla dimensione temporale, guardando come ogni “fotogramma” di dati si collega a quelli passati e futuri, ma trascurando un po’ le correlazioni tra le diverse variabili all’interno dello stesso “fotogramma”. Immaginate di prevedere il traffico guardando solo la sequenza di auto che passano da un sensore, senza considerare cosa succede contemporaneamente sugli altri sensori della città. Si perde un pezzo importante del puzzle!

Inoltre, per gestire la complessità computazionale (i Transformer “puri” sono pesantucci), spesso si riduceva la quantità di informazioni utilizzate, limitando la capacità del modello di capire veramente le dinamiche complesse e generalizzare a situazioni diverse. Soprattutto nelle previsioni a lungo termine, la faccenda si complicava parecchio.

La Soluzione: Ecco a Voi VTformer!

Ed è qui che entro in gioco io… o meglio, entra in gioco VTformer, un nuovo approccio che abbiamo sviluppato proprio per affrontare questi problemi. L’idea di base è semplice ma potente: perché scegliere tra guardare il tempo e guardare le variabili, quando possiamo fare entrambe le cose in parallelo?

VTformer è un Transformer “leggero” progettato specificamente per le serie storiche multivariate. Mantiene la struttura base del Transformer classico (l’encoder, per i più tecnici), ma la sdoppia.

Ecco come funziona a grandi linee:

- Due Occhi sono Meglio di Uno: Prendiamo i dati di input e li “guardiamo” da due prospettive diverse fin dall’inizio. Una branca del modello si concentra sulle dipendenze temporali (come cambiano i dati nel tempo), l’altra sulle correlazioni tra le variabili (come le diverse misurazioni si influenzano a vicenda in ogni istante).

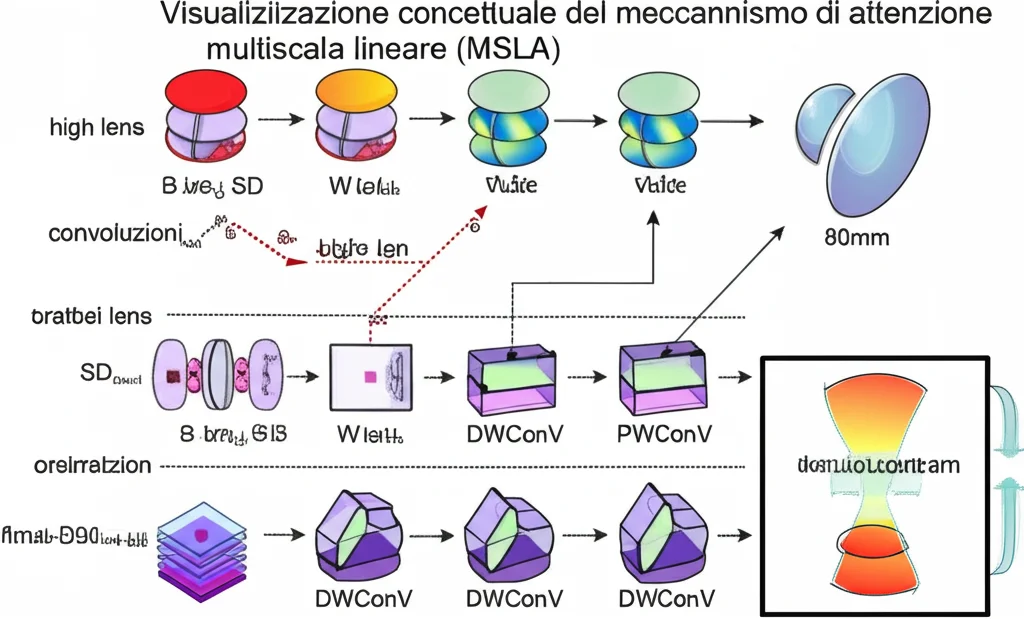

- Attenzione Intelligente e Leggera (MSLA): Invece del classico meccanismo di attenzione “multi-head” (MHA), che può essere computazionalmente costoso (complessità quadratica, O(T²)), usiamo una nuova Attenzione Lineare Multiscala (MSLA) potenziata da convoluzioni. Cosa significa in parole povere? È molto più efficiente (complessità lineare, O(T+D)), richiede meno memoria e riesce a catturare pattern a diverse “scale” temporali e tra variabili, un po’ come usare zoom diversi per cogliere sia i dettagli che il quadro generale. Utilizza convoluzioni specifiche (DWConv e PWConv) che sono brave a estrarre caratteristiche locali e a integrarle, rispettivamente.

- Fusione Adattiva: Una volta che le due branche hanno “studiato” i dati dalle loro prospettive, non basta sommare i risultati. Abbiamo progettato un meccanismo di fusione adattiva che impara a pesare e combinare le informazioni provenienti dalla branca temporale e da quella delle variabili nel modo più efficace possibile, riconoscendo che a seconda della situazione una prospettiva può essere più importante dell’altra.

Alla Prova dei Fatti: VTformer Batte la Concorrenza

Bello sulla carta, ma funziona? Eccome! Abbiamo messo VTformer alla prova su ben otto dataset pubblici reali, che coprono scenari diversissimi: consumo elettrico (Electricity), traffico (Traffic, PEMS), meteo (Weather), tassi di cambio (Exchange), dati sull’influenza (ILI), energia solare (Solar-Energy) e dati meteorologici specifici (ETTh1, ETTm2).

Lo abbiamo confrontato con i pezzi da novanta del settore: altri Transformer (Autoformer, Informer, FEDformer, Crossformer, PatchTST, iTransformer), modelli basati su reti convoluzionali (TimesNet, MICN) e persino modelli lineari potenziati (DLinear).

I risultati parlano chiaro: VTformer ha ottenuto prestazioni stato dell’arte (SOTA) nella maggior parte dei casi, specialmente nelle previsioni a lungo termine. In media, ha migliorato le performance (misurate con MSE, Mean Squared Error) del 6.8% rispetto ai migliori concorrenti, e in alcuni casi specifici (come sul dataset ILI) il miglioramento è stato stratosferico (oltre il 60%!).

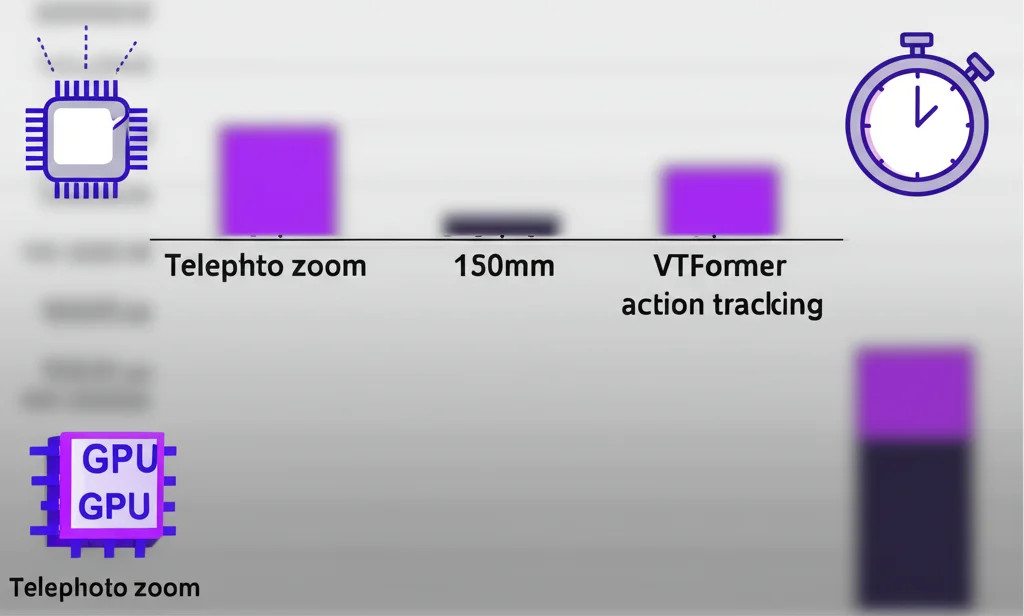

Non solo è più accurato, ma è anche efficiente! Grazie all’attenzione lineare MSLA, VTformer richiede meno risorse computazionali (tempo di addestramento, memoria GPU, numero di parametri) rispetto a molti altri Transformer, avvicinandosi all’efficienza dei modelli non lineari più semplici ma superandoli in accuratezza. Abbiamo anche verificato che è robusto: anche aggiungendo un po’ di “rumore” ai dati (cosa che succede spesso nel mondo reale), le sue prestazioni calano pochissimo.

Le analisi che abbiamo fatto (studi di ablazione) confermano che ogni pezzo di VTformer è importante: imparare sia le dipendenze temporali che quelle tra variabili è cruciale, l’attenzione MSLA è più efficace della MHA classica in questo contesto, e la fusione adattiva funziona meglio di una semplice somma o di un FFN.

Perché VTformer è Importante?

Questo lavoro dimostra che i Transformer hanno ancora molto da dire nel campo delle previsioni temporali, ma bisogna ripensare a come usarli. Concentrarsi solo sul tempo non basta quando le variabili interagiscono in modi complessi. VTformer offre un approccio bilanciato ed efficiente che cattura entrambe le dinamiche.

Questo si traduce in previsioni più affidabili in tantissimi campi:

- Migliore gestione delle reti elettriche

- Pianificazione del traffico più efficace

- Previsioni meteorologiche più precise

- Strategie finanziarie più informate

- Monitoraggio sanitario e prevenzione più tempestivi

Insomma, VTformer è un passo avanti significativo per rendere le previsioni basate sull’IA più accurate, efficienti e utili nella pratica. È la dimostrazione che, a volte, guardare le cose da due prospettive contemporaneamente è la chiave per capire davvero come funziona il mondo (o almeno, una piccola parte di esso che vogliamo prevedere!). E noi siamo solo all’inizio, chissà quali altre applicazioni potremo trovare per questo approccio!

Fonte: Springer