Trackformers: Sveliamo i Segreti delle Particelle nell’Era HL-LHC con l’IA!

Ciao a tutti! Oggi voglio portarvi nel cuore pulsante della fisica delle particelle, un mondo affascinante dove cerchiamo di capire i mattoncini fondamentali dell’universo. In particolare, vi parlerò di una sfida enorme che ci aspetta con l’aggiornamento High-Luminosity LHC (HL-LHC) al CERN e di come l’intelligenza artificiale, nello specifico i modelli Transformer, ci sta dando una mano incredibile. Immaginatevi di essere detective cosmici: questo è un po’ quello che facciamo!

La Sfida del Tracciamento nell’Era HL-LHC

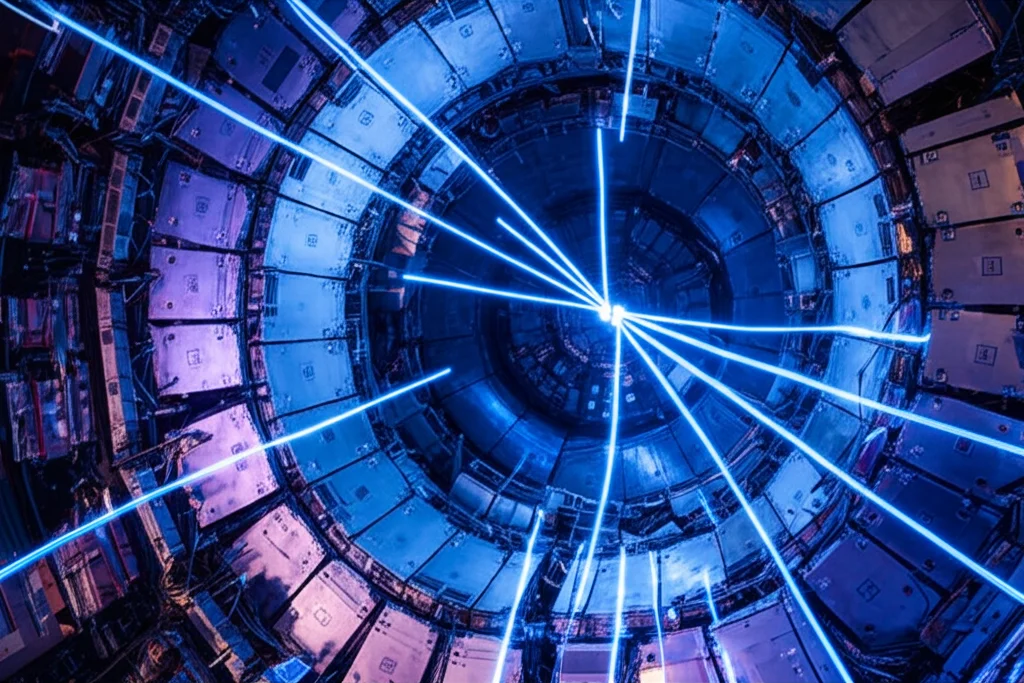

Avete presente l’LHC, il Large Hadron Collider? È quella macchina pazzesca che fa scontrare particelle a velocità prossime a quelle della luce. Bene, sta per ricevere un super-potenziamento, diventando l’HL-LHC. Questo significa una cosa: una valanga di dati! Molti, molti più dati di prima. E qui casca l’asino, o meglio, qui entra in gioco la nostra sfida: il tracciamento delle particelle (in gergo, tracking).

Ma cos’è il tracking? Immaginate che dopo ogni collisione nasca una miriade di nuove particelle. Queste particelle sfrecciano attraverso dei rivelatori super sofisticati, lasciando delle “impronte” digitali, chiamate hit. Il nostro compito è collegare questi puntini, questi hit, per ricostruire la traiettoria (la traccia) di ogni singola particella. È un po’ come giocare a “unisci i puntini”, ma in 3D, con migliaia di puntini generati in una frazione di secondo e con tantissime traiettorie che si sovrappongono!

I metodi tradizionali, come il filtro di Kalman, sono stati fantastici finora, ma con l’HL-LHC rischiano di andare in tilt. Il problema è che la complessità del calcolo cresce in modo quadratico con il numero di particelle: più particelle ci sono, più il tempo necessario per ricostruire le tracce esplode. Serve qualcosa di nuovo, qualcosa di più veloce e intelligente.

L’Intelligenza Artificiale Scende in Campo: Arrivano i Transformer!

Ed è qui che entra in gioco l’Intelligenza Artificiale (IA) e, in particolare, una famiglia di modelli che sta facendo faville nel campo del linguaggio: i Transformer. Sì, proprio quelli alla base di modelli come ChatGPT! Ci siamo chiesti: se i Transformer sono così bravi a capire le relazioni tra le parole in una frase, potrebbero essere altrettanto bravi a capire le relazioni tra gli hit di una particella lungo la sua traccia?

L’idea è affascinante: trattare la sequenza di hit come se fosse una “frase” scritta dalla particella stessa. Abbiamo quindi iniziato a esplorare questa strada, prendendo ispirazione dai modelli linguistici (Large Language Models, LLM). Abbiamo pensato a due approcci principali:

- Prevedere il prossimo “hit” della traccia, un po’ come un LLM prevede la prossima parola.

- Identificare tutti gli hit appartenenti a tutte le tracce in un colpo solo, come se stessimo “traducendo” l’intera nuvola di hit in un insieme di tracce distinte.

Non ci siamo fermati ai Transformer. Abbiamo anche esplorato un’altra architettura molto usata nell’analisi di immagini, la U-Net, pensando al problema come a una sorta di “segmentazione” dello spazio del rivelatore per isolare le diverse tracce.

I Nostri “Campioni” di IA: Quattro Modelli a Confronto

Abbiamo messo a punto e testato quattro diversi design di modelli:

1. Encoder-Decoder (EncDec): Un Transformer “classico”, simile a quelli usati per la traduzione automatica. Lavora in modo autoregressivo: dato un pezzetto di traccia, prova a indovinare l’hit successivo. Molto preciso nel suo compito specifico, ma potenzialmente lento perché deve fare un’inferenza per ogni hit.

2. Encoder-Classifier (EncCla): Un Transformer più snello, basato solo sulla parte “encoder”. L’idea qui è rivoluzionaria per il tracking: prende tutti gli hit di un evento in un colpo solo e assegna a ciascuno un’etichetta che lo associa a una specifica traccia candidata. Una sorta di “traduzione istantanea” da hit a tracce. Super veloce!

3. Encoder-Regressor (EncReg): Simile al precedente, ma invece di classificare gli hit, cerca di stimare direttamente i parametri della traccia a cui ogni hit appartiene (come la curvatura, l’angolo, ecc.). Poi, un algoritmo di clustering raggruppa gli hit con parametri simili. Concettualmente ricorda la Trasformata di Hough, una tecnica classica dell’elaborazione di immagini. Anch’esso molto veloce.

4. Sparse U-Net: Un modello basato su reti convoluzionali (quelle usate per le immagini), ma adattato per lavorare su dati “sparsi” come i nostri hit (ci sono tanti punti vuoti nel rivelatore). L’idea è trattare l’evento come un’immagine 3D e “colorare” i pixel (gli hit) in base alla traccia a cui appartengono.

La Prova del Nove: Dati Simulati e Risultati

Come abbiamo testato questi modelli? Non potevamo usare l’HL-LHC (non è ancora pronto!), quindi abbiamo usato dati simulati. Abbiamo iniziato con simulazioni semplici (poche tracce lineari o elicoidali) generate con un nostro strumento chiamato REDVID, per poi passare a dati più complessi, derivati dal famoso dataset della competizione TrackML, che simula più realisticamente le condizioni dell’HL-LHC (fino a 500 tracce per evento!). Questo approccio “a complessità crescente” ci ha permesso di valutare i modelli passo dopo passo, scartando subito quelli meno promettenti.

Abbiamo misurato due cose fondamentali:

- Accuratezza: Quanto bene i modelli ricostruiscono le tracce correttamente? Abbiamo usato una metrica chiamata FitAccuracy, molto simile a quella ufficiale della TrackML.

- Velocità: Quanto tempo impiega il modello a processare un singolo evento? Abbiamo misurato sia il tempo di calcolo sulla CPU che quello sulla GPU (le schede grafiche super potenti usate per l’IA).

Il Verdetto: Velocità e Precisione Sorprendenti!

I risultati sono stati davvero incoraggianti!

* L’EncDec, pur essendo bravo a prevedere il prossimo hit, si è rivelato troppo lento per ricostruire eventi complessi, a causa della sua natura “un hit alla volta”.

* La Sparse U-Net ha funzionato bene sui dati più semplici, ma ha faticato con l’aumentare della complessità e richiede una preparazione dei dati (preprocessing) un po’ macchinosa.

* I veri campioni sono stati i modelli “one-shot” basati su Transformer: EncCla ed EncReg! Entrambi si sono dimostrati molto veloci e accurati anche sui dataset più complessi derivati da TrackML. L’EncCla, in particolare, è risultato il più veloce in assoluto, processando un evento complesso (fino a 500 tracce, circa 10.000 hit) in una manciata di millisecondi (stimiamo tra 3 e 6 ms)!

Questo è un risultato pazzesco! Pensate che i metodi tradizionali, anche ottimizzati, impiegano secondi per processare un evento simile. Stiamo parlando di un potenziale miglioramento della velocità di ordini di grandezza! Questo dimostra che un approccio basato su Transformer, che processa tutti gli hit in un colpo solo, è non solo fattibile, ma estremamente promettente per l’era HL-LHC.

Perché Tutto Questo è Importante?

Questi risultati aprono scenari incredibili. Avere algoritmi di tracking così veloci ed efficienti è cruciale per poter analizzare l’enorme mole di dati dell’HL-LHC. Significa poter selezionare eventi interessanti in tempo reale, scoprire nuove particelle o fenomeni rari che altrimenti andrebbero persi nel rumore di fondo. È come dare ai fisici degli occhiali molto più potenti per scrutare nei segreti più profondi della materia.

La Strada è Tracciata: Cosa Ci Aspetta?

Certo, il lavoro non è finito. I modelli EncCla ed EncReg sono un punto di partenza fantastico, ma possiamo migliorarli ancora. La prossima sfida è testarli su dati ancora più complessi, che si avvicinino il più possibile alla realtà dell’HL-LHC.

Pensiamo anche a come integrare questi modelli con passi aggiuntivi:

- Pre-processing: Magari usare un modello per creare dei “cluster” iniziali di hit da dare in pasto al classificatore.

- Post-processing: Usare altri modelli (magari proprio l’EncDec!) per rifinire le tracce trovate, aggiungere hit mancanti o eliminare quelli sbagliati. Potremmo anche sfruttare il fatto che l’EncCla non dà solo una risposta secca, ma una probabilità per ogni possibile traccia, permettendo analisi più sofisticate.

- Modelli più efficienti: Esplorare varianti dei Transformer ancora più veloci e leggere.

Insomma, la ricerca continua! Ma la strada indicata dai “Trackformers” sembra davvero quella giusta. Abbiamo dimostrato che l’approccio “one-shot” ispirato ai modelli linguistici è una scommessa vincente per affrontare una delle sfide computazionali più grandi della fisica moderna. È emozionante essere parte di questa avventura, dove l’intelligenza artificiale ci aiuta a spingere i confini della conoscenza!

Fonte: Springer