Parla al Tuo Drone: Ecco Come Gli Ho Insegnato a Tracciare Oggetti in Tempo Reale!

Avete mai sognato di poter semplicemente dire a un drone: “Ehi, segui quella macchina rossa!” e vederlo obbedire all’istante, seguendola agilmente nel traffico? Beh, quel futuro è molto più vicino di quanto pensiate, e lasciate che vi racconti come ci stiamo arrivando! Nel mio campo, quello del tracciamento di oggetti tramite droni (UAV), la sfida è sempre stata quella di rendere questi occhi volanti non solo autonomi, ma anche intelligenti e capaci di interagire con noi in modo naturale.

Il Vecchio Metodo: Due Passi Indietro?

Tradizionalmente, per far tracciare un oggetto a un drone, si doveva prima indicarglielo manualmente nel primo fotogramma (il cosiddetto “bounding box”). Poi, un algoritmo di tracciamento cercava di mantenerlo a fuoco nei fotogrammi successivi. Più recentemente, si è iniziato a usare il linguaggio naturale, ma spesso il processo era diviso in due fasi nette:

- Visual Grounding: Capire a cosa si riferisce la descrizione testuale (“macchina rossa”) nel primo fotogramma.

- Object Tracking: Una volta identificato, seguire l’oggetto basandosi solo sull’aspetto visivo iniziale.

Questo approccio “a compartimenti stagni”, però, ha dei limiti. Primo, ignora il fatto che la descrizione linguistica (“macchina rossa *veloce* che sta svoltando a destra”) contiene informazioni preziose che potrebbero essere utili *durante* tutto il tracciamento, non solo all’inizio. Secondo, rende difficile addestrare il sistema in modo integrato (“end-to-end”), ottimizzando tutto il processo insieme. Era come avere due specialisti che non si parlavano abbastanza.

La Svolta: Unificare Linguaggio e Visione con TCMLTrack

Ecco dove entra in gioco la nostra idea, che abbiamo chiamato TCMLTrack. Abbiamo pensato: perché non ridefinire il problema come un’unica sfida? L’obiettivo è tracciare un oggetto basandosi su una descrizione in linguaggio naturale, punto. Niente più separazioni artificiali.

Il cuore del nostro sistema è quella che abbiamo chiamato “integrazione triangolare“. Immaginate un triangolo dove i vertici sono:

- La descrizione in linguaggio naturale (es. “l’uomo con la maglietta blu”).

- L’immagine “modello” (il primo fotogramma o un riferimento precedente dell’oggetto).

- L’immagine “di ricerca” (il fotogramma attuale dove il drone deve trovare l’oggetto).

Il nostro metodo crea connessioni forti tra questi tre elementi, permettendo al sistema di usare *contemporaneamente* le informazioni linguistiche e quelle visive (sia passate che presenti) per capire cosa sta succedendo e dove si trova il target. Questo rende il tracciamento molto più robusto e flessibile.

L’Asso nella Manica: Attenzione Multi-Scala Concentrata e Lineare (CMLatten)

Ma non basta collegare le informazioni. Bisogna anche che il sistema sappia *dove guardare* e come interpretare ciò che vede, specialmente quando l’oggetto cambia dimensione, viene parzialmente coperto o si muove velocemente. Qui entra in gioco il secondo pilastro della nostra innovazione: un nuovo meccanismo di attenzione chiamato CMLatten (Concentrated Multi-scale Linear Attention).

I meccanismi di “attenzione” nei modelli di intelligenza artificiale aiutano il sistema a focalizzarsi sulle parti più importanti dell’input. Quelli tradizionali (come “softmax attention”) sono potenti ma computazionalmente costosi, specialmente con le immagini ad alta risoluzione dei droni. Altri, come l'”attenzione lineare”, sono più veloci ma tendono ad essere un po’ “miopi”, faticando a catturare dettagli fini o a mantenere una messa a fuoco nitida sul target.

Il nostro CMLatten cerca di prendere il meglio dei due mondi:

- È lineare, quindi computazionalmente leggero (fondamentale per il tempo reale sui droni!).

- È multi-scala: aggrega informazioni a diverse “risoluzioni” per capire sia i dettagli fini che il contesto generale.

- È concentrato: abbiamo introdotto una funzione matematica che aiuta l’attenzione a “mettere a fuoco” meglio le caratteristiche simili e a ignorare quelle dissimili, un po’ come fa l’attenzione softmax ma senza il costo computazionale.

- Ha un campo recettivo globale: può considerare l’intera immagine, non solo piccole finestre, per non perdere di vista il target.

In più, per limare ulteriormente i tempi di calcolo, abbiamo introdotto l’uso di “residui” (residuals), una tecnica che permette di ottimizzare parti del modello in modo più efficiente.

Alla Prova dei Fatti: Risultati Che Parlano Chiaro

Naturalmente, le belle idee devono essere validate. Abbiamo messo alla prova TCMLTrack su ben sei dataset standard per il tracciamento UAV (come UAV123, DTB70, VisDrone2018) e due dataset generali (LaSOT, GOT-10K). Questi dataset contengono migliaia di video con tutte le sfide tipiche del mondo reale: oggetti che cambiano dimensione, vengono nascosti (occlusioni), si muovono velocemente, sfondi complessi, bassa risoluzione, cambi di prospettiva.

I risultati? Siamo stati entusiasti! TCMLTrack ha superato molti dei tracker allo stato dell’arte (SOTA) attualmente disponibili. In media, abbiamo raggiunto:

- Precisione (Pre): 0.819 (significa che nell’81.9% dei fotogrammi il centro del nostro riquadro era molto vicino al centro reale dell’oggetto).

- Tasso di Successo (Suc): 0.654 (basato sull’area di sovrapposizione tra il nostro riquadro e quello reale, un valore molto buono).

- Velocità media: 61 FPS (fotogrammi al secondo) su una GPU NVIDIA Titan RTX. Questo è cruciale per applicazioni in tempo reale!

Ad esempio, sul dataset UAV123, abbiamo ottenuto la migliore precisione (82.2%) e il miglior tasso di successo (62.1%). Su DTB70, abbiamo superato il secondo classificato di 2 punti percentuali in precisione e ben 4.6 punti nel successo. Questo dimostra che la nostra CMLatten gestisce particolarmente bene i cambi di punto di vista frequenti in quel dataset. Anche su sequenze lunghe (UAV20L, UAVTrack112L), dove è facile perdere il target, TCMLTrack ha mostrato grande robustezza, mantenendo il tracciamento grazie alla capacità di aggiornare la “comprensione” dell’oggetto usando anche la descrizione linguistica iniziale.

Vedere per Credere: TCMLTrack in Azione

Al di là dei numeri, abbiamo analizzato qualitativamente come si comporta TCMLTrack in situazioni difficili. Abbiamo confrontato le sue performance visivamente con altri tracker SOTA. In scenari con rapide variazioni di scala, occlusioni parziali, sfondi caotici o movimenti bruschi, TCMLTrack ha dimostrato una stabilità e una precisione notevoli. Mentre altri tracker magari “perdevano” l’oggetto o diventavano incerti, il nostro sistema riusciva a mantenere un aggancio solido.

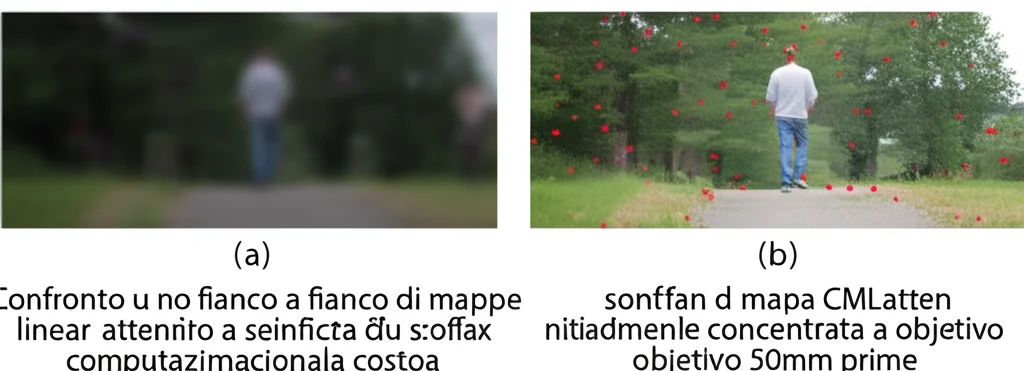

Abbiamo anche visualizzato le “mappe di attenzione” generate da CMLatten rispetto a quelle di softmax e linear attention. È evidente come il nostro metodo riesca a mantenere il “focus” sull’oggetto tracciato, mentre l’attenzione lineare tende a disperdersi e quella softmax, pur focalizzata, ha i noti limiti di costo. CMLatten riesce a concentrarsi sul target, ignorando le distrazioni dello sfondo, proprio grazie alla combinazione di concentrazione e capacità multi-scala.

Sotto il Cofano: Perché Ogni Pezzo Conta

Per essere sicuri che ogni parte del nostro sistema contribuisse davvero, abbiamo condotto degli “studi di ablazione”. In pratica, abbiamo provato a togliere o modificare singolarmente i componenti chiave (l’integrazione triangolare, CMLatten, i residui) per vedere l’impatto sulle performance.

I risultati hanno confermato le nostre ipotesi:

- L’integrazione triangolare è fondamentale: considerare insieme linguaggio, template e immagine di ricerca migliora significativamente l’accuratezza rispetto a usare solo coppie di queste informazioni.

- CMLatten fa la differenza: la sua capacità multi-scala e globale porta a miglioramenti tangibili. La funzione di “concentrazione” da sola ha aumentato l’accuratezza di 2.7 punti! Abbiamo anche visto che è robusta alla scelta esatta del parametro ‘p’ della funzione. Confrontata con altre attenzioni “efficienti”, CMLatten ha mostrato prestazioni superiori.

- I residui aiutano: contribuiscono a migliorare le performance, specialmente nell’ottimizzare le caratteristiche legate al linguaggio e nel ridurre il carico computazionale durante l’addestramento/inferenza.

Sfide Aperte e Prossimi Passi

Siamo molto soddisfatti di TCMLTrack, ma come in ogni ricerca, ci sono sempre margini di miglioramento e nuove sfide. Una limitazione intrinseca dei metodi basati sul linguaggio è l’ambiguità. Se dico al drone “segui la pecora nel prato” e ce ne sono tante, il sistema potrebbe scegliere quella sbagliata all’inizio. Attualmente, la soluzione migliore è fornire descrizioni più precise (“la pecora nera vicino all’albero”) o usare un bounding box iniziale per disambiguare. Stiamo lavorando per rendere il modello più bravo a gestire queste ambiguità magari sfruttando meglio il contesto.

Un’altra sfida è il costo computazionale. Sebbene CMLatten sia efficiente, tracciare oggetti in video ad altissima risoluzione o in scene con molti target contemporaneamente può ancora essere pesante. Stiamo esplorando tecniche come il pruning (rimuovere parti non essenziali del modello) o la quantizzazione (usare numeri meno precisi per i calcoli) per alleggerire ulteriormente il carico.

Infine, l’integrazione con tecnologie emergenti come l’edge computing e lo SLAM (Simultaneous Localization and Mapping) visuale-inerziale multi-robot potrebbe aprire scenari applicativi ancora più complessi e affascinanti, migliorando la robustezza e l’adattabilità in ambienti difficili.

In conclusione, con TCMLTrack abbiamo fatto un passo avanti significativo verso droni che non solo vedono, ma *capiscono* le nostre istruzioni verbali per interagire con il mondo in modo più intelligente ed efficiente. È un campo in rapidissima evoluzione, e non vediamo l’ora di mostrarvi cosa riusciremo a fare dopo!

Fonte: Springer