Analisi dei Materiali: Più Veloci, Più Intelligenti con la Selezione Mirata dei Dati

Ciao a tutti! Oggi voglio parlarvi di una sfida che conosco bene, una di quelle che ti fanno sudare freddo in laboratorio: caratterizzare nuovi materiali. Ogni volta che mettiamo a punto una nuova lega metallica, magari super performante e sostenibile, dobbiamo capire esattamente com’è fatta e come si comporterà. E qui casca l’asino, perché le tecniche standard, come la diffrazione a raggi X (XRD), richiedono un sacco di tempo. Tempo prezioso che potremmo usare per fare nuove scoperte!

Perché tutta questa fretta? La sfida dei nuovi materiali

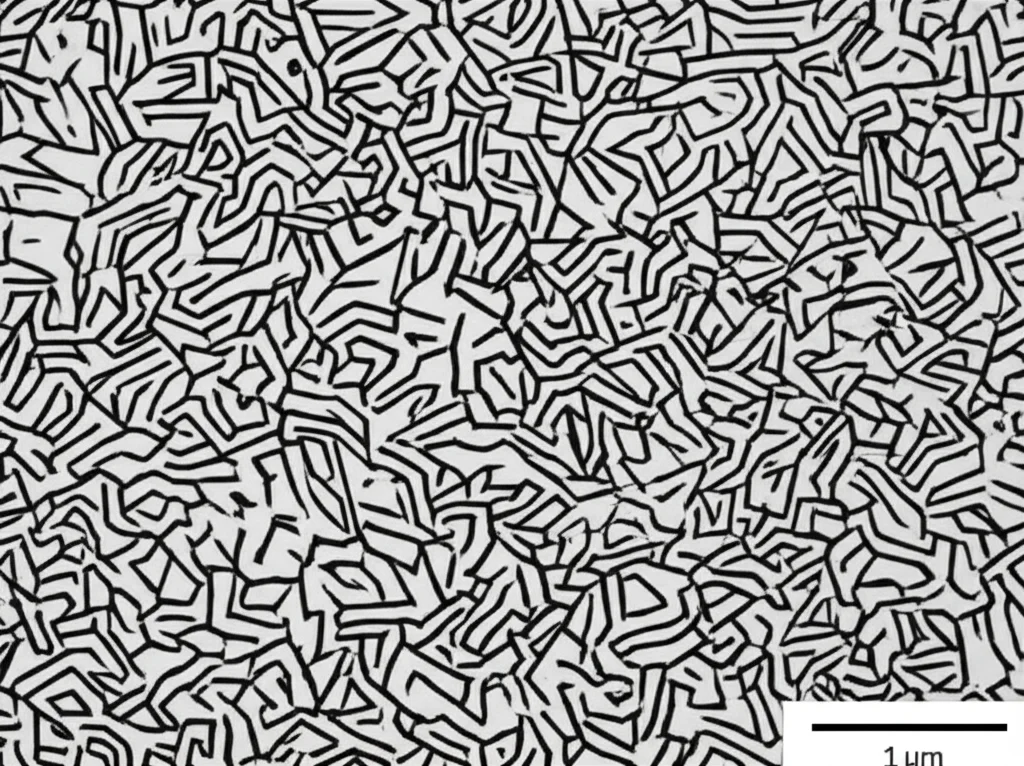

Pensateci un attimo: siamo in un’epoca in cui la sostenibilità e l’efficienza sono cruciali. Dobbiamo sviluppare materiali più leggeri e resistenti, ad esempio per le auto (meno peso = meno emissioni di (CO_{2})), o per processi innovativi come la stampa 3D di metalli. Prendiamo gli acciai QP (Quench and Partitioning): sono fantastici perché combinano alta resistenza e buona duttilità grazie a una microstruttura complessa, dove l’austenite metastabile si trasforma in martensite sotto sforzo (il famoso effetto TRIP). Capire a fondo questi meccanismi richiede analisi dettagliate: mappe di deformazione, analisi delle fasi, misura delle tensioni residue… insomma, un lavoro enorme! E se vogliamo progettare componenti con proprietà specifiche in punti diversi (come nella manifattura additiva), l’efficienza delle analisi diventa ancora più critica.

Il metodo classico: sicuro ma… lento come una lumaca!

Tradizionalmente, quando facciamo un’analisi XRD, cosa facciamo? Per essere sicuri di non perderci nulla, misuriamo *tutto* l’intervallo possibile, punto per punto. Più punti misuriamo, più tempo impieghiamo, più accurati (in teoria) dovremmo essere. Il problema è che se il tempo di misura per ogni punto è troppo breve, il segnale è debole, pieno di “rumore”, e l’analisi successiva diventa un incubo, se non impossibile. Allora che si fa? Si ripete tutto, aumentando *significativamente* il tempo di misura. Un approccio “prendi tutto” che però è terribilmente inefficiente. Sprechiamo ore a misurare zone che magari non aggiungono nessuna informazione utile alla nostra analisi finale. Non sarebbe fantastico poter concentrare i nostri sforzi solo dove serve davvero?

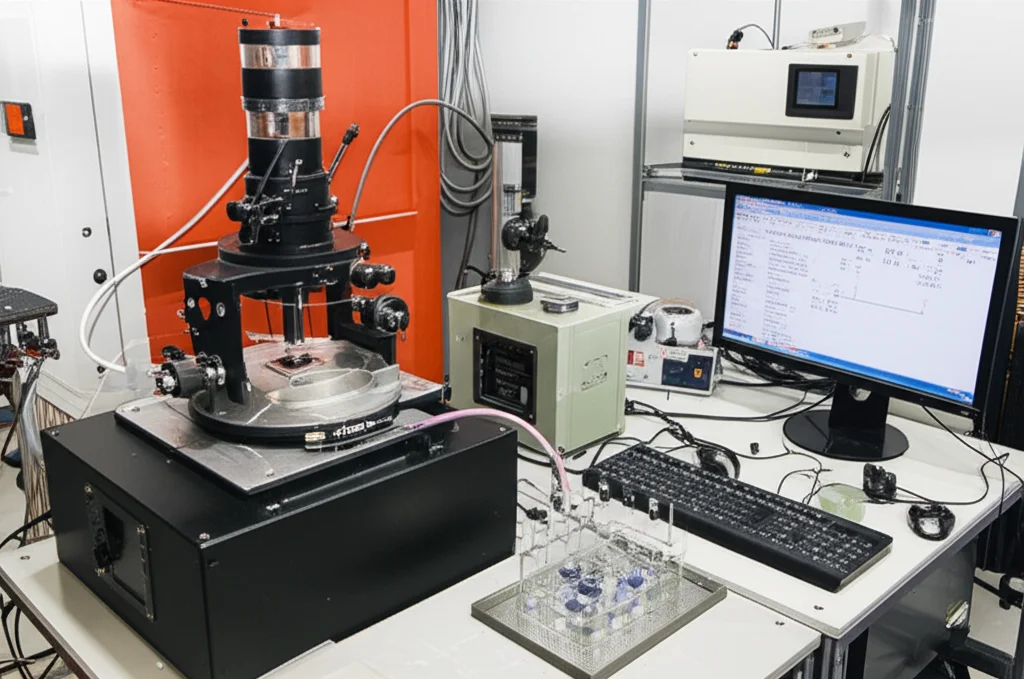

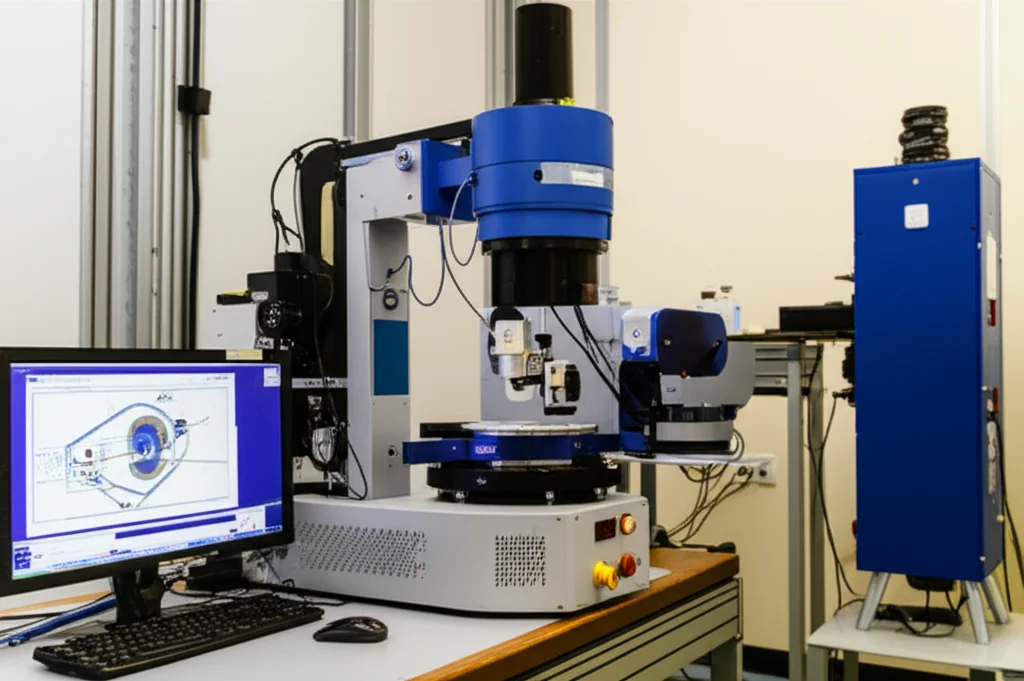

Entra in gioco l’XRD a dispersione di energia (EDXRD)

Qui entra in gioco una variante della tecnica XRD che si presta magnificamente a un approccio più smart: l’XRD a dispersione di energia (EDXRD). Facciamo un passo indietro. Nell’XRD “classico” (a dispersione angolare, ADXRD), usiamo raggi X di una lunghezza d’onda fissa ((lambda)) e variamo l’angolo ((theta)) per trovare i picchi di diffrazione che ci dicono com’è fatto il reticolo cristallino del materiale (la famosa legge di Bragg: (nlambda = 2D sintheta)). È un processo sequenziale, un passo alla volta. Nell’EDXRD, invece, teniamo l’angolo (theta) fisso e usiamo uno spettro “bianco” di raggi X (con tante energie, quindi lunghezze d’onda, diverse). Un rivelatore speciale misura l’energia dei raggi X diffratti, permettendoci di ottenere l’intero spettro di diffrazione *contemporaneamente* e in modo continuo. Capite il vantaggio? Mentre la misura va avanti, i dati sull’intero spettro si accumulano.

L’idea “geniale”: la selezione intelligente dei dati

E se potessimo usare questi dati che si accumulano *durante* l’esperimento per decidere come continuare? È il concetto di sperimentazione “closed-loop” (a ciclo chiuso): l’analisi dei dati in tempo reale guida le fasi successive dell’esperimento stesso. Invece di seguire pedissequamente uno script predefinito (“misura tutto per X secondi”), possiamo implementare delle strategie di selezione dei dati più intelligenti. L’obiettivo? Ottenere le informazioni chiave sui picchi di diffrazione (posizione esatta, altezza, larghezza, area – fondamentali per capire fasi, stress, texture) nel minor tempo possibile, concentrando il tempo di misura solo dove serve di più.

Il nostro esperimento: il caso dell’acciaio QP

Per mettere alla prova questa idea, abbiamo preso un acciaio speciale, un 42CrSi trattato con processo QP, che sapevamo avere una microstruttura complessa con austenite trattenuta (la fase che ci interessava quantificare). Avevamo già dati sperimentali raccolti in modo tradizionale: una scansione lungo un provino di trazione rotto, con 8 punti di misura (dal punto di frattura fino alla zona non deformata), e per ogni punto avevamo acquisito lo spettro EDXRD per ben 4 ore, salvando i dati ogni 900 secondi (15 minuti). Questo ci ha dato una base dati “perfetta” (la nostra “ground truth”) e la possibilità di *simulare* cosa sarebbe successo applicando diverse strategie di acquisizione.

Strategie a confronto: il vecchio, il furbo e il furbissimo

Abbiamo confrontato tre approcci:

- Strategia full (il metodo classico): Simuliamo l’acquisizione sequenziale. Ogni 900 secondi, aggiungiamo i dati dell’intero spettro energetico [1-60 keV]. È il nostro riferimento, il modo tradizionale di lavorare.

- Strategia roi (Regioni di Interesse): Prima di iniziare, identifichiamo le zone di energia dove ci aspettiamo i picchi principali (le nostre “seed peaks”). Poi, ad ogni “passo” di 900 secondi, simuliamo l’acquisizione dei dati solo in queste regioni predefinite (ROI). L’idea è: perché perdere tempo a misurare zone piatte dello spettro?

- Strategia min_vol (Volume Minimo – la più smart): Questa è la vera novità. Dopo la prima misura completa (900s), analizziamo i picchi ottenuti. Qual è quello con il segnale più debole, con il “volume” (intensità accumulata) minore? Bene, nel prossimo intervallo di tempo, concentriamo *tutta* la misura solo sull’intervallo energetico di quel picco specifico. Poi rivalutiamo: qual è ora il picco più “incerto”? E così via. L’idea è rafforzare selettivamente i segnali più deboli per migliorare rapidamente l’accuratezza complessiva.

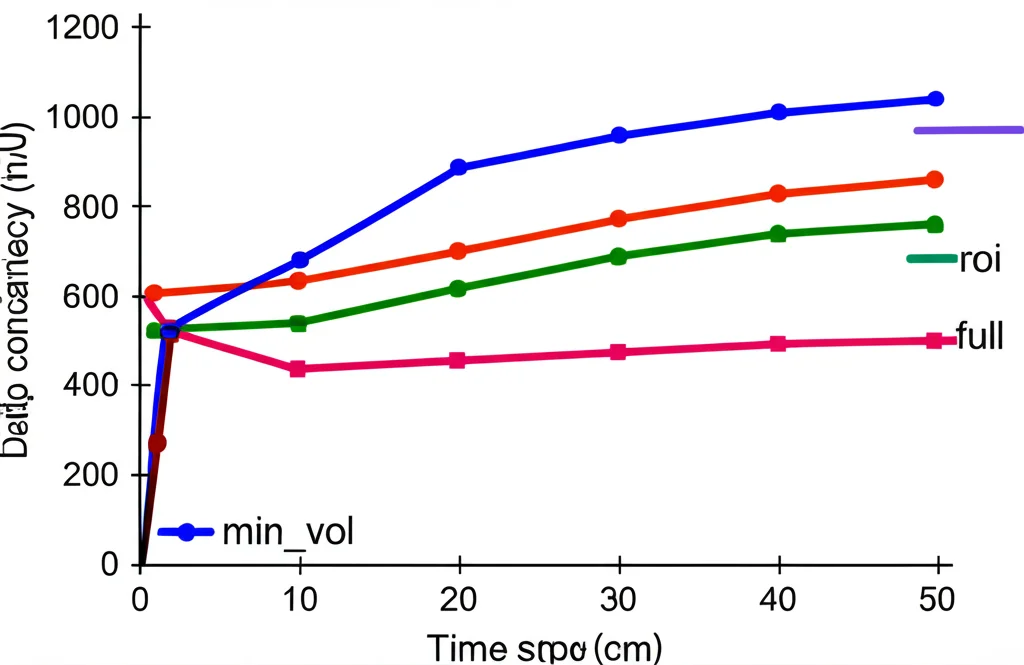

I risultati? Un risparmio di tempo pazzesco!

Ebbene, i risultati sono stati entusiasmanti! Abbiamo monitorato l’errore medio assoluto relativo (MAE) nella stima dei parametri dei picchi (posizione, larghezza, altezza, area) rispetto ai valori “veri” ottenuti dalle 4 ore complete di misura. Come ci aspettavamo, tutte le strategie alla fine convergono a errore zero (usando tutti i dati disponibili). Ma la velocità con cui ci arrivano è drasticamente diversa!

La strategia full è la più lenta. La strategia roi è già molto meglio, perché elimina le zone inutili. Ma la vera star è la strategia min_vol! Concentrandosi iterativamente sui picchi più deboli, raggiunge un basso livello di errore molto più rapidamente. In pratica, per ottenere un’accuratezza considerata “buona” (ad esempio, un MAE molto basso), le strategie roi e min_vol ci permettono di fermare l’esperimento molto prima.

Quantifichiamo? Abbiamo visto che, a seconda del livello di errore accettabile, potremmo risparmiare fino al 55% del tempo con la strategia roi e fino al 62% con la strategia min_vol rispetto all’approccio tradizionale! Immaginate cosa significa questo per un laboratorio che deve analizzare decine di campioni o mappare aree estese di un componente. È una rivoluzione in termini di efficienza.

Cosa ci riserva il futuro? Verso esperimenti ancora più intelligenti

Questo studio apre scenari interessantissimi.

- Possiamo rendere queste strategie ancora più potenti usando tecniche di active learning, dove l’algoritmo non solo sceglie *dove* misurare, ma impara attivamente quale sia la scelta migliore per ottimizzare un parametro specifico (es. la posizione del picco per misure di stress).

- Potremmo introdurre criteri di arresto automatici: l’esperimento si ferma da solo quando l’accuratezza desiderata è raggiunta, senza bisogno di tempi fissi.

- L’approccio è flessibile: può essere adattato per gestire picchi sovrapposti o sfondi complessi, magari usando funzioni matematiche più sofisticate (come le wavelet “Mexican-Hat”) per l’analisi dei picchi.

- Si integra perfettamente con la tendenza verso la sperimentazione automatizzata, ma permette anche l’intervento umano (“human-in-the-loop”) nei casi più difficili.

- Sebbene qui abbiamo usato dati di laboratorio, queste strategie sono applicabili anche a grandi infrastrutture di ricerca come i sincrotroni, dove il tempo di misura è ancora più prezioso.

La bellezza di queste strategie, specialmente la min_vol, è la loro relativa semplicità concettuale e la facilità con cui potrebbero essere integrate negli script di controllo degli strumenti moderni (molti usano Python, per cui il nostro codice sarebbe quasi pronto all’uso!). Non serve un database enorme o un pre-addestramento complesso.

In conclusione, abbiamo dimostrato che cambiando il *modo* in cui decidiamo cosa misurare durante un esperimento XRD, possiamo ottenere gli stessi risultati di alta qualità in molto meno tempo. È un passo importante verso una caratterizzazione dei materiali più efficiente, più rapida e, in definitiva, più intelligente. E questo, lasciatemelo dire, è musica per le orecchie di chiunque passi le sue giornate in laboratorio a svelare i segreti della materia!

Fonte: Springer