LiDAR: I Miei Occhi Laser per una Logistica Industriale a Prova di Futuro

Ciao a tutti! Oggi voglio parlarvi di qualcosa che mi appassiona da matti: come rendere i veicoli autonomi (quelli che chiamiamo AGV, Autonomous Ground Vehicles) veramente intelligenti e sicuri negli ambienti industriali e logistici. Immaginate capannoni immensi, fabbriche brulicanti di attività, muletti che sfrecciano, carrelli pieni di pezzi… un caos controllato, certo, ma pur sempre un ambiente complesso per una macchina che deve muoversi da sola.

La Sfida: Vedere Chiaro nel Caos Industriale

Negli ultimi anni, l’automazione industriale ha fatto passi da gigante. Gli AGV sono diventati fondamentali per velocizzare i processi, ridurre i costi e aumentare la sicurezza. Pensate a una fabbrica di automobili, come quella della Renault a Palencia, in Spagna, dove abbiamo lavorato con il progetto R3CAV: lì i veicoli devono operare 24 ore su 24, 7 giorni su 7, senza sosta e senza intervento umano. Figo, no?

Però, c’è un “ma”. Molti sistemi di percezione attuali sono ancora un po’… basici. Spesso si limitano a dire “c’è un ostacolo, fermati!”. Questo va bene in ambienti semplici, ma in scenari più dinamici, magari all’aperto o in centri logistici complessi, serve di più. Serve un sistema che capisca davvero cosa c’è intorno, che distingua un muro da un carrello in movimento, che permetta al veicolo non solo di fermarsi, ma magari di aggirare l’ostacolo in sicurezza.

Qui entrano in gioco le tecnologie più avanzate, come l’Intelligenza Artificiale (AI), il Machine Learning (ML) e le Reti Neurali (NN). Sono potentissime, capaci di analizzare immagini e dati per capire l’ambiente. Ma hanno dei limiti, specialmente in fabbrica. Perché?

- Ostacoli “strani”: Le fabbriche sono piene di oggetti che non trovi per strada (carrelli specifici, pezzi ingombranti, muletti…). I modelli AI allenati per la guida su strada normale non li riconoscono bene.

- Mancanza di dati specifici: Per allenare un’AI servono tantissimi dati etichettati. Ma dataset specifici per ambienti industriali? Scarseggiano. Quelli esistenti sono quasi tutti per strade convenzionali.

- Costi e consumi: Le reti neurali profonde (Deep Learning) richiedono hardware potente, come le GPU, che costano e consumano un sacco di energia. Non proprio l’ideale per applicazioni industriali dove si bada ai costi e all’efficienza energetica.

La Mia Soluzione: LiDAR e un Pizzico di Astuzia (Senza AI Pesante!)

Allora, come ho affrontato questa sfida? Ho pensato: perché non sfruttare al massimo quello che già sappiamo dell’ambiente? In una fabbrica, molte cose sono fisse: muri, colonne, aree di parcheggio… Questa informazione è preziosa!

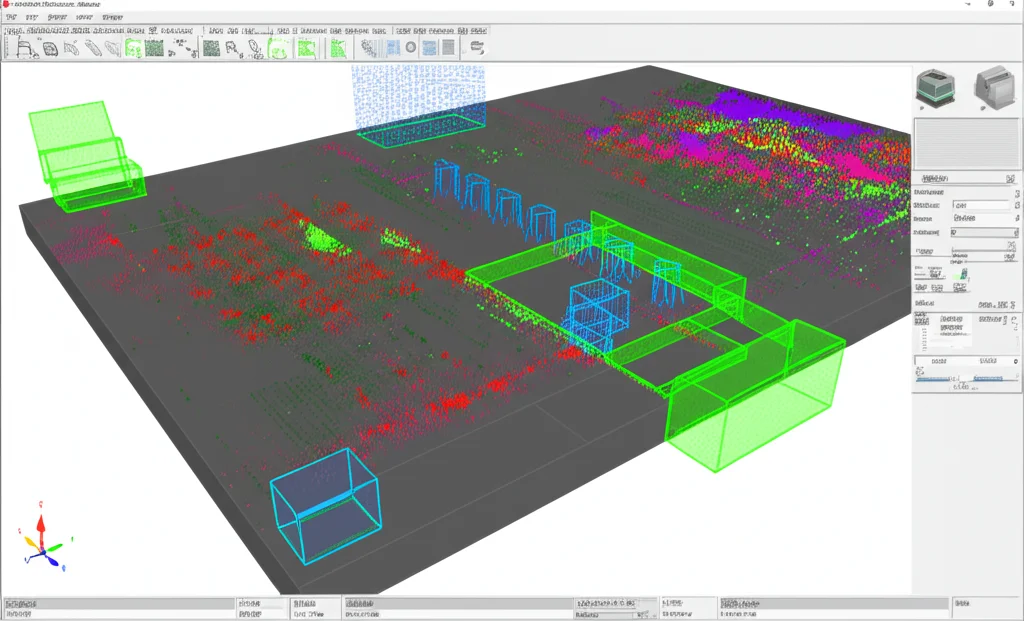

Il cuore del mio sistema è il LiDAR (Light Detection and Ranging). È un sensore che usa impulsi laser per creare una mappa 3D precisissima dell’ambiente circostante, una “nuvola di punti”. Il bello del LiDAR è che funziona benissimo con qualsiasi luce (anche al buio!) e con diverse condizioni meteo, ed è molto preciso nel misurare le distanze. Niente telecamere, quindi massima privacy, un aspetto cruciale in ambito industriale.

Ma il LiDAR da solo non basta. La vera magia sta in come elaboriamo i dati che raccoglie. Ho sviluppato una pipeline, una sequenza di passaggi, pensata per essere super efficiente e funzionare anche su computer con potenza limitata, senza bisogno di costose GPU.

Ecco come funziona, passo dopo passo:

1. Pulizia Iniziale: Via il Pavimento!

La prima cosa da fare è eliminare i punti della nuvola LiDAR che colpiscono il terreno. Il pavimento non è un ostacolo con cui possiamo scontrarci, quindi toglierlo semplifica l’analisi e velocizza tutto. Usiamo un algoritmo intelligente che sfrutta le caratteristiche del LiDAR (come gli angoli fissi dei suoi laser) per separare i punti “terra” da quelli “non terra”.

2. Il Colpo di Genio: Filtrare con la Mappa

Questo è il passaggio chiave, la vera innovazione. Usiamo una mappa pre-generata dell’area di navigazione. Ma non una mappa qualsiasi! È una mappa 2D speciale, multi-strato. L’abbiamo creata combinando diverse “fette” orizzontali della nuvola di punti LiDAR a varie altezze (usando un algoritmo SLAM chiamato gmapping, un po’ modificato) e arricchendola con dati da OpenStreetMap (OSM). Perché multi-strato? Per catturare anche ostacoli bassi (cordoli) o alti che una singola fetta 2D mancherebbe. Perché OSM? Per gestire elementi “semi-permanenti” come le auto parcheggiate nelle aree designate, che cambiano nel tempo ma sono comunque in zone non navigabili.

Questa mappa ci dice dove sono gli elementi statici *noti* (muri, edifici, marciapiedi, zone di parcheggio…). Confrontando la nuvola di punti (quella senza pavimento) con questa mappa, possiamo eliminare tutti i punti che cadono in aree statiche e non navigabili. Cosa rimane? Solo i punti che potrebbero essere ostacoli reali e potenzialmente pericolosi: oggetti in mezzo alla strada, altri veicoli in movimento, pedoni, carrelli… Questo riduce drasticamente la quantità di dati da analizzare nei passaggi successivi, rendendo il sistema incredibilmente veloce!

3. Raggruppare e Identificare: Clustering e PCA

Ora che abbiamo una nuvola di punti “pulita”, contenente solo potenziali ostacoli, dobbiamo capire cosa sono. Usiamo un algoritmo di clustering 3D (un adattamento leggero e veloce di un metodo esistente) che raggruppa i punti vicini tra loro. Ogni gruppo (cluster) rappresenta un potenziale ostacolo.

Ma un gruppo di punti non basta. Dobbiamo dargli una forma, una dimensione, una posizione precisa. Qui entra in gioco la Principal Component Analysis (PCA). È una tecnica matematica che ci permette di trovare l’orientamento principale di ogni cluster di punti e di calcolare il “Bounding Box Minimo Orientato” (MOBB), cioè il parallelepipedo più piccolo che contiene tutti i punti del cluster. In pratica, trasformiamo un ammasso informe di punti in un ostacolo definito, con:

- Posizione del centro (rispetto al nostro veicolo)

- Dimensioni (lunghezza, larghezza, altezza)

- Orientamento (heading)

Abbiamo ottimizzato la PCA lavorando in 2D (ignorando temporaneamente l’altezza, che calcoliamo separatamente) per renderla ancora più rapida.

4. Seguire il Movimento: Tracking degli Ostacoli

Avere una “foto” degli ostacoli in un dato istante è utile, ma non sufficiente. Dobbiamo capire come si muovono! L’ultimo stadio è il tracking degli ostacoli. Usiamo un filtro di Kalman Unscented (UKF) per seguire ogni ostacolo rilevato nel tempo. Questo ci dà diversi vantaggi:

- Robustezza: Elimina i “falsi positivi” (rilevamenti sporadici che non sono veri ostacoli). Un oggetto viene considerato tale solo se appare in più frame consecutivi.

- Consistenza: Mantiene traccia degli ostacoli anche se vengono temporaneamente nascosti o se il rilevamento “salta” per un frame.

- Stima della velocità: Analizzando lo spostamento dell’ostacolo tra un frame e l’altro, possiamo stimare la sua velocità. Informazione cruciale per la navigazione sicura!

L’output finale di tutta la pipeline è una lista di ostacoli tracciati, con posizione, orientamento, dimensioni e velocità. Questi dati vengono inviati al sistema di navigazione del veicolo, che può così pianificare il percorso e prendere decisioni in modo sicuro ed efficiente.

Messo alla Prova: Sul Campo (e Contro i “Campioni” AI)

Ok, tutto bello in teoria, ma funziona davvero? Per verificarlo, abbiamo fatto un sacco di esperimenti nel mondo reale, proprio nella fabbrica Renault di Palencia. Abbiamo fatto girare il nostro AGV in condizioni operative normali, incontrando traffico reale (altri veicoli, muletti, persone), e abbiamo anche creato scenari specifici (tipo un’auto che ci segue o un pedone che attraversa).

Abbiamo misurato tutto: precisione, richiamo (recall), accuratezza, F1-Score (metriche standard per valutare i sistemi di rilevamento). E abbiamo confrontato il nostro sistema con un pezzo da novanta del Deep Learning per la rilevazione 3D basata su LiDAR: SECOND. Lo abbiamo fatto girare sugli stessi dati registrati, per un confronto il più equo possibile (anche se SECOND richiede una potente GPU per funzionare in tempo reale, mentre il nostro sistema gira su una normale CPU).

I risultati? Beh, sono stati molto incoraggianti!

- Affidabilità Top: Il nostro sistema ha raggiunto percentuali superiori al 98% in quasi tutte le metriche per auto e pedoni. Anche con ostacoli “strani” (come un trenino di carrelli specifico della fabbrica), dove SECOND è andato in crisi (recall sotto il 41% perché non lo aveva mai “visto” prima!), il nostro sistema ha mantenuto un’ottima performance (recall del 93%). Questo dimostra la capacità di gestire oggetti sconosciuti, fondamentale in ambiente industriale.

- Precisione nelle Stime: Siamo stati incredibilmente precisi nel localizzare gli ostacoli statici (errore medio sotto i 3 cm, meglio della precisione intrinseca del LiDAR!). Anche la stima delle dimensioni (Bounding Box) è risultata molto accurata per larghezza e altezza. Sulla lunghezza, abbiamo un errore maggiore se la parte posteriore dell’oggetto è nascosta (perché vediamo solo i punti che il LiDAR colpisce). Qui, bisogna ammetterlo, SECOND fa meglio per oggetti noti come le auto, perché “immagina” la parte mancante grazie all’addestramento. Ma per la sicurezza, la nostra precisione sulle parti visibili è più che sufficiente.

- Tracking Efficace: Confrontando le stime di posizione, orientamento e velocità con i dati reali di un veicolo “Ground Truth” (equipaggiato con GPS+RTK ad alta precisione), il nostro sistema si è dimostrato notevolmente accurato, anche in manovre complesse come sorpassi ad alta velocità o curve strette.

Il Vero Vantaggio: Velocità e Leggerezza

Ma la cosa forse più impressionante è stata la velocità di elaborazione. Grazie al filtraggio basato sulla mappa, l’intera pipeline impiega in media solo 5-7 millisecondi per elaborare un intero scan LiDAR! Senza il filtro della mappa, ci vorrebbero quasi 200 millisecondi, troppo lenti per il tempo reale (il LiDAR fa uno scan ogni 100 ms). Questo significa che il nostro sistema è:

- Real-time: Elabora i dati più velocemente di quanto arrivino.

- Efficiente: Funziona su una singola CPU, senza bisogno di GPU.

- Economico: Meno hardware costoso, meno consumo energetico.

- Scalabile: Gestisce bene anche scene con molti ostacoli senza rallentare proporzionalmente.

Resilienza alle Intemperie? Quasi Perfetta!

Abbiamo anche testato il sistema sotto la pioggia battente. Il LiDAR, in generale, è robusto, ma la pioggia intensa può creare qualche piccolo “falso positivo” (gocce d’acqua vicine che riflettono il laser e vengono scambiate per mini-ostacoli). Abbiamo visto un leggero aumento dei falsi positivi (dal 0.34% col sole al 2.2% con pioggia forte), ma sono quasi sempre piccoli e vicini al sensore, quindi gestibili. Un piccolo prezzo da pagare per poter operare 24/7 con qualsiasi tempo.

Perché Funziona (e Cosa Ci Riserva il Futuro)

In sintesi, credo che questo approccio basato su LiDAR e mappe intelligenti sia una soluzione vincente per la percezione degli AGV in ambienti industriali. È robusto, efficiente, economico, rispettoso della privacy e capace di gestire l’imprevisto. Certo, ha dei prerequisiti: serve una mappa accurata dell’area e un buon sistema di localizzazione del veicolo. Ma in un ambiente confinato come una fabbrica, questi sono aspetti gestibili.

Cosa bolle in pentola per il futuro? Sicuramente migliorare ancora la gestione delle condizioni meteo avverse. Poi, sto pensando all’integrazione con sistemi V2X (Vehicle-to-Everything) per comunicare con altri veicoli e infrastrutture, migliorando la consapevolezza situazionale. E infine, la migrazione a ROS 2, la nuova versione del Robot Operating System, per garantire prestazioni, manutenibilità e scalabilità a lungo termine.

La strada verso l’automazione completa è ancora lunga, ma con sistemi di percezione come questo, stiamo mettendo dei mattoni fondamentali per costruire fabbriche e magazzini più intelligenti, efficienti e sicuri. Ed è emozionante far parte di questa rivoluzione!

Fonte: Springer