SegMatch: L’IA che Impara a Vedere in Sala Operatoria (Anche Senza Troppe Etichette!)

Ciao a tutti! Oggi voglio parlarvi di qualcosa che mi appassiona tantissimo: come l’intelligenza artificiale sta entrando in sala operatoria per dare una mano ai chirurghi. Immaginate un futuro in cui i sistemi computerizzati non solo assistono, ma comprendono attivamente cosa sta succedendo durante un intervento. Uno dei mattoncini fondamentali per costruire questo futuro è la capacità dei computer di “vedere” e riconoscere gli strumenti chirurgici utilizzati. Sembra semplice, ma non lo è affatto! Ed è qui che entra in gioco il nostro lavoro su SegMatch.

La Sfida: Occhi Elettronici Hanno Bisogno di Imparare, Ma Come?

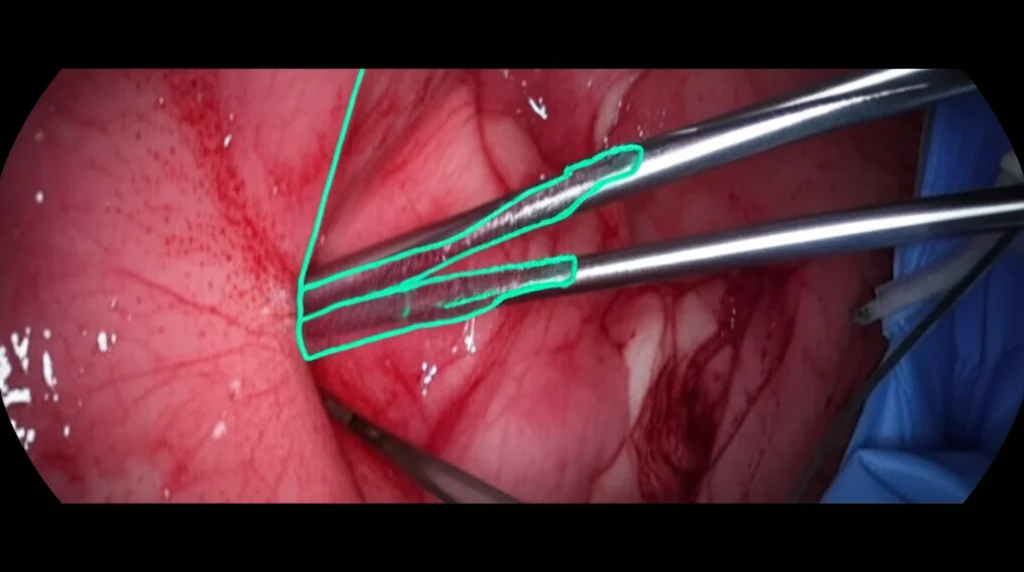

Per insegnare a un’IA a riconoscere, ad esempio, un bisturi o una pinza laparoscopica in un video chirurgico, tradizionalmente le si danno migliaia e migliaia di immagini dove ogni singolo pixel dello strumento è stato meticolosamente “colorato” (annotato) da esperti umani. Questo processo, chiamato segmentazione, è incredibilmente costoso e richiede un sacco di tempo. Pensateci: ore e ore di lavoro di personale specializzato solo per preparare i dati di addestramento. Un vero collo di bottiglia!

E se ci fosse un modo per ridurre drasticamente la necessità di tutte queste etichette manuali? Se l’IA potesse imparare anche da video chirurgici “grezzi”, non annotati? Questa è la promessa dell’apprendimento semi-supervisionato, ed è il cuore pulsante di SegMatch.

SegMatch: Imparare con Pochi Esempi (e Tanta Intelligenza)

Ci siamo ispirati a un metodo molto efficace nel campo della classificazione di immagini chiamato FixMatch e lo abbiamo adattato per il compito più complesso della segmentazione in chirurgia. L’idea di base è geniale nella sua semplicità: usiamo sia i pochi dati etichettati che abbiamo, sia una montagna di dati non etichettati (che sono molto più facili da ottenere).

Come funziona? Durante l’addestramento, SegMatch fa passare le immagini non etichettate attraverso due “percorsi” paralleli:

- Augmentation Debole: L’immagine viene modificata leggermente (es. ruotata, capovolta). È come mostrare all’IA lo strumento da un’angolazione un po’ diversa, ma senza stravolgerlo. L’IA fa la sua previsione su questa immagine “facile”.

- Augmentation Forte: Qui le cose si fanno interessanti. L’immagine viene modificata in modo più significativo, soprattutto nei colori, nella luminosità, nel contrasto (trasformazioni fotometriche).

L’IA deve poi fare una previsione anche sull’immagine “difficile”. Il trucco sta nella consistenza: la previsione fatta sull’immagine facile (se l’IA è abbastanza sicura) viene usata come “pseudo-etichetta”, una sorta di verità temporanea. L’obiettivo è fare in modo che la previsione sull’immagine difficile sia il più possibile simile a questa pseudo-etichetta. In pratica, stiamo dicendo all’IA: “Anche se ti cambio le luci o i colori, devi comunque riconoscere che quello è sempre lo stesso strumento!”.

Equivarianza vs. Invarianza: Un Dettaglio Cruciale

Adattare FixMatch alla segmentazione non è stato banale. C’è una differenza sottile ma fondamentale rispetto alla classificazione. Se ruoto un’immagine (trasformazione spaziale), voglio che anche la maschera di segmentazione dello strumento ruoti insieme ad essa (questa si chiama equivarianza). Se invece cambio solo la luminosità (trasformazione fotometrica), la maschera di segmentazione non deve cambiare (invarianza). Abbiamo dovuto tenere conto di queste proprietà nel progettare le augmentation deboli e forti di SegMatch, invertendo le trasformazioni spaziali dopo la previsione nel percorso debole per poter confrontare correttamente i risultati.

Il Tocco Magico: l’Augmentation Avversaria Addestrabile

Le augmentation forti “fatte a mano” (quelle fotometriche standard) sono utili, ma fino a un certo punto. Una volta che l’IA impara a gestirle, l’apprendimento dai dati non etichettati rischia di saturarsi. Come possiamo continuare a “sfidare” l’IA in modo intelligente?

Ecco la nostra seconda, e forse più importante, innovazione: abbiamo introdotto una strategia di augmentation forte addestrabile e avversaria. Usiamo una tecnica chiamata I-FGSM (Iterative Fast Gradient Sign Method), che è un metodo noto per creare “esempi avversari”, cioè piccole modifiche a un’immagine, quasi impercettibili per noi, ma che possono ingannare un’IA. Noi però la usiamo a nostro vantaggio!

In pratica, partiamo dall’augmentation forte fatta a mano e poi usiamo I-FGSM per “peggiorare” l’immagine in modo mirato, rendendo il compito di segmentazione ancora più difficile, proprio nei punti in cui l’IA è più incerta o potrebbe sbagliare. È come avere un allenatore che adatta dinamicamente gli esercizi per spingere l’atleta a migliorare continuamente. Questo aiuta SegMatch a imparare in modo più robusto e a generalizzare meglio.

Alla Prova dei Fatti: SegMatch Batte la Concorrenza

Abbiamo messo alla prova SegMatch su dataset standard utilizzati nelle competizioni scientifiche internazionali, come Robust-MIS 2019 (chirurgia laparoscopica) ed EndoVis 2017 (chirurgia robotica), e anche sul più recente CholecInstanceSeg per la segmentazione multi-classe (riconoscere diversi tipi di strumenti).

I risultati sono stati entusiasmanti! Usando solo una frazione dei dati etichettati (ad esempio, il 10% o il 30%) e aggiungendo i dati non etichettati disponibili, SegMatch ha superato significativamente le prestazioni dei modelli addestrati solo con la stessa quantità di dati etichettati (approccio supervisionato). Non solo, ha anche battuto diversi altri metodi semi-supervisionati all’avanguardia.

Ancora più interessante: quando abbiamo usato tutti i dati etichettati disponibili e in più abbiamo aggiunto decine di migliaia di frame video non etichettati (che altrimenti sarebbero rimasti inutilizzati), SegMatch ha ottenuto punteggi notevolmente superiori anche rispetto ai migliori modelli completamente supervisionati attuali, inclusi approcci recenti che sfruttano modelli pre-addestrati enormi (foundation models). Questo dimostra il valore immenso dei dati non etichettati, se sfruttati nel modo giusto! Particolarmente notevole è stato il miglioramento su tipi di chirurgia mai visti durante l’addestramento, segno di una migliore capacità di generalizzazione.

Perché Tutto Questo è Importante? Le Applicazioni

Ok, belle le performance, ma a cosa serve tutto ciò nella pratica? Beh, una segmentazione accurata e affidabile degli strumenti chirurgici apre le porte a un mondo di applicazioni:

- Realtà Aumentata Migliore: Sovrapporre informazioni utili direttamente sulla vista del chirurgo senza coprire gli strumenti.

- Guida Intraoperatoria: Sistemi che aiutano il chirurgo a navigare e a eseguire manovre complesse.

- Analisi del Flusso di Lavoro: Capire automaticamente quali fasi dell’intervento si stanno svolgendo.

- Valutazione Oggettiva delle Abilità: Misurare le performance dei chirurghi in modo automatico.

- Controllo Robotico Avanzato (Visual Servoing): Robot che si muovono con precisione basandosi su ciò che “vedono”.

- Automazione di Compiti Chirurgici: Un passo verso sistemi chirurgici più autonomi.

- Feedback Aptico: Simulare la sensazione del contatto per manovre più sicure.

Limiti e Prospettive Future

Ovviamente, non è tutto perfetto. SegMatch, come ogni modello, ha i suoi limiti. Fa ancora fatica con superfici molto riflettenti (come la garza bagnata) o quando lo strumento ha un colore molto simile al tessuto circostante. Inoltre, la qualità dei dati non etichettati è importante: se sono pieni di “rumore” o artefatti, possono peggiorare le performance. Scenari molto diversi da quelli visti in addestramento possono ancora metterlo in difficoltà.

Tuttavia, crediamo che l’approccio di SegMatch, in particolare l’uso dell’augmentation avversaria addestrabile, sia molto promettente. Potrebbe essere applicato anche in altri campi medici (e non solo) dove ottenere dati etichettati è difficile e costoso.

In conclusione, SegMatch rappresenta un passo avanti significativo verso sistemi di visione artificiale più intelligenti ed efficienti per la sala operatoria. Sfruttando la potenza dei dati non etichettati in modo intelligente, possiamo accelerare lo sviluppo di tecnologie che renderanno la chirurgia più sicura, efficace e accessibile. E questo, per noi, è l’obiettivo più importante!

Fonte: Springer