SAM e U-Net Insieme: Rivoluzioniamo l’Analisi Cellulare in Patologia Digitale!

Ciao a tutti! Oggi voglio parlarvi di qualcosa che mi appassiona davvero: come stiamo cercando di rendere l’analisi delle immagini mediche, in particolare quelle di patologia digitale, più veloce, precisa e intelligente. Immaginate un patologo che passa ore e ore al microscopio, o davanti a uno schermo, a identificare, contare e classificare cellule in campioni di tessuto. È un lavoro fondamentale per diagnosticare malattie come il cancro, ma è anche incredibilmente lungo, faticoso e, diciamocelo, a volte soggetto a interpretazioni personali. Questo può rallentare le diagnosi e creare delle leggere discrepanze. Qui entra in gioco l’intelligenza artificiale!

La Sfida: Vedere Chiaro nel Microcosmo Cellulare

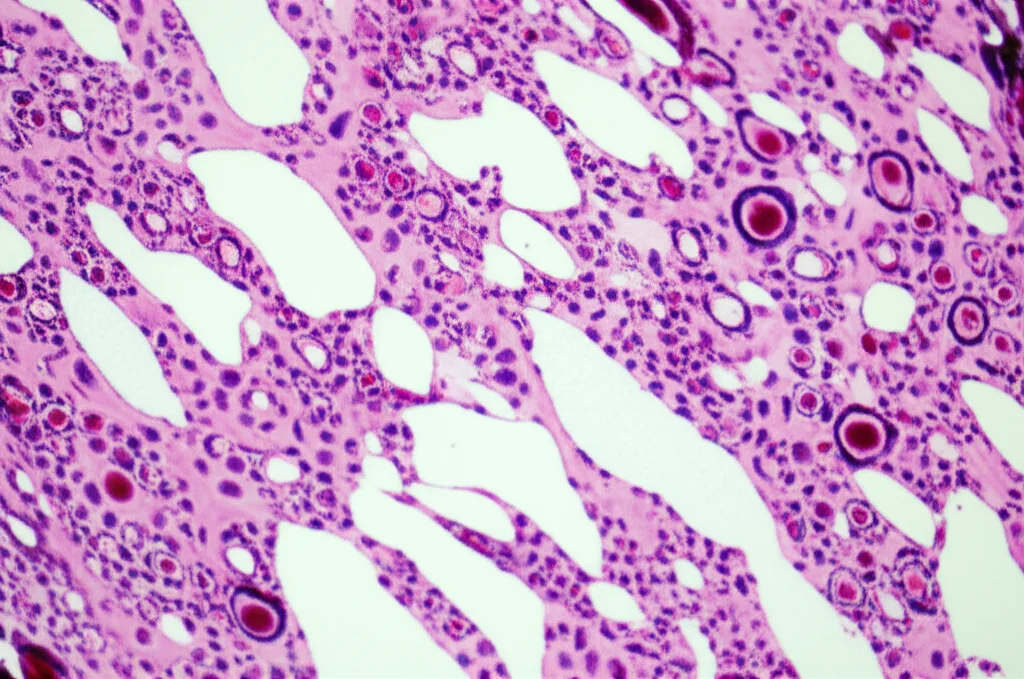

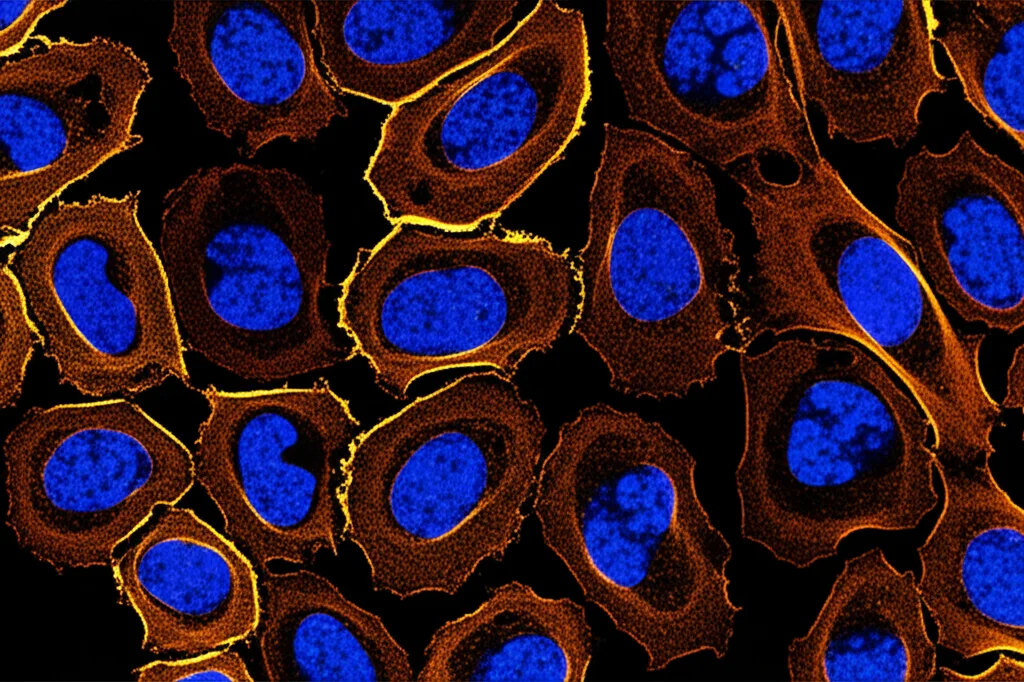

Nel campo dell’analisi delle immagini mediche, la segmentazione e la classificazione delle cellule sono compiti cruciali. Significa identificare con precisione i confini di ogni singola cellula e capire di che tipo è (ad esempio, una cellula tumorale, una cellula immunitaria, ecc.). Pensate che la distribuzione di certi tipi di cellule, come i linfociti che infiltrano un tumore (TILs), può dirci molto sulla prognosi di un paziente.

Per anni, abbiamo cercato di automatizzare questo processo. Uno dei “cavalli di battaglia” in questo campo è la rete neurale chiamata U-Net. È bravissima a segmentare immagini mediche grazie alla sua architettura intelligente che cattura dettagli a diverse scale. Tuttavia, anche U-Net ha i suoi limiti, specialmente quando si tratta di integrare informazioni “esterne” o “prior” che potrebbero aiutarla a fare ancora meglio.

Poi è arrivato SAM (Segment Anything Model), un modello gigantesco addestrato su milioni di immagini, capace, come dice il nome, di “segmentare qualsiasi cosa”. Una potenza incredibile! Però, applicarlo direttamente alle immagini mediche, che sono molto particolari (alta risoluzione, strutture complesse, colorazioni specifiche), non dà sempre i risultati sperati. È come avere una Formula 1 e cercare di usarla su una strada sterrata: potentissima, ma non adatta al terreno senza le giuste modifiche. Inoltre, SAM spesso ha bisogno di “suggerimenti” (prompts) da parte di un esperto per funzionare al meglio, il che ci riporta al problema del lavoro manuale.

L’Idea Brillante: Unire le Forze di SAM e U-Net

Allora ci siamo chiesti: e se potessimo prendere il meglio di entrambi i mondi? Se potessimo usare la potenza “grezza” di SAM per dare una mano alla precisione specializzata di U-Net? Ed è qui che nasce la nostra proposta: un nuovo meccanismo di attenzione congiunta guidata da prior. Sembra complicato, ma l’idea di fondo è affascinante.

In pratica, facciamo così:

- Prima “specializziamo” SAM per le immagini di patologia. Lo abbiamo fatto “fine-tunando” (cioè ri-addestrando leggermente) SAM su un mix di dataset pubblici di cellule patologiche (MoNuSeg, BRCA-M2C, PanNuke). Abbiamo anche sviluppato un modo furbo per generare automaticamente i “suggerimenti” (prompt points) per SAM, basandoci sulla correlazione tra i colori dell’immagine (i canali RGB) e le maschere delle cellule. Questo SAM “specializzato” lo abbiamo chiamato SSAM.

- Poi, usiamo SSAM per generare delle “mappe prior”, cioè delle indicazioni iniziali su dove potrebbero trovarsi le cellule e i loro bordi.

- Infine, queste mappe prior vengono “passate” a U-Net mentre analizza l’immagine. Ma non in modo banale! Usiamo un meccanismo di attenzione congiunta: a ogni livello di analisi di U-Net, questo meccanismo fonde le caratteristiche estratte da U-Net con le informazioni prior fornite da SSAM, aiutando U-Net a “concentrarsi” meglio sulle aree giuste e a capire meglio i dettagli.

Questo approccio permette di sfruttare la capacità di SAM di generare buone maschere iniziali (i nostri “prior”) e la capacità di U-Net di raffinare i dettagli e lavorare su diverse scale, il tutto orchestrato da questo meccanismo di attenzione che fa “dialogare” i due modelli.

I Risultati: Un Salto di Qualità Notevole

Abbiamo messo alla prova il nostro metodo su un dataset pubblico chiamato CoNSep, che contiene immagini di adenocarcinoma colorettale con cellule annotate per tipo (infiammatorie, epiteliali, stromali). I risultati sono stati entusiasmanti!

Il nostro approccio ha superato significativamente sia U-Net da sola, sia altri metodi che provavano a usare SAM semplicemente “sovrapponendo” le sue maschere all’immagine originale come input aggiuntivo (un metodo che chiamiamo Aug(SAMAug)).

Per darvi un’idea, guardando le metriche come Precision, Recall e F1-score (che misurano rispettivamente la precisione, la capacità di trovare tutte le cellule giuste e un bilanciamento tra le due), il nostro modello ha mostrato miglioramenti notevoli, specialmente nella segmentazione generale delle cellule. Ad esempio, l’F1-score per la segmentazione è migliorato di circa il 3% rispetto a U-Net e UNet++ e di circa il 5% nella classificazione delle cellule epiteliali rispetto al metodo Aug.

Abbiamo anche fatto degli “esperimenti di ablazione”, cioè abbiamo testato il modello togliendo parti del nostro meccanismo di attenzione (solo spaziale o solo sui canali di colore) per vedere quanto contribuiva ciascuna. Abbiamo visto che entrambe le componenti aiutano, ma è la loro combinazione nel meccanismo di attenzione congiunta guidata da prior a dare la spinta maggiore alle performance.

Come Funziona nel Dettaglio (Senza Mal di Testa!)

Okay, provo a spiegarvi un po’ più tecnicamente, ma in modo semplice.

Per creare SSAM, abbiamo prima analizzato come i colori (rosso, verde, blu) si correlano con le aree delle cellule nelle immagini patologiche. Abbiamo scoperto, usando un modello statistico (regressione logistica), che il canale blu era spesso il più indicativo per trovare le cellule, mentre il rosso lo era meno. Questo ci ha permesso di scegliere automaticamente i punti “positivi” (dove probabilmente c’è una cellula) dal canale blu e quelli “negativi” (dove probabilmente non c’è) dal canale rosso, per guidare SAM durante il fine-tuning.

Una volta ottenuto SSAM, lo usiamo per generare due tipi di mappe prior per ogni immagine che U-Net deve analizzare: una mappa di segmentazione (Seg) che indica le aree cellulari, e una mappa dei bordi (Bound) che evidenzia i contorni.

Quando U-Net processa l’immagine, a diversi livelli di “zoom” (downsampling), il nostro meccanismo di attenzione entra in gioco.

- L’attenzione sui canali guidata da prior usa la mappa dei bordi (Bound) per dare più peso ai canali di feature che sono importanti per definire i contorni.

- L’attenzione spaziale guidata da prior usa la mappa di segmentazione (Seg) per far concentrare il modello sulle regioni spaziali dove si trovano le cellule.

Fondendo queste informazioni a ogni livello, U-Net impara a sfruttare i suggerimenti di SSAM in modo intelligente e contestualizzato. Il risultato finale passa poi a due “teste” di output: una per la segmentazione finale e una per la classificazione del tipo di cellula.

Perché il Nostro Metodo è Migliore?

Rispetto a U-Net da sola, il nostro metodo ha il vantaggio di ricevere una “guida” esplicita da SSAM, che è stato pre-addestrato su una quantità enorme di dati e poi specializzato sul nostro compito. Questo aiuta U-Net a interpretare meglio le strutture cellulari complesse, specialmente quelle sovrapposte o con forme strane.

Rispetto al metodo Aug(SAMAug), che semplicemente aggiunge le maschere di SAM ai canali di colore dell’immagine originale, il nostro approccio è più sofisticato. Non “inquiniamo” l’immagine originale e permettiamo a U-Net di usare le informazioni prior in modo flessibile e multilivello, grazie al meccanismo di attenzione. Questo preserva l’integrità dell’immagine e si adatta meglio alle necessità dei diversi stadi di analisi.

Abbiamo anche confrontato visivamente le maschere generate dal nostro SSAM con quelle di SAM originale, FastSAM (una versione veloce ma meno precisa) e MedSAM (un SAM fine-tunato per organi, non ottimale per cellule piccole). SSAM, grazie al fine-tuning specifico e ai prompt guidati dai colori, produce maschere molto più pulite e precise per le singole cellule, evitando errori comuni degli altri modelli in scene dense o con cellule piccole.

Sfide e Prossimi Passi

Non è tutto oro quello che luccica, ovviamente. Il nostro metodo, pur essendo potente, è computazionalmente più complesso di U-Net da sola, richiedendo più tempo e risorse per l’addestramento.

Inoltre, abbiamo notato che, sebbene la segmentazione sia migliorata molto, la classificazione di alcuni tipi di cellule ha ancora margini di miglioramento. A volte, l’aggiunta di tante feature per la segmentazione può introdurre “rumore” che confonde il classificatore. Inoltre, il classificatore attuale è relativamente semplice e potrebbe beneficiare di ottimizzazioni specifiche per ogni tipo di cellula.

Un’altra sfida aperta sono le aree con cellule estremamente dense e sovrapposte. Anche il nostro modello combinato fatica a distinguere perfettamente i singoli individui quando i confini sono quasi inesistenti.

Per il futuro, stiamo pensando a come ottimizzare ulteriormente il modello. Magari introducendo strategie di “pesatura dinamica” nell’attenzione, o metodi di guida prior ancora più raffinati. Potremmo anche migliorare la parte di classificazione integrando reti più avanzate o usando approcci di apprendimento multi-task più sofisticati. Sarà interessante anche confrontare il nostro approccio con altre architetture emergenti come i Vision Transformer ibridi.

Conclusione: Un Futuro più Intelligente per la Patologia

In conclusione, credo che questo lavoro rappresenti un passo avanti importante. Abbiamo dimostrato che combinare in modo intelligente la potenza dei grandi modelli pre-addestrati (come SAM) con architetture consolidate e specializzate (come U-Net), usando meccanismi sofisticati come l’attenzione guidata da prior, può portare a miglioramenti significativi in compiti complessi come la segmentazione e classificazione cellulare in patologia digitale.

Questo non solo fa avanzare la ricerca nel campo dell’intelligenza artificiale applicata alla medicina, ma apre anche la strada a strumenti diagnostici più potenti, veloci e affidabili per i patologi, con un potenziale impatto positivo sulla salute dei pazienti. La strada è ancora lunga, ma la direzione sembra quella giusta!

Fonte: Springer