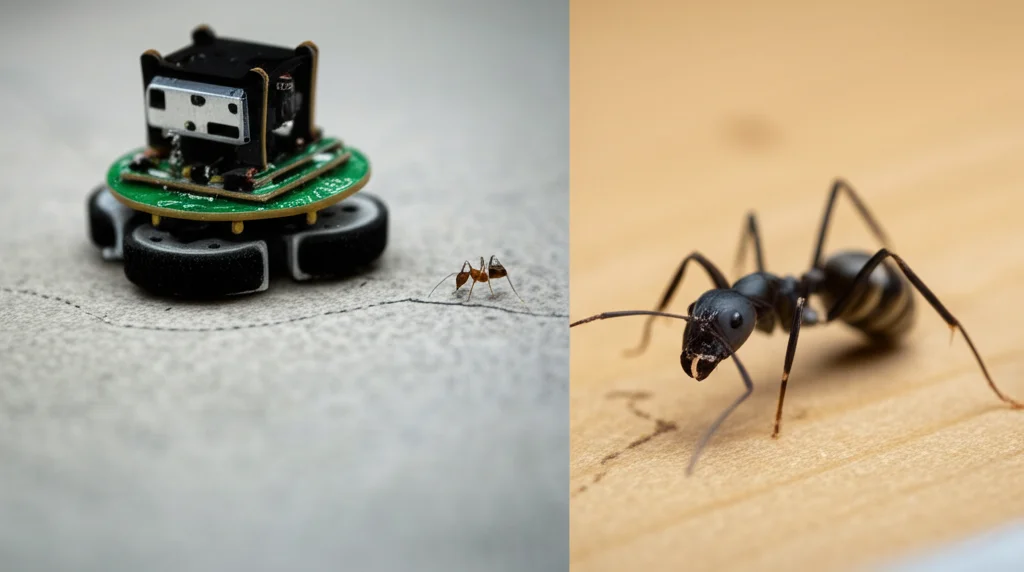

Robot che Imparano dagli Insetti: Seguire Rotte Visive come Formiche Hi-Tech

Ciao a tutti! Oggi voglio parlarvi di qualcosa che mi affascina da sempre: come fanno creature minuscole come gli insetti, con cervelli infinitesimali rispetto ai nostri computer, a navigare nel mondo con una precisione incredibile? Pensate a una formica che ritrova la strada verso il formicaio dopo un lungo giro di esplorazione. Non usa GPS, non ha mappe dettagliate, eppure ci riesce. E se potessimo insegnare ai nostri robot a fare lo stesso, usando solo i loro “occhi”?

Questa è la sfida che abbiamo raccolto: sviluppare un sistema di navigazione per robot mobili chiamato “teach-and-repeat” (insegna e ripeti) visivo. L’idea è semplice: guidi il robot lungo un percorso una volta (la fase di “insegnamento”), lui memorizza ciò che vede, e poi è in grado di ripercorrere autonomamente quella stessa strada (la fase di “ripetizione”) basandosi solo sui ricordi visivi. Sembra fantascienza? Forse, ma la natura ci offre già degli esempi straordinari.

L’Ispirazione dal Mondo degli Insetti: Il Potere della Familiarità

Il segreto, o almeno parte di esso, sembra risiedere in una struttura specifica nel cervello degli insetti chiamata Corpo Fungiforme (Mushroom Body o MB). Questa area è nota per essere cruciale nell’apprendimento associativo e, in particolare, nel riconoscere quanto un certo stimolo visivo sia “familiare”. In pratica, l’insetto impara l’aspetto del suo percorso abituale e, quando si ritrova a navigare, confronta ciò che vede con i suoi ricordi. Se una direzione sembra più “familiare” dell’altra, probabilmente è quella giusta!

Noi ci siamo ispirati proprio a questo meccanismo. Abbiamo pensato: e se dessimo al nostro robot non uno, ma due “cervelli” MB artificiali, uno che guarda a sinistra e uno che guarda a destra? L’idea geniale, ispirata da studi sul comportamento degli insetti [26, 27], è quella di non basare la navigazione sulla familiarità assoluta di una singola vista, ma sulla differenza di familiarità tra il campo visivo sinistro e quello destro.

Il Nostro Modello: “Differential-MB” all’Opera

Così è nato il nostro modello, che abbiamo chiamato differential-MB. Funziona così:

- Durante la fase di “insegnamento”, il robot percorre la rotta e i suoi due MB artificiali (reti neurali molto semplici, ispirate alla struttura biologica) imparano le viste associate a quel percorso, una per il lato sinistro e una per il destro.

- Durante la fase di “ripetizione”, il robot confronta continuamente ciò che vede a sinistra e a destra con i ricordi immagazzinati.

- La magia sta nel controllo: la velocità di rotazione del robot è proporzionale alla differenza normalizzata tra la familiarità della vista destra e quella sinistra. Se la vista destra è più familiare, il robot gira a destra; se è più familiare la sinistra, gira a sinistra. Se sono ugualmente familiari, va dritto.

Questo approccio “differenziale” ha un vantaggio enorme: il robot non ha bisogno di fermarsi continuamente, ruotare su se stesso per scannerizzare l’ambiente e decidere la direzione migliore, come invece richiedono altri modelli [23]. Sterza in modo fluido e riflessivo, un po’ come noi quando guidiamo e correggiamo la traiettoria istintivamente. E non serve nemmeno una vista a 360° o immagini ad alta risoluzione! Usiamo immagini a bassa risoluzione, in scala di grigi, simili a quelle che percepirebbe l’occhio composto di un insetto, rendendo il tutto molto efficiente dal punto di vista computazionale. È quasi come un veicolo di Braitenberg [29, 30] evoluto, capace di apprendere rotte visive complesse.

Alla Prova dei Fatti: Le Simulazioni

Ovviamente, le idee vanno testate. Abbiamo messo alla prova differential-MB in simulazioni realistiche usando il simulatore iGibson [46, 47], che ricrea ambienti interni dettagliati e fisica credibile. Abbiamo usato un robot virtuale chiamato Freight e lo abbiamo sfidato a seguire percorsi curvi in stanze piene di oggetti.

Per capire quanto fosse valido il nostro approccio, lo abbiamo confrontato con altri tre metodi:

- Klinokinesis-MB: Un altro modello ispirato agli insetti [25], che però usa un solo MB e modula un’oscillazione laterale in base alla familiarità.

- Pure-Pursuit: Un algoritmo classico di inseguimento di percorso [42], che usa informazioni geometriche precise sulla posizione del robot e del percorso (un benchmark quasi ideale in assenza di errori).

- Visual-Localisor: Un modello semplificato che cerca di localizzarsi confrontando la vista attuale con un database di immagini del percorso (una sorta di SLAM visivo molto basilare).

I risultati? Klinokinesis-MB ha faticato parecchio sui percorsi curvi, dimostrando che la sua strategia oscillatoria non si adatta bene al movimento continuo. Il nostro differential-MB, invece, se l’è cavata egregiamente! Certo, in un ambiente simulato perfetto e senza rumore, Pure-Pursuit e Visual-Localisor (che “barano” avendo accesso a dati di posizione perfetti) erano leggermente più precisi. Ma la vera sorpresa è arrivata quando abbiamo introdotto del rumore simulato, sia nella percezione visiva che nel controllo motorio.

Qui differential-MB ha mostrato i muscoli! Mentre le prestazioni di Pure-Pursuit e Visual-Localisor crollavano drasticamente anche con poco rumore (perché la loro precisione dipende criticamente da dati esatti), il nostro modello si è dimostrato incredibilmente robusto. Continuava a seguire la rotta in modo affidabile, dimostrando che basarsi sulla differenza di familiarità laterale è una strategia intrinsecamente più resistente agli errori sensoriali e motori. Abbiamo notato che percorsi molto lunghi o complessi potevano mettere in difficoltà il modello, a volte portandolo a perdersi se deviava troppo, ma la sua resilienza al rumore era notevole.

Dal Virtuale al Reale: Il Test con TurtleBot3

Le simulazioni sono utili, ma il mondo reale è un’altra storia. Luci che cambiano, superfici irregolari, piccole imperfezioni meccaniche… sfide che un simulatore non cattura mai del tutto. Perciò, abbiamo implementato differential-MB su un robot reale, un piccolo TurtleBot3 (Waffle Pi) [51], e lo abbiamo testato in un’arena nel nostro laboratorio.

Abbiamo insegnato al robot percorsi curvi e rettilinei. I risultati sono stati entusiasmanti! Il robot seguiva le curve correttamente, anche se con una precisione leggermente inferiore rispetto alle simulazioni (dovuto a vari fattori: telecamera con campo visivo più stretto, rete neurale leggermente più piccola per limiti hardware, controllo a frequenza più bassa). Abbiamo anche giocato con l’illuminazione, spegnendo le luci da un lato dell’arena: il robot inizialmente si confondeva, ma spesso riusciva a correggere la rotta, mostrando una buona tolleranza ai cambiamenti ambientali.

Ma il test più impressionante è stato quello del bias di sterzata. Abbiamo addestrato il robot a seguire un percorso dritto. Poi, in fase di test, abbiamo tolto il pneumatico da una delle ruote! Questo crea un fortissimo sbilanciamento fisico che farebbe curvare il robot anche se gli si comanda di andare dritto. Ebbene, differential-MB è riuscito a compensare attivamente questo bias, mantenendo il robot sorprendentemente vicino alla linea retta originale! Certo, ci metteva un po’ più di tempo, perché doveva fare piccole correzioni e a volte fermarsi per riallinearsi (un comportamento emergente interessante!), ma dimostra una capacità di adattamento notevole, senza bisogno di sapere esplicitamente di avere un “difetto”. Abbiamo confermato questa capacità anche in simulazioni con diversi livelli di bias imposto.

Punti di Forza e Debolezze: Cosa Abbiamo Imparato

Allora, cosa ci portiamo a casa da questa ricerca?

- Efficienza: Il nostro approccio è leggero. Non richiede mappe complesse (niente SLAM), usa immagini a bassa risoluzione e reti neurali semplici. È veloce perché non deve fermarsi a scannerizzare.

- Robustezza: Si è dimostrato molto resistente a rumore sensoriale e motorio, e persino a bias fisici importanti, sia in simulazione che nel mondo reale.

- Semplicità Ispirata alla Natura: Imita un principio biologico efficace (navigazione basata sulla familiarità differenziale) con un’architettura relativamente semplice.

Ma ci sono anche dei limiti, ovviamente:

- Niente Mappa, Niente Recupero Globale: Essendo un sistema “mapless”, se il robot si perde *veramente* (magari spostato da una forza esterna o a causa di un’enorme deviazione), non ha modo di ritrovare la strada da una posizione completamente nuova. Non può pianificare percorsi alternativi o scorciatoie in modo intelligente come farebbe un sistema basato su SLAM.

- Interferenza di Memoria: Sebbene la rete MB sia progettata per minimizzarla, percorsi molto lunghi o con viste molto ripetitive possono comunque creare confusione nella memoria visiva. Aumentare la dimensione della rete (più “neuroni” KC) può aiutare, ma ha un costo computazionale.

- Divario Simulazione-Realtà: Come spesso accade, le prestazioni nel mondo reale sono state leggermente inferiori a quelle simulate, a causa delle tante variabili non perfettamente modellate e dei limiti hardware.

Uno Sguardo al Futuro: Verso Robot Insetti Ancora Più Intelligenti

Questo lavoro apre strade interessanti. Il prossimo passo potrebbe essere integrare questo sistema di navigazione visiva basato sulla familiarità con altri meccanismi, proprio come fanno gli insetti! Loro combinano la memoria visiva con la capacità di “sentire” la direzione e la distanza percorsa (una sorta di navigazione stimata o “dead reckoning”, gestita da un’altra area cerebrale chiamata Complesso Centrale). Un robot che unisce queste due strategie potrebbe essere ancora più robusto, capace magari di ritrovare la strada anche dopo essersi perso.

In conclusione, guardare al mondo degli insetti continua a offrirci soluzioni eleganti ed efficienti per problemi complessi come la navigazione autonoma. Il nostro differential-MB è un piccolo passo in questa direzione, dimostrando che a volte, per andare lontano, basta imparare a guardarsi intorno… un po’ a sinistra, un po’ a destra, proprio come farebbe una formica hi-tech!

Fonte: Springer