Decifrare l’Urdu: La Mia Avventura con l’IA per Scovare le Parafrasi Nascoste

Ciao a tutti! Oggi voglio raccontarvi di un progetto affascinante che mi ha tenuto impegnato: insegnare a un computer a capire quando due frasi in urdu, una lingua tanto bella quanto complessa, dicono la stessa cosa anche se usano parole diverse. Stiamo parlando del rilevamento automatico di parafrasi, un compito fondamentale per un sacco di applicazioni di Elaborazione del Linguaggio Naturale (NLP), come il riassunto automatico di testi, la caccia al plagio e i sistemi di domanda-risposta.

La Sfida dell’Urdu: Un Osso Duro per l’NLP

Perché proprio l’urdu? Beh, lavorare con questa lingua presenta delle sfide uniche. Immaginate:

- Una morfologia complessa: le parole cambiano forma in modi intricati.

- Una scrittura distintiva (il Nastaleeq, che si legge da destra a sinistra!).

- Una cronica mancanza di risorse: pochi dataset etichettati, modelli pre-addestrati o strumenti NLP specifici.

Insomma, applicare direttamente tecniche pensate per l’inglese o altre lingue spesso non funziona. Serviva un approccio su misura.

La Nostra Arma Segreta: Un Framework BiLSTM Affinato

Ecco dove entra in gioco la nostra idea: un nuovo framework basato su reti neurali BiLSTM (Bidirectional Long Short-Term Memory). Perché BiLSTM? Perché queste reti sono fantastiche nel processare sequenze, come le frasi. La parte “Bidirezionale” è cruciale: il modello legge la frase sia da sinistra a destra che da destra a sinistra, catturando così il contesto in entrambe le direzioni. Questo è fondamentale per decifrare i complessi pattern sintattici e semantici dell’urdu.

Per preparare il terreno, abbiamo usato tecniche di preprocessing del testo come la tokenizzazione (dividere il testo in parole o “token”), la rimozione delle stop-word (parole comuni come “e”, “il”, “di”) e la codifica delle etichette. Abbiamo anche utilizzato i word embeddings (in particolare GloVe), che trasformano le parole in vettori numerici catturandone il significato semantico. Questo aiuta il modello a capire le relazioni tra le parole, anche se non sono identiche.

Costruire le Fondamenta: Il Nostro Corpus Urdu Paraphrased (UPC)

Uno dei maggiori ostacoli era la mancanza di dati. Come si addestra un modello senza esempi? Semplice (si fa per dire!): ce li siamo creati noi! Abbiamo messo insieme un’enorme collezione di potenziali coppie di frasi duplicate in urdu, circa 400.000. Poi, un team di cinque volontari madrelingua urdu, esperti nel riconoscere le parafrasi, ha lavorato sodo per identificare e validare manualmente 150.000 coppie che fossero effettivamente parafrasi. È nato così l’Urdu Paraphrased Corpus (UPC), una risorsa preziosissima che abbiamo creato raccogliendo dati da libri, blog, social media, articoli di notizie e altro materiale scritto. Questo dataset è stato fondamentale per addestrare e valutare il nostro modello in modo specifico per l’urdu.

Gestire le Eccezioni: Il Motore di Regole Linguistiche

L’urdu, come ogni lingua viva, ha le sue stranezze, le sue eccezioni, le sue costruzioni particolari. Per rendere il nostro sistema ancora più robusto, abbiamo integrato un motore di regole linguistiche. Immaginatelo come un esperto linguista digitale che interviene per gestire casi specifici:

- Regole Morfologiche: per gestire formazioni di parole irregolari o parole composte.

- Regole Sintattiche: per affrontare variazioni nell’ordine delle parole o strutture sintattiche anomale.

- Regole Semantiche: per interpretare espressioni idiomatiche o significati che cambiano a seconda del contesto.

Questo motore lavora in sinergia con il BiLSTM, assicurando che il modello non vada in tilt di fronte a frasi un po’ “fuori dagli schemi”.

Alla Prova dei Fatti: Esperimenti e Risultati Sorprendenti

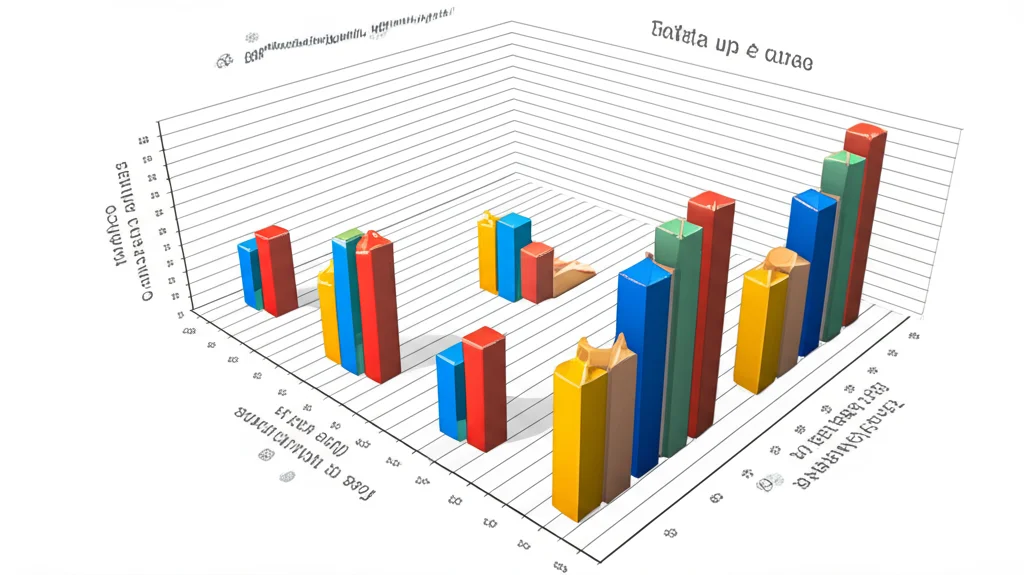

Ovviamente, non ci siamo fermati alla teoria. Abbiamo messo alla prova il nostro framework BiLSTM sia sul nostro dataset personalizzato UPC sia su un dataset di benchmark molto conosciuto, il Quora dataset (coppie di domande dalla piattaforma Quora, etichettate come parafrasi o meno).

I risultati sono stati entusiasmanti! Il nostro modello BiLSTM ha raggiunto un’accuratezza del 94.14% sul dataset UPC e un impressionante 95.34% sul dataset Quora. Abbiamo confrontato le nostre performance con altri metodi all’avanguardia, tra cui:

- Reti Neurali Convoluzionali (CNN): accuratezza dell’83.43% sull’UPC.

- Reti LSTM (unidirezionali): accuratezza dell’88.09% sull’UPC.

- Modelli Ibridi CNN-LSTM.

- Modelli basati su Transformer come BERT.

Il nostro BiLSTM ha superato tutti questi approcci sul nostro compito specifico, dimostrando la sua efficacia per l’urdu. Anche l’F1-score, una metrica che bilancia precisione e richiamo, è stato eccellente, raggiungendo 95.03 sul nostro dataset.

Perché BiLSTM e Non l’Ultima Moda?

Qualcuno potrebbe chiedersi: “Con tutti i modelli potenti come BERT e Transformer in giro, perché usare BiLSTM?”. Ottima domanda! La scelta è stata ponderata. Mentre modelli come BERT sono incredibilmente potenti, richiedono enormi quantità di dati e risorse computazionali per l’addestramento e il pre-addestramento. Per una lingua “a basse risorse” come l’urdu, dove dataset giganteschi e modelli pre-addestrati specifici scarseggiano, un modello come BiLSTM offre un ottimo compromesso tra prestazioni, complessità e fabbisogno di dati. Si è dimostrato più stabile ed efficace con dataset relativamente più piccoli, oltre ad essere più interpretabile. Abbiamo anche implementato strategie attente per evitare l’overfitting (quando il modello impara troppo bene i dati di training ma non generalizza bene su nuovi dati), come l’early stopping, il dropout e la regolarizzazione L2.

Limiti (Sì, ci sono!) e Orizzonti Futuri

Nessun modello è perfetto, e anche il nostro ha dei limiti. A volte fatica a cogliere sfumature semantiche molto sottili o a gestire costruzioni sintattiche estremamente complesse. Errori possono verificarsi con espressioni idiomatiche o quando il contesto è ambiguo. Inoltre, le performance potrebbero calare se applicato a domini molto specifici senza un ulteriore fine-tuning.

Ma siamo già al lavoro sul futuro! Stiamo esplorando diverse direzioni:

- Integrare Meccanismi di Attenzione: Per aiutare il modello a “focalizzarsi” sulle parti più importanti della frase, migliorando la gestione delle dipendenze a lungo raggio.

- Estensione al Livello di Paragrafo: Affrontare la sfida, ancora più complessa, di rilevare parafrasi tra interi paragrafi.

- Applicazione ad Altre Lingue a Basse Risorse: Testare il nostro approccio su altre lingue simili come il Pashto, il Sindhi o l’Amarico.

- Modelli Ibridi: Combinare BiLSTM con altre architetture, come i Transformer, per sfruttare i punti di forza di entrambi.

In Conclusione: Un Passo Avanti per l’Urdu NLP

Questo progetto è stato un viaggio incredibile nel cuore dell’urdu e dell’intelligenza artificiale. Non solo abbiamo sviluppato un sistema di rilevamento di parafrasi molto performante e specificamente adattato alle sfide di questa lingua, ma abbiamo anche creato l’Urdu Paraphrased Corpus (UPC), una risorsa fondamentale che speriamo possa essere utile a tutta la comunità di ricercatori che lavorano sull’NLP per l’urdu e altre lingue simili. È stata una dimostrazione di come, anche con risorse limitate, si possano ottenere risultati significativi combinando l’architettura giusta (BiLSTM), dati di qualità (il nostro UPC) e un pizzico di intelligenza linguistica (il rule engine). La strada è ancora lunga, ma sentiamo di aver dato un contributo importante!

Fonte: Springer