Prostatectomia Navigata con Realtà Aumentata: Un Overlay Senza Fiducial per Vedere l’Invisibile!

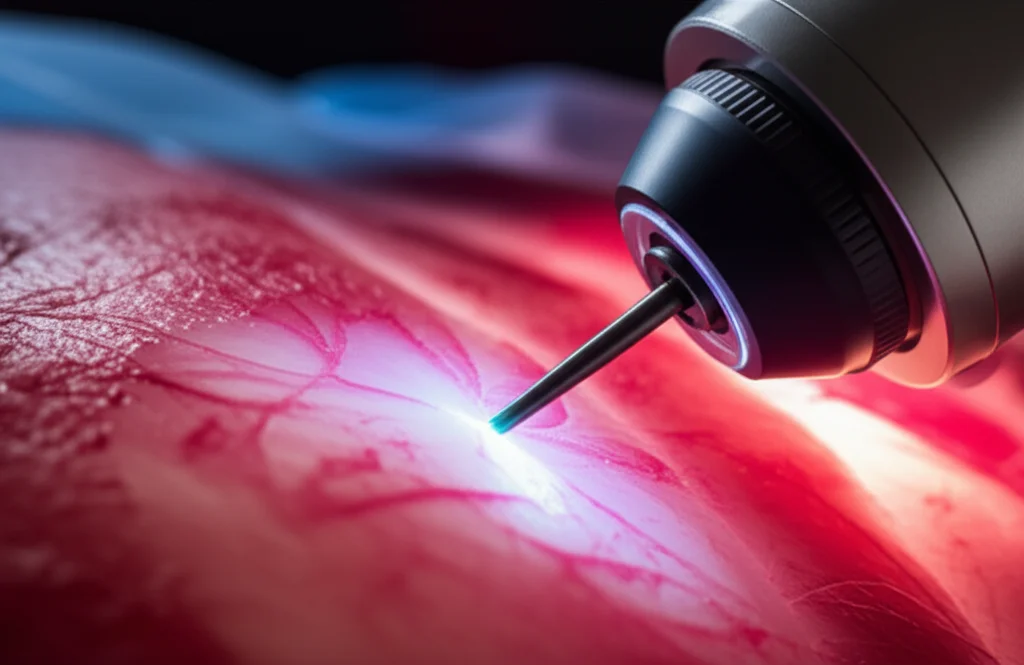

Ciao a tutti! Oggi voglio parlarvi di qualcosa che sta letteralmente cambiando il modo in cui vediamo… dentro il corpo umano durante interventi chirurgici complessi. Immaginate di essere un chirurgo alle prese con una prostatectomia radicale, un’operazione delicata dove la precisione è tutto. I rischi ci sono, non nascondiamocelo: incontinenza, impotenza, complicazioni. Certo, la chirurgia “nerve-sparing” (che cerca di preservare i nervi) aiuta, ma a volte può compromettere il risultato oncologico. E se potessimo dare al chirurgo dei “superpoteri”, una sorta di vista a raggi X che mostra tumori e fasci neurovascolari direttamente nel suo campo visivo? Ecco, è qui che entra in gioco la realtà aumentata (AR).

Noi, un gruppo di ricercatori appassionati, ci siamo tuffati nel mondo dell’urologia, e in particolare della prostatectomia radicale, per sviluppare un sistema di navigazione che sia facile da usare, preciso e che, idealmente, funzioni con l’hardware che già si trova in sala operatoria. Niente più aggeggi extra che interrompono il flusso di lavoro!

Le Sfide della Navigazione Chirurgica Attuale

Molti sistemi di navigazione proposti per la chirurgia mininvasiva si basano su immagini stereoscopiche, ma nella pratica clinica si usano spesso endoscopi monoculari. E per le prostatectomie? Beh, i sistemi di navigazione automatica basati su video sono ancora merce rara. Il nostro obiettivo era quindi duplice: affrontare queste due lacune contemporaneamente per gli interventi di prostatectomia robot-assistita.

Pensateci: alcuni approcci attuali richiedono che il chirurgo sposti, ruoti e scali manualmente un modello 3D della prostata del paziente durante tutto l’intervento. Altri usano ultrasuoni, tracciamento ottico o magnetico, o fluorescenza. Tutte cose utili, per carità, ma spesso non fanno parte della routine clinica standard e possono essere invasive o macchinose. C’è chi ha provato con le reti neurali convoluzionali (CNN) per segmentare il catetere vescicale e da lì predire l’orientamento della prostata, ma noi volevamo qualcosa di ancora più generale e meno dipendente da elementi specifici o fasi particolari dell’intervento.

La nostra idea? Un sistema che si basi solo sulle informazioni video e che riduca al minimo l’interazione manuale. Per questo abbiamo scelto un approccio monoculare basato sulla registrazione 2D-3D, una tecnica che sta prendendo piede in neurochirurgia, chirurgia epatica e uterina. Il problema, però, è che spesso questi metodi si affidano all’identificazione di punti di riferimento (landmark) geometrici, che nella prostatectomia sono scarsi e i contorni difficili da definire univocamente. Altri metodi usano texture o ombreggiature, ma possono fallire se le strutture bersaglio sono occluse.

La Nostra Soluzione: “Cues” Visive e Rendering Differenziabile

Ecco la nostra proposta: un overlay di realtà aumentata markerless (senza marcatori fisici) basato su video per la prostatectomia navigata. Come funziona? Utilizziamo dei “cue” (indizi, segnali) visivi flessibili, definiti dall’utente direttamente sulle strutture anatomiche, che vengono poi tracciati nel flusso video endoscopico. A questo abbiniamo una registrazione rigida 2D-3D basata sul rendering differenziabile per stimare la posa delle strutture anatomiche rispetto alla telecamera virtuale.

È un approccio semi-automatico: serve un po’ di interazione manuale all’inizio, in un “key frame” (un fotogramma chiave), e poi più nessun input da parte dell’utente. In pratica:

- Si crea un modello 3D dalla risonanza magnetica preoperatoria della prostata e delle strutture vicine (fasci neurovascolari, ghiandole vescicolari).

- Nel key frame iniziale, il chirurgo allinea manualmente il modello 3D con le strutture anatomiche visibili nel video endoscopico.

- Subito dopo, disegna dei “cue” visivi direttamente sull’immagine della prostata e dei fasci neurovascolari. Questo è geniale perché ci permette di acquisire simultaneamente dati 2D (dall’immagine) e 3D (dal modello) sul cue.

La maschera di segmentazione ottenuta viene usata per inizializzare il tracciamento del cue nei fotogrammi successivi, mentre una mesh 3D del cue viene costruita proiettando il cue 2D sul modello preoperatorio. Questi cue disegnati vengono approssimati da punti chiave connessi da linee. Per tracciare questi punti nel video endoscopico, abbiamo usato CoTracker, un metodo che, una volta inizializzato con un set di coordinate di punti e l’immagine corrispondente, predice la posizione dei punti chiave nei fotogrammi seguenti.

Registrazione 2D-3D: PnPRansac vs. Rendering Differenziabile

Per far “combaciare” il mondo 2D del video con il modello 3D, abbiamo esplorato due metodi: PnPRansac (usato come baseline) e il rendering differenziabile. Quest’ultimo è particolarmente interessante: si tratta di una tecnica in cui il normale processo di rendering di un’immagine viene modificato per renderlo, appunto, “differenziabile”. L’output renderizzato viene confrontato con un’immagine di riferimento per calcolare un “errore” (loss) in 2D, che può essere propagato all’indietro attraverso la pipeline di rendering per ottimizzare i parametri desiderati.

Nel nostro caso, abbiamo implementato un renderer differenziabile usando PyTorch3D. Questo disegna solo la silhouette del cue fornito e calcola l’errore quadratico medio tra l’immagine renderizzata e la maschera 2D fornita dal tracker. Questo errore viene poi minimizzato ottimizzando la posizione e l’orientamento del cue nello spazio coordinate della telecamera virtuale, usando l’algoritmo Adam. La posa stimata con l’errore più basso viene scelta e usata come inizializzazione per il fotogramma successivo, e così via.

Perché usare i cue sulla superficie dell’organo invece delle silhouette delle strutture anatomiche? Per minimizzare i problemi di occlusione. Ad esempio, renderizzare la silhouette di un modello 3D della prostata isolata potrebbe creare una maschera che include regioni sempre oscurate da altri organi, come la vescica, nella vista intraoperatoria. Questo renderebbe difficile la gestione dell’errore nel processo di rendering differenziabile.

I Test: Dal Sintetico al Reale

Per validare il nostro metodo, abbiamo condotto esperimenti su due set di dati:

- Dataset Sintetico: Composto da 504 scene di forme 3D generate casualmente, simili a organi (per simulare lo stato intraoperatorio di un organo), all’interno di una forma cava più grande (che simula la cavità addominale insufflata). I cue erano generati casualmente sulla superficie dell’organo. In ogni scena, immagini dell’organo simulato e dei cue venivano renderizzate da 15 diverse pose casuali della telecamera. Questo ci ha permesso di parametrizzare l’approccio di rendering differenziabile in condizioni ideali.

- Dataset In Vivo: Abbiamo catturato video della fase di staging di due prostatectomie robot-assistite (con il robot DaVinci Xi) presso l’Ospedale Universitario Carl Gustav Carus di Dresda. Per ogni paziente, avevamo una risonanza magnetica preoperatoria da cui abbiamo costruito un modello 3D specifico. Un paziente è stato usato per la parametrizzazione e l’altro per la valutazione.

Sui dati sintetici, il rendering differenziabile ha raggiunto un errore mediano di registrazione del target (TRE) di 6.11 mm. Questo è considerato accettabile (range 5-10 mm) per i tumori nella prostatectomia navigata, il che è molto promettente per future applicazioni cliniche! La traslazione mediana dell’errore della posa della telecamera è stata ridotta da 4.86 a 3.04 mm e l’errore di rotazione mediano da 3.66 a 1.43 gradi.

Sui dati in vivo, sia PnPRansac che il rendering differenziabile sono stati in grado di tracciare il movimento delle strutture anatomiche. CoTracker ha mostrato un errore mediano di tracciamento di 2,46 pixel per il paziente 1 e 5,36 pixel per il paziente 2, dimostrando una buona robustezza anche con movimenti rapidi della telecamera, deformazioni e occlusioni da parte degli strumenti. Questo fornisce una base eccellente per la registrazione 2D-3D.

Cosa Abbiamo Imparato e Prospettive Future

Il nostro metodo proposto dipende da un buon allineamento iniziale, che attualmente è manuale. Stiamo conducendo uno studio clinico per determinarne la fattibilità, ma in futuro questo passaggio potrebbe essere automatizzato.

Abbiamo identificato alcune cause per l’errore residuo. Ad esempio, l’immagine viene sfocata dal renderer differenziabile per rendere l’effetto di un cambio di posa della telecamera meno “rumoroso” sulla loss. Questo, però, riduce l’accuratezza perché il cue renderizzato è sistematicamente diluito ai bordi. Bisognerà trovare un compromesso migliore.

Sui dati in vivo, il rendering differenziabile a volte “esagerava” la rotazione o il cue stimato si ribaltava, specialmente con cue simmetrici (un triangolo non equilatero, ad esempio, previene questo problema). È anche risultato meno robusto di PnPRansac se i punti chiave non venivano tracciati correttamente. D’altro canto, PnPRansac ha mostrato un problema quando i punti 3D del cue giacevano su un piano, portando a due possibili soluzioni simmetriche per la posa della telecamera.

Nonostante queste sfide, entrambi i metodi riescono a seguire le strutture anatomiche durante la deformazione. PnPRansac lavora naturalmente con i punti chiave, mentre il rendering differenziabile offre un framework flessibile dove diversi tipi di informazioni (maschere, contorni, profondità) possono essere processati. E poiché l’intera pipeline di rendering è differenziabile, in futuro potremmo ottimizzare altri parametri, come la posizione dei vertici stessi, aprendo la possibilità di catturare la deformazione dell’organo.

In conclusione, abbiamo dimostrato la fattibilità di un overlay di realtà aumentata markerless basato su video per la prostatectomia navigata. L’aggiunta di cue “al volo” tracciati durante l’intervento, combinata con PnPRansac e il rendering differenziabile, fornisce un framework di registrazione 2D-3D che non dipende dalla visibilità e dalla corretta segmentazione di specifiche strutture anatomiche. La possibilità di interazione potrebbe anche permettere all’utente di correggere i cue predetti. È un passo avanti entusiasmante che, speriamo, porterà a interventi più sicuri e con migliori risultati per i pazienti!

Fonte: Springer