Prevedere l’Imprevedibile: Terremoti e Ondate di Calore in Italia Sotto la Lente Statistica

Ciao a tutti! Oggi voglio parlarvi di qualcosa che mi appassiona molto: come possiamo usare la statistica, e in particolare dei modelli matematici chiamati autoregressioni di Poisson, per cercare di prevedere eventi estremi come i terremoti e le ondate di calore qui in Italia. Sembra fantascienza? Forse un po’, ma vi assicuro che è un campo di ricerca fondamentale, soprattutto pensando ai rischi legati ai disastri naturali e ai cambiamenti climatici che stiamo vivendo.

L’Italia, lo sappiamo bene, è un paese meraviglioso ma anche fragile. Siamo spesso soggetti a terremoti, specialmente lungo le Alpi e gli Appennini. Pensate che negli ultimi 2500 anni ci sono stati più di 30.000 sismi, alcuni devastanti. E non dimentichiamo il clima: siamo nel cuore dell’emisfero boreale, con un clima generalmente temperato, ma le temperature possono variare tantissimo da nord a sud, e le estati diventano sempre più roventi, con ondate di calore intense.

La Sfida: Modellare Eventi Rari e Complessi

Prevedere quando e dove colpirà il prossimo terremoto o quando arriverà la prossima ondata di calore eccezionale è incredibilmente difficile. Questi eventi non accadono con regolarità, e la loro frequenza può dipendere da tantissimi fattori, inclusi gli eventi passati. Ecco perché i modelli statistici “semplici” spesso non bastano.

Qui entrano in gioco le autoregressioni di Poisson. Cosa sono? Immaginate di contare quanti terremoti (sopra una certa soglia) o quanti giorni con temperature altissime (diciamo sopra i 30°C) ci sono ogni mese. La distribuzione di Poisson è un classico strumento statistico per modellare questo tipo di “conteggi”. Ma noi vogliamo fare un passo in più: vogliamo che il modello “impari” dal passato. L’idea “autoregressiva” significa proprio questo: il numero di eventi futuri potrebbe dipendere da quanti ne sono successi di recente.

Nel mio studio, ho messo sotto la lente quattro diversi tipi di modelli Poisson per vedere quale se la cava meglio nel fare previsioni:

- Un modello Poisson standard: il più semplice, assume che la frequenza media degli eventi sia costante nel tempo. Una sorta di punto di partenza.

- Un modello Poisson autoregressivo (PAR): qui introduciamo la “memoria”. La frequenza attesa degli eventi dipende da quanti eventi ci sono stati nel periodo precedente e dalla frequenza stessa nel periodo precedente.

- Un modello Poisson autoregressivo con covariate (PARX): ancora più sofisticato. Oltre alla memoria, aggiungiamo delle “covariate”, cioè delle variabili esterne che pensiamo possano influenzare il fenomeno. Per i terremoti, potrebbe essere un trend temporale di lungo periodo; per le temperature, potrebbero essere le stagioni (ovviamente!).

- Un modello Poisson autoregressivo a soglia auto-eccitante (SETPAR): questo è interessante perché permette al modello di cambiare comportamento. Ad esempio, la frequenza degli eventi potrebbe seguire regole diverse a seconda che nel passato ci siano stati pochi o tanti eventi (superando una certa “soglia”). Questo modello è bravo anche a catturare dipendenze negative (un periodo di alta attività seguito da uno di calma).

Mettere alla Prova i Modelli: Prima le Simulazioni

Prima di lanciarci sui dati reali, ho voluto fare un po’ di “allenamento” con delle simulazioni al computer (tecnicamente si chiama studio Monte Carlo). Ho creato delle serie storiche artificiali che imitassero le caratteristiche principali dei dati reali di terremoti e temperature (come trend e “salti” improvvisi nella frequenza). Poi ho usato i quattro modelli per fare previsioni “un passo avanti” (prevedere il mese successivo) e ho visto quali ci azzeccavano di più.

Per valutare le previsioni, ho usato due misure principali:

- L’Errore Quadratico Medio di Previsione (MSFE): misura quanto, in media, le previsioni si discostano dai valori reali. Più basso è, meglio è.

- Il Punteggio Medio di Previsione (FS): valuta quanto bene il modello prevede l’intera distribuzione di probabilità degli eventi, non solo il valore medio. Più alto è, meglio è.

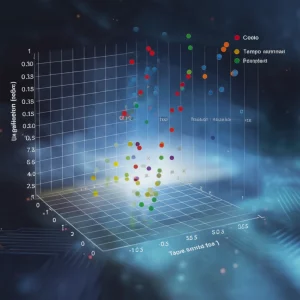

Cosa è emerso dalle simulazioni? Che i modelli PARX (quello con le covariate) e SETPAR (quello a soglia) erano generalmente i migliori, anche se la loro performance dipendeva un po’ dalle caratteristiche specifiche dei dati simulati. Questo ci ha dato fiducia nel fatto che questi modelli più complessi potessero davvero fare la differenza.

Il Test sul Campo: I Terremoti Italiani

A questo punto, ero pronto per i dati reali. Ho preso i dati mensili dei conteggi dei terremoti in Italia dal gennaio 1900 al dicembre 2020, forniti dall’Istituto Nazionale di Geofisica e Vulcanologia (INGV). Parliamo di oltre 120 anni di storia sismica!

Ho usato una tecnica chiamata “finestra mobile” (rolling window): ho addestrato i modelli su una parte iniziale dei dati, ho fatto una previsione per il mese successivo, poi ho spostato la finestra avanti di un mese (includendo il nuovo dato e scartando il più vecchio) e ho ripetuto il processo per gli ultimi 20 anni di dati (2001-2020). Questo simula come faremmo previsioni in tempo reale, usando solo le informazioni disponibili fino a quel momento.

E il vincitore per i terremoti? Il modello PARX, quello che includeva un trend deterministico come covariata. Ha ottenuto i risultati migliori sia guardando quanto bene si adattava ai dati passati (usando criteri come AIC e BIC), sia, cosa più importante, nelle previsioni future (miglior MSFE e FS). Questo suggerisce che tenere conto di una tendenza di lungo periodo nell’attività sismica (o almeno, nei dati registrati) è fondamentale per fare previsioni più accurate. Il semplice modello Poisson base è risultato il peggiore, come c’era da aspettarsi.

Il Test sul Campo: Le Ondate di Calore in Sei Città Italiane

Poi sono passato alle temperature. Ho raccolto i dati mensili del numero di giorni con temperatura massima uguale o superiore a 30°C, dal gennaio 1973 a giugno 2024, per sei città italiane rappresentative: Torino, Milano, Bologna, Roma, Napoli e Palermo. Queste città coprono diverse zone climatiche del paese.

Anche qui ho usato la procedura di previsione a finestra mobile per gli ultimi anni (dal 2016 al 2024). Per il modello PARX, questa volta la covariata più ovvia erano le stagioni! Ho inserito delle variabili “dummy” per indicare i mesi tipicamente più caldi (da maggio a ottobre).

I risultati per le temperature sono stati più… variegati!

- Guardando l’adattamento ai dati passati (AIC e BIC), il modello SETPAR (quello a soglia) è risultato il migliore per tutte le città. Questo ha senso: il modello a soglia può catturare bene la differenza tra i mesi invernali (pochi o zero giorni caldi) e quelli estivi (molti giorni caldi).

- Guardando le previsioni future con l’MSFE (quanto ci si avvicina al numero esatto di giorni caldi), il modello PARX con le variabili stagionali ha vinto su tutta la linea, per tutte e sei le città. Includere l’informazione sulla stagionalità è chiaramente cruciale per prevedere il *livello* delle temperature estreme.

- Guardando le previsioni future con l’FS (quanto bene si prevede la distribuzione), la situazione si è fatta più mista: il modello PAR (quello autoregressivo semplice) è risultato il migliore per Milano, Bologna, Roma e Napoli. Il PARX ha vinto a Palermo, mentre il SETPAR ha primeggiato a Torino.

Cosa ci Portiamo a Casa?

Questo viaggio tra statistica, terremoti e caldo estremo ci dice alcune cose importanti. Innanzitutto, i modelli Poisson autoregressivi, specialmente quelli che includono informazioni aggiuntive (covariate come trend o stagionalità, cioè i PARX), sembrano strumenti molto promettenti per migliorare le nostre capacità di previsione di questi eventi estremi in Italia.

Per i terremoti, il modello PARX con un trend temporale si è dimostrato il più performante nel nostro studio. Per le ondate di calore, la situazione è più sfumata: il PARX con le stagioni è ottimo per prevedere *quanti* giorni caldi ci saranno (MSFE), ma altri modelli (PAR o SETPAR) potrebbero essere migliori nel catturare la variabilità e la distribuzione di questi eventi (FS), a seconda della città specifica.

Ovviamente, la previsione esatta di questi fenomeni resta una sfida enorme. Ma ogni passo avanti nella modellazione statistica ci aiuta a comprendere meglio i rischi, a prepararci e, speriamo, a gestire meglio le conseguenze dei disastri naturali e dei cambiamenti climatici. È un lavoro continuo, ma credo ne valga assolutamente la pena!

Fonte: Springer