Cancro del Colon-Retto: Come l’IA Sta Imparando a Prevedere la Sopravvivenza (Anche Quando i Dati Fanno i Capricci!)

Ciao a tutti! Oggi voglio portarvi dietro le quinte di una sfida affascinante nel mondo della ricerca medica e dell’intelligenza artificiale: prevedere la sopravvivenza dei pazienti affetti da cancro del colon-retto. So che suona un po’ tecnico, ma fidatevi, è una storia che merita di essere raccontata, perché tocca corde profonde sulla speranza e sulle potenzialità della tecnologia.

Il cancro del colon-retto, purtroppo, è uno di quei “big killer” a livello mondiale. Pensate che, combinando tutti gli stadi, ha un tasso di mortalità intorno al 64.5%. Capire chi ha più probabilità di sopravvivere a 1, 3 o 5 anni dalla diagnosi è fondamentale. Perché? Perché permette ai medici di personalizzare le cure, di prendere decisioni più informate e, in definitiva, di dare ai pazienti le migliori chance possibili. Qui entra in gioco l’analisi dei dati clinici, un tesoro di informazioni che, se letto correttamente, può svelare pattern nascosti.

La Sfida Nascosta: i Dati Sbilanciati

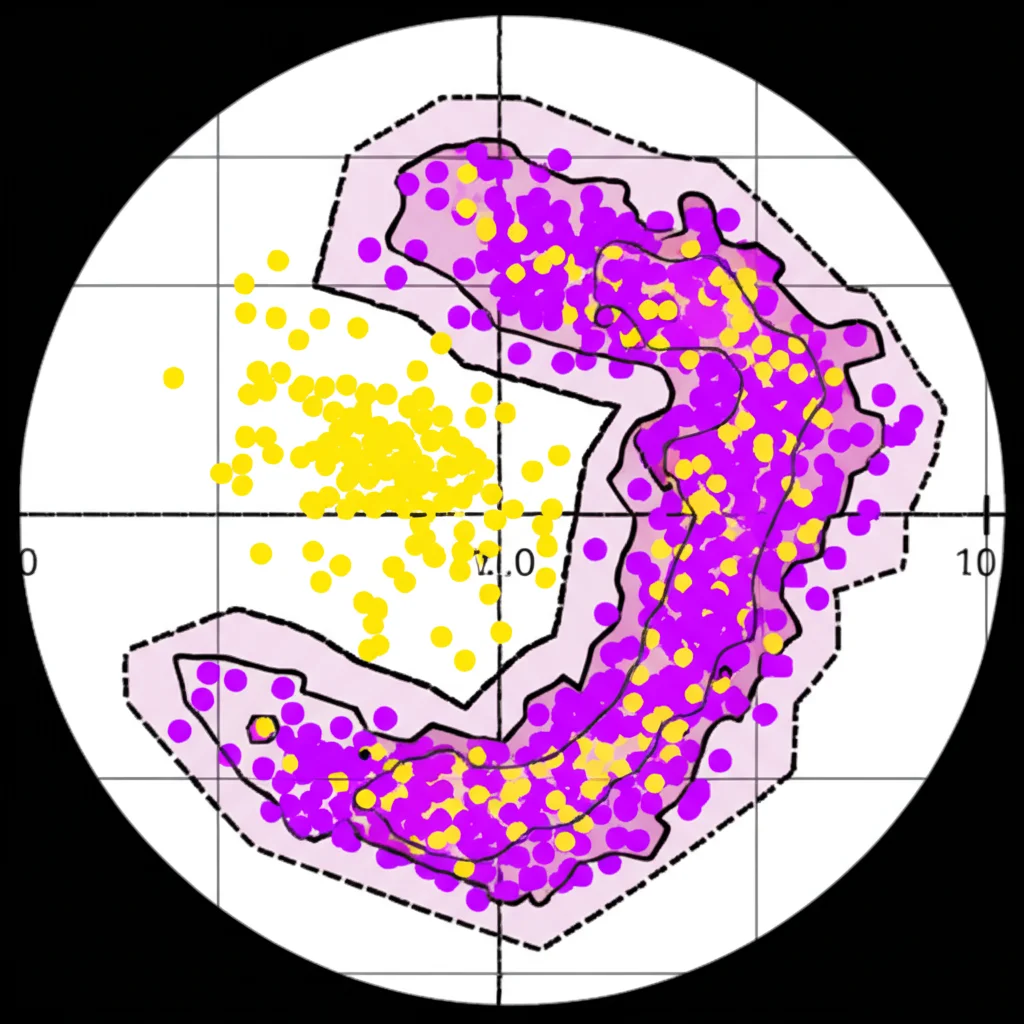

Ed è proprio qui che le cose si complicano. Immaginate di avere una montagna di dati sui pazienti. Sembra fantastico, no? Il problema è che spesso questi dati sono “sbilanciati”. Cosa significa? Nel nostro caso, soprattutto per la previsione a 1 anno, avevamo molti più dati di pazienti sopravvissuti che di pazienti deceduti (un rapporto di circa 10 a 1!).

Potreste pensare: “Beh, meglio così, no?”. Dal punto di vista umano, assolutamente sì! Ma per un algoritmo di machine learning, questo è un bel grattacapo. L’algoritmo, vedendo così tanti “sopravvissuti”, tende a diventare “pigro” e a prevedere quasi sempre quell’esito, ottenendo magari un’accuratezza generale alta, ma fallendo miseramente nel riconoscere i casi più a rischio (la classe minoritaria, i non sopravvissuti). È come cercare un ago (i pazienti a rischio) in un pagliaio enorme (i pazienti che sopravvivono): l’algoritmo finisce per dire “è tutto paglia!”. Questo si traduce in una bassa “sensibilità”, ovvero la capacità di identificare correttamente i veri positivi (in questo caso, i pazienti che purtroppo non ce la faranno).

Per il nostro studio, abbiamo usato i dati del database SEER (Surveillance, Epidemiology, and End Results), un’enorme raccolta di informazioni sui tumori negli Stati Uniti. Dopo una bella “pulizia” – via i dati mancanti, accorpamento di categorie troppo piccole per non creare confusione – ci siamo ritrovati con circa 42.764 casi. E sì, lo sbilanciamento per la sopravvivenza a 1 anno era ancora più marcato!

La Nostra Arma Segreta: Campionamento Ibrido e Classificatori Intelligenti

Come abbiamo affrontato questo “squilibrio”? Abbiamo sperimentato diverse tecniche di “campionamento”, che servono proprio a bilanciare il dataset prima di darlo in pasto agli algoritmi.

- Undersampling (Sotto-campionamento): Tecniche come ENN (Edited Nearest Neighbor) e RENN (Repeated Edited Nearest Neighbor) provano a “pulire” la classe maggioritaria, eliminando i campioni più “rumorosi” o vicini al confine con l’altra classe. È un po’ come togliere un po’ di paglia per vedere meglio l’ago.

- Oversampling (Sovra-campionamento): Tecniche come SMOTE (Synthetic Minority Over-sampling Technique) fanno il contrario: creano nuovi campioni “sintetici” ma realistici della classe minoritaria. È come aggiungere più aghi simili all’originale per renderli più visibili.

Ma noi abbiamo voluto provare qualcosa di più: un approccio ibrido. In particolare, abbiamo testato una pipeline RENN + SMOTE: prima puliamo un po’ la classe maggioritaria con RENN, eliminando il rumore, e *poi* potenziamo la classe minoritaria con SMOTE. L’idea è di ottenere il meglio dei due mondi: meno rumore e più rappresentazione per chi è in minoranza.

Una volta bilanciati (o meno, per confronto) i dati, li abbiamo dati in pasto a una squadra di classificatori “basati su alberi”. Perché proprio loro? Perché sono noti per essere robusti, abbastanza interpretabili (almeno i singoli alberi decisionali) e spesso performano bene con dati complessi come quelli clinici. Abbiamo messo alla prova:

- Decision Tree (Albero Decisionale)

- Random Forest (Foreste Casuali)

- Extra Trees (Alberi Estremamente Casuali)

- XGBoost (eXtreme Gradient Boosting)

- LGBM (Light Gradient Boosting Machine)

Questi ultimi due, XGBoost e LGBM, sono versioni “potenziate” che combinano tanti alberi in modo intelligente (tecniche di boosting) e sono spesso tra i migliori performer nelle competizioni di machine learning.

I Risultati: Cosa Abbiamo Scoperto?

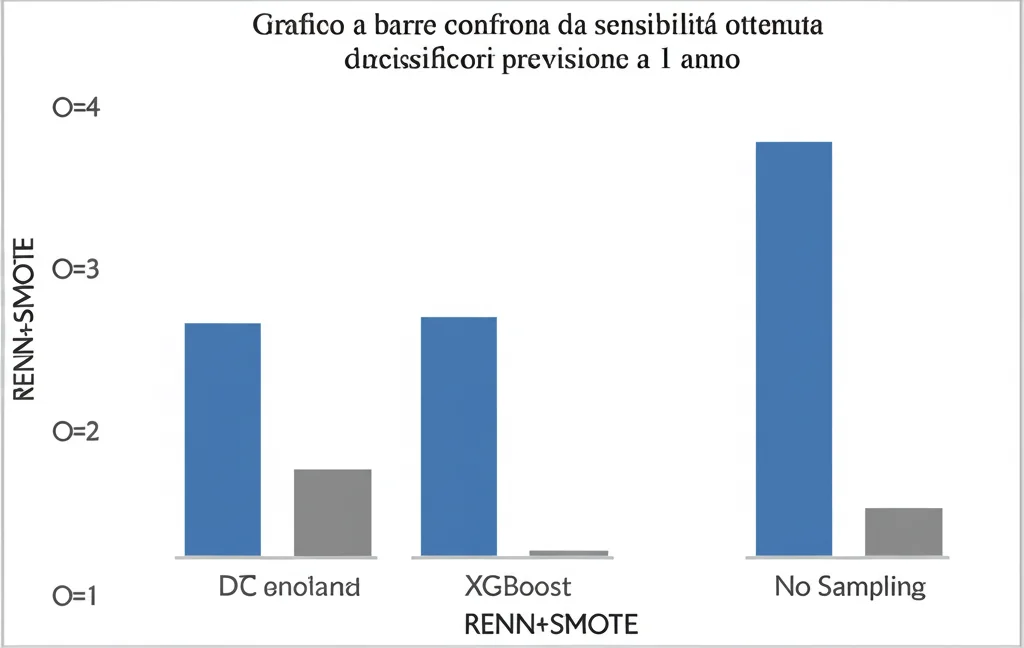

E qui viene il bello! Per valutare le performance, abbiamo usato una tecnica chiamata “cross-validation a 5 fold” (dividiamo i dati in 5 parti, alleniamo su 4 e testiamo sulla quinta, ripetendo 5 volte per essere sicuri dei risultati) e misurato diverse metriche, ma ci siamo concentrati soprattutto sulla sensibilità (la capacità di beccare i non-sopravvissuti) e sull’F1-score (una media armonica tra precisione e sensibilità, che dà un’idea generale dell’equilibrio del modello).

Sopravvivenza a 1 anno (il caso più sbilanciato):

Senza nessun campionamento, i risultati erano deludenti, con sensibilità bassissime (attorno al 10%). Ma… applicando la nostra strategia ibrida RENN + SMOTE, in combinazione con l’algoritmo LGBM, abbiamo fatto un balzo incredibile! La sensibilità è schizzata al 72.30%! È quasi 9 volte meglio rispetto a non fare nulla e circa il 15% in più rispetto a usare solo RENN o solo SMOTE. Questo ci dice che la nostra idea di “pulire e poi potenziare” funziona alla grande quando lo sbilanciamento è forte. L’F1-score è anche migliorato notevolmente, indicando un modello molto più equilibrato.

Sopravvivenza a 3 anni (sbilanciamento moderato):

Qui lo sbilanciamento era minore (circa 2 a 10). In questo caso, la combinazione migliore è stata RENN (il sotto-campionamento “ripetuto”) con LGBM, raggiungendo una sensibilità dell’80.81%. L’approccio ibrido RENN+SMOTE ha dato risultati simili, ma non superiori a RENN da solo. Questo suggerisce che per sbilanciamenti meno estremi, tecniche più semplici potrebbero essere sufficienti (e magari computazionalmente meno costose).

Sopravvivenza a 5 anni (dati quasi bilanciati):

Qui i dati erano abbastanza equilibrati. LGBM si è confermato il migliore, ottenendo la sensibilità più alta (63.03%) e il miglior F1-score, anche senza tecniche di campionamento particolarmente aggressive.

Cosa Significa Tutto Questo?

Questi risultati sono entusiasmanti! Dimostrano che, anche partendo da dati “difficili” e sbilanciati, possiamo sviluppare strumenti di intelligenza artificiale che aiutino concretamente i medici. Migliorare la capacità di prevedere la sopravvivenza, soprattutto per i casi più a rischio (la classe minoritaria), significa poter intervenire prima, scegliere terapie più mirate e dare informazioni più accurate ai pazienti e alle loro famiglie.

Certo, c’è un prezzo da pagare. Il nostro metodo ibrido RENN+SMOTE, pur essendo efficace, richiede più tempo di calcolo rispetto a non usare campionamento o usare tecniche più semplici. Ma con la potenza di calcolo disponibile oggi, pensiamo che il gioco valga la candela, specialmente nei casi di forte sbilanciamento dove fa davvero la differenza.

Il nostro lavoro evidenzia l’importanza cruciale di affrontare il problema dello sbilanciamento dei dati nella previsione della sopravvivenza. L’approccio ibrido che abbiamo proposto sembra essere una strada promettente, capace di bilanciare la necessità di identificare i casi a rischio (alta sensibilità) senza perdere troppa precisione generale.

Ovviamente, la ricerca non si ferma qui. Ci sono tante altre strade da esplorare: come gestire i dati mancanti in modi ancora più intelligenti, selezionare le caratteristiche (features) più importanti, provare altri algoritmi di machine learning o deep learning, e magari ottimizzare ulteriormente il rapporto tra RENN e SMOTE nel nostro approccio ibrido.

Ma per ora, siamo felici di aver aggiunto un piccolo tassello alla comprensione di come l’IA possa diventare un’alleata sempre più preziosa nella lotta contro il cancro del colon-retto. È un viaggio complesso, fatto di dati, algoritmi e tanta statistica, ma con un obiettivo chiarissimo: migliorare la vita delle persone.

Fonte: Springer