Allacciate le Cinture: Sveliamo i Segreti per Prevedere la Turbolenza Aerea!

Vi è mai capitato di sobbalzare sul sedile durante un volo, magari con un caffè che fa una brutta fine sulla camicia? Ecco, spesso la colpa è della turbolenza indotta da convezione (CIT, per gli amici), un fenomeno atmosferico che è un vero grattacapo per l’aviazione. Non solo provoca qualche spavento e disagio ai passeggeri (a volte, purtroppo, anche infortuni), ma causa anche ritardi, problemi nella gestione del traffico aereo e costi operativi non indifferenti per le compagnie.

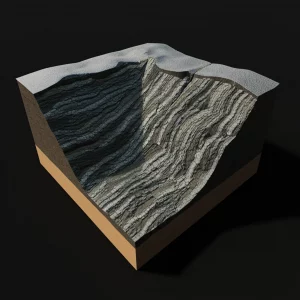

Parliamoci chiaro: prevedere la CIT è una sfida enorme. Perché? Beh, i modelli meteorologici tradizionali, quelli che usiamo per le previsioni del tempo “normali”, lavorano a risoluzioni troppo basse. Non riescono a “vedere” i movimenti convettivi, quelle correnti ascensionali e discensionali potenti che si scatenano dentro e vicino ai temporali, su scale di pochi chilometri. E sono proprio questi movimenti a generare gran parte della turbolenza più severa in quota.

Da dove Nasce la Turbolenza Convettiva?

La CIT può avere diverse origini, tutte legate ai “capricci” delle nubi convettive, come i cumulonembi:

- Quando la convezione “sfonda” verso l’alta troposfera, può intensificare i venti già presenti (wind shear).

- I forti gradienti di galleggiamento ai bordi delle nuvole deformano il flusso d’aria circostante.

- La convezione può innescare onde di gravità che, propagandosi verso l’alto, possono “rompersi” e generare turbolenza, anche lontano dalla nube stessa.

I metodi attuali per prevedere la turbolenza si basano spesso su indici empirici, legati a misure indirette come le onde di gravità o l’instabilità atmosferica. Funzionano, per carità, ma la risoluzione dei modelli rimane un limite. Sistemi come il GTG (Graphical Turbulence Guidance) hanno fatto passi da gigante, passando da risoluzioni di 20 km a 13 km, e si riconosce che per cogliere certi eventi servirebbero risoluzioni ancora più spinte, sotto i 3 km o addirittura 1 km. Ma simulare l’intero globo a queste risoluzioni è, al momento, proibitivo in termini di costi computazionali per le previsioni operative.

La Nostra Scommessa: Zoomare Dove Serve

E se potessimo usare modelli ad altissima risoluzione solo dove serve davvero, nelle aree dove si prevede forte convezione? È qui che entra in gioco il nostro studio. Abbiamo utilizzato un modello chiamato MPAS (Model for Prediction Across Scales). La sua figata? Usa una griglia flessibile, come una ragnatela a maglie variabili: fittissima (risoluzione di ~1 km, quella che chiamiamo “convection-permitting”, capace di risolvere la convezione) nelle zone di interesse (nel nostro caso, vicino a Hong Kong, dove abbiamo analizzato alcuni incidenti di CIT reali), e molto più larga altrove nel mondo. Un modo intelligente per avere il dettaglio che serve senza fondere i supercomputer!

Ma non basta avere una simulazione dettagliata. Bisogna tradurre quei dati complessi in qualcosa di utile per i piloti e i controllori di volo. Lo standard internazionale per misurare l’intensità della turbolenza è l’EDR (Eddy Dissipation Rate), che misura quanta energia cinetica viene trasferita dai vortici più grandi a quelli più piccoli, fino a dissiparsi. Più alto è l’EDR, più forte è lo scossone.

Un Nuovo Modo per “Vedere” la Turbolenza: Il Metodo SFSR

I metodi tradizionali per calcolare l’EDR dalle simulazioni si basano spesso sulle “funzioni di struttura di secondo ordine” (2ndSF) o sulla stima della resistenza d’onda gravitazionale convettiva (CGWD). Sono tecniche valide, ma hanno i loro limiti, specialmente a risoluzioni così alte.

Così, abbiamo sviluppato e testato un nuovo metodo per stimare l’EDR direttamente dai campi di vento simulati da MPAS. Lo abbiamo chiamato SFSR (Subfilter-Scale Reconstruction). L’idea di base, presa in prestito dalle simulazioni a grandissima turbolenza (LES), è quella di “ricostruire” esplicitamente l’energia cinetica turbolenta (TKE) sia alle scale che il modello risolve direttamente, sia a quelle leggermente più piccole (subfiltro) che non riesce a catturare del tutto, ma che possiamo stimare. Sommando questi contributi, otteniamo una stima della TKE totale, da cui poi deriviamo l’EDR.

Abbiamo confrontato il nostro SFSR con i metodi 2ndSF e CGWD usando i dati di cinque reali incidenti di CIT riportati vicino a Hong Kong. I risultati sono stati incoraggianti! Il metodo SFSR ha prodotto una distribuzione e un’intensità della turbolenza diverse dagli altri metodi, mostrando una maggiore accuratezza e una migliore correlazione con le osservazioni reali per i casi che abbiamo testato. Sembra cogliere meglio la turbolenza, specialmente quella legata allo shear verticale del vento, cosa che gli altri metodi faticano a fare direttamente.

Risoluzione: Quanto Dettaglio Serve Davvero?

Abbiamo anche esplorato l’impatto della risoluzione. Abbiamo fatto girare MPAS con risoluzioni nella zona “calda” di 1 km, 3 km, 9 km e 18 km. Come prevedibile, la simulazione a 1 km ha dato i risultati EDR più accurati e pattern spaziali migliori. Riesce a “vedere” dettagli della convezione e della turbolenza associata che le altre risoluzioni si perdono. Però, ragazzi, che fatica computazionale! Una simulazione a 1 km richiede risorse enormi.

La simulazione a 3 km, invece, si è rivelata un ottimo compromesso: offre un’accuratezza ragionevole a un costo computazionale molto più accessibile. Le risoluzioni più grossolane (9 km, 18 km) iniziano a perdere troppi dettagli e tendono a sovrastimare l’estensione delle aree turbolente con il metodo SFSR, probabilmente perché non risolvono più adeguatamente la convezione.

La “Zona Grigia” e l’Importanza degli Ensemble

Lavorare a risoluzioni “convection-permitting” (come 1 km o 3 km) ci porta in quella che chiamiamo la “zona grigia”. Siamo abbastanza dettagliati da iniziare a risolvere la convezione direttamente, ma non abbastanza da catturare tutta la fisica fine senza l’aiuto di alcune parametrizzazioni (semplificazioni) per processi come la microfisica delle nubi (come si formano gocce, ghiaccio, etc.) o la convezione stessa (specialmente a 3 km).

Questo introduce incertezza. Quale schema di microfisica usare? È meglio lasciare che il modello sviluppi la convezione da solo o aiutarlo con uno schema di parametrizzazione cumulus (anche se “scale-aware”, cioè consapevole della scala)? Abbiamo testato diverse opzioni. Variare queste scelte (ad esempio, usare lo schema microfisico WSM6 invece del Thompson, o disattivare del tutto la parametrizzazione cumulus GF) ha effettivamente cambiato le simulazioni, a volte in modo significativo, influenzando l’intensità, la tempistica e la localizzazione della convezione e, di conseguenza, della turbolenza prevista.

Questo ci dice una cosa fondamentale: per previsioni affidabili, soprattutto per fenomeni “capricciosi” come la convezione, serve un approccio “ensemble”. In pratica, si fanno girare tante simulazioni leggermente diverse (variando le fisiche, come abbiamo fatto noi, o le condizioni iniziali) per avere un’idea della gamma di possibilità e dell’incertezza della previsione. Abbiamo visto che variare gli schemi fisici e numerici può generare una utile “dispersione” (spread) nell’ensemble, aiutando a catturare la stocasticità della convezione. Tuttavia, questo tipo di ensemble basato solo sulle perturbazioni fisiche ha i suoi limiti; per coprire al meglio le incertezze, specialmente nello sviluppo iniziale della convezione, le perturbazioni delle condizioni iniziali rimangono probabilmente necessarie.

Uno Sguardo ai Numeri: Statistiche e Performance

Analizzando tutti i casi e le diverse simulazioni dell’ensemble, abbiamo confermato che il metodo SFSR tende a produrre valori massimi di EDR più vicini a quelli osservati rispetto al metodo 2ndSF, suggerendo una maggiore capacità di rilevare eventi di turbolenza severa (maggiore Probability of Detection, POD). Statisticamente, la distribuzione dei valori EDR calcolati con SFSR assomiglia di più a quella osservata in studi precedenti, anche se tende a sovrastimare leggermente i valori bassi di EDR (sotto 0.1).

Abbiamo anche usato le curve ROC (Relative Operating Characteristic) per valutare la performance. Selezionando il “membro migliore” dell’ensemble (quello che si avvicinava di più all’osservazione per ogni caso), sia SFSR che 2ndSF mostrano capacità predittiva superiore a una scelta casuale, con SFSR che ha una performance leggermente migliore (area sotto la curva, AUC, più grande). Tuttavia, se usiamo semplicemente la media dell’ensemble, la performance cala drasticamente per entrambi i metodi. Questo suggerisce che per la previsione della turbolenza, una semplice media dell’ensemble potrebbe non essere l’approccio migliore; servono metodi di post-processing più sofisticati o modi per selezionare i membri più probabili.

Cosa Ci Portiamo a Casa?

Questo studio ci ha mostrato alcune cose importanti:

- Usare modelli a risoluzione variabile come MPAS, con dettaglio elevato (~1-3 km) nelle aree critiche, è una strada promettente per prevedere la CIT.

- Il nostro nuovo metodo SFSR per calcolare l’EDR sembra più accurato e cattura meglio la turbolenza osservata rispetto ai metodi tradizionali come 2ndSF e CGWD, specialmente in presenza di forte shear verticale.

- La risoluzione di 3 km offre un buon equilibrio tra accuratezza e costo computazionale, rendendola potenzialmente utilizzabile in futuro per sistemi operativi.

- L’approccio ensemble è cruciale per gestire l’incertezza intrinseca nella previsione della convezione e della turbolenza associata. Variare gli schemi fisici è utile, ma probabilmente va combinato con perturbazioni delle condizioni iniziali.

Certo, c’è ancora lavoro da fare. Il metodo SFSR va ulteriormente testato e calibrato, magari usando più dati osservativi. Bisogna capire come si comporta con altri tipi di turbolenza (come quella orografica o in aria chiara). E dobbiamo sviluppare metodi migliori per usare le informazioni dell’ensemble.

Ma la strada è tracciata. Con simulazioni sempre più potenti e metodi di analisi più raffinati, speriamo di poter fornire in futuro previsioni della turbolenza sempre più precise, contribuendo a rendere i nostri voli ancora più sicuri e confortevoli. E magari, a salvare qualche caffè dalla forza di gravità!

Fonte: Springer