Ottimizzazione Industriale: Decidi Meglio Sfruttando l’Incertezza!

Ciao a tutti! Oggi voglio parlarvi di una sfida affascinante nel mondo della produzione industriale: come prendere le decisioni migliori quando ci sono mille variabili in gioco e, soprattutto, tanta incertezza. Sapete, ottimizzare un processo produttivo non è mai semplice. Spesso dobbiamo bilanciare obiettivi contrastanti: vogliamo la massima qualità del prodotto, ma anche ridurre i costi e aumentare la velocità di produzione. Un bel rompicapo, vero?

La Complessità dei Processi Produttivi

Immaginate un processo industriale: ci sono parametri di input (come temperature, pressioni, tempi) e risultati di output (la qualità del pezzo, l’energia consumata, ecc.). Le relazioni tra questi elementi sono spesso complesse, a volte quasi misteriose. Per capirci qualcosa e trovare le impostazioni ottimali, spesso usiamo dei “modelli surrogati”. Cosa sono? In pratica, sono delle approssimazioni matematiche che cercano di imitare il comportamento del processo reale, permettendoci di esplorare diverse combinazioni di parametri senza dover fare migliaia di test costosi direttamente sulla linea di produzione. Funzionano, ma c’è un “ma”.

Il Problema Nascosto: l’Incertezza

Il “ma” è l’incertezza. I processi reali non sono mai perfettamente prevedibili. Ci sono piccole variazioni nelle materie prime, fluttuazioni ambientali, usura delle macchine… Tutta questa variabilità, che chiamiamo incertezza aleatoria (è quella casualità intrinseca che non possiamo eliminare del tutto, anche se conosciamo bene il processo), può portare i nostri modelli surrogati a darci indicazioni non proprio perfette. Rischiamo di scegliere parametri che sembrano ottimali sulla carta, ma che poi nella realtà si rivelano meno performanti o meno robusti del previsto.

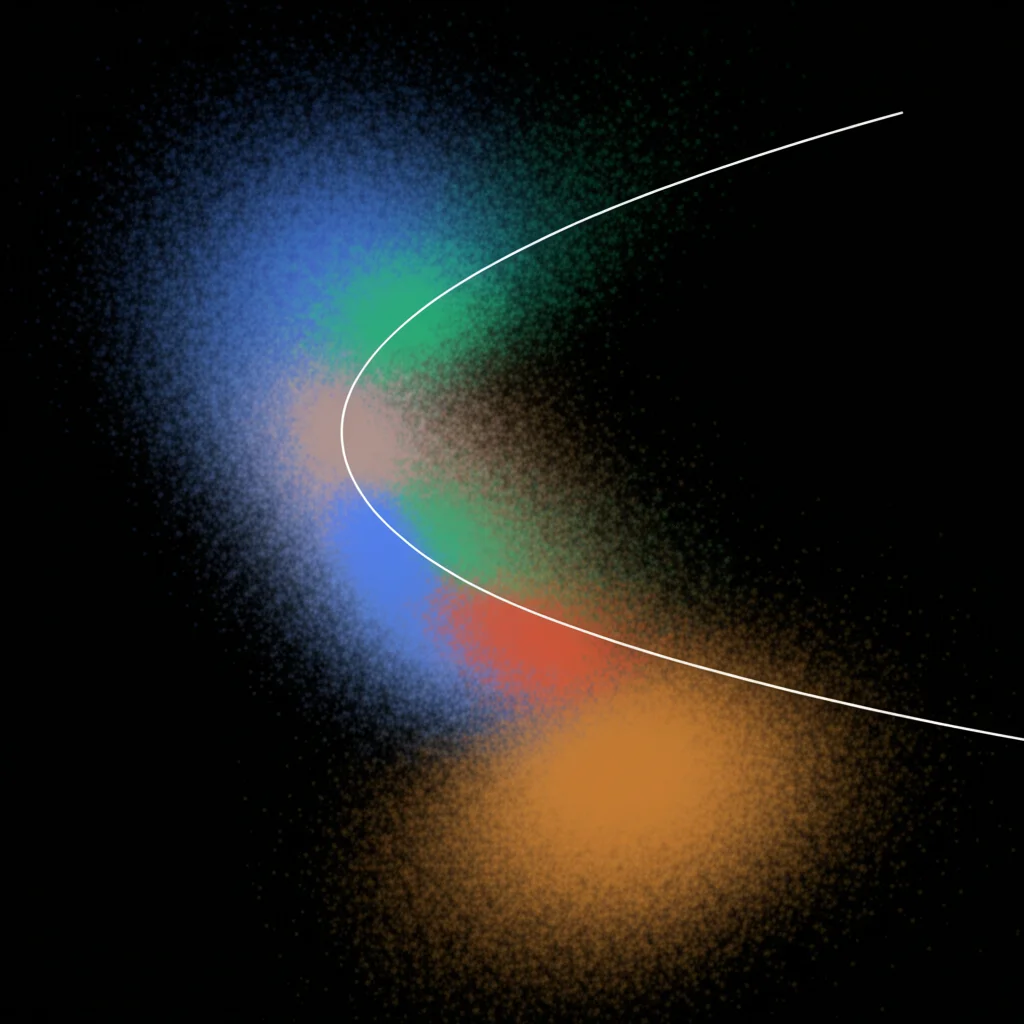

Pensate a dover scegliere tra due possibili configurazioni, A e B. Magari B sembra dare risultati mediamente migliori, ma è molto più sensibile alle piccole fluttuazioni del processo. A, invece, pur essendo leggermente meno performante in condizioni ideali, è molto più stabile. Se il nostro modello non tiene conto di questa incertezza, potremmo scegliere B e ritrovarci con risultati altalenanti. L’obiettivo è trovare il famoso “Fronte di Pareto”: l’insieme delle soluzioni migliori dove non puoi migliorare un obiettivo (es. ridurre i costi) senza peggiorarne un altro (es. la qualità). L’incertezza può farci sbagliare nel definire questo fronte.

La Nostra Proposta: Modelli Grafici Probabilistici e Conoscenza Esperta

Ecco dove entriamo in gioco noi con un approccio un po’ diverso. Abbiamo pensato: perché non usare modelli che non solo approssimano il processo, ma quantificano anche questa benedetta incertezza? E se potessimo integrare in questi modelli anche la conoscenza che già abbiamo sul processo, quella che deriva dall’esperienza degli ingegneri e dei tecnici?

Abbiamo deciso di esplorare l’uso dei Modelli Grafici Probabilistici (PGM), in particolare le Reti Causali Grafiche (GCM). Immaginate una mappa dove i nodi sono le variabili del processo (input, stati intermedi, output) e le frecce indicano le relazioni causali tra loro. La cosa bella è che possiamo:

- Inserire le relazioni che già conosciamo come funzioni fisse (l’esperienza conta!).

- Usare modelli probabilistici, come la Regressione Gaussiana di Processo (GPR), per approssimare le relazioni che non conosciamo bene, ma facendolo in modo da stimare non solo il valore medio, ma anche la distribuzione di probabilità attorno a quel valore (cioè l’incertezza).

In pratica, costruiamo un modello “ibrido” che mescola dati e conoscenza esperta, e che ci dà una visione molto più realistica di come si comporterà il processo, incertezza inclusa.

Perché la Probabilità Fa la Differenza (Soprattutto con Funzioni Strane)

“Ok,” potreste dire, “ma cosa cambia in pratica?” Cambia molto, specialmente quando nel processo ci sono delle funzioni non lineari, come delle soglie. Immaginate che un prodotto sia considerato “buono” solo se una certa caratteristica (diciamo, la sua luminosità misurata) supera un valore di soglia, altrimenti è scarto (valore zero).

Se usiamo un modello tradizionale che predice solo il valore medio, potremmo trovare un punto operativo che ci dà una luminosità media appena sopra la soglia. Sembrerebbe ottimo! Ma se il nostro modello probabilistico ci dice che, a causa dell’incertezza, c’è una probabilità non trascurabile che la luminosità scenda sotto la soglia, allora quel punto non è poi così buono. Il nostro approccio, lavorando con le distribuzioni di probabilità, ci permette di “vedere” questo rischio.

Quando applichiamo la funzione di soglia non solo al valore medio, ma all’intera distribuzione prevista, otteniamo una stima del valore atteso del prodotto molto più realistica. Questo porta a un Fronte di Pareto più conservativo: magari non ci illude con prestazioni eccezionali che sono difficili da mantenere stabilmente, ma ci guida verso soluzioni veramente robuste. Il punto che sembrava ottimale nel modello medio, ora potrebbe rivelarsi subottimale quando consideriamo l’intera distribuzione.

Mettiamolo alla Prova: Un Caso Studio Reale (in Scala)

Per vedere se tutto questo funzionava davvero, abbiamo messo in piedi un esperimento in un ambiente di laboratorio che simula un processo industriale: l’asciugatura o cottura di prodotti. Abbiamo usato un sistema modulare chiamato Festo CP Factory, molto versatile. Il nostro “prodotto” erano dei fogli speciali a cristalli liquidi che cambiano colore con la temperatura (intorno ai 40°C).

L’obiettivo era duplice:

- Massimizzare il “valore del prodotto” (PV), basato sulla luminosità del colore finale misurata da un sistema di visione. C’era una soglia: se la luminosità (chiamata V nello spazio colore HSV) era sotto 200, il prodotto valeva zero (scarto), altrimenti valeva V.

- Minimizzare l’energia consumata (E) dal forno usato per scaldare i fogli.

Le variabili su cui potevamo agire (le nostre “leve decisionali”) erano la durata dell’esposizione nel forno e la temperatura impostata. Ovviamente, c’erano fattori di incertezza: piccole variazioni nella potenza del forno, nel tempo di trasporto, nella luce ambientale, ecc.

Abbiamo costruito il nostro modello GCM basato sulla conoscenza del processo e sui dati raccolti da un campionamento iniziale. Abbiamo usato la GPR per modellare le relazioni sconosciute (come la luminosità V dipendesse da tempo e temperatura) quantificando l’incertezza.

I Risultati: Cosa Abbiamo Scoperto

Abbiamo confrontato il nostro approccio GCM probabilistico con tre metodi di riferimento:

- Decisione diretta sui dati originali (spesso troppo ottimistica perché influenzata da outlier fortunati).

- Un modello GPR singolo (senza la struttura causale e la conoscenza esperta integrata).

- Un modello GCM basato solo sui valori medi (senza considerare la distribuzione dell’incertezza).

Abbiamo generato i Fronti di Pareto per ciascun metodo. Come previsto, il metodo diretto dava un fronte molto ottimista. La GPR singola era più realistica, ma ancora un po’ troppo ottimista. I metodi GCM (basato sulla media e il nostro probabilistico) mostravano un andamento più complesso, riflettendo la soglia di qualità.

La differenza chiave è emersa proprio vicino alla soglia. Il metodo GCM basato sulla media mostrava un “ginocchio” netto nel fronte: sembrava molto vantaggioso operare appena sopra la soglia. Il nostro metodo GCM probabilistico, invece, mostrava una transizione più graduale. Perché? Perché teneva conto che anche operando con una media leggermente sopra la soglia, una parte della distribuzione poteva cadere sotto, riducendo il valore atteso reale.

Abbiamo poi scelto un punto operativo ottimale da ciascun fronte (usando una funzione peso per bilanciare qualità ed energia) e abbiamo testato questi setpoint nel processo reale, ripetendo l’operazione 32 volte per vedere la performance media e la variabilità.

I risultati sono stati chiari: i metodi baseline tendevano a sovrastimare la qualità ottenibile. Il loro punto operativo “ottimale” portava spesso a prodotti sotto soglia. Il nostro metodo GCM probabilistico, invece, aveva suggerito un setpoint leggermente più “costoso” in termini di energia (più tempo nel forno), ma questo si è tradotto in una performance media reale significativamente migliore e più robusta, con molti meno scarti. In pratica, spendere un po’ più di energia ci ha permesso di essere più sicuri di superare la soglia di qualità, ottenendo un risultato complessivo decisamente superiore quando valutato con gli stessi criteri economici.

Conclusioni e Prossimi Passi

Cosa ci portiamo a casa da tutto questo? Che considerare esplicitamente l’incertezza aleatoria nei processi produttivi, usando modelli probabilistici come i GCM che integrano anche la conoscenza esperta, può davvero fare la differenza. Ci permette di creare Fronti di Pareto più realistici e di scegliere punti operativi più robusti, che funzionano meglio nel mondo reale, anche se sulla carta potrebbero non sembrare i più “estremi”.

È un passo avanti verso decisioni più consapevoli e affidabili nell’ottimizzazione industriale. Certo, c’è ancora strada da fare. Sarebbe interessante applicare questo approccio a problemi più complessi, magari dinamici o con tantissime variabili. E un altro aspetto chiave per il futuro è rendere questi modelli ancora più “spiegabili”, in modo che gli ingegneri e i manager possano fidarsi delle indicazioni fornite e capire *perché* viene suggerita una certa soluzione.

Ma la direzione è tracciata: capire e gestire l’incertezza non è solo un esercizio accademico, è una leva concreta per migliorare le performance delle nostre fabbriche!

Fonte: Springer