Intelligenza Artificiale nel Deserto: Sveliamo i Segreti del Sottosuolo Egiziano con i Log di Pozzo

Ciao a tutti! Oggi voglio raccontarvi di un’avventura affascinante nel mondo della geofisica e dell’intelligenza artificiale. Immaginate di essere nel Deserto Occidentale dell’Egitto, nel campo petrolifero di Shahd SE. Qui, come in molti altri posti, capire cosa c’è sotto i nostri piedi è fondamentale, specialmente se si cerca petrolio o gas. Uno strumento chiave per farlo sono i log sonici compressionali (li chiameremo DTC, da Compressional Sonic Logs). Questi log misurano quanto tempo impiega un’onda acustica (come un’onda P) ad attraversare le rocce laggiù nel sottosuolo.

Perché i Log Sonici Sono Così Importanti?

Beh, questi dati sono oro colato! Ci dicono un sacco di cose:

- La litologia: di che tipo di roccia stiamo parlando? Arenaria, argilla, calcare?

- La porosità: quanti spazi vuoti ci sono nella roccia, che potrebbero contenere idrocarburi?

- Le proprietà meccaniche: quanto è resistente la roccia? Questo è cruciale per la stabilità del pozzo durante la perforazione e per pianificare operazioni come la fratturazione idraulica (il famoso “fracking”).

In geofisica, usiamo i log sonici per calibrare i dati sismici, creando dei “sismogrammi sintetici” che ci aiutano a interpretare meglio le immagini del sottosuolo. In petrofisica, ci aiutano a stimare la porosità e a capire come si comporterà la roccia. In ingegneria petrolifera, sono fondamentali per perforare in sicurezza e ottimizzare la produzione. Insomma, sono davvero indispensabili.

La Sfida: Ottenere i Dati

Qui arriva il “ma”. Ottenere questi log sonici non è una passeggiata. Costa parecchio, richiede tempo aggiuntivo con l’impianto di perforazione fermo e, a volte, può essere rischioso. Tenere il pozzo aperto a lungo per far scendere gli strumenti può compromettere la stabilità delle formazioni rocciose, specialmente quelle argillose. E se il pozzo collassa… beh, non è una bella notizia.

Nel campo di Shahd SE, nonostante ci siano molti pozzi e dati sismici ad alta risoluzione, spesso c’è una discrepanza tra quello che ci aspettiamo di trovare basandoci sulla sismica e quello che poi troviamo perforando. Avere log sonici affidabili aiuterebbe tantissimo a calibrare i modelli di velocità sismica e a interpretare meglio le strutture sotterranee. Inoltre, sono fondamentali per progettare la fratturazione idraulica necessaria in alcune formazioni come la Upper Bahariya.

La Nostra Idea: E se Usassimo l’Intelligenza Artificiale?

Ecco dove entra in gioco la nostra ricerca. Ci siamo chiesti: e se potessimo prevedere i valori del log sonico compressionale usando altri dati di log di pozzo che sono più comuni, meno costosi e più facili da ottenere? Parlo di log come il Gamma Ray (GR), la Densità (RHOB), la Resistività profonda (Deep_Res), il log Neutronico (NPHI) e il Fattore Fotoelettrico (PE). Questi log vengono registrati quasi sempre.

L’idea è usare l’apprendimento automatico (Machine Learning – ML). In pratica, addestriamo un computer a riconoscere le relazioni complesse tra questi log “convenzionali” e il log sonico, basandosi sui dati di pozzi dove entrambi i tipi di log sono disponibili. Una volta che il modello ha “imparato” queste relazioni, possiamo usarlo per prevedere il log sonico in pozzi dove non è stato misurato. Figo, no?

Il Nostro Viaggio: Dati, Modelli e Ottimizzazione

Abbiamo preso i dati da cinque pozzi nel campo di Shahd SE, concentrandoci sull’intervallo di interesse geologico, dalla formazione A/R “F” fino alla cima della formazione Kharita. Il primo passo, fondamentale, è stato “pulire” i dati.

Mettere Ordine nei Dati: Preprocessing

I modelli di ML sono un po’ schizzinosi: vogliono dati completi e puliti. Abbiamo dovuto gestire i valori mancanti. Invece di buttare via intere righe di dati (che sarebbe stato uno spreco), abbiamo usato un metodo di imputazione, stimando i valori mancanti basandoci sui punti vicini. Dato che i log hanno una risoluzione molto alta (mezzo piede!), le proprietà della roccia non cambiano drasticamente in così poco spazio, quindi questo approccio funziona bene.

Poi, abbiamo dovuto affrontare gli outlier, cioè quei valori anomali che possono mandare in tilt il modello. Ad esempio, abbiamo trovato valori di densità o neutronici fuori dal range geologicamente plausibile per le rocce presenti (arenarie, argille, siltiti, calcari). Per identificarli e rimuoverli in modo automatico ed efficiente, abbiamo usato un algoritmo chiamato Isolation Forest. È un metodo intelligente che “isola” i valori anomali. Dopo questa pulizia, i nostri dati erano molto più coerenti e pronti per il passo successivo. Abbiamo anche aggiunto un’informazione preziosa: l’interpretazione delle litofacies (i tipi di roccia) basata sui log convenzionali e sulle descrizioni dei campioni di roccia (mud log). Questa è diventata una feature aggiuntiva per i nostri modelli.

Scegliere gli Ingredienti Giusti: Feature Selection e Engineering

Non tutte le informazioni sono ugualmente utili. Abbiamo analizzato la correlazione tra i vari log di input e il nostro target (il log sonico DTC). Abbiamo scoperto che quasi tutti i log mostravano una buona correlazione, tranne la resistività profonda. Curiosamente, però, usando il logaritmo della resistività, la correlazione migliorava parecchio! Quindi, abbiamo deciso di usare il logaritmo della resistività come input invece del valore originale.

Un altro passo importante è stato gestire la feature categorica delle litofacies. I computer preferiscono i numeri, quindi abbiamo trasformato le categorie (shale, sandstone, siltstone, limestone) in variabili binarie usando una tecnica chiamata one-hot encoding.

Infine, per alcuni modelli di ML (come SVM, KNN e reti neurali), è fondamentale normalizzare i dati, cioè portarli tutti sulla stessa scala. Questo evita che una feature con valori molto grandi domini sulle altre. Abbiamo usato la standardizzazione (Standard Scaling). Per altri modelli, come quelli basati su alberi decisionali (Random Forest, CatBoost, XGBoost), la normalizzazione non è strettamente necessaria e, anzi, abbiamo visto che a volte può peggiorare leggermente i risultati.

Addestrare le “Menti Artificiali”: Modelli e Tuning

A questo punto, eravamo pronti per addestrare i nostri modelli. Ne abbiamo provati diversi:

- Metodi Ensemble: Random Forest (RF), CatBoost, XGBoost. Questi combinano le previsioni di molti modelli più semplici (alberi decisionali) per ottenere un risultato più robusto e accurato. Sono un po’ come chiedere il parere a tanti esperti diversi.

- K-Nearest Neighbors (KNN): Un approccio più semplice che prevede il valore per un nuovo punto basandosi sulla media dei suoi “vicini” più prossimi nei dati di addestramento.

- Support Vector Machines (SVM): Un modello potente che cerca di trovare il miglior “confine” (o iperpiano) per separare o fittare i dati, anche in spazi complessi.

- Deep Neural Networks (DNN): Reti neurali profonde, ispirate al cervello umano, capaci di apprendere pattern molto complessi nei dati.

Per ogni modello, non basta solo addestrarlo. Bisogna trovare i suoi iperparametri ottimali, che sono un po’ come le manopole di regolazione del modello. Abbiamo usato una tecnica chiamata Grid Search, che prova sistematicamente diverse combinazioni di iperparametri per trovare quella che dà i risultati migliori. È un processo che richiede potenza di calcolo, ma è cruciale per spremere il massimo dai modelli.

Il Momento della Verità: Valutazione e Risultati

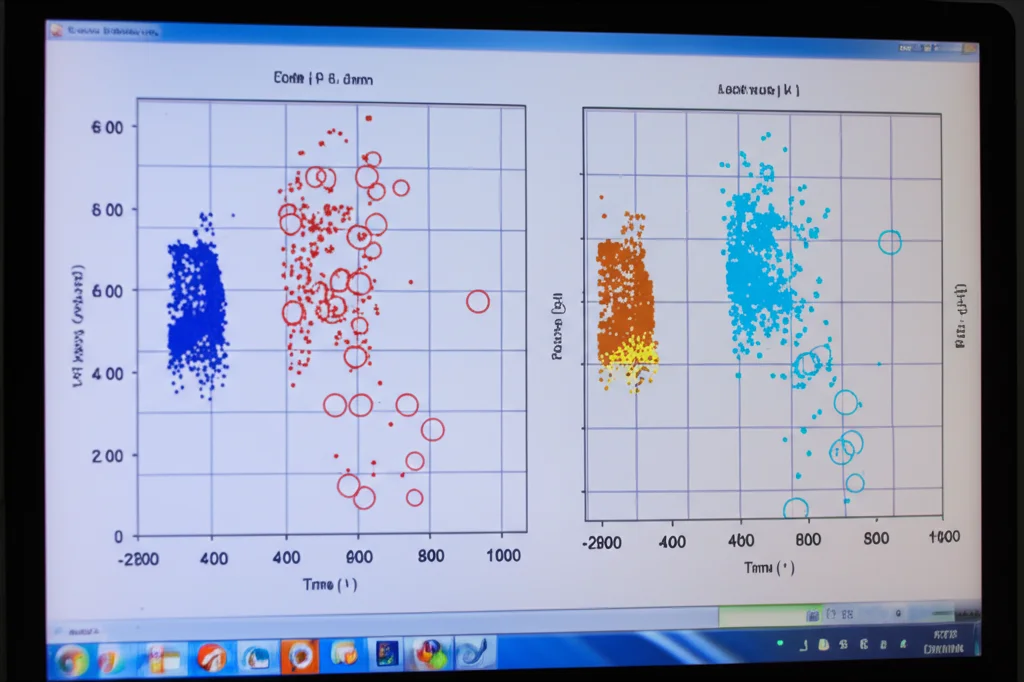

Come abbiamo valutato le performance? Abbiamo usato metriche standard come il Coefficiente di Correlazione (R-squared), che ci dice quanto bene il modello spiega la variabilità dei dati reali, e l’Errore Quadratico Medio (RMSE), che misura l’errore medio delle previsioni.

Abbiamo diviso i nostri dati: quattro pozzi per addestrare e testare i modelli (80% per training, 20% per testing interno), e un quinto pozzo tenuto completamente da parte come “blind test well”. Questo è fondamentale: testare il modello su dati che non ha mai visto durante l’addestramento o la messa a punto ci dà una misura realistica di come si comporterà “nel mondo reale”.

I risultati sono stati entusiasmanti! I modelli ensemble (Random Forest, CatBoost, XGBoost) hanno nettamente superato gli altri. Hanno mostrato ottime performance sia sul set di test interno che, soprattutto, sul pozzo “blind”.

- CatBoost è emerso come uno dei migliori, con un’ottima correlazione (quasi 90%) e un RMSE basso sul blind well (circa 5.85).

- Anche Random Forest e XGBoost hanno fatto benissimo, con performance molto simili.

- KNN, SVM e DNN, pur dando risultati decenti, hanno mostrato un errore leggermente maggiore e una tendenza a sottostimare i valori reali sul blind well.

Abbiamo anche analizzato l’importanza delle feature per il modello migliore (CatBoost). È venuto fuori che il Gamma Ray (GR), la Densità (RHOB) e il Fattore Fotoelettrico (PE) erano le informazioni più influenti per la previsione del log sonico. Questo ha senso dal punto di vista geologico!

Perché Tutto Questo è Importante?

Questa ricerca dimostra che possiamo sviluppare un flusso di lavoro robusto basato sul machine learning per prevedere i log sonici compressionali con alta accuratezza, usando dati di log convenzionali. Questo offre una soluzione economica ed efficiente quando misurare direttamente il log sonico è difficile o troppo costoso.

I vantaggi sono concreti:

- Migliore caratterizzazione del sottosuolo: Avere log sonici accurati, anche se sintetici, migliora la nostra comprensione delle rocce, della loro porosità e delle loro proprietà meccaniche.

- Ottimizzazione della gestione del giacimento: Decisioni più informate sulla perforazione, completamento dei pozzi e strategie di produzione.

- Analisi geomeccanica più affidabile: Previsione della stabilità del pozzo e progettazione efficace della fratturazione idraulica.

- Riduzione delle incertezze: Migliore calibrazione sismica e interpretazione geofisica.

Il modello CatBoost, in particolare, si è dimostrato molto promettente e adattabile, superando i limiti di alcuni modelli empirici tradizionali. E la cosa bella è che questo approccio può essere esteso per prevedere anche altri tipi di log, come quelli delle onde di taglio (shear sonic) o le proprietà elastiche delle rocce.

In conclusione, è stato un viaggio incredibile vedere come l’intelligenza artificiale possa aiutarci a svelare i segreti nascosti sotto la sabbia del deserto egiziano, trasformando dati comuni in informazioni preziose e aprendo nuove strade per l’esplorazione e lo sviluppo delle risorse energetiche in modo più efficiente e sicuro.

Fonte: Springer