Operatori di Koopman Profondi: Svelato il Segreto della Loro Magia!

Amici scienziati e appassionati di misteri, vi siete mai trovati di fronte a un sistema così intricato da far girare la testa? Pensate al meteo, alla turbolenza di un fluido, o persino alle dinamiche di una malattia che si diffonde. Roba complessa, vero? Per decenni, noi ricercatori abbiamo cercato modi per “semplificare” questi mostri matematici. E qui entra in gioco una vecchia conoscenza, l’operatore di Koopman.

Immaginate di poter prendere un sistema non lineare, uno di quelli che fanno i capricci e non seguono regole semplici, e trasformarlo magicamente in un sistema lineare, bello ordinato e prevedibile. Sembra fantascienza, ma è l’idea di base dietro Koopman. Lo fa “sollevando” il nostro sistema in uno spazio di funzioni più grande, chiamate osservabili di Koopman. Il problema è: come scegliamo queste funzioni, questo “dizionario” di trasformazioni?

Recentemente, l’apprendimento profondo (deep learning) ha fatto irruzione sulla scena con algoritmi come il deep Dynamic Mode Decomposition (deepDMD). Questi metodi sembrano fare magie, imparando da soli le funzioni giuste e ottenendo risultati strabilianti sia nella precisione del modello che nella scalabilità con la dimensione del sistema originale. Ma, come spesso accade con il deep learning, ci siamo chiesti: perché diavolo funzionano così bene? È questo il mistero che abbiamo cercato di svelare.

I Vecchi Metodi e i Loro Limiti: L’Approccio del “Dizionario Fisso”

Prima del deep learning, l’approccio più comune, come nell’Extended Dynamic Mode Decomposition (EDMD), era quello di definire a priori un “dizionario” di funzioni. Potevano essere polinomi, funzioni di Fourier, insomma, una sorta di cassetta degli attrezzi predefinita. Il problema? Se il tuo dizionario non conteneva gli “attrezzi” giusti per il sistema specifico, i risultati erano così così. E peggio ancora, per sistemi molto grandi, questi dizionari definiti dall’uomo, con non linearità piazzate su una griglia uniforme, diventavano enormi, ingestibili, scalando esponenzialmente con la dimensione dello spazio degli stati. Un po’ come cercare di costruire un modellino di astronave con i mattoncini per bambini: tanti pezzi, ma non quelli che ti servono davvero per fare un lavoro di precisione.

La teoria ci dice che gli operatori di Koopman non dovrebbero necessariamente avere bisogno di un numero esponenziale di parametri per scalare con la dimensione dello stato. Quindi, c’era qualcosa che non tornava. Certo, ci sono stati tentativi di migliorare la situazione, come l’algoritmo SINDy che usa la regressione sparsa, o la decomposizione simmetrica di sottospazi, ma i modelli basati sul deep learning sembravano avere una marcia in più.

Deep Learning al Microscopio: Cosa Abbiamo Scoperto?

L’algoritmo deepDMD usa una rete neurale artificiale profonda per selezionare queste osservabili. Essendo le reti neurali degli approssimatori universali di funzioni, possono imparare una vasta classe di osservabili continue. E funziona! Ma le reti neurali sono spesso delle “scatole nere”. Noi volevamo aprirla, questa scatola, e capire cosa succedeva dentro.

Analizzando i dizionari imparati da deepDMD, abbiamo notato qualcosa di interessante. Le funzioni che la rete neurale “sceglieva” avevano delle caratteristiche ricorrenti. Questo ci ha ispirato a definire una nuova classe di funzioni dizionario, che abbiamo chiamato State-Inclusive Logistic Lifting (SILL). “State-Inclusive” perché includono direttamente lo stato del sistema, e “Logistic Lifting” perché contengono funzioni non lineari che sono, essenzialmente, funzioni logistiche congiuntive multivariate. Queste funzioni logistiche agiscono un po’ come degli interruttori morbidi, mappando certe regioni dello spazio degli stati a quasi 1 e il resto a quasi 0.

La cosa cruciale che abbiamo scoperto è che questi dizionari SILL soddisfano una proprietà che abbiamo definito chiusura finita approssimata uniforme. Detta semplice: quando l’operatore di Koopman (o meglio, il suo generatore) agisce su una funzione del nostro dizionario SILL, il risultato può essere approssimato molto bene da una combinazione lineare delle funzioni già presenti nel dizionario, con un errore limitato uniformemente. Questa è una manna dal cielo! Significa che il nostro dizionario è “quasi” autosufficiente e non esplode dimensionalmente all’infinito per rappresentare le dinamiche.

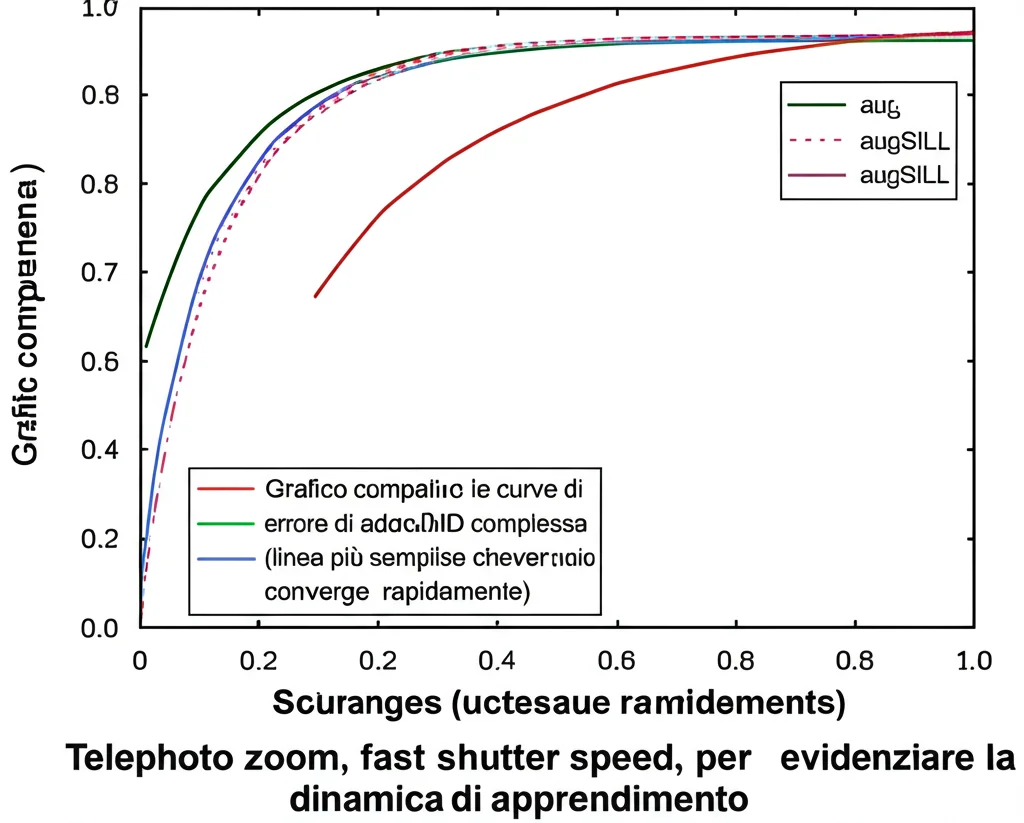

Abbiamo dimostrato matematicamente che l’errore di questa approssimazione nei modelli SILL diminuisce esponenzialmente all’aumentare della “ripidezza” (steepness) delle funzioni logistiche e all’aumentare della dimensionalità delle misure di stato incluse nei dati. Questo spiega in parte il successo di deepDMD, ma c’era dell’altro.

Il Colpo di Scena: Non Solo SILL, Ma un Cocktail di Funzioni!

Osservando ancora più da vicino (guardate la Figura 1 del paper originale, se siete curiosi!), ci siamo accorti che deepDMD non imparava solo funzioni di tipo SILL. Imparava un mix eterogeneo, un cocktail di funzioni provenienti da diverse classi! In particolare, abbiamo notato la presenza di profili che assomigliavano a delle “campane”, ovvero le funzioni a base radiale (RBF) congiuntive.

Questa è stata una vera illuminazione! Tradizionalmente, i metodi basati su dizionario usano dizionari omogenei (tutte funzioni dello stesso tipo, es. tutti polinomi). Noi ci siamo chiesti: e se creassimo deliberatamente un dizionario eterogeneo, mescolando le nostre funzioni SILL con queste RBF congiuntive? Così è nato il dizionario augSILL (SILL aumentato).

La sfida era capire se anche questo dizionario “Frankenstein” mantenesse le buone proprietà di chiusura. Mescolare basi diverse aumenta l’efficienza rappresentativa, ma la proprietà di invarianza del sottospazio (o chiusura) non è scontata. Dopo un bel po’ di lavoro sulle derivate di Lie (non entriamo nei dettagli, ma fidatevi, è stato divertente!), abbiamo dimostrato che anche i dizionari augSILL soddisfano la chiusura finita approssimata uniforme! L’errore si comporta bene, proprio come per i SILL puri.

La Prova del Nove: augSILL Batte DeepDMD (sul Suo Stesso Terreno?)

A questo punto, dovevamo mettere alla prova le nostre idee. Abbiamo confrontato le prestazioni del nostro dizionario augSILL con quelle di deepDMD e dei classici dizionari polinomiali (Legendre e Hermite) su vari sistemi non lineari, come l’oscillatore di Van der Pol, l’oscillatore di Duffing, il modello preda-predatore di Lotka-Volterra e persino un modello a sette dimensioni della glicolisi.

I risultati sono stati entusiasmanti!

- I modelli augSILL hanno raggiunto una precisione paragonabile a deepDMD, ma con un ordine di grandezza in meno di parametri! Per il modello della glicolisi, augSILL usava 995 parametri contro i 3.949 di deepDMD, raggiungendo la stessa accuratezza di predizione in meno di 1000 epoche di addestramento.

- Sia SILL che augSILL hanno stracciato i dizionari polinomiali. In alcuni casi, augSILL è risultato fino a 372 volte più accurato dei modelli basati su polinomi di Legendre per modelli a 20 dimensioni. Questo suggerisce che i problemi di EDMD potrebbero essere risolti scegliendo un dizionario con provata chiusura finita approssimata uniforme.

- Un altro aspetto importante è l’interpretabilità. Mentre deepDMD è una scatola nera, i parametri del nostro dizionario augSILL (centri, ripidezze, pesi delle funzioni logistiche e RBF) mantengono un significato geometrico.

Abbiamo anche confrontato diversi algoritmi per scegliere i parametri del dizionario augSILL, come il matching pursuit e la discesa stocastica del gradiente (SGD). L’SGD si è rivelato più efficiente per costruire modelli più grandi, mantenendo un’ottima accuratezza.

Perché Tutto Questo è Importante?

Il nostro lavoro fa un po’ di luce sul perché algoritmi di deep learning come deepDMD funzionino così bene nell’approssimare gli operatori di Koopman. La chiave sembra risiedere nella loro capacità di imparare (implicitamente) dizionari di funzioni eterogenee che possiedono questa cruciale proprietà di chiusura finita approssimata uniforme.

Ma non ci siamo fermati alla comprensione. Abbiamo proposto un’alternativa, il dizionario augSILL, che offre prestazioni simili a deepDMD ma con molti meno parametri, maggiore interpretabilità e solide garanzie teoriche. Questo apre la strada alla costruzione di modelli di Koopman ad alta fedeltà, a bassa dimensionalità, strutturati e interpretabili per sistemi dinamici complessi.

In pratica, abbiamo fornito una sorta di “ricetta” per costruire dizionari potenti, senza dover ricorrere alla complessità computazionale e alla natura di “scatola nera” delle reti neurali profonde per questo specifico compito. È un passo avanti, crediamo, per rendere l’apprendimento basato su dizionari per l’identificazione di sistemi dinamici più scalabile, interpretabile e, in definitiva, più utile.

C’è ancora molto da esplorare, ovviamente. Ad esempio, come scegliere i parametri ottimali per una data classe di problemi di identificazione di sistema, o come i modelli augSILL gestiscono la ridondanza quando il modello è sovradimensionato. Ma per ora, siamo entusiasti di aver contribuito a svelare un po’ della “magia” dietro gli operatori di Koopman profondi e di aver offerto uno strumento pratico e potente alla comunità scientifica.

Fonte: Springer