Reattori Chimici Sotto Controllo: Come l’IA Ibrida Prevede il Calore Meglio di Mai!

Ciao a tutti! Oggi voglio parlarvi di qualcosa che mi appassiona moltissimo: come possiamo usare la potenza dei computer e dell’intelligenza artificiale per capire e controllare meglio quello che succede all’interno dei reattori chimici. Sembra complicato? Forse un po’, ma vi assicuro che è affascinante e incredibilmente utile!

Perché la Temperatura è Così Importante?

Immaginate un reattore chimico come una specie di “pentola” super tecnologica dove avvengono trasformazioni complesse. Per ottenere il prodotto desiderato con la massima efficienza e sicurezza, uno dei parametri chiave da tenere d’occhio è la temperatura. Una distribuzione del calore non uniforme o temperature sbagliate possono compromettere la resa della reazione, creare sottoprodotti indesiderati o, nei casi peggiori, portare a situazioni pericolose.

Prevedere con precisione come si distribuisce la temperatura all’interno di questi sistemi è fondamentale. Tradizionalmente, ci si affida alla fluidodinamica computazionale (CFD), una tecnica potentissima che simula il comportamento dei fluidi risolvendo complesse equazioni matematiche. Ma c’è un “ma”: applicare la CFD a reattori industriali, spesso grandi e complessi, richiede una potenza di calcolo enorme e tempi lunghissimi. Non proprio l’ideale se hai bisogno di risposte rapide, vero?

L’Idea Geniale: Unire CFD e Machine Learning

Ed è qui che entra in gioco l’idea brillante: perché non combinare il meglio dei due mondi? Possiamo usare la CFD per generare dati accurati, anche se richiede tempo, e poi usare questi dati per “allenare” modelli di machine learning (ML). Una volta allenati, questi modelli ML sono incredibilmente veloci nel fare previsioni. È un po’ come insegnare a un assistente super intelligente a riconoscere pattern complessi basandosi sugli esempi che gli forniamo.

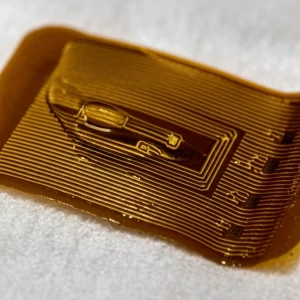

Nel nostro caso specifico, abbiamo studiato un reattore chimico tubolare in fase liquida. Abbiamo usato la CFD (con il software COMSOL, per i più tecnici) per simulare nel dettaglio il trasferimento di calore (per conduzione e convezione) e di massa (diffusione e convezione), considerando un flusso laminare. Questo ci ha fornito un ricco dataset con oltre 54.000 punti dati, che descrivono la temperatura (T) in diverse posizioni all’interno del reattore, definite dalle coordinate radiali (r) e assiali (z).

I “Cervelli Artificiali” in Campo

A questo punto, abbiamo messo alla prova diversi modelli di machine learning per vedere quale fosse il migliore nel predire la temperatura (T) basandosi sulle coordinate (r, z). Ecco i contendenti:

- Bayesian Ridge Regression (BRR): Un approccio robusto che bilancia la complessità del modello e la sua capacità di adattarsi ai dati, evitando l’overfitting (cioè imparare troppo a memoria i dati di training e non generalizzare bene). È basato su principi bayesiani, che lo rendono flessibile.

- Support Vector Machine (SVM): Famoso per la sua efficacia nelle classificazioni, l’SVM è anche un ottimo strumento per la regressione (cioè predire valori continui come la temperatura). Cerca di trovare il “confine” ottimale che meglio si adatta ai dati, gestendo bene anche relazioni non lineari grazie all’uso di funzioni kernel (noi abbiamo usato la RBF, Radial Basis Function).

- Deep Neural Network (DNN): Le reti neurali profonde sono ispirate al funzionamento del cervello umano, con strati di “neuroni” artificiali interconnessi. Sono eccezionali nel catturare pattern estremamente complessi e relazioni non lineari, cosa molto comune nei sistemi reali.

- Attention-based Deep Neural Network: Questa è la nostra novità! Abbiamo potenziato la DNN aggiungendo un “meccanismo di attenzione”. In pratica, abbiamo insegnato al modello a concentrarsi dinamicamente sulle parti più importanti dell’input (le coordinate r e z) per fare la previsione. È come dare al modello la capacità di “prestare attenzione” alle zone più influenti, migliorando l’uso delle dipendenze spaziali.

Ottimizzare per Vincere: L’Algoritmo Ispirato alle Meduse

Scegliere il modello giusto è solo una parte del lavoro. Ogni modello ML ha dei “parametri” interni, chiamati iperparametri, che devono essere regolati finemente per ottenere le massime prestazioni. Trovare la combinazione perfetta può essere un processo lungo e noioso. Per velocizzare le cose e trovare le impostazioni ottimali, abbiamo usato un algoritmo di ottimizzazione piuttosto originale: il Jellyfish Swarm Optimizer (JSO).

Sì, avete capito bene! Questo algoritmo si ispira al comportamento collettivo degli sciami di meduse nell’oceano, che coordinano i loro movimenti per trovare cibo e condizioni migliori. Allo stesso modo, gli “agenti” dell’algoritmo JSO esplorano lo spazio degli iperparametri, imparando dalle loro esperienze passate e dalla migliore soluzione trovata dall’intero “sciame”, fino a convergere verso la configurazione ottimale. Affascinante, no?

Ah, un dettaglio importante: prima di dare i dati in pasto ai modelli, abbiamo fatto un po’ di pulizia. Abbiamo usato la tecnica dello z-score per identificare e rimuovere i valori anomali (outlier), cioè quei dati che si discostano troppo dalla media e che potrebbero “confondere” i modelli e peggiorare le loro prestazioni. Un passaggio fondamentale per avere risultati affidabili.

I Risultati: Chi Ha Vinto la Sfida?

E ora, il momento della verità! Abbiamo valutato le prestazioni dei modelli usando diverse metriche standard:

- R² Score: Indica quanto bene il modello spiega la variabilità dei dati (più vicino a 1 è, meglio è).

- Mean Absolute Error (MAE): L’errore medio assoluto tra previsioni e valori reali (più basso è, meglio è).

- Root Mean Squared Error (RMSE): Simile al MAE ma penalizza di più gli errori grandi (più basso è, meglio è).

- Average Absolute Relative Deviation (AARD%): L’errore relativo medio percentuale (più basso è, meglio è).

I risultati sono stati chiarissimi (li trovate riassunti nella Tabella 1 dello studio originale e visualizzati nelle Figure da 4 a 7). Il modello Attention-based Deep Neural Network ha sbaragliato la concorrenza! Ha ottenuto un punteggio R² stratosferico di 0.99432, vicinissimo alla perfezione, e i valori più bassi per MAE, RMSE e AARD%. Questo significa che le sue previsioni erano incredibilmente vicine ai valori reali ottenuti dalla simulazione CFD.

Il meccanismo di attenzione ha fatto davvero la differenza, permettendo alla rete neurale di capire quali coordinate (r, z) fossero più critiche in ogni punto per determinare la temperatura. Anche la DNN “standard” si è comportata egregiamente (R² di 0.99147), confermando la potenza delle reti neurali per questo tipo di problemi. L’SVM ha mostrato buone performance, offrendo un buon compromesso, mentre il BRR, pur essendo valido (R² di 0.86039), è risultato meno preciso dei modelli basati su reti neurali in questo specifico contesto.

Uno Sguardo Dentro il Reattore

Ma cosa ci dicono questi modelli sulla fisica del reattore? Le analisi hanno confermato cose che ci aspettavamo, ma con una precisione incredibile. Ad esempio, abbiamo visualizzato la distribuzione della temperatura in 3D (Figura 8), mostrando come varia nello spazio. Abbiamo visto (Figura 9) che la temperatura tende a diminuire spostandosi dal centro del reattore (r=0) verso le pareti, come è logico aspettarsi dato che il calore si trasferisce verso l’esterno. Il picco di temperatura si trova al centro. Allo stesso modo, abbiamo analizzato l’andamento della temperatura lungo l’asse del reattore (z) (Figura 10), osservando il profilo termico longitudinale. Questi grafici sono fondamentali per capire dove avvengono le maggiori variazioni di calore e ottimizzare il design e il funzionamento del reattore.

Cosa Portiamo a Casa?

Questa ricerca, secondo me, dimostra in modo convincente il potenziale enorme dell’approccio ibrido CFD-ML. Abbiamo visto che:

- Combinare CFD e ML è una strategia vincente per simulare e ottimizzare reattori chimici complessi.

- Le reti neurali profonde (DNN), specialmente con l’aggiunta di meccanismi di attenzione, offrono una precisione predittiva eccezionale per la temperatura in sistemi spaziali.

- L’ottimizzazione degli iperparametri con tecniche avanzate come il JSO è cruciale per spremere il massimo dai modelli ML.

Credo fermamente che questi strumenti rappresentino il futuro. Forniscono ai professionisti dell’ingegneria termica, della scienza dei materiali, della fisica e ovviamente dell’ingegneria chimica, metodi potenti per analizzare, predire e controllare i processi termici con un’accuratezza e un’efficienza senza precedenti. Man mano che la tecnologia evolve, vedremo applicazioni sempre più sofisticate che ci aiuteranno a progettare processi più efficienti, sicuri e sostenibili. E questo, lasciatemelo dire, è davvero entusiasmante!

Spero che questo viaggio nel mondo della simulazione avanzata vi sia piaciuto!

Fonte: Springer