Modelli Idrologici Ibridi: Previsioni Fluviali Locali Mai Così Precise

Sapete, prevedere quanta acqua scorrerà nei nostri fiumi locali è una sfida affascinante e cruciale. Che si tratti di gestire le risorse idriche, prepararci a piene improvvise o affrontare periodi di siccità, avere previsioni accurate fa tutta la differenza. Per anni ci siamo affidati a modelli idrologici su larga scala, strumenti potentissimi che simulano il ciclo dell’acqua su interi continenti. Ma, diciamocelo, quando si scende nel dettaglio, a livello del singolo fiume o torrente vicino a casa, questi giganti a volte faticano.

Le Sfide dei Grandi Modelli

I modelli su larga scala, come l’europeo E-HYPE che abbiamo usato come base nel nostro studio, sono incredibili per darci il quadro generale. Tuttavia, portarli a fare previsioni precise su scala locale è un’altra storia. Perché? Beh, i motivi sono diversi:

- Incertezze intrinseche: Impostare i parametri giusti per ogni piccola area è complesso e può portare a errori.

- Varietà idro-climatica: L’Europa è un mosaico di climi, topografie e influenze umane (come irrigazione o dighe). Un modello unico fa fatica a catturare tutte queste sfumature locali.

- Dati scarsi: Non tutti i fiumi sono monitorati costantemente, specialmente in aree remote. Questo rende difficile calibrare i modelli.

- Dati meteo imperfetti: Nessun set di dati meteorologici globali è perfetto al 100% a livello locale, specialmente per le precipitazioni.

- Processi complessi: Flussi come l’evapotraspirazione o la ricarica delle falde sono difficili da quantificare esattamente.

Insomma, c’era bisogno di un approccio che prendesse la potenza dei grandi modelli ma la “rafffinasse” per le esigenze locali. Ed è qui che entra in gioco l’idea degli approcci ibridi.

L’Idea Ibrida: Il Meglio di Due Mondi

Cosa succede se prendiamo le simulazioni di un modello robusto come E-HYPE e le “correggiamo” usando tecniche statistiche o di machine learning (ML)? L’idea è semplice: il modello fisico-matematico ci dà la base, la comprensione dei processi fondamentali, mentre gli algoritmi di post-processing imparano dai dati locali osservati per aggiustare il tiro, catturando quelle dinamiche complesse e non lineari che il modello base potrebbe mancare.

Nel nostro lavoro, abbiamo messo alla prova questa idea su scala paneuropea, usando oltre 2000 stazioni di monitoraggio. Abbiamo confrontato le previsioni “grezze” del modello E-HYPE con quelle ottenute applicando quattro diverse tecniche di post-processing:

- Due metodi statistici classici: Generalised Linear Model (GLM) e Quantile Mapping (QM).

- Due metodi basati sul machine learning: Random Forest (RF) e Long Short-Term Memory (LSTM), una rete neurale specializzata per le serie temporali.

L’obiettivo? Vedere se e come questi metodi ibridi migliorassero le previsioni della portata fluviale, non solo in termini di volume totale, ma anche per gli eventi estremi: le piene (flussi alti) e le magre (flussi bassi).

Funziona Davvero? I Risultati Parlano Chiaro

La risposta breve è: sì, funziona alla grande! Tutti e quattro i metodi di post-processing hanno portato a miglioramenti significativi rispetto al modello E-HYPE da solo. Gli errori si sono ridotti, sia nel calcolo del volume d’acqua totale sia, cosa importantissima, nella previsione degli estremi. Ma non tutti i metodi si sono comportati allo stesso modo.

Abbiamo notato che, mentre per il volume totale le differenze tra i metodi erano minori, per gli eventi estremi (piene e magre) i metodi di machine learning (RF e LSTM) hanno mostrato una marcia in più. Sono riusciti a migliorare drasticamente le prestazioni anche in situazioni dove il modello base era molto carente. Pensate che in alcuni casi, stazioni con prestazioni iniziali “discrete” sono passate a “ottime” grazie a LSTM o RF. Questo suggerisce che l’ML riesce a compensare anche errori strutturali del modello base, magari legati a interventi umani non modellizzati, mentre i metodi statistici correggono meglio incertezze nei dati di input o nei parametri.

Il Quantile Mapping (QM), pur migliorando il volume generale, ha mostrato qualche difficoltà con gli estremi, a volte peggiorando leggermente la situazione per le portate minime in alcuni bacini. Questo perché si concentra sull’aggiustare la distribuzione statistica, ma non cattura le dinamiche temporali complesse come fanno le reti LSTM.

Non Esiste la Bacchetta Magica: Ogni Fiume ha la Sua Soluzione

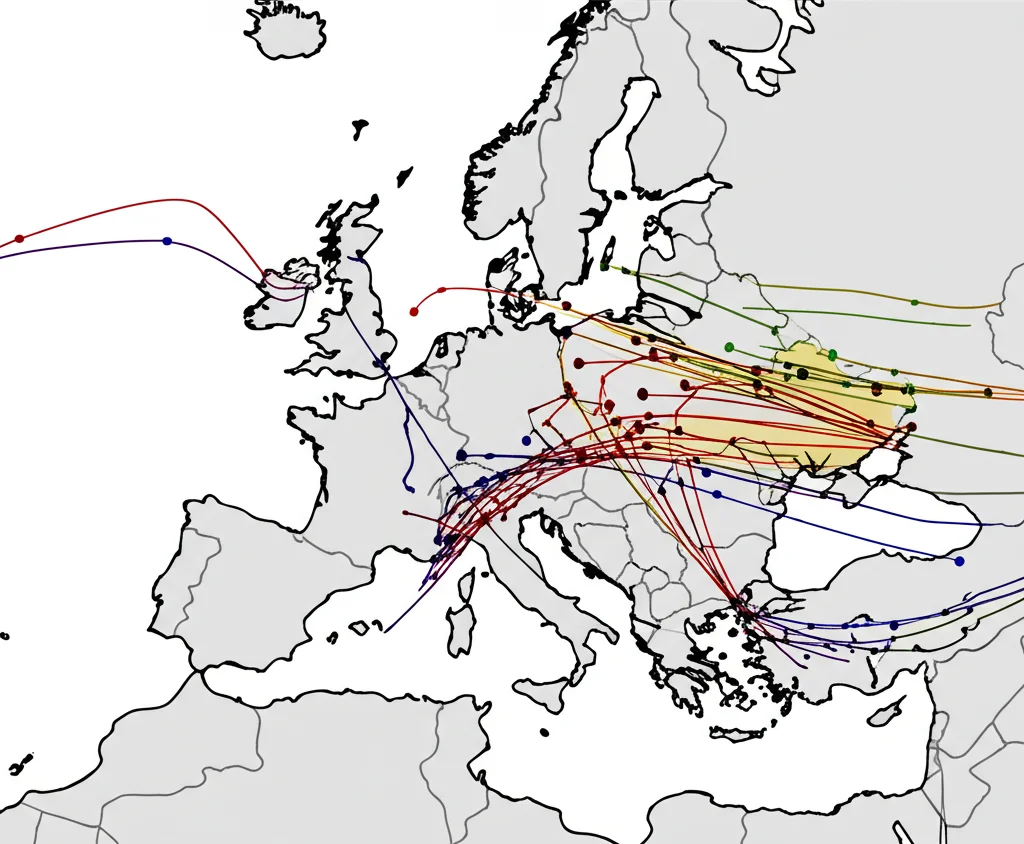

Un altro risultato affascinante è stata la scoperta di una sorta di “complementarità spaziale”. Non c’è stato un metodo di post-processing che fosse il migliore in assoluto ovunque in Europa. Piuttosto, diverse tecniche eccellevano in diverse regioni.

- LSTM è risultato il migliore in oltre il 50% delle stazioni per le piene, specialmente in Europa centrale e occidentale.

- Random Forest (RF) è stato il secondo più efficace, brillando in Nord Europa e lungo le coste mediterranee.

- Anche i metodi statistici GLM e QM hanno avuto i loro momenti di gloria in specifiche aree. Ad esempio, QM si è comportato molto bene con le portate minime nella regione a ovest degli Urali, dominata dallo scioglimento delle nevi.

- Nel Regno Unito, ad esempio, dove le interazioni fiume-falda sono complesse, LSTM ha dato i miglioramenti più netti, probabilmente grazie alla sua capacità di gestire dipendenze temporali complesse.

C’erano anche alcune (poche) stazioni dove nessun metodo ibrido ha portato vantaggi significativi. Spesso si trattava di bacini molto piccoli e con risposte rapide alle piogge. Questo ci dice che la scelta del metodo di post-processing dovrebbe tenere conto delle caratteristiche specifiche del bacino idrografico locale. Per il futuro, si potrebbe pensare a combinare i risultati di diversi modelli (model averaging) per sfruttare i punti di forza di ciascuno.

Ma Perché Funziona Meglio Qui o Lì? I Fattori Chiave

Se metodi diversi funzionano meglio in posti diversi, quali sono i fattori che influenzano l’efficacia del post-processing? Abbiamo usato un’analisi chiamata CART (Classification and Regression Tree) per capirlo, considerando vari fattori climatici, fisiografici, di impatto umano e, soprattutto, di similarità idrologica.

La similarità idrologica, cioè quanto il comportamento di un fiume (il suo regime) assomiglia a quello di altri, è emersa come uno dei fattori più importanti, insieme alle condizioni climatiche medie (precipitazione e temperatura). Questo vale sia per il volume totale che per le piene. Ad esempio, abbiamo visto che LSTM tende a migliorare di più le previsioni delle piene in condizioni più calde e secche.

Per le portate minime, invece, la similarità idrologica conta ancora di più, insieme all’altitudine e all’indice di aridità. Questo ha senso: le magre dipendono meno dalle piogge recenti e più dalla “memoria” del sistema fluviale (falde, suolo), caratteristiche ben rappresentate dai regimi idrologici.

La cosa interessante è che questi fattori influenzano l’efficacia di tutti i metodi di post-processing in modo simile. Non è tanto il metodo in sé, ma le caratteristiche del bacino a determinare quanto miglioramento si può ottenere.

Uno Sguardo al Futuro: Acqua Più Sicura per Tutti

Cosa significa tutto questo in pratica? Le implicazioni sono notevoli.

- Previsioni locali più affidabili: Avere modelli più precisi a livello locale è fondamentale per settori come l’agricoltura, la produzione idroelettrica, la fornitura di acqua potabile e la gestione del rischio idrogeologico.

- Potenziale per aree senza dati: Capire che la similarità idrologica guida l’efficacia del post-processing apre la porta alla “regionalizzazione”. Potremmo allenare modelli di post-processing su più bacini simili e poi applicarli anche dove mancano dati di osservazione diretta (bacini non strumentati).

- Migliori previsioni operative: Questi approcci ibridi possono essere integrati nei sistemi di allerta precoce (early warning). Addestrando i modelli di post-processing specificamente per diverse finestre temporali future (lead time), si possono correggere i bias sia delle condizioni iniziali sia delle previsioni meteorologiche, rendendo le allerte per piene e siccità più tempestive ed efficaci.

Questo lavoro si inserisce perfettamente negli sforzi globali come il decennio scientifico HELPING dell’Associazione Internazionale delle Scienze Idrologiche e l’iniziativa Early Warnings for All (EW4ALL) delle Nazioni Unite. L’obiettivo comune è proteggere tutti dai rischi legati all’acqua, e previsioni accurate sono il primo passo fondamentale.

In Conclusione: Un Passo Avanti per la Gestione dell’Acqua

Combinare la potenza dei modelli idrologici su larga scala con la flessibilità e la capacità di apprendimento delle tecniche statistiche e di machine learning si è rivelato un successo. Gli approcci ibridi non sono solo un esercizio accademico, ma uno strumento concreto per rendere le simulazioni idrologiche molto più utili e affidabili là dove serve di più: a livello locale. È un passo importante verso una gestione più consapevole e sicura della nostra risorsa più preziosa, l’acqua.

Fonte: Springer