MobiLiteNet: L’IA Leggera che Trasforma il Tuo Smartphone in un Segugio Anti-Buche!

Ehilà, appassionati di tecnologia e strade lisce come biliardi! Oggi voglio parlarvi di qualcosa che mi sta davvero a cuore, perché riguarda le nostre strade e, diciamocelo, la nostra pazienza quando guidiamo. Sapete una cosa? Le nostre strade sono un po’ come le arterie del corpo umano: fondamentali per farci muovere, lavorare, vivere. Ma, ahimè, proprio come le arterie, possono “ammalarsi”. Parlo di crepe, buche, solchi… insomma, tutti quei fastidiosi “acciacchi” che rendono i viaggi un incubo e le riparazioni un salasso.

Tradizionalmente, scovare questi problemi è un lavoraccio: squadre di tecnici che perlustrano chilometri e chilometri, armati di taccuino e occhio clinico. Un metodo lento, costoso e, diciamocelo, non sempre precisissimo. Negli ultimi anni, la tecnologia ci ha dato una mano con sistemi automatici, ma spesso questi richiedono computer potentissimi, roba da NASA, limitandone l’uso su larga scala. Ma se vi dicessi che la soluzione potrebbe essere già nelle nostre tasche?

La Sfida: Portare l’Intelligenza Artificiale sulle Strade, Davvero!

Immaginate di dover caricare terabyte di dati (sì, avete letto bene, terabyte!) su un server cloud ogni volta che si ispeziona una lunga tratta stradale. Un delirio per la trasmissione dati, per non parlare dei costi di archiviazione e delle preoccupazioni per la privacy e la sicurezza. E poi, la risposta non è immediata, cosa fondamentale se si vuole intervenire rapidamente.

Qui entra in gioco l’edge computing. Invece di mandare tutto al “cervellone” centrale, l’idea è di processare i dati direttamente lì dove vengono raccolti, cioè “sul campo”. E cosa c’è di più “sul campo” dei nostri smartphone o dei dispositivi di realtà mista (MR)? Gli smartphone sono diventati potentissimi, con fotocamere, processori e connettività da urlo. I dispositivi MR, poi, aprono scenari fantascientifici, permettendo agli ingegneri di vedere le informazioni sovrapposte alla realtà, come in un film di fantascienza, per pianificare manutenzioni o valutare i danni.

Questi aggeggi mobili sono flessibili, versatili e ci permettono di raggiungere zone impervie, fare ispezioni d’emergenza dopo un disastro naturale o lavorare in ambienti pericolosi. Il potenziale è enorme, ma c’era un “ma”: mancava un sistema, un framework, pensato apposta per far girare modelli di intelligenza artificiale leggeri e scattanti su questi dispositivi, senza prosciugare la batteria o richiedere una laurea in ingegneria informatica per usarli. E, non da ultimo, servivano dati di alta qualità, raccolti apposta per questo scopo.

Ecco MobiLiteNet: L’Allenatore Personale per l’IA del Tuo Telefono

Ed è qui che, con un po’ di orgoglio, vi presento MobiLiteNet! È un approccio di deep learning leggero, pensato su misura per funzionare in tempo reale su smartphone e sistemi di realtà mista. L’idea è semplice ma potente: rendere il rilevamento dei dissesti stradali accessibile, efficiente e accurato, usando la tecnologia che abbiamo già.

Come ci siamo riusciti? Abbiamo messo insieme un “dream team” di tecniche di ottimizzazione dei modelli di intelligenza artificiale. Abbiamo iniziato con un meccanismo chiamato Efficient Channel Attention (ECA), che è come dare al modello degli occhiali speciali per concentrarsi sulle informazioni più importanti. Poi, abbiamo “snellito” la struttura del modello (structural refinement), gli abbiamo fatto imparare da un “maestro” più esperto ma ingombrante (sparse knowledge distillation), abbiamo eliminato le parti inutili (structured pruning) e, infine, abbiamo compresso tutto quanto (quantization) per renderlo super efficiente senza perdere troppa precisione.

Per “allenare” MobiLiteNet, abbiamo raccolto un sacco di immagini di strade da diverse parti d’Europa e Asia, in condizioni diverse, per essere sicuri che il sistema funzionasse bene un po’ ovunque. Il risultato? Un modello basato sul già efficiente MobileNet V2, ma ulteriormente potenziato, che batte i modelli di partenza sia in accuratezza che in velocità sui dispositivi mobili. Questo non solo migliora il monitoraggio delle infrastrutture, ma apre la strada a sistemi di valutazione automatica di nuova generazione, con applicazioni che vanno dai trasporti intelligenti alle smart city, fino a tecnologie inclusive per migliorare la sicurezza pubblica.

Come Funziona la Magia di MobiLiteNet? Un Tuffo nei Dettagli

Vi spiego un po’ più nel dettaglio come abbiamo “messo a dieta” il nostro modello di IA, prendendo come esempio MobileNet V2. Immaginate un processo in due fasi: prima massimizziamo la sua capacità di capire e la precisione nel rilevare i problemi, poi lo “alleggeriamo” drasticamente per farlo girare veloce sui cellulari.

Ecco i cinque ingredienti segreti:

- Meccanismi ECA (Efficient Channel Attention): Come dicevo, è un modulo leggero che aiuta il modello a capire quali “canali” di informazione sono più importanti, usando delle semplici convoluzioni monodimensionali. Poca spesa, massima resa!

- Raffinamento Strutturale: Qui abbiamo ottimizzato l’architettura del modello, riducendo il numero di ripetizioni di certi blocchi e aggiustando le dimensioni dei canali di input e output. Risultato? Meno parametri, meno calcoli, più efficienza.

- Distillazione della Conoscenza Sparsa (Sparse Knowledge Distillation): Immaginate un modello “insegnante” (nel nostro caso, un potente ResNet) molto bravo ma troppo pesante per un cellulare. Questo insegnante trasferisce la sua “saggezza” a un modello “allievo” più leggero. L’allievo impara non solo le risposte giuste (hard target loss) ma anche le “sfumature” del ragionamento del maestro (soft target loss). In più, abbiamo aggiunto una regolarizzazione L1 che spinge l’allievo a essere “spartano”, cioè a usare solo i parametri strettamente necessari, preparando il terreno per il passo successivo.

- Potatura Strutturata (Structured Pruning): Dopo la distillazione, andiamo a “potare” i canali meno importanti, quelli che contribuiscono meno al risultato finale. Possiamo eliminare fino al 30% dei canali, riducendo drasticamente il numero di parametri e, di conseguenza, l’uso di memoria e i tempi di calcolo.

- Quantizzazione: Questa è la ciliegina sulla torta. Convertiamo i calcoli da numeri in virgola mobile a 32 bit (float32) a interi a 8 bit (INT8). Questo riduce la dimensione del modello a circa un quarto dell’originale! Meno memoria occupata e operazioni aritmetiche più veloci, perfette per l’hardware mobile. È cruciale per avere risposte in tempo reale.

Mettendo insieme tutte queste tecniche, MobiLiteNet riesce a far girare modelli di deep learning complessi su smartphone e dispositivi MR, permettendo un rilevamento dei dissesti stradali accurato, efficiente e in tempo reale.

L’Importanza di Dati di Qualità (e Quantità!)

Un buon modello di IA ha bisogno di buoni dati per imparare, un po’ come uno studente ha bisogno di buoni libri. Esistono già dataset di immagini di dissesti stradali (come GAPs, CRACK500, CrackForest), che sono stati utilissimi. Però, spesso si concentrano su immagini scattate col bel tempo. E le strade sotto la pioggia? O di notte? Il mondo reale è molto più vario!

Per questo, abbiamo creato un nostro dataset super variegato. Abbiamo raccolto immagini da Aachen (Germania), Pechino (Cina) e Swansea (Regno Unito). Ogni luogo ha le sue particolarità: Aachen con traffico intenso e variazioni termiche moderate; Pechino con sbalzi di temperatura estremi; Swansea con alta umidità e piogge frequenti. Questa diversità aiuta il modello a generalizzare meglio, cioè a funzionare bene anche in condizioni mai viste prima.

Abbiamo incluso immagini scattate sotto la pioggia e di notte, e da diverse angolazioni (parallele e oblique rispetto al pavimento). Il dataset copre quattro tipi di dissesti: crepe longitudinali, crepe trasversali, crepe a “pelle di coccodrillo” (alligator cracks) e segnaletica orizzontale rovinata. In totale, 2873 immagini, tutte standardizzate a una risoluzione di 512×512 pixel.

Ma non ci siamo fermati qui! Per avere ancora più dati e bilanciare le diverse categorie, abbiamo usato una tecnica chiamata WGAN-GP (Wasserstein Generative Adversarial Network with Gradient Penalty). In pratica, è un’IA che impara a creare immagini sintetiche di dissesti stradali talmente realistiche da sembrare vere! Abbiamo generato 4500 immagini sintetiche per ogni classe di dissesto, usandone 4000 per l’allenamento e 500 per la validazione. Questo “doping” di dati ha reso il nostro modello ancora più robusto e adattabile.

Dal Laboratorio alla Strada: Test e Risultati

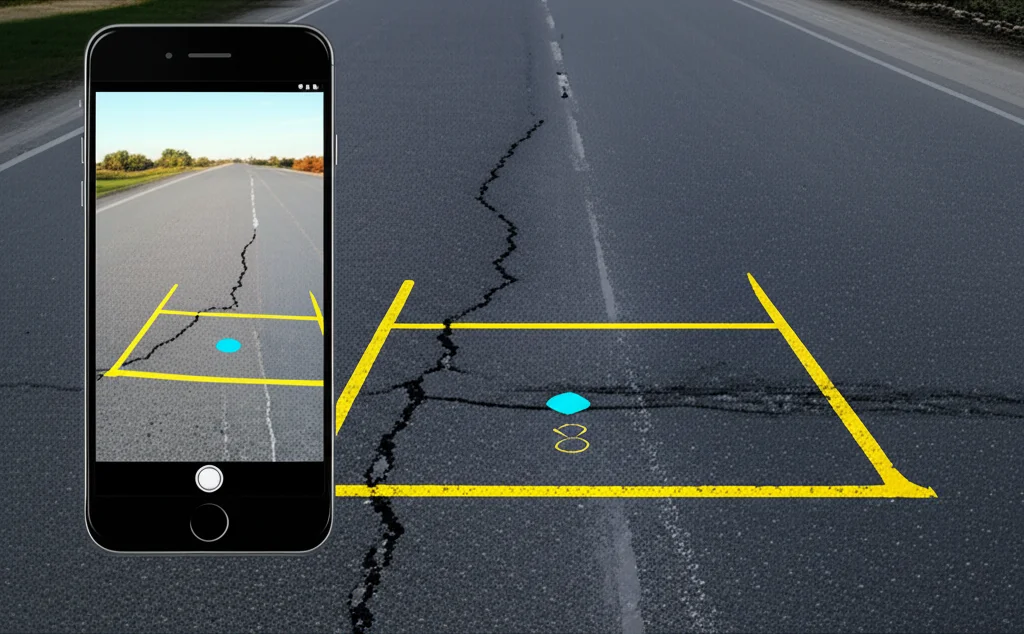

Dopo aver “allenato” il nostro modello MobileNet V2 potenziato con MobiLiteNet, era ora di vedere come se la cavava nel mondo reale. Lo abbiamo convertito nel formato TensorFlow Lite (TFLite), ottimizzato per i dispositivi mobili, e lo abbiamo integrato in un’app Android che abbiamo chiamato RoadIntelligent. Quest’app permette di scattare foto con lo smartphone o con un visore MR, e l’IA analizza l’immagine in tempo reale, mostrando i risultati.

Per capire l’impatto di ogni singola tecnica di ottimizzazione, abbiamo condotto degli “studi di ablazione”. È come smontare un motore pezzo per pezzo per vedere quanto contribuisce ogni componente. I risultati sono stati chiari: ogni tecnica ha dato il suo contributo! Per darvi un’idea, un modello complesso come ResNet è super accurato (98.02%) ma ha oltre 11 milioni di parametri e pesa 44.7 MB – improponibile per un cellulare. Il MobileNet V2 di base è molto più leggero (2.229 milioni di parametri, 8.9 MB) ma meno accurato (94.09%).

Il nostro modello finale ottimizzato (chiamiamolo Modello 5), dopo tutti i trattamenti di MobiLiteNet, ha raggiunto un’accuratezza del 96.38%, ma con soli 0.498 milioni di parametri e una dimensione di appena 0.6 MB! Praticamente un quindicesimo della dimensione del MobileNet V2 originale, ma più preciso. Un risultato notevole!

In Azione: Smartphone e Realtà Mista al Servizio delle Strade

Abbiamo quindi installato l’app RoadIntelligent su uno smartphone (un Huawei P40) e su un dispositivo di realtà mista (Meta Quest 3). Su smartphone, l’app usa la fotocamera, processa l’immagine e mostra i risultati sullo schermo. Sulla piattaforma MR, è ancora più figo: i risultati vengono visualizzati come sovrapposizioni direttamente sulla superficie stradale, e si può interagire con comandi gestuali, a mani libere!

E i tempi di elaborazione? Su smartphone, il nostro Modello 5 processava un’immagine in soli 34.5 millisecondi, il 71.8% più veloce del MobileNet V2 base e un incredibile 94.2% più veloce di ResNet. Su MR, i risultati sono stati simili: 40.1 millisecondi, con riduzioni dell’86.1% e 97.2% rispettivamente. Questi numeri significano rilevamento in tempo reale, anche a velocità operative, minor consumo di batteria e la possibilità di far girare altre app contemporaneamente senza problemi.

La Prova del Nove: Validazione sul Campo ad Aachen

Per essere sicuri che non fossero solo bei numeri da laboratorio, abbiamo portato tutto ad Aachen, in Germania, per dei test sul campo. Con lo smartphone, abbiamo raccolto 400 immagini di dissesti (100 per ogni categoria). L’accuratezza complessiva è stata del 92.5%, un ottimo risultato considerando le variabili del mondo reale (luce, angolazioni, ecc.).

Con il dispositivo MR, abbiamo fatto un confronto interessante. Abbiamo usato la nostra app RoadIntelligent e un’altra app basata su YOLOv8, un modello di object detection allo stato dell’arte. Attenzione: le due app fanno cose leggermente diverse (RoadIntelligent classifica l’immagine intera, YOLO individua oggetti specifici) e sono state addestrate su dataset differenti, quindi è un confronto più ingegneristico che funzionale. RoadIntelligent ha raggiunto il 91% di accuratezza con un tempo di rilevamento di 87 millisecondi. L’app YOLO è arrivata al 92.5% di accuratezza, ma ha impiegato ben 2316 millisecondi! La nostra app era quasi 27 volte più veloce, pur mantenendo un’accuratezza competitiva. Questo dimostra l’equilibrio perfetto tra precisione ed efficienza raggiunto da MobiLiteNet.

Tutti i dati raccolti sono stati salvati con timestamp e verranno caricati su un database cloud, e in futuro sulla piattaforma tedesca Mobilithek, per supportare la gestione delle infrastrutture su larga scala.

Conclusioni e Sguardo al Futuro: Strade Più Intelligenti per Tutti

Insomma, MobiLiteNet è un bel passo avanti. Abbiamo dimostrato che è possibile avere un rilevamento dei dissesti stradali accurato ed efficiente usando i dispositivi che molti di noi hanno già. L’integrazione di tecniche come ECA, distillazione della conoscenza, potatura e quantizzazione ha permesso di “domare” modelli di deep learning potenti per farli funzionare su piattaforme con risorse limitate.

Le applicazioni future? Tantissime! Oltre al monitoraggio stradale, pensate a sistemi di allerta precoce per persone con disabilità visive, o a iniziative per le smart city. La fusione tra mobile computing e intelligenza artificiale, come vediamo con i progressi negli occhiali AR, apre scenari incredibili per il monitoraggio in tempo reale e la consapevolezza situazionale.

Certo, ci sono ancora limiti. Le app attuali sono prototipi. La qualità delle immagini in input è fondamentale, e condizioni estreme (maltempo, poca luce) possono ancora influire. La ricerca futura punterà a migliorare la robustezza in queste condizioni, magari integrando dati da più sensori, e a sviluppare app più complete e facili da usare, integrate con i sistemi di gestione esistenti.

Nonostante questo, sono convinto che MobiLiteNet e approcci simili contribuiranno enormemente a creare ambienti urbani più intelligenti, inclusivi e resilienti. E, chissà, magari un giorno le buche saranno solo un lontano ricordo!

Piccola Nota Tecnica (per i più curiosi)

Per chi volesse saperne di più, l’allenamento dei modelli è stato fatto su un server con una GPU NVIDIA RTX 4090. Per il mobile, abbiamo usato un Huawei P40 e per la MR un Meta Quest 3. Abbiamo usato Python, PyTorch e Android Studio. Le tecniche come ECA, Knowledge Distillation, Structured Pruning e WGAN-GP sono standard nel campo, ma la loro combinazione mirata per questo specifico problema è la vera novità. MobileNet V2 è stato scelto per la sua già nota efficienza, che abbiamo ulteriormente spinto. La conversione in TFLite è stata fatta con AI Edge Torch, assicurando che il modello convertito si comportasse come l’originale. Per YOLOv8, il processo di conversione è passato da PyTorch a ONNX e poi a TensorFlow prima di arrivare a TFLite.

Spero che questo viaggio nel mondo dell’IA applicata alle strade vi sia piaciuto tanto quanto a me è piaciuto lavorarci e raccontarvelo!

Fonte: Springer