Equazioni Complesse? Risolvile alla Velocità della Luce (quasi!) con il Nostro Metodo Quasi-Newton su GPU!

Ciao a tutti gli appassionati di scienza e calcolo! Oggi voglio parlarvi di una sfida che spesso ci troviamo ad affrontare nel mondo della simulazione scientifica: risolvere equazioni complesse, in particolare quelle che chiamiamo equazioni ellittiche quasi-lineari. Queste bestioline matematiche spuntano ovunque, dalla fisica all’ingegneria, dalla finanza alla biologia, descrivendo fenomeni stazionari come la distribuzione di calore, i campi elettrostatici o processi di diffusione con reazioni chimiche.

Il problema? Risolverle numericamente, specialmente quando diventano grandi e intricate (pensate a simulazioni 3D ad alta risoluzione!), richiede una potenza di calcolo enorme e tanto, tanto tempo. I metodi tradizionali, come il classico metodo di Newton, sono potenti ma hanno un tallone d’Achille: ad ogni passo devono calcolare e invertire matrici gigantesche (le matrici Jacobiane), un’operazione che può mettere in ginocchio anche i supercomputer più potenti.

La Sfida Computazionale: Quando Newton Rallenta

Vedete, quando trasformiamo un’equazione differenziale (continua) in un sistema di equazioni algebriche (discrete) che un computer può capire – un processo chiamato discretizzazione (usando tecniche come i Metodi alle Differenze Finite – FDM, Metodi agli Elementi Finiti – FEM, o Volumi Finiti – FVM) – ci ritroviamo con sistemi non lineari enormi. Il metodo di Newton è fantastico perché converge velocemente verso la soluzione (convergenza quadratica, dicono i matematici), ma richiede di calcolare la derivata del nostro sistema (la Jacobiana) e risolvere un sistema lineare con quella matrice ad ogni iterazione. Immaginate di dover fare questo per matrici con milioni o miliardi di elementi… capite bene che il costo computazionale esplode!

Qui entrano in gioco i metodi quasi-Newton. L’idea è furba: invece di calcolare l’esatta e costosa Jacobiana ogni volta, ne usiamo un’approssimazione più semplice e veloce da gestire. È un po’ come usare una mappa semplificata invece di una foto satellitare dettagliatissima per trovare la strada: magari non è perfetta al millimetro, ma ci porta a destinazione molto più rapidamente.

La Nostra Idea: Semplificare Senza Perdere Potenza

Nel nostro lavoro, abbiamo sviluppato un metodo quasi-Newton specificamente pensato per queste equazioni ellittiche quasi-lineari, con un occhio di riguardo per l’hardware moderno, in particolare le GPU (Graphics Processing Units). Le GPU sono nate per i videogiochi, ma si sono rivelate potentissime anche nel calcolo scientifico grazie alla loro capacità di eseguire tantissime operazioni in parallelo.

Qual è il nostro “trucco”? Abbiamo notato che in molti problemi discretizzati, la Jacobiana è composta da una parte lineare (spesso legata all’operatore Laplaciano, quello che descrive la diffusione) e una parte non lineare. Noi approssimiamo la Jacobiana usando la parte lineare (la matrice ( A_h ) che deriva dalla discretizzazione del Laplaciano) e sostituendo la parte complicata non lineare con un termine molto più semplice: una matrice identità ( I ) moltiplicata per un parametro scalare ( beta_n ) che aggiorniamo ad ogni passo.

La bellezza di questa scelta sta nel fatto che la matrice ( A_h + beta_n I ) è molto più facile da “invertire” rispetto alla Jacobiana completa, specialmente se ( A_h ) ha una struttura particolare. E qui entra in gioco la seconda parte della nostra magia.

Il Segreto dell’Efficienza: Prodotti Tensoriali e GPU

Molti metodi di discretizzazione, come il Metodo agli Elementi Spettrali (SEM) o le Differenze Finite (FDM) su griglie regolari (rettangolari o cubiche), producono matrici ( A_h ) che hanno una struttura meravigliosa chiamata struttura a prodotto tensoriale (o prodotto di Kronecker). Senza entrare troppo nei dettagli tecnici, questa struttura permette di scomporre i calcoli su matrici enormi in calcoli su matrici molto più piccole.

Immaginate di dover risolvere un puzzle gigante: invece di manipolare tutti i pezzi insieme, questa struttura ci permette di lavorare su sezioni più piccole separatamente. Quando dobbiamo calcolare l’inversa della nostra matrice approssimata ( A_h + beta_n I ), grazie ai prodotti tensoriali, non dobbiamo fare una vera e propria inversione matriciale (che è costosissima!). Possiamo invece usare delle trasformazioni (simili alla Trasformata di Fourier Veloce, per chi la conosce) che diagonalizzano le matrici più piccole. Invertire una matrice diagonale è banale: basta invertire i singoli elementi sulla diagonale!

Il vantaggio è enorme:

- Calcoliamo la parte “difficile” (la diagonalizzazione delle matrici piccole) una sola volta all’inizio.

- Ad ogni iterazione del metodo quasi-Newton, aggiorniamo solo il parametro ( beta_n ) e facciamo divisioni elemento per elemento su matrici diagonali – operazioni velocissime!

- Questa struttura basata su prodotti tensoriali è perfetta per le GPU, che eccellono nel parallelizzare operazioni su grandi array di dati.

Abbiamo preso ispirazione da un’implementazione Matlab minimale ma efficientissima sviluppata da [22] per problemi lineari su GPU e l’abbiamo adattata al nostro contesto non lineare grazie all’approssimazione quasi-Newton. Abbiamo usato principalmente il Metodo agli Elementi Spettrali (SEM), in particolare con elementi (Q^k), perché offre alta accuratezza ed è anch’esso molto adatto all’accelerazione su GPU, pur mantenendo una certa robustezza (monotonicità) che aiuta la convergenza.

Funziona Davvero? La Prova della Convergenza

Ovviamente, non basta avere un metodo veloce, deve anche funzionare! Abbiamo dedicato una parte importante del nostro lavoro all’analisi della convergenza. Sotto ipotesi ragionevoli (come la “buona” regolarità della parte non lineare e la positività di certe matrici), abbiamo dimostrato matematicamente che il nostro metodo converge localmente alla soluzione esatta ( U^* ).

Ancora meglio, abbiamo trovato un modo per scegliere il parametro ( beta_n ) in modo “ottimale” ad ogni passo. Scegliendo ( beta_n ) come la media tra l’autovalore massimo e minimo della Jacobiana della parte non lineare (che, grazie alla nostra implementazione, è una matrice diagonale e quindi questi autovalori sono facilissimi da calcolare!), garantiamo che l’errore diminuisca ad ogni iterazione, assicurando stabilità ed efficienza.

Alla Prova dei Fatti: Esperimenti Numerici

La teoria è bella, ma la pratica? Abbiamo messo alla prova il nostro metodo su diversi banchi di prova, sia in 1D (su CPU, dove il vantaggio tensoriale non si sfrutta appieno) che in 2D e 3D (su GPU NVIDIA A100, dove il metodo brilla).

- Problemi 1D: Abbiamo confrontato il nostro metodo con il Newton classico su problemi con soluzioni note o multiple. I risultati mostrano che il nostro metodo converge in modo affidabile, e la scelta “ottimale” di ( beta ) è effettivamente vantaggiosa rispetto a un ( beta ) fisso. Anche quando alcune ipotesi teoriche (come la positività definita della Jacobiana non lineare) non erano soddisfatte, il metodo ha funzionato bene empiricamente.

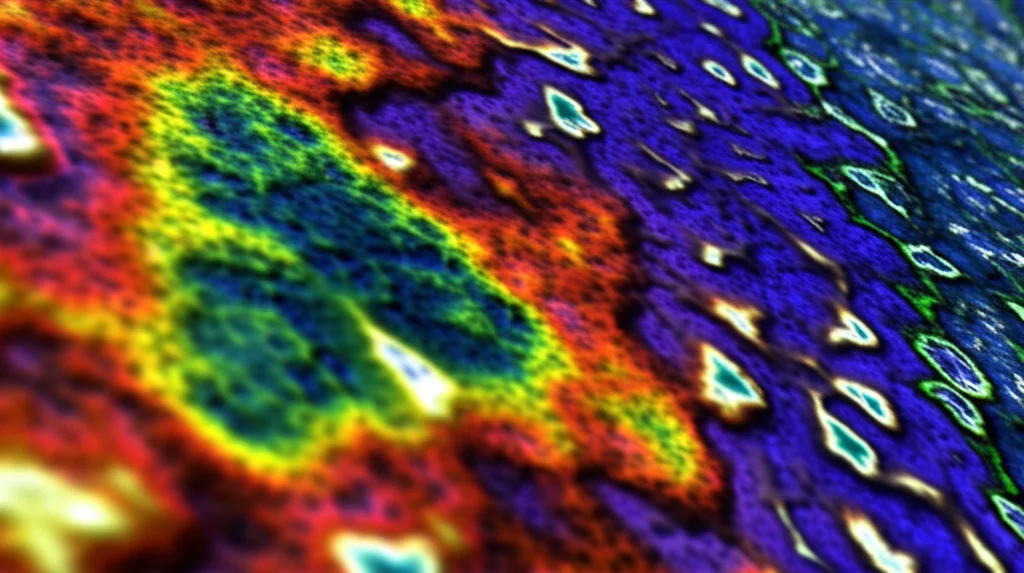

- Problemi 2D: Qui il vantaggio della GPU e dei tensori si fa sentire! Su un problema con soluzione analitica nota, il nostro metodo quasi-Newton è risultato considerevolmente più veloce del metodo di Newton, specialmente all’aumentare della dimensione della griglia. Abbiamo anche affrontato un problema con soluzioni multiple (adattato da [1]) e il famoso modello di Gray-Scott, che descrive sistemi di reazione-diffusione e può generare pattern spaziali complessi. Il nostro metodo è riuscito a calcolare diverse soluzioni stabili in modo efficiente.

- Sistemi di Equazioni (Gray-Scott 2D): Abbiamo esteso il metodo anche a sistemi di equazioni differenziali, come nel modello di Gray-Scott. Anche qui, l’approccio si è dimostrato robusto ed efficiente nel trovare le varie soluzioni stazionarie del sistema.

- Problemi 3D: Abbiamo testato il metodo su un problema 3D con soluzione nota e sull’equazione di Schrödinger non lineare stazionaria (un problema agli autovalori). Anche in 3D, dove le dimensioni diventano davvero impegnative, il metodo ha mostrato ottime performance in termini di tempo di calcolo e numero di iterazioni, gestendo anche la complessità aggiuntiva del calcolo dell’autovalore ( lambda ) nell’equazione di Schrödinger tramite un approccio iterativo e una normalizzazione.

Conclusioni e Prospettive Future

In sintesi, abbiamo sviluppato un metodo quasi-Newton che sfrutta in modo intelligente l’approssimazione della Jacobiana e la potenza dei prodotti tensoriali implementati su GPU per risolvere equazioni ellittiche quasi-lineari in modo molto efficiente. Riduce drasticamente il collo di bottiglia computazionale dei metodi Newton tradizionali, specialmente per problemi grandi e multidimensionali.

La nostra analisi teorica ne garantisce la convergenza locale e fornisce una guida per scegliere il parametro di regolarizzazione ( beta_n ) in modo ottimale. Gli esperimenti numerici confermano la robustezza, la scalabilità e i guadagni computazionali del metodo, rendendolo uno strumento promettente per accelerare simulazioni complesse in fisica, ingegneria e molti altri campi scientifici che si affidano alla risoluzione di PDE.

Cosa ci riserva il futuro? Stiamo pensando di estendere questo approccio ad altre classi di equazioni non lineari e di affinare ulteriormente la strategia di scelta del parametro ( beta ), magari rendendola adattiva in modo dinamico, per sfruttare ancora meglio le capacità dell’hardware moderno e spingere i limiti delle simulazioni scientifiche ad alte prestazioni.

Spero che questa panoramica vi abbia incuriosito! Risolvere queste equazioni è fondamentale per capire e predire il mondo che ci circonda, e avere metodi più veloci ed efficienti ci permette di affrontare problemi sempre più complessi.

Fonte: Springer