Prevedere l’Adsorbimento? Ora si Può (Grazie al Machine Learning!)

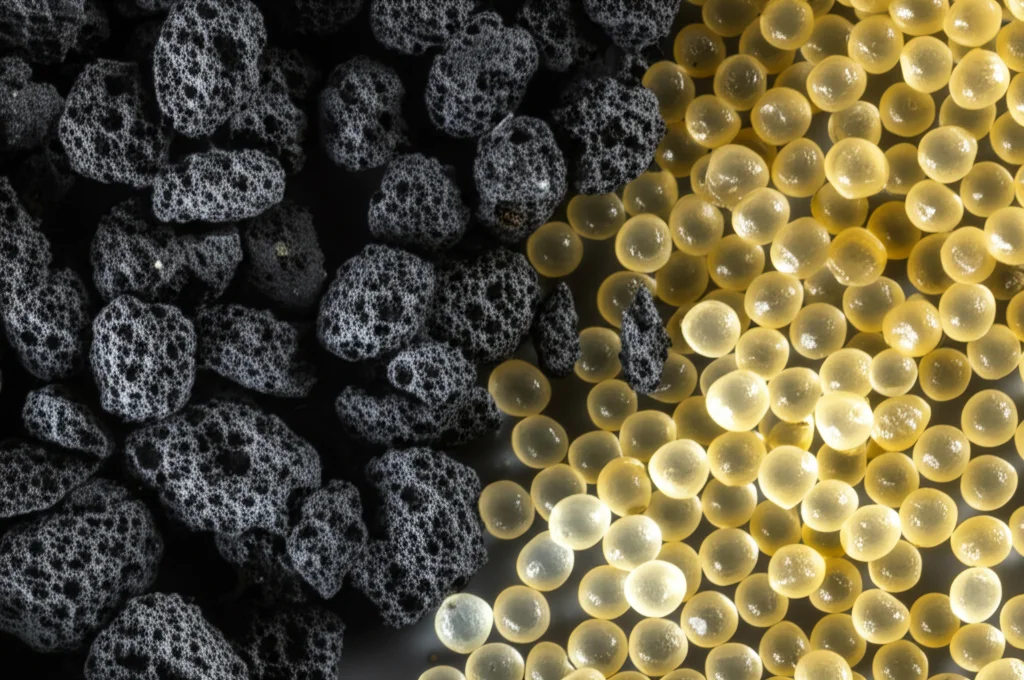

Ragazzi, parliamoci chiaro: l’acqua pulita è una risorsa sempre più preziosa e minacciata. Uno dei grandi cattivi della storia sono gli inquinanti organici – pensate a pesticidi, residui di farmaci, additivi alimentari… insomma, un bel mix poco simpatico che finisce nelle nostre risorse idriche. Fortunatamente, abbiamo delle armi per combattere questa battaglia, e una delle più promettenti è l’adsorbimento fisico. Immaginatelo come una sorta di “calamita” super selettiva: materiali come il biochar (un carbone vegetale super poroso) e speciali resine polimeriche possono catturare queste molecole indesiderate. Bello, no? Sì, ma c’è un “ma”.

La Sfida: Capire Come Funziona Davvero

Il problema è che prevedere quanto e come un certo materiale adsorbirà uno specifico inquinante è un gran bel rompicapo. Ci sono un sacco di variabili in gioco: le caratteristiche della molecola inquinante, la struttura del materiale adsorbente (quanto è poroso? qual è la sua area superficiale?), la concentrazione dell’inquinante… fare esperimenti per ogni combinazione possibile richiederebbe tempo, risorse e una pazienza infinita.

Certo, esistono modelli matematici come il pp-LFER (Polyparameter Linear Free Energy Relationship) che provano a fare delle stime, basandosi sulle proprietà molecolari. Sono utili, per carità, ma spesso trascurano le caratteristiche specifiche dell’adsorbente o funzionano bene solo in certi intervalli di concentrazione. Insomma, ci serviva qualcosa di più potente, di più flessibile.

Ecco che Entra in Scena il Machine Learning!

Ed è qui che entriamo in gioco noi, o meglio, entra in gioco il machine learning (ML). Se non avete vissuto su Marte negli ultimi anni, saprete che l’ML è quella branca dell’intelligenza artificiale che permette ai computer di “imparare” dai dati senza essere programmati esplicitamente per ogni singolo compito. È come dare a un computer un’enorme quantità di esempi (nel nostro caso, dati di adsorbimento) e lasciargli scoprire le regole e i pattern nascosti.

L’idea era semplice ma ambiziosa: usare algoritmi di ML per creare modelli capaci di prevedere con alta precisione il grado di adsorbimento (un valore che chiamiamo logKd) basandosi su alcune caratteristiche chiave.

Il Nostro Campo di Battaglia: Dati e Modelli

Ci siamo rimboccati le maniche e abbiamo messo insieme un dataset bello corposo: 1750 punti dati relativi all’adsorbimento di 73 diverse sostanze organiche su 50 tipi di biochar e 30 resine polimeriche. Un bel po’ di roba!

Come “input” per i nostri modelli abbiamo usato 8 parametri:

- Cinque descrittori di Abraham (che ci dicono cose sulla molecola inquinante, tipo la sua capacità di interagire in certi modi, accettare o donare protoni, ecc.)

- Il volume totale dei pori dell’adsorbente (Vt)

- L’area superficiale specifica (BET) – immaginate quanta “pelle” ha il materiale per catturare le molecole

- La concentrazione all’equilibrio dell’inquinante (logCe)

L’obiettivo? Prevedere il logKd, appunto.

Prima di dare i dati in pasto ai modelli, li abbiamo “ripuliti” usando una tecnica chiamata Monte Carlo Outlier Detection (MCOD) per scovare e gestire eventuali valori anomali che avrebbero potuto confondere i nostri algoritmi. Dopodiché, abbiamo suddiviso il dataset: una parte per l’allenamento (il grosso, 1225 punti), una per il test (262) e una per la validazione finale (263).

E poi… abbiamo scatenato l’arsenale! Non ci siamo accontentati di un solo algoritmo. Abbiamo testato di tutto: dai classici come la Regressione Lineare, Ridge, Lasso, Elastic Net, agli alberi decisionali (Decision Trees) e le foreste casuali (Random Forests), passando per le macchine a vettori di supporto (SVR), i K-Nearest Neighbors (KNN), le reti neurali (ANN e CNN), i processi gaussiani (Gaussian Processes), fino ai pezzi da novanta degli algoritmi di ensemble: XGBoost, LightGBM e CatBoost. Volevamo vedere chi se la cavava meglio in questa sfida predittiva.

I Risultati: Chi Ha Vinto la Gara?

Dopo aver allenato e testato tutti questi modelli, abbiamo tirato le somme usando diverse metriche (come il famoso R², che ci dice quanto bene il modello spiega i dati, e l’MSE, l’errore quadratico medio). I risultati sono stati… illuminanti!

Immaginate un grafico, il Diagramma di Taylor, che ci permette di vedere subito quali modelli sono più vicini alla “perfezione” (cioè ai dati reali). Bene, tre nomi brillavano più degli altri: XGBoost, LightGBM e CatBoost. Questi campioni hanno mostrato prestazioni eccellenti:

- CatBoost: R² di 0.984 e MSE bassissimo (0.0212) – praticamente un cecchino!

- XGBoost: R² di 0.974 e MSE di 0.0343 – quasi perfetto.

- LightGBM: R² di 0.964 e MSE di 0.0484 – ancora incredibilmente preciso.

Questo significa che questi modelli sono stati capaci di prevedere i valori di adsorbimento con una precisione sbalorditiva!

E gli altri? Beh, i modelli più semplici come la Regressione Lineare, Lasso, Elastic Net, o gli Alberi Decisionali singoli hanno fatto il loro lavoro, ma con un’accuratezza decisamente inferiore (R² tra 0.678 e 0.875 e errori più alti). Questo conferma un’idea ormai consolidata nel mondo ML: per problemi complessi come questo, gli algoritmi più sofisticati, specialmente quelli di ensemble che combinano la forza di tanti “piccoli” modelli, fanno davvero la differenza.

Abbiamo anche visualizzato i risultati in altri modi: grafici che confrontano i valori predetti con quelli reali (nei modelli migliori, i punti si allineavano quasi perfettamente sulla diagonale!), grafici che mostrano la distribuzione degli errori (nei campioni, gli errori erano piccoli e ben distribuiti attorno allo zero). Tutto confermava la superiorità di XGBoost, LightGBM e CatBoost.

Ma Perché Funzionano Così Bene? Capire Cosa Conta Davvero

Ok, i modelli sono precisi, ma cosa hanno imparato? Quali sono i fattori che influenzano di più l’adsorbimento secondo loro? Per rispondere a questa domanda, abbiamo usato un’altra tecnica potente chiamata SHAP (Shapley Additive exPlanations). Pensatela come un modo per chiedere al modello: “Ehi, per questa previsione specifica, quanto ha pesato ogni singolo input?”.

L’analisi SHAP, insieme all’analisi di importanza delle feature fatta con Random Forest, ci ha dato una risposta chiara: i due fattori più critici sono risultati essere la concentrazione all’equilibrio (logCe) e l’area superficiale specifica (BET) dell’adsorbente. In parole povere: quanto inquinante c’è già in giro e quanto “spazio di attracco” offre il materiale sono le due cose che contano di più per prevedere quanto altro inquinante verrà catturato. Questo ha perfettamente senso anche dal punto di vista chimico-fisico, e vedere che i modelli ML sono arrivati alla stessa conclusione è una grande conferma della loro validità.

Limiti e Prossimi Passi: La Ricerca Non Finisce Qui!

Siamo entusiasti di questi risultati, ma siamo anche scienziati, quindi sappiamo che c’è sempre margine di miglioramento. Il nostro studio si basa su un set specifico di materiali e condizioni. Sarebbe fantastico poter includere più dati, magari considerando anche l’effetto di temperatura, pH e pressione sull’adsorbimento.

In futuro, potremmo esplorare modelli ibridi, che combinano la potenza del ML con le conoscenze della fisica dell’adsorbimento, per ottenere il meglio dei due mondi: precisione e interpretabilità. Pensiamo anche a come rendere questi modelli scalabili per applicazioni industriali o per monitoraggi in tempo reale. E perché non usare il transfer learning, per adattare i modelli già allenati a nuovi scenari con meno dati?

Insomma, il lavoro dimostra che il machine learning è uno strumento formidabile per affrontare la sfida della previsione dell’adsorbimento. XGBoost, LightGBM e CatBoost si sono rivelati dei veri campioni, offrendoci modelli accurati e affidabili. Capire quali fattori sono più importanti (grazie a SHAP) ci aiuta non solo a fidarci di più delle previsioni, ma anche a progettare materiali e processi migliori in futuro. La strada per acque più pulite e tecnologie più efficienti passa anche da qui, dall’intelligenza dei dati!

Fonte: Springer