Laser, AI e Metalli: Rivoluzioniamo la Formatura con Dati Immaginari e Transfer Learning!

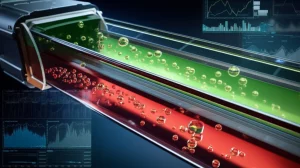

Ciao a tutti! Oggi voglio portarvi con me in un viaggio affascinante nel mondo della manifattura avanzata, un posto dove laser potenti incontrano l’intelligenza artificiale per fare cose incredibili. Nello specifico, parleremo di laser forming, una tecnologia pazzesca che ci permette di piegare e modellare lastre di metallo usando solo il calore di un laser, senza bisogno di stampi costosi. Immaginate la flessibilità, specialmente per piccole produzioni o prototipi! Ma, come in tutte le storie avvincenti, c’è una sfida.

La Sfida: Predire la Piegatura Perfetta

Il laser forming è fantastico, ma non è esattamente una passeggiata. Capire esattamente come il metallo si deformerà, specialmente quando dobbiamo fare più passaggi di laser (quella che chiamiamo formatura multi-stadio), è un vero rompicapo. Ogni passaggio cambia le carte in tavola: il metallo si “indurisce” (work hardening), la sua struttura interna si modifica, persino il modo in cui assorbe il laser può cambiare! Prevedere il percorso esatto che il laser deve seguire per ottenere la forma finale desiderata è cruciale, ma difficilissimo.

Qui entra in gioco l’intelligenza artificiale (AI), o più precisamente, il machine learning (ML). L’idea è: se non riusciamo a definire una regola precisa causa-effetto, perché non insegnare a una macchina a capirlo dai dati? Addestriamo un modello con tanti esempi (dati di training) e poi lo mettiamo alla prova su dati nuovi (dati di test) per vedere se ha imparato bene.

L’Intuizione: E se i Dati ce li Inventassimo?

Uno dei problemi principali con l’ML in questo campo è che raccogliere dati sperimentali reali è un processo lungo e costoso. Misurare con precisione la deformazione della lastra dopo ogni passaggio laser richiede tempo e risorse. E per addestrare bene un’AI, servono TANTI dati. Allora ci è venuta un’idea: e se creassimo dei dati “immaginari”?

Non si tratta di dati a caso, ovviamente! Abbiamo sviluppato un metodo per generarli usando calcoli geometrici e basandoci sulle caratteristiche che avevamo osservato nei (pochi) dati sperimentali raccolti in precedenza. In pratica, abbiamo simulato la deformazione basandoci su un angolo di piegatura medio osservato. Questo ci ha permesso di creare un dataset enorme su cui addestrare le nostre reti neurali (nello specifico, reti neurali fully connected, un tipo comune di architettura ML). L’obiettivo era addestrare il modello sui dati immaginari e poi usarlo per predire i percorsi laser necessari basandosi sui dati sperimentali reali.

Primi Risultati e la Doccia Fredda

Abbiamo addestrato la nostra rete neurale usando i dati immaginari. All’inizio, durante la fase di training e validazione (usando una parte dei dati immaginari tenuta da parte), sembrava andare tutto abbastanza bene. La rete imparava, l’errore diminuiva. Ma quando siamo andati a testare il modello sui dati sperimentali reali… beh, i risultati non erano all’altezza delle aspettative.

Soprattutto negli stadi di formatura più avanzati (cioè dopo diversi passaggi del laser), la precisione nella predizione del percorso calava drasticamente. Inoltre, abbiamo notato un fenomeno chiamato overfitting: il modello diventava bravissimo a “memorizzare” i dati di training (quelli immaginari), ma perdeva la capacità di generalizzare, cioè di applicare ciò che aveva imparato a situazioni nuove (i dati reali). Era chiaro che c’era una differenza crescente tra i nostri dati immaginari e la realtà complessa del processo sperimentale, e questa differenza diventava più marcata man mano che la formatura procedeva.

La Mossa Successiva: Il Transfer Learning

Non ci siamo persi d’animo. Se il problema era la difficoltà crescente negli stadi avanzati e l’overfitting, forse potevamo usare una tecnica più sofisticata: il transfer learning. L’idea alla base del transfer learning è semplice e potente: perché non sfruttare la conoscenza acquisita risolvendo un problema (o uno stadio precedente del processo) per affrontare meglio un problema nuovo ma correlato (lo stadio successivo)? È un po’ come imparare ad andare in bicicletta e poi usare parte di quell’equilibrio e coordinazione per imparare ad andare in moto.

Nel nostro caso, abbiamo pensato di addestrare un modello per il primo stadio di formatura e poi “trasferire” parte di quella conoscenza (i “pesi” della rete neurale) a un nuovo modello per il secondo stadio, aggiungendo magari qualche strato nuovo da addestrare specificamente per le complessità aggiuntive. Abbiamo esplorato due approcci principali:

- Fine-tuning: Usiamo i pesi del modello precedente come punto di partenza e poi ri-addestriamo *tutti* i pesi (vecchi e nuovi) sui dati del nuovo stadio.

- Final-layer learning: Congeliamo i pesi trasferiti dal modello precedente e addestriamo solo i nuovi strati aggiunti.

I Risultati del Transfer Learning: Una Vittoria Parziale

E qui le cose si sono fatte interessanti! Il metodo del fine-tuning ha mostrato risultati promettenti. Confrontato con la rete neurale “semplice” addestrata da zero per ogni stadio, il fine-tuning ha:

- Ridotto il tempo di addestramento: Circa il 35% in meno di iterazioni necessarie per raggiungere le prestazioni migliori. Questo perché partivamo già da una base di conoscenza “buona”.

- Migliorato leggermente l’accuratezza: Un miglioramento di circa 3-5 mm nella predizione dei percorsi sui dati sperimentali, specialmente negli stadi più avanzati.

- Ridotto l’overfitting: La differenza tra le prestazioni sui dati di training/validazione e quelli di test era meno marcata.

Il metodo del final-layer learning, invece, non ha funzionato altrettanto bene. Anzi, in alcuni casi ha peggiorato le prestazioni e aumentato il tempo di addestramento. Sembra che congelare troppa conoscenza pregressa impedisse al modello di adattarsi adeguatamente alle nuove sfide degli stadi successivi.

Ma Quanto Erano “Buoni” Questi Dati Immaginari?

A questo punto, era fondamentale capire meglio le differenze tra i nostri dati immaginari e quelli reali. Abbiamo fatto un confronto diretto, calcolando l’errore quadratico medio (RMSE) tra la forma della lastra simulata (immaginaria) e quella misurata (sperimentale) per lo stesso percorso laser.

I risultati sono stati illuminanti:

- Nel primo stadio: La differenza era relativamente piccola (RMSE medio di 0.16 mm). Le forme erano abbastanza simili, giustificando l’uso dei dati immaginari come punto di partenza. C’erano delle piccole discrepanze, forse dovute al “rumore” nelle misurazioni reali o a leggere variazioni nell’angolo di piegatura effettivo rispetto a quello ipotizzato.

- Nel quarto stadio: La differenza era significativamente maggiore (RMSE medio di 0.35 mm). Le discrepanze si accumulavano. Un fattore chiave sembrava essere l’intersezione dei percorsi laser: quando i percorsi si incrociavano, la rigidezza locale della lastra aumentava in modo non previsto dalla nostra simulazione semplificata, portando a piegature minori del previsto.

Questo ci ha confermato che il nostro metodo di generazione dei dati immaginari era valido per l’inizio del processo, ma doveva essere reso più sofisticato per catturare le complessità che emergono negli stadi successivi.

Cosa Abbiamo Imparato e Dove Andiamo Ora?

Tirando le somme, questa ricerca è stata un’avventura incredibile nel tentativo di domare la complessità del laser forming multi-stadio con l’AI. Ecco i punti chiave che ci portiamo a casa:

- Usare dati immaginari per addestrare modelli ML è fattibile e può essere un buon modo per aggirare la scarsità di dati reali, ma bisogna essere consapevoli dei loro limiti.

- Le reti neurali standard possono faticare con la complessità crescente e l’overfitting negli stadi avanzati di processi come questo.

- Il transfer learning, in particolare la tecnica del fine-tuning, è uno strumento potente per migliorare l’efficienza dell’addestramento e (leggermente) l’accuratezza, sfruttando la conoscenza pregressa.

- La validità dei dati immaginari diminuisce con l’aumentare degli stadi di formatura. È necessario migliorare i metodi di generazione per includere effetti più complessi (come la variazione della rigidezza o le intersezioni dei percorsi).

La strada per una predizione perfetta è ancora lunga, ma questi risultati sono incoraggianti. Il prossimo passo? Sicuramente affinare la creazione dei dati immaginari, magari introducendo variazioni nell’angolo di piegatura o modelli che tengano conto della storia pregressa della deformazione in modo più dettagliato. L’obiettivo finale è avere un sistema AI che possa guidare il processo laser in modo autonomo e preciso, aprendo nuove frontiere nella manifattura personalizzata e flessibile. È una sfida complessa, ma estremamente affascinante!

Fonte: Springer