Raccomandazioni Mai Viste Prima: Ecco Come l’IA Impara Davvero i Tuoi Gusti con ICCL!

Ammettiamolo, chi di noi non si affida quotidianamente ai sistemi di raccomandazione? Che sia per scegliere il prossimo film su Netflix, la canzone perfetta su Spotify o quel prodotto che sembra fatto apposta per noi su Amazon, questi algoritmi sono diventati i nostri consiglieri digitali personali. Dietro le quinte, una delle tecnologie più promettenti che sta rivoluzionando questo campo è quella delle reti neurali convoluzionali su grafo (GCN) applicate al filtraggio collaborativo. Sembra complicato? Tranquilli, cercherò di spiegarvelo in modo semplice e, spero, affascinante!

Il Potere dei Grafi nelle Raccomandazioni

Immaginate i sistemi di raccomandazione come dei detective che cercano di capire cosa vi piace. Il filtraggio collaborativo (CF) è una delle loro tecniche principali: costruisce una sorta di “mappa” delle interazioni tra utenti e item (prodotti, film, canzoni, ecc.). Questa mappa è un grafo bipartito, dove da una parte ci sono gli utenti e dall’altra gli item, e le linee che li collegano rappresentano le interazioni (un click, una visualizzazione, un acquisto).

I primi modelli di CF, come il buon vecchio BPR (Bayesian Personalized Ranking) basato sulla scomposizione di matrici (MF), erano bravi a catturare le relazioni più superficiali. Poi sono arrivati modelli più sofisticati come NeuMF, che hanno introdotto le reti neurali per scovare connessioni più profonde e non lineari. Recentemente, l’ispirazione è arrivata dal mondo della computer vision e del natural language processing, dove le GCN hanno fatto faville. Modelli come NGCF hanno iniziato a usare le GCN per “navigare” questi grafi di interazione, aggregando le informazioni dei nodi vicini per ottenere rappresentazioni (chiamate embedding) più ricche e catturare connessioni di “alto livello”. Pensateci: se a molti utenti a cui piace il film A piace anche il film B, probabilmente c’è una connessione interessante da esplorare!

LightGCN ha ulteriormente semplificato le cose, dimostrando che in molti casi, per il CF, non servono complesse matrici di pesi o funzioni di attivazione non lineari. Una semplice aggregazione degli embedding dei vicini è spesso sufficiente, rendendo il modello più leggero e veloce.

La Spina nel Fianco: il Problema dell’Uniformità dei Dati

Tutto bello, direte voi. E in effetti le GCN hanno portato grandi miglioramenti. Ma c’è un “però”, un problema che limita ancora le loro prestazioni: l’uniformità degli embedding. Cosa significa? In pratica, man mano che le informazioni si propagano attraverso i vari strati della rete GCN, gli embedding dei diversi utenti e item tendono a diventare troppo simili tra loro. È come se, dopo aver ascoltato troppe opinioni, tutto iniziasse a sembrare uguale, perdendo le sfumature distintive. Questa “omogeneizzazione” riduce la qualità espressiva degli embedding e, di conseguenza, l’efficacia del modello di raccomandazione. Se gli embedding sono tutti uguali, come facciamo a distinguere le preferenze uniche di un utente o le caratteristiche distintive di un item?

Inoltre, i modelli basati su GCN possono essere piuttosto sensibili al “rumore” nei dati. Le interazioni implicite (come un click) non sempre riflettono una vera preferenza, introducendo dati spuri che possono confondere il modello durante l’allenamento.

La Nostra Soluzione: ICCL, l’Apprendimento Contrastivo con Compensazione dell’Informazione

Ed è qui che entriamo in gioco noi con la nostra proposta: ICCL (Information Compensation Graph Contrastive Learning). L’idea di base è affrontare questi problemi introducendo due meccanismi principali.

1. Apprendimento Contrastivo Auto-Supervisionato con Compensazione Globale dell’Informazione

L’apprendimento contrastivo è una tecnica di apprendimento auto-supervisionato che sta dando risultati incredibili. In parole povere, si insegna al modello a riconoscere cosa è “simile” e cosa è “diverso”. Nel nostro caso, vogliamo che gli embedding di uno stesso utente o item, visti da “prospettive” leggermente diverse, siano il più possibile simili, mentre quelli di utenti o item diversi siano ben distinti.

Come creiamo queste “prospettive diverse”? Qui sta una delle nostre innovazioni. Invece di perturbare il grafo eliminando nodi o connessioni a caso (cosa che può far perdere informazioni preziose), o aggiungere rumore casuale e privo di significato agli embedding, noi proponiamo una compensazione dell’informazione. In pratica:

- Estraiamo casualmente l’embedding di un utente.

- Lo trasformiamo attraverso una funzione.

- Aggiungiamo questa informazione “compensata” (che non è rumore casuale, ma deriva da dati reali) all’embedding di un item.

Facciamo lo stesso procedimento inverso: prendiamo l’embedding di un item, lo trasformiamo e lo aggiungiamo a quello di un utente. In questo modo, creiamo due “viste” potenziate dei nostri dati, senza distruggere l’informazione originale del grafo. Su queste viste potenziate applichiamo poi l’apprendimento contrastivo. Questo aiuta a rendere gli embedding più uniformemente distribuiti (immaginateli sparsi meglio su un’ipotetica ipersfera) e migliora la robustezza del modello al rumore.

2. Propagazione Cooperativa Locale per Migliorare l’Uniformità

L’altro problema che abbiamo affrontato è come l’informazione si propaga attraverso i layer della GCN. Come detto, gli embedding dei layer più bassi sono generalmente più uniformi ma mancano della visione d’insieme data dalle connessioni di alto livello. Al contrario, gli embedding dei layer più alti catturano queste connessioni complesse ma soffrono di più il problema dell’uniformità.

La nostra soluzione è un metodo di propagazione cooperativa locale. Quando calcoliamo l’embedding di un nodo in un certo layer, non usiamo solo l’informazione del layer immediatamente precedente (come fa, ad esempio, LightGCN), ma aggreghiamo gli embedding provenienti da tutti i layer precedenti. In questo modo, l’influenza positiva degli embedding più uniformi dei layer bassi si estende anche ai layer più alti, migliorando l’uniformità complessiva senza perdere le preziose informazioni sulle connessioni a lungo raggio. E tutto questo con un costo computazionale aggiuntivo minimo!

I Risultati Parlano Chiaro

Abbiamo messo alla prova il nostro ICCL su tre dataset pubblici molto conosciuti nel settore: Movielen-1M (ML-1M), Yelp2018 e Gowalla. E i risultati sono stati davvero incoraggianti!

Confrontato con modelli di riferimento come BPR, NeuMF, NGCF, LightGCN e persino SGL (un altro approccio basato su apprendimento contrastivo che perturba il grafo), il nostro ICCL ha mostrato prestazioni significativamente migliori su tutti i dataset. Ad esempio, sul dataset ML-1M, ICCL ha ottenuto un miglioramento del 7.96% rispetto al baseline nelle predizioni top-10. Questo dimostra che il nostro approccio non solo è valido, ma anche spiegabile: la compensazione dell’informazione e la propagazione cooperativa locale fanno davvero la differenza.

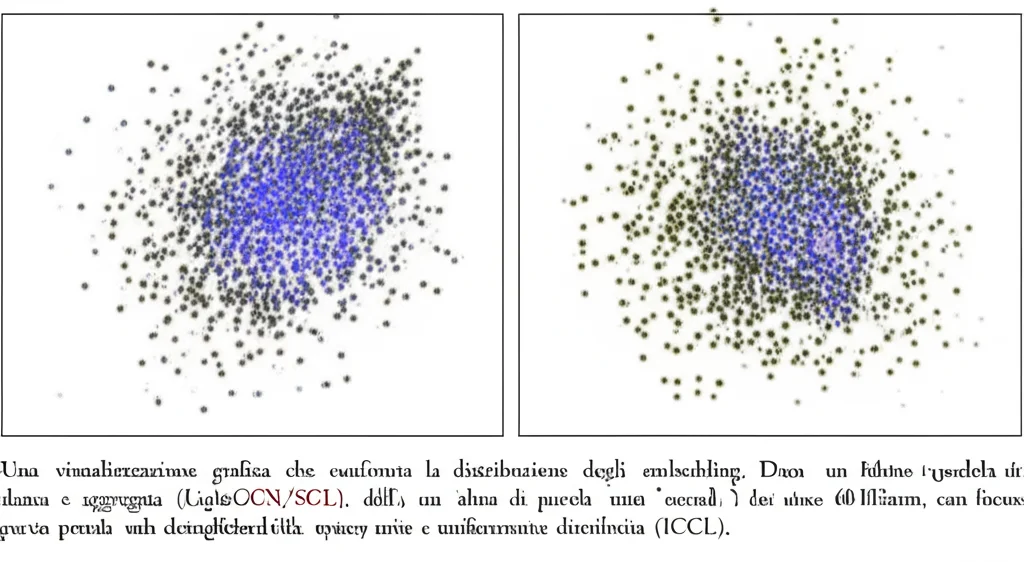

Abbiamo anche analizzato la distribuzione degli embedding utilizzando la stima di densità kernel Gaussiana (KDE). Le immagini generate mostrano chiaramente che la distribuzione degli embedding prodotti da ICCL è più uniforme, con una densità simile in diverse direzioni, mentre altri modelli tendono a mostrare aggregazioni più marcate. Questo conferma visivamente che ICCL riesce ad alleviare il problema dell’uniformità.

Gli esperimenti di ablazione (dove abbiamo testato le componenti del nostro modello separatamente) hanno confermato che sia la compensazione dell’informazione per l’apprendimento contrastivo sia la propagazione cooperativa locale contribuiscono positivamente al miglioramento delle prestazioni.

Cosa Ci Riserva il Futuro?

Con ICCL, abbiamo dimostrato che è possibile migliorare significativamente la robustezza e l’accuratezza dei sistemi di raccomandazione basati su GCN, affrontando il problema dell’uniformità degli embedding e della sensibilità al rumore. La combinazione di una strategia di data augmentation più “intelligente” (la compensazione dell’informazione) e di un meccanismo di propagazione migliorato si è rivelata vincente.

Certo, c’è sempre spazio per migliorare. Ad esempio, l’efficienza dell’allenamento, pur avendo adottato una strategia di multi-task learning, potrebbe essere ulteriormente ottimizzata. Per il futuro, stiamo esplorando altri tipi di metodi di apprendimento auto-supervisionato e tecniche di perturbazione e data augmentation ancora più efficaci, che ci permettano di costruire viste diverse del grafo senza perdere informazioni cruciali. L’obiettivo è sempre lo stesso: fornire raccomandazioni sempre più precise e personalizzate, perché capire i gusti unici di ogni persona è la vera sfida!

Fonte: Springer