IA in Sala Esami: Il Futuro della Valutazione Medica o un Giudice Troppo Buono?

Ragazzi, parliamoci chiaro. Avete mai pensato a come si diventa medici? Non parlo solo degli anni sui libri, ma di quella parte cruciale in cui bisogna dimostrare di *saper fare* le cose: un’iniezione, un nodo chirurgico, rianimare qualcuno… insomma, le basi pratiche del mestiere. Per valutare queste competenze, da anni si usano gli OSCE (Objective Structured Clinical Examination), esami a stazioni dove gli studenti passano da un compito all’altro sotto l’occhio attento di valutatori umani. Funzionano, certo, ma hanno i loro bei problemi: costano, richiedono un sacco di tempo ai professori (che spesso sono anche medici oberati di lavoro) e, diciamocelo, la valutazione umana non è sempre perfettamente oggettiva o costante.

E qui entra in gioco lei, l’Intelligenza Artificiale (IA). Con i progressi pazzeschi degli ultimi tempi, soprattutto con i modelli multimodali (quelli che capiscono testo, immagini, audio…), la domanda sorge spontanea: e se usassimo l’IA per dare i voti agli aspiranti medici durante gli OSCE? Potrebbe essere la soluzione per standardizzare, velocizzare e magari pure risparmiare?

L’Esperimento Turco: IA vs Umani sul Campo

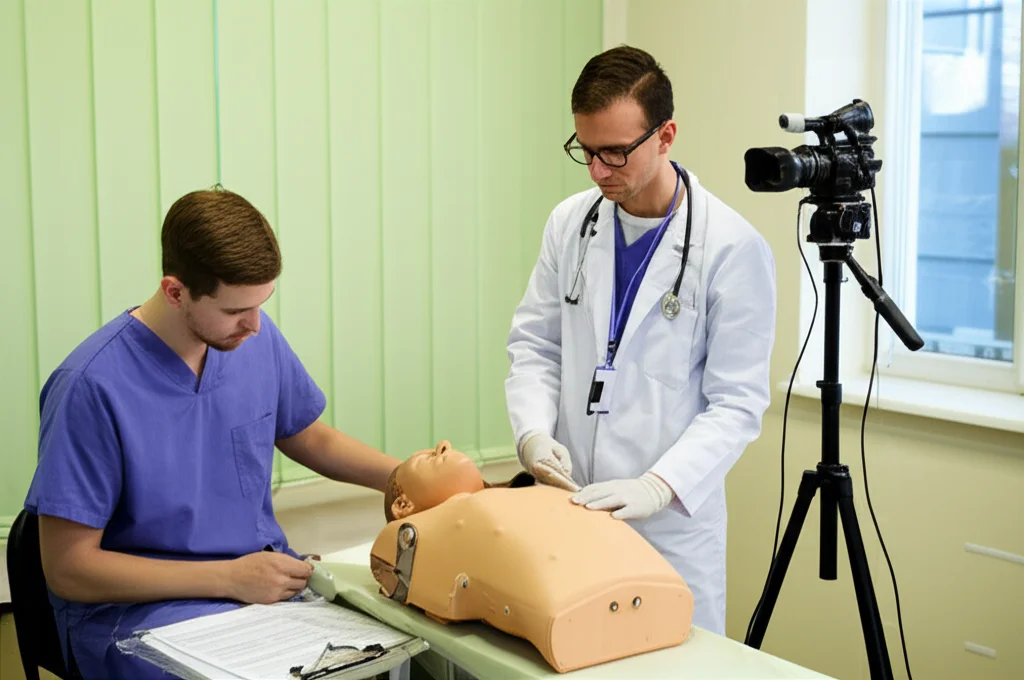

Mi sono imbattuto in uno studio super interessante, fresco fresco di pubblicazione su Springer, condotto in un’università statale turca. Hanno messo alla prova proprio questa idea. Hanno preso un gruppo di studenti di medicina dei primi anni (196 volontari, mica pochi!) e li hanno filmati mentre eseguivano quattro procedure fondamentali durante l’OSCE di fine anno:

- Iniezione intramuscolare (la classica puntura!)

- Nodo quadrato (essenziale in chirurgia)

- Supporto vitale di base (rianimazione cardiopolmonare)

- Cateterismo urinario

La cosa figa è stata come hanno gestito le valutazioni. Ogni performance è stata giudicata da ben CINQUE “giudici”:

- Un valutatore umano presente lì, in tempo reale, durante l’esame.

- Due medici esperti che hanno riguardato i video con calma dopo l’esame.

- Due sistemi di IA: il famoso ChatGPT-4o e Gemini Flash 1.5, che hanno analizzato gli stessi video.

Tutti usavano le stesse checklist standardizzate, quelle ufficiali dell’università, quindi i criteri erano identici per umani e macchine. L’obiettivo? Vedere quanto fossero d’accordo tra loro, specialmente tra umani e IA.

Cosa Abbiamo Scoperto? L’IA è di Manica Larga?

E qui arriva il succo. I risultati sono stati… sorprendenti, per certi versi. La prima cosa che salta all’occhio è che, in generale, le IA (sia ChatGPT-4o che Gemini) tendevano a dare voti più alti rispetto ai valutatori umani. Prendiamo l’iniezione intramuscolare: punteggio medio IA 28.23, media umana 25.25. Per il nodo chirurgico, il divario era ancora più netto: 16.07 per l’IA contro 10.44 per gli umani! Nel supporto vitale di base, i punteggi erano più vicini (17.05 IA vs 16.48 umani), mentre nel cateterismo i punteggi medi erano simili (26.68 IA vs 27.02 umani), ma con differenze notevoli su singoli criteri.

Un altro dato interessante: i punteggi dati dalle IA erano più “uniformi”, con meno variabilità (deviazione standard più bassa) rispetto a quelli degli umani. Questo suggerisce che l’IA applica i criteri in modo più rigido e costante, nel bene e nel male.

Questione di Percezione: Occhio Batte Orecchio (per Ora)

Ma la vera chiave di volta sembra essere il *tipo* di compito. I ricercatori hanno diviso i passaggi delle checklist in tre categorie:

- Visivi (V): Cose che si valutano solo guardando (es. posizionare correttamente l’ago, fare il nodo).

- Auditivi (A): Cose che richiedono comunicazione verbale (es. spiegare la procedura al paziente, chiedere il consenso).

- Visivi + Auditivi (V+A): Azioni che combinano vista e udito (es. presentarsi guardando negli occhi, spiegare mentre si fa qualcosa).

Ebbene, l’accordo tra IA e umani era decisamente migliore per i compiti puramente visivi. L’IA sembra cavarsela egregiamente nell’osservare e giudicare azioni concrete e ben visibili. Quando però entra in gioco l’udito – capire se lo studente ha spiegato bene, se ha usato le parole giuste, se ha interagito verbalmente in modo appropriato – le cose si complicano. Lì le discrepanze tra IA e umani aumentavano parecchio. Ad esempio, nel criterio “assicurare la privacy (basta conferma verbale)”, la coerenza tra i valutatori era tra le più basse.

Questo ci dice una cosa importante: le IA attuali, anche quelle multimodali avanzate come GPT-4o e Gemini, sono fortissime nell’analisi visiva, ma faticano ancora a interpretare sfumature uditive e contestuali complesse, specialmente in un ambiente “rumoroso” come un esame pratico. È un po’ come se avessero un super-occhio ma un orecchio ancora da allenare. Va detto che lo studio ha usato modelli IA “non addestrati” specificamente per questo compito; chissà, magari con un training mirato le cose potrebbero migliorare.

IA Più Buona o Meno Attenta?

Perché l’IA dà voti più alti? È più “generosa” o semplicemente meno brava a cogliere piccoli errori, esitazioni, o quelle sottigliezze che un occhio (e orecchio) umano esperto nota subito? Lo studio suggerisce che potrebbe essere una combinazione di fattori. L’IA potrebbe interpretare i criteri in modo più letterale e meno sfumato. Ad esempio, nel nodo chirurgico, dove la manualità fine è tutto, l’IA potrebbe aver avuto difficoltà a valutare la tensione del nodo o la fluidità dei movimenti, forse “vedendo” un successo dove l’umano notava un’incertezza. C’è anche il rischio, menzionato nello studio, di “interpretazioni allucinatorie” da parte dell’IA su movimenti sottili.

L’analisi statistica più approfondita (Bland-Altman) ha confermato questa tendenza dell’IA a sovrastimare leggermente le performance rispetto alla media degli umani, con un “bias” (scostamento sistematico) negativo. E Gemini Flash 1.5 è sembrato leggermente più “in linea” con gli umani rispetto a ChatGPT-4o, specialmente nei compiti visivi.

Il Futuro è Ibrido? Prospettive e Cautele

Allora, l’IA sostituirà i professori nelle commissioni d’esame? Calma. I risultati di questo studio, pur affascinanti, suggeriscono che siamo ancora lontani da uno scenario del genere. L’IA mostra un potenziale enorme, soprattutto per:

- Standardizzare: Potrebbe ridurre le differenze di giudizio tra diversi valutatori umani.

- Efficienza: Potrebbe analizzare video velocemente, liberando tempo prezioso per i docenti.

- Feedback: Potrebbe fornire analisi dettagliate e immediate agli studenti per aiutarli a migliorare.

Tuttavia, le sue attuali debolezze, specialmente nella valutazione delle competenze comunicative e uditive, sono un limite non da poco. La medicina non è solo tecnica, è anche (e soprattutto) interazione umana.

La strada più promettente, come suggeriscono anche i ricercatori, sembra quella di un modello ibrido: l’IA come strumento di supporto, un “assistente” che affianca il valutatore umano. L’IA potrebbe occuparsi dell’analisi preliminare, magari dei compiti più oggettivi e visivi, fornendo dati e punteggi di base, mentre l’umano si concentra sugli aspetti più complessi, comunicativi e sulle sfumature che la macchina ancora non coglie. Potrebbe anche diventare uno strumento di coaching o di “peer education” virtuale.

Certo, restano aperte questioni importanti:

- Bias Algoritmico: L’IA potrebbe avere pregiudizi nascosti derivanti dai dati su cui è addestrata? Potrebbe penalizzare accenti diversi o stili comunicativi non standard?

- Privacy: Come gestire i dati sensibili degli studenti (video delle performance)?

- Accettazione: Studenti e docenti si fideranno di un giudizio (anche parziale) dato da una macchina?

- Addestramento: Servono modelli specificamente addestrati e validati per questo compito delicato.

In Conclusione: Un Aiuto Prezioso, Ma Non Ancora un Sostituto

Questo studio turco ci dà una fotografia nitida dello stato dell’arte: l’IA ha fatto passi da gigante e può già dare una mano concreta nella valutazione delle competenze cliniche, specialmente quelle visive. È più costante, forse, ma tende a essere un po’ “ottimista” e inciampa ancora sulle parti dell’esame che richiedono “orecchio”.

Non è ancora pronta per mandare in pensione i valutatori umani, ma si candida prepotentemente a diventare un loro prezioso alleato. Il futuro della formazione medica probabilmente vedrà una collaborazione sempre più stretta tra intelligenza umana ed artificiale, sperando di prendere il meglio da entrambe. Serviranno altre ricerche, modelli più raffinati e addestrati, e un dialogo aperto sulle implicazioni etiche. Ma la strada è tracciata, e sarà affascinante vedere dove ci porterà!

Fonte: Springer