IA in Urologia: Stiamo Rivoluzionando Davvero la Valutazione dei Medici?

Ragazzi, parliamoci chiaro: formare i futuri medici è una sfida pazzesca, specialmente in campi super specifici come l’urologia. Pensateci: un mix di decisioni oncologiche complesse, abilità chirurgiche da affinare, gestione di malattie croniche… Insomma, un bel guazzabuglio! E come facciamo a essere sicuri che i nostri specializzandi siano davvero pronti? Tradizionalmente, si usano esami con domande create da professori esperti. Ma sapete com’è, richiede un sacco di tempo, e la medicina corre veloce, quindi tenere il passo è dura.

Ecco che entra in gioco lei, l’Intelligenza Artificiale (IA). Se ne parla tanto, ma nel campo della valutazione medica, soprattutto durante i tirocini clinici, siamo ancora agli inizi. Mi sono imbattuto in uno studio affascinante che ha provato a vedere se l’IA può darci una mano proprio in urologia. L’idea? Usare l’IA per creare le domande a scelta multipla per valutare le competenze degli specializzandi durante il loro tirocinio.

Come Hanno Fatto? L’Esperimento con l’IA

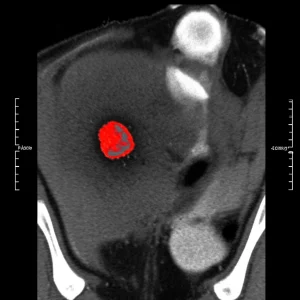

Allora, cosa hanno combinato questi ricercatori? Hanno preso due pezzi da novanta dell’IA, ChatGPT (la versione 4.0) e Gemini (la 1.5), e gli hanno chiesto di sfornare 300 domande a scelta multipla. Mica su argomenti a caso, eh! Hanno coperto sei sotto-specialità dell’urologia: uro-oncologia, endourologia, urologia funzionale, urologia pediatrica, andrologia e trapianti. Hanno dato istruzioni precise: domande basate su scenari clinici reali, con una sola risposta giusta, distrattori plausibili, linguaggio chiaro e allineate alle linee guida attuali.

Poi, la parte fondamentale: la validazione umana. Sette urologi super esperti (con più di 10 anni di esperienza clinica e attivi nella formazione) si sono messi lì, armati di griglie di valutazione standardizzate, e hanno passato al setaccio ogni singola domanda. Hanno guardato l’accuratezza tecnica, la rilevanza clinica per il tirocinio, la validità (cioè se misurava davvero quello che doveva misurare) e l’allineamento con gli obiettivi formativi. Hanno usato un metodo chiamato “Delphi modificato”, che in pratica significa che hanno discusso e votato finché non hanno raggiunto un consenso. Solo le domande approvate da almeno cinque esperti su sette sono passate. Alla fine, ne sono rimaste 100, 50 per ogni IA. Un bel taglio, eh? Solo un terzo ce l’ha fatta!

I Risultati sul Campo: Cosa Hanno Scoperto?

A questo punto, hanno coinvolto 42 specializzandi al loro primo tirocinio in urologia. Li hanno testati tre volte: all’inizio (giorno 1), a metà (giorno 11, dopo 40 ore di pratica) e alla fine del tirocinio (giorno 21, dopo 72 ore). Per non far memorizzare le domande, le 100 validate sono state divise a caso in tre set equivalenti (A, B, C) e somministrate in ordine casuale.

E i risultati? Beh, sono stati incoraggianti! I punteggi medi sono migliorati nettamente: dal 45.2% iniziale, al 62.8% a metà, fino a un bel 78.4% alla fine. Questo ci dice una cosa importante: le domande generate dall’IA, una volta validate, sembrano funzionare nel misurare l’apprendimento durante il tirocinio. C’era una forte correlazione tra il tempo passato in reparto e il miglioramento dei punteggi (r = 0.78, mica poco!).

Un’altra chicca: le domande basate su scenari clinici si sono dimostrate migliori nel “discriminare” (cioè distinguere chi sa da chi non sa) rispetto a quelle basate sulla semplice memorizzazione (indici medi di discriminazione: 0.28 vs 0.14). Questo suggerisce che l’IA è più utile quando le chiediamo di creare situazioni complesse, simili alla realtà clinica.

Ma è Tutto Oro Quello che Luccica? Limiti e Considerazioni

Certo, non possiamo dire che l’IA sia la bacchetta magica. Prima di tutto, l’accuratezza tecnica delle domande generate inizialmente era intorno all’84% (simile per ChatGPT e Gemini). Buona, ma non perfetta. E il fatto che solo un terzo delle domande sia stato validato dagli esperti ci ricorda che l’occhio umano (e l’esperienza clinica) è ancora insostituibile. Non possiamo fidarci ciecamente dell’output dell’IA, specialmente per valutazioni importanti.

Inoltre, anche se le domande validate misuravano bene l’apprendimento, la loro capacità di discriminazione era inferiore a quella delle domande tradizionali usate negli esami di stato (indice medio 0.28 per l’IA vs 0.42 per le tradizionali). Questo significa che, al momento, queste domande vanno benissimo per le valutazioni formative (quelle fatte durante il percorso per capire come sta andando l’apprendimento), ma forse non sono ancora pronte per gli esami finali ad alto impatto (high-stakes testing), dove serve una precisione chirurgica nel distinguere i livelli di competenza.

Lo studio ha anche mostrato che la qualità delle domande variava a seconda della sotto-specialità. L’IA se la cavava meglio in aree con linee guida molto standardizzate, come l’uro-oncologia (accuratezza 87.2%, tasso di validazione 38.2%), mentre faticava un po’ di più in campi come i trapianti (accuratezza 80.6%, tasso di validazione 28.9%). Questo ci suggerisce dove concentrare di più l’attenzione umana durante la revisione.

Infine, non dimentichiamo i limiti dello studio stesso: è stato fatto in un solo centro universitario in Turchia, con un numero relativamente piccolo di studenti (42) e per un periodo breve (3 settimane). Serviranno studi più ampi, in contesti diversi e magari con follow-up più lunghi per confermare questi risultati.

Allora, Qual è il Futuro? Un Modello Ibrido

Qual è la morale della favola? L’IA ha un potenziale enorme per aiutarci nella formazione medica, anche in campi tosti come l’urologia. Può farci risparmiare un sacco di tempo nella creazione delle domande (si stima un risparmio del 65% del tempo per domanda validata!). Può generare scenari clinici realistici che aiutano a valutare non solo la conoscenza, ma anche il ragionamento clinico.

Ma non può fare tutto da sola. La strada migliore sembra essere un modello ibrido:

- L’IA genera una bozza di domande seguendo istruzioni precise.

- Esperti umani (medici, formatori) le revisionano attentamente, correggono, scartano quelle non valide.

- Le domande validate vengono usate per le valutazioni formative, monitorando continuamente la loro performance.

- I dati raccolti servono a migliorare sia le istruzioni date all’IA (i “prompt”) sia i modelli stessi.

In pratica, l’IA diventa un assistente super efficiente, ma la supervisione e la validazione umana rimangono centrali per garantire qualità e sicurezza. Dobbiamo continuare a ricercare per migliorare la capacità discriminativa dell’IA, addestrare modelli specifici per ogni specialità e magari sviluppare strumenti automatici che aiutino nella validazione.

Insomma, l’IA non ci ruberà il lavoro (almeno non quello di formatori!), ma può diventare un alleato prezioso per rendere la valutazione delle competenze mediche più efficiente, moderna e, speriamo, ancora più efficace nel preparare i medici di domani. La strada è tracciata, ma serve cautela, supervisione esperta e validazione continua. Staremo a vedere cosa ci riserva il futuro!

Fonte: Springer