HLNet: L’IA con Super Vista per Scovare i Tumori Cerebrali

Ciao a tutti! Oggi voglio parlarvi di qualcosa che mi appassiona tantissimo: l’incontro tra intelligenza artificiale (IA) e medicina, in particolare come stiamo cercando di “insegnare” ai computer a vedere cose che per l’occhio umano, anche esperto, sono difficilissime da cogliere. Immaginate di dover trovare un piccolo dettaglio nascosto in un’immagine complessa… ecco, per i medici che analizzano le risonanze magnetiche (MRI) del cervello alla ricerca di tumori, la sfida è simile, ma con implicazioni enormemente più grandi.

La Sfida: Vedere il Tumore nel Dettaglio

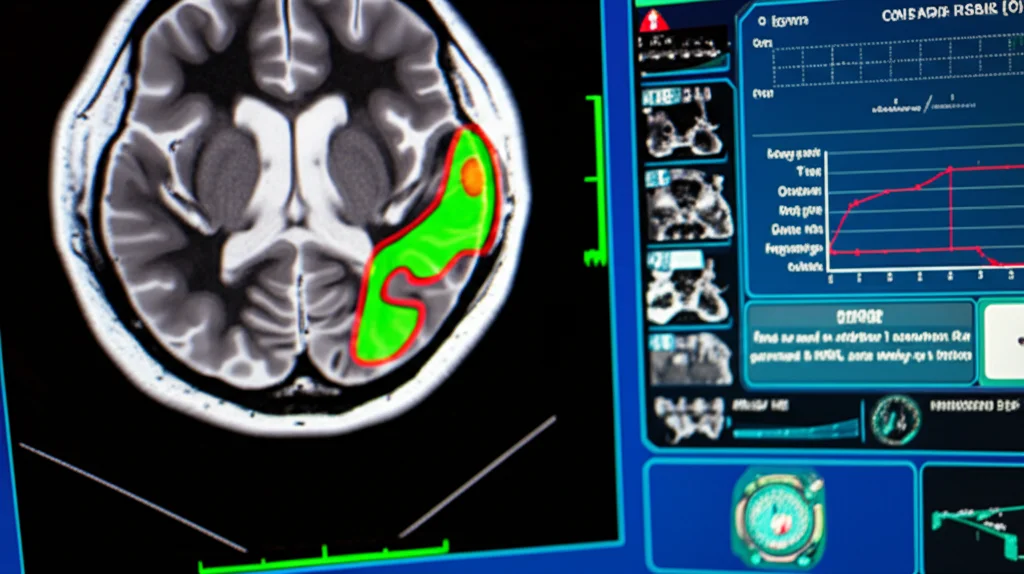

La segmentazione dei tumori cerebrali, cioè la capacità di delineare con precisione i confini del tumore separandolo dal tessuto sano nelle immagini mediche, è un passo fondamentale. Serve per capire dove si trova esattamente il tumore, quanto è grande, come cresce nel tempo e se ci sono anomalie nei tessuti circostanti. Pensate a quanto sia cruciale per pianificare un intervento chirurgico o una radioterapia: una mappa precisa è tutto!

Negli ultimi anni, l’IA, e in particolare il deep learning, ha fatto passi da gigante in questo campo. Algoritmi addestrati su migliaia di immagini mediche riescono a identificare e segmentare i tumori con un’accuratezza impressionante. Usano reti neurali complesse per distinguere il tessuto malato da quello sano, migliorando l’efficienza e la precisione della diagnosi. Questa tecnologia promette di rivoluzionare il modo in cui trattiamo il cancro, portando a piani di cura più personalizzati e mirati.

U-Net e U-Net++: Buoni Punti di Partenza, Ma Si Può Fare di Meglio?

Tra gli strumenti più usati in questo campo c’è la famiglia di modelli U-Net. La U-Net originale, e la sua evoluzione U-Net++, sono architetture di reti neurali convoluzionali che si sono dimostrate molto efficaci nella segmentazione di immagini mediche, incluse quelle cerebrali. Funzionano con una struttura a “encoder-decoder” (una parte che comprime l’informazione per capirne il contesto e una che la riespande per localizzare i dettagli) e delle “skip connections” che aiutano a non perdere informazioni importanti durante il processo.

La U-Net++ è ancora più sofisticata, catturando informazioni sia locali che globali in modo efficiente, e ha raggiunto ottimi risultati, con coefficienti di somiglianza (come il Dice score, una metrica che misura quanto la segmentazione dell’IA si sovrappone a quella “vera” fatta da un esperto) che sfiorano il 90%. Ma la ricerca non si ferma mai, giusto? Ci siamo chiesti: possiamo dare a questi modelli una sorta di “super vista”?

HLNet: L’Ingrediente Segreto è l’Attenzione di Alto Livello

Ed è qui che entra in gioco il nostro protagonista: HLNet. L’idea alla base è quella di potenziare la U-Net++ integrandovi un meccanismo di “attenzione di alto livello” (High-Level Attention). Cosa significa?

Immaginate un meccanismo di attenzione come un evidenziatore: permette al modello di concentrarsi sulle parti più importanti dell’immagine per prendere una decisione. I meccanismi di attenzione tradizionali (di primo ordine) fanno già un buon lavoro. Ma quelli di “alto livello” (o ordine superiore, nel nostro caso abbiamo usato il secondo ordine) vanno oltre. Non si limitano a “evidenziare”, ma cercano di capire relazioni più complesse e statistiche di ordine superiore nei dati. È come se non solo vedessero i singoli pixel importanti, ma anche come questi pixel interagiscono tra loro in pattern più sofisticati.

Questo è cruciale per i tumori cerebrali, che possono avere forme irregolari, confini sfumati e presentarsi in modi molto diversi. Un meccanismo di attenzione di alto livello può, in teoria, catturare queste sottigliezze meglio dei sistemi precedenti, identificando pattern insoliti e comprendendo il contesto globale senza aggiungere un carico computazionale eccessivo.

Nel nostro studio, abbiamo integrato questo modulo di attenzione di alto livello in punti strategici della U-Net++: nell’encoder, nel decoder e nelle skip connections. Abbiamo anche usato dei “blocchi residuali”, un’altra tecnica che aiuta la rete a imparare meglio caratteristiche complesse.

Alla Prova dei Fatti: I Risultati Parlano Chiaro

Ovviamente, le idee vanno testate. Abbiamo messo alla prova HLNet usando dataset di riferimento molto noti e impegnativi nel campo della ricerca sui tumori cerebrali: BraTS2018 e BraTS2019. E per essere ancora più sicuri, abbiamo usato anche un dataset clinico indipendente, UPENN-GBM, fornito dall’Università della Pennsylvania. Abbiamo confrontato HLNet con la U-Net standard, la U-Net++ “liscia” e una U-Net con un meccanismo di attenzione più semplice (HLAU-Net).

I risultati sono stati davvero incoraggianti! Usando il Dice score come metro di paragone, HLNet ha ottenuto punteggi notevoli:

- Sul dataset BraTS2019: 88.68% per il tumore che cattura il contrasto (ET), 89.71% per il nucleo del tumore (TC) e 91.50% per l’intero tumore (WT).

- Sul dataset UPENN-GBM: addirittura 90.93% (ET), 92.79% (TC) e 93.77% (WT).

Questi numeri sono significativamente migliori rispetto ai modelli di base. Ad esempio, rispetto alla U-Net standard, su BraTS2019 abbiamo visto miglioramenti fino al 10% per ET, 8.8% per TC e 9.4% per WT. Anche rispetto alla già performante U-Net++, HLNet ha mostrato miglioramenti consistenti (fino all’8% per ET, 7.1% per TC e 6.6% per WT su BraTS2019).

Abbiamo anche notato che HLNet sembra essere particolarmente bravo a identificare aree tumorali che altri modelli faticavano a vedere, specialmente quelle più piccole o con confini meno definiti. Questo suggerisce che l’attenzione di alto livello sta davvero aiutando a catturare dettagli cruciali.

Perché Funziona? E Quali Sono i Prossimi Passi?

L’integrazione dell’attenzione di alto livello sembra dare a HLNet una marcia in più nel:

- Estrarre caratteristiche più significative: Capisce meglio quali parti dell’immagine sono davvero rilevanti per identificare il tumore.

- Modellare relazioni complesse: Va oltre i pattern semplici, cogliendo sfumature e contesti globali.

- Migliorare la generalizzazione: I buoni risultati su dataset diversi (BraTS e UPENN-GBM) suggeriscono che il modello non impara solo a memoria le immagini di training, ma acquisisce una comprensione più robusta.

Certo, ci sono ancora sfide. Addestrare questi modelli richiede molti dati e tempo computazionale, e bisogna stare attenti all’overfitting (quando il modello diventa troppo bravo sui dati di training ma perde capacità di generalizzare su nuovi dati). Usiamo tecniche come il dropout e l’early stopping per mitigare questo rischio, ma è un aspetto da monitorare sempre.

Il potenziale, però, è enorme. Vedo HLNet non solo come uno strumento per i tumori cerebrali su MRI, ma potenzialmente applicabile anche ad altri tipi di tumore (rene, fegato) e ad altre modalità di imaging, come la Tomografia Computerizzata (CT). Immaginate di poter integrare un sistema così potente direttamente nelle console degli scanner MRI o CT, fornendo una segmentazione quasi in tempo reale subito dopo l’acquisizione dell’immagine. Sarebbe un aiuto incredibile per la diagnosi e la pianificazione terapeutica!

Stiamo anche pensando a come esplorare ordini di attenzione ancora più alti (terzo ordine e oltre), anche se la complessità aumenta. La ricerca continua, e ogni passo avanti ci avvicina a strumenti diagnostici sempre più precisi ed efficaci.

In conclusione, HLNet rappresenta un passo avanti promettente. Dimostra come l’aggiunta di meccanismi “intelligenti” come l’attenzione di alto livello possa potenziare architetture già solide come U-Net++, aprendo nuove strade per l’analisi delle immagini mediche. È un campo in continua evoluzione, e sono entusiasta di vedere dove ci porterà!

Fonte: Springer