GPT: Un Alleato Sorprendente per Velocizzare la Ricerca Ambientale?

Avete mai pensato a quanto lavoro ci sia dietro una ricerca scientifica seria, specialmente quelle che cercano di mettere insieme tutti gli studi fatti su un certo argomento? Parlo delle cosiddette revisioni sistematiche. Uno dei passaggi più lunghi e, diciamocelo, un po’ noiosi, è lo screening iniziale: leggere centinaia, a volte migliaia, di titoli e abstract (i riassuntini degli articoli) per capire quali siano davvero rilevanti per la nostra domanda di ricerca. È un lavoro immane che richiede tempo, concentrazione e, spesso, più di una persona per garantire l’oggettività.

Ma se vi dicessi che forse abbiamo trovato un aiutante inaspettato? Un aiutante che non si stanca, non si distrae e potrebbe farci risparmiare un sacco di tempo? Sto parlando di GPT, il famoso modello linguistico di OpenAI che sta facendo tanto parlare di sé.

La Sfida: Screening di Migliaia di Articoli

Immaginate di dover analizzare quasi 12.000 articoli scientifici. È esattamente quello che è successo in uno studio recente nel campo, super attuale e in rapida evoluzione, delle infrastrutture di ricarica per veicoli elettrici. Un campo dove le revisioni sistematiche non sono ancora così consolidate come in medicina, per esempio. Tradizionalmente, questo screening iniziale viene fatto manualmente da ricercatori esperti. Nel nostro caso di studio, prima di iniziare, abbiamo fatto un test di coerenza tra tre revisori su un campione di 100 articoli, raggiungendo un accordo dell’88% al primo colpo. Non male, eh? Questo ci dà fiducia nel processo manuale, ma resta il fatto che è un lavoro enorme.

Arriva GPT: Un Nuovo Aiutante?

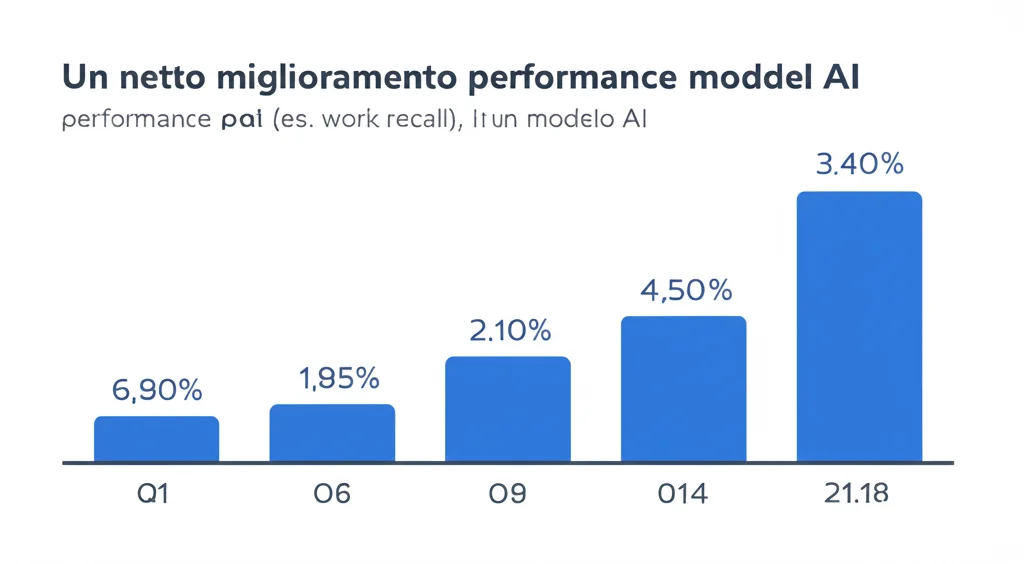

Qui entra in gioco la curiosità: e se provassimo a usare GPT per questo compito? L’idea era semplice: dare a diverse versioni di GPT (precisamente gpt-3.5-0311, gpt-3.5-0613 e l’allora più recente gpt-4-1106, testato a novembre 2023) le stesse istruzioni e criteri di inclusione/esclusione usati dai revisori umani. Abbiamo chiesto a GPT di “leggere” titolo e abstract e di darci una probabilità di rilevanza da 0 (per niente rilevante) a 1 (molto rilevante), motivando anche la sua scelta. Niente addestramento specifico, niente “fine tuning”, solo le istruzioni chiare e i criteri. Volevamo vedere come se la cavava “out of the box”.

Risultati Che Fanno Strizzare Gli Occhi

Beh, i risultati sono stati, onestamente, sorprendenti. Soprattutto con l’ultima versione testata, GPT-4. Usando una soglia di probabilità “di default” di 0.5 (cioè, consideriamo rilevante tutto ciò che GPT ritiene almeno al 50% probabile), questo modello ha raggiunto un tasso di recall del 100%. Cosa significa? Significa che non ha scartato nemmeno un articolo che i revisori umani avevano considerato rilevante! Questo è fondamentale, perché perdere studi importanti è l’errore più grave che si possa fare in questa fase.

Ma non è tutto. Raggiungendo questo 100% di recall, GPT-4 avrebbe permesso di risparmiare circa il 50% del tempo di screening manuale. In pratica, avrebbe scartato automaticamente metà degli articoli irrilevanti, lasciando ai ricercatori “solo” l’altra metà da controllare.

E se fossimo disposti a correre un rischio minimo, accettando di perdere potenzialmente fino al 5% degli studi rilevanti (un recall superiore al 95%)? In quel caso, impostando una soglia di probabilità più alta, il risparmio di tempo sarebbe potuto salire addirittura al 75%! Stiamo parlando di un taglio drastico del lavoro più tedioso.

Un’altra cosa interessante: abbiamo notato che le prestazioni migliorano nettamente con le versioni più recenti di GPT. La prima versione testata era molto più cauta, mentre GPT-4 è diventato incredibilmente più preciso nel distinguere il grano dal loglio. Anzi, a volte GPT sembrava persino più “efficiente” degli umani: tendeva a scartare già nella fase di titolo/abstract articoli che gli umani avrebbero tenuto, per poi scartarli solo dopo aver letto il testo completo. In pratica, anticipava il lavoro!

Ma È Tutto Oro Quello Che Luccica?

Ovviamente, bisogna andarci cauti. Questi risultati sono entusiasmanti, ma derivano da un singolo studio, in un campo specifico (quello ambientale/tecnologico, meno standardizzato della medicina) e usando un solo set di istruzioni (prompt). Ci sono diverse questioni aperte:

- Riproducibilità e Trasparenza: I modelli come GPT vengono aggiornati continuamente dai loro sviluppatori. Questo è ottimo per le prestazioni, ma rende difficile replicare esattamente i risultati e capire *perché* il modello prende certe decisioni (la famosa “scatola nera” dell’AI).

- Scelta della Soglia: Come decidere a priori la soglia di probabilità ottimale? Un 0.5 sembra un buon punto di partenza, ma forse si può osare di più. Servono più test in campi diversi.

- Letteratura Grigia: Non abbiamo potuto testare GPT su report, documenti governativi, ecc. (la “letteratura grigia”), perché spesso mancano di abstract strutturati. Come gestire questi casi?

- Errori Umani vs AI: Anche gli umani sbagliano. Confrontare l’AI con lo screening umano ha i suoi limiti. Servono metodi di valutazione più robusti.

- Bias e Affidabilità: Non dimentichiamo i noti problemi degli LLM, come la tendenza a “inventare” informazioni (hallucinations) o i possibili bias presenti nei dati di addestramento.

Uno Sguardo al Futuro (Con Cautela)

Nonostante le doverose cautele, il potenziale è innegabile. Immaginate revisioni sistematiche, specialmente in campi che evolvono rapidamente come quelli ambientali e della sostenibilità, completate in tempi molto più brevi. Questo non solo ridurrebbe i costi, ma libererebbe tempo prezioso per i ricercatori, permettendo loro di concentrarsi sull’analisi, l’interpretazione e la sintesi dei risultati, che è poi il vero cuore della ricerca.

L’idea non è (ancora) quella di sostituire completamente l’uomo. La supervisione umana resta cruciale. Ma usare GPT come un assistente super efficiente per la prima, faticosa scrematura? Beh, sembra molto più che una semplice possibilità. È una strada che vale assolutamente la pena esplorare ulteriormente. Il risparmio potenziale del 50-75% del tempo di screening è un argomento troppo forte per essere ignorato. Continueremo a testare, a verificare, a migliorare le metodologie, perché se queste promesse saranno confermate su larga scala, potrebbe davvero cambiare il modo in cui facciamo sintesi della conoscenza scientifica.

Fonte: Springer