GPSOM: Vi presento l’algoritmo a sciame di particelle che sta rivoluzionando l’ottimizzazione (e non solo in ingegneria!)

Amici miei, oggi voglio parlarvi di una sfida che, da addetto ai lavori, mi appassiona e mi impegna costantemente: l’ottimizzazione. Sembra una parola complessa, ma in realtà è qualcosa con cui abbiamo a che fare tutti i giorni. Pensateci: migliorare l’efficienza produttiva, ridurre i costi, progettare prodotti migliori… sono tutti problemi di ottimizzazione! E risolverli è cruciale non solo per far progredire la ricerca scientifica, ma anche per accelerare lo sviluppo tecnologico industriale.

Quando ci troviamo di fronte a problemi del mondo reale, che spesso sono enormi, non lineari e difficili da “scomporre” con i metodi tradizionali (come la discesa del gradiente o il metodo di Newton), questi ultimi mostrano la corda. Hanno una complessità computazionale elevata e, diciamocelo, tendono a rimanere “incastrati” in soluzioni che sembrano buone ma non sono le migliori in assoluto, i cosiddetti ottimi locali. Ecco perché c’è un bisogno spasmodico di algoritmi più efficienti e robusti.

L’ispirazione dalla Natura: nasce l’Intelligenza Computazionale

E dove troviamo l’ispirazione per questi nuovi algoritmi? Ma nella natura, ovviamente! Trasformare fenomeni, comportamenti e meccanismi naturali in modelli computazionali è diventato un modo innovativo per affrontare questi rompicapi. Questo approccio non si limita all’ottimizzazione, ma si estende a tutto il campo dell’Intelligenza Computazionale (CI). La CI è un universo di strategie computazionali ispirate alla natura, applicate per risolvere questioni complesse del mondo reale. Include principalmente:

- Sistemi Fuzzy (FS)

- Reti Neurali (NN)

- Intelligenza di Sciame (SI)

- Calcolo Evolutivo (EC)

Ognuno di questi approcci ha i suoi punti di forza, ma anche le sue sfide. I Sistemi Fuzzy gestiscono bene l’incertezza, ma la loro costruzione dipende molto da dati empirici e conoscenze esperte. Le Reti Neurali sono potenti nel riconoscere pattern, ma l’addestramento può essere lungo e soggetto a problemi come l’overfitting. L’Intelligenza di Sciame, che simula comportamenti collettivi (formiche, uccelli, pesci), è affascinante, ma la sua performance dipende da molti fattori, come la dimensione del gruppo e le regole di interazione. Infine, il Calcolo Evolutivo, che imita la selezione naturale, deve bilanciare bene la diversità della popolazione e la velocità di convergenza.

Particle Swarm Optimization (PSO): un classico con qualche acciacco

All’interno dell’Intelligenza di Sciame, uno degli algoritmi più noti è il Particle Swarm Optimization (PSO), presentato da Kennedy ed Eberhart nel 1995. Immaginate uno stormo di uccelli che cerca cibo: l’obiettivo (il cibo) è la funzione da ottimizzare, e ogni uccello (particella) è una potenziale soluzione. Le particelle si muovono nello spazio di ricerca, aggiornando la loro posizione e velocità in base alla loro migliore esperienza passata e alla migliore esperienza dell’intero sciame.

Però, anche il PSO classico, pur essendo brillante, ha i suoi limiti quando si tratta di problemi complessi e ad alta dimensionalità: è sensibile ai parametri iniziali, la diversità della popolazione può scarseggiare e, sì, anche lui può rimanere bloccato in ottimi locali.

La mia proposta: GPSOM, l’evoluzione del PSO

Per superare questi ostacoli, ho sviluppato un nuovo algoritmo che ho chiamato GPSOM (Group-based Particle Swarm Optimization with Multiple Strategies). L’idea di base è semplice ma potente: invece di avere un unico sciame, divido la popolazione in tre sottogruppi, ognuno con una strategia mirata in base alla fase di ottimizzazione. Questo migliora significativamente le prestazioni!

Ecco i contributi e le innovazioni principali del mio GPSOM:

- Divisione in sottogruppi: Ho suddiviso la popolazione in tre sottogruppi con strategie di aggiornamento distinte (esplorazione, sfruttamento, equilibrio) per affrontare i difetti del PSO classico.

- Fase di esplorazione (Sottogruppo 1): Qui, un operatore (A) viene aggiustato dinamicamente per potenziare la capacità dell’algoritmo di cercare nuove regioni dello spazio delle soluzioni ed evitare la convergenza prematura.

- Fase di sfruttamento (Sottogruppo 2): Ho introdotto fattori seno e coseno e un meccanismo di autoprotezione ispirato al Genghis Khan Shark Optimizer (GKSO) per migliorare la capacità di ricerca locale.

- Fase di equilibrio (Sottogruppo 3): Un fattore di peso (Coef) e operatori di aggiustamento della posizione permettono di regolare dinamicamente la strategia di ricerca, mantenendo la diversità della popolazione e migliorando la qualità della soluzione.

Vi spiego un po’ più nel dettaglio come funzionano questi sottogruppi. Immaginiamo di avere una popolazione totale N. Il 20% forma il Sottogruppo 1 (Pop1), un altro 20% forma il Sottogruppo 2 (Pop2), e il restante 60% forma il Sottogruppo 3 (Pop3). Ho fatto diverse prove (analisi di sensibilità) e questa suddivisione 20-20-60 sembra dare i risultati migliori!

Sottogruppo 1: Gli Esploratori Audaci

Pop1 è il nostro pioniere. Il suo obiettivo è esplorare ampiamente lo spazio delle soluzioni per scoprire aree promettenti. Per questo, ho introdotto un operatore di aggiustamento dinamico (A). Quando (A > 1) (siamo all’inizio, in fase di ricerca ampia), applichiamo una strategia di mutazione differenziale. Questo aumenta la diversità della popolazione. Quando (A < 1) (siamo in una fase di ricerca più raffinata), entra in gioco un operatore di aggiornamento della posizione (Loup), che permette ricerche più dettagliate nell'area corrente. L'idea è bilanciare l'esplorazione globale con la capacità di "scavare" localmente.

Sottogruppo 2: Gli Sfruttatori Intelligenti

Dopo che Pop1 ha mappato il territorio, Pop2 entra in azione. Il suo scopo è condurre una ricerca fine vicino alle soluzioni di alta qualità già identificate. Per evitare che le particelle “corrano” troppo velocemente e divergano, ho aggiunto un fattore seno-coseno (y) che regola dinamicamente la loro velocità. Inoltre, per migliorare la ricerca globale e non cadere in trappole locali, ho incorporato una strategia di “autoprotezione” presa dall’algoritmo GKSO. Fattori di aggiustamento dinamici ((L, alpha, beta)) permettono di adattare la strategia in tempo reale.

Sottogruppo 3: I Bilanciatori Strategici

Pop3, il gruppo più numeroso, ha il compito di bilanciare esplorazione e sfruttamento. A seconda di un valore casuale (rand) e di un fattore di peso (Coef), si adottano strategie diverse. Se rand < Coef < 0.5, si enfatizza una ricerca più esplorativa. Se Coef < rand < 0.5, ci si concentra sulla ricerca locale e sull’affinamento. Ho anche preso ispirazione dall’algoritmo Manta Ray Foraging Optimization per i coefficienti a elica variabile ((beta) e (a)), che controllano flessibilmente il passo di ricerca. Un fattore di ponderazione (Ind) aiuta a stimolare le particelle con scarse capacità di ricerca o ad accelerare la convergenza di quelle vicine alla soluzione ottimale.

GPSOM alla prova dei fatti: i test

Per verificare l’efficacia di GPSOM, l’ho messo alla prova sul set di test benchmark CEC 2020 (che chiamo 20TS), un vero osso duro! I risultati sono stati entusiasmanti: GPSOM si è comportato significativamente meglio degli algoritmi tradizionali.

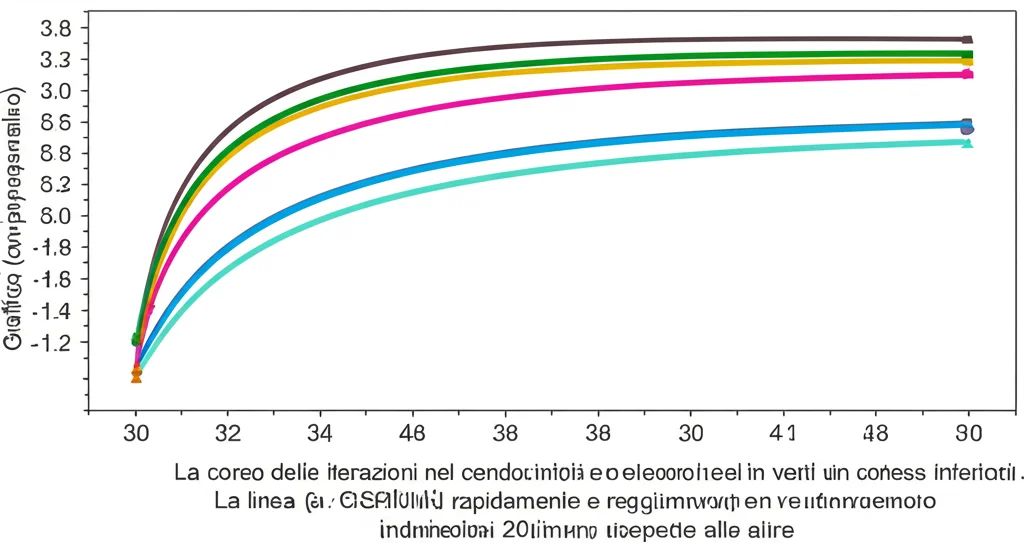

Ho condotto esperimenti di “ablazione”, cioè ho testato varianti di GPSOM con e senza le diverse strategie, per capire l’impatto di ciascuna. È emerso chiaramente che la combinazione delle tre fasi (esplorazione, sfruttamento, equilibrio) porta alle migliori prestazioni.

Ho analizzato la performance di GPSOM su funzioni test con diverse caratteristiche (unimodali, multimodali, ibride, composite) e in varie dimensionalità (10D, 50D, 100D). Le visualizzazioni della cronologia di ricerca mostrano come le particelle di GPSOM riescano a convergere vicino all’ottimo globale, dimostrando efficienza e stabilità. Anche l’analisi della diversità della popolazione ha confermato che GPSOM evita la convergenza prematura meglio del PSO tradizionale, mantenendo una buona capacità esplorativa più a lungo.

Ho confrontato GPSOM con ben 16 algoritmi ad alte prestazioni, inclusi classici come PSO e DE, versioni migliorate di PSO, e algoritmi recentissimi. Negli esperimenti a 50D e 100D sul CEC2020, GPSOM si è classificato quasi sempre primo, superando anche algoritmi molto competitivi. Ad esempio, a 100D, GPSOM è risultato il migliore in tutte e 10 le funzioni test! Questo dimostra la sua superiorità nel risolvere problemi complessi ad alta dimensionalità. Ho anche fatto un confronto specifico con sette algoritmi metaheuristici pubblicati di recente, e anche qui GPSOM ha brillato, piazzandosi primo nella maggior parte dei casi.

Applicazioni nel mondo reale: non solo teoria!

Ma la vera soddisfazione arriva quando un algoritmo funziona bene anche su problemi pratici. E GPSOM non ha deluso!

- 15 Esempi di Ingegneria: Ho testato GPSOM su 15 problemi di ottimizzazione vincolata classici dell’ingegneria (dal CEC2020 benchmark suite), come la progettazione di reattori doppi, pulegge coniche, pinze robotiche e layout di parchi eolici. A parte qualche piccola incertezza su 3 istanze, GPSOM ha mostrato capacità di ottimizzazione eccellenti sulle restanti 12.

- Controllo di Crociera dei Veicoli: Un’applicazione affascinante! Ho usato GPSOM per ottimizzare i parametri di un controller FOPID (Fractional Order Proportional Integral Derivative) per un sistema di controllo di crociera di un veicolo. L’obiettivo è minimizzare l’overshoot, il tempo di assestamento, ecc. GPSOM ha trovato la strategia di controllo più efficace, superando altri sette algoritmi, e ha mostrato la migliore risposta transitoria e stabilità nel dominio della frequenza.

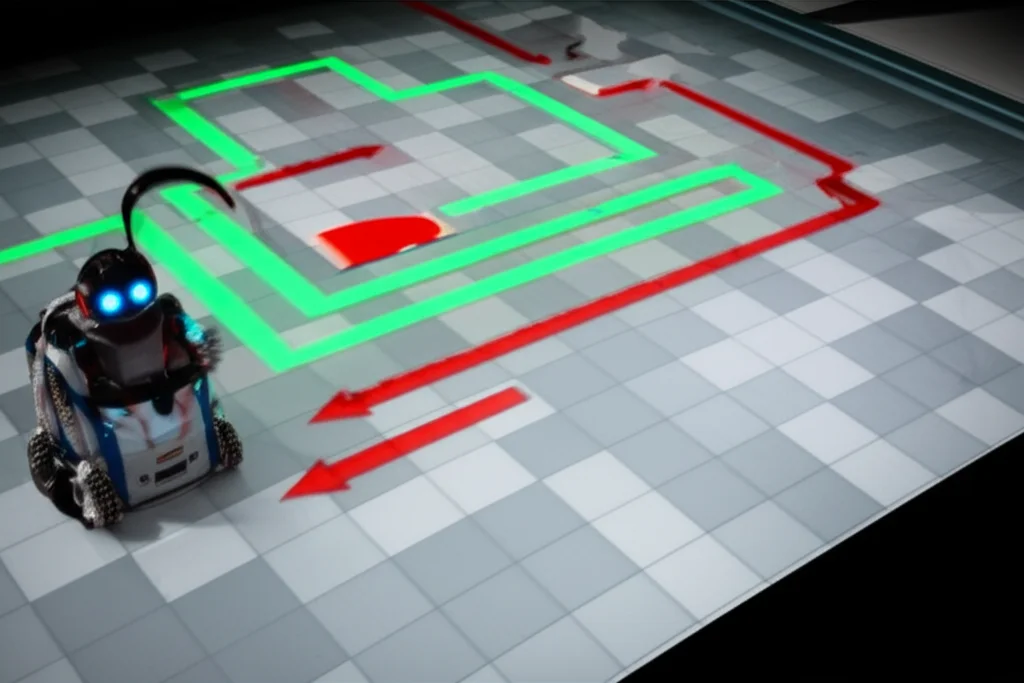

- Ottimizzazione del Percorso di Robot Mobili: Immaginate un robot che deve muoversi da un punto A a un punto B in un ambiente con ostacoli (rappresentato da una griglia). GPSOM è stato utilizzato per trovare il percorso più breve. Anche qui, confrontato con altri algoritmi, GPSOM ha dimostrato capacità di ottimizzazione del percorso notevoli, trovando spesso la soluzione ottimale.

Conclusioni e Sguardo al Futuro

Insomma, GPSOM, con la sua strategia di dividere la popolazione e adottare approcci mirati per ogni sottogruppo, si è dimostrato un algoritmo efficiente, stabile e pratico. Ha superato brillantemente i test teorici e ha mostrato grande adattabilità ed efficacia nelle applicazioni reali, dal controllo di crociera alla robotica.

Certo, c’è sempre spazio per migliorare. A volte, nelle fasi iniziali, GPSOM potrebbe enfatizzare troppo la selezione degli individui migliori, riducendo un po’ la diversità. E la sua complessità computazionale, dovuta alle nuove strategie, è un aspetto da bilanciare.

Per il futuro, sto pensando di:

- Introdurre strategie caotiche nella fase di inizializzazione per aumentare ulteriormente la diversità.

- Estendere GPSOM all’ottimizzazione multi-obiettivo, un campo davvero sfidante.

- Esplorare applicazioni interdisciplinari: combinare GPSOM con il deep learning per ottimizzare iperparametri di reti neurali, usarlo nell’ottimizzazione di orbite aerospaziali, nell’elaborazione di immagini (segmentazione, selezione di feature), nella previsione e gestione dell’energia, e ovviamente, continuare a migliorare la pianificazione di percorsi per robot e droni.

Il viaggio nell’ottimizzazione è appena iniziato, e con strumenti come GPSOM, sono convinto che potremo affrontare sfide sempre più complesse!

Fonte: Springer