Gleason Grading Automatico: La Mia Rivoluzione con l’Attenzione Gerarchica nel Cancro alla Prostata!

Amici della scienza e dell’innovazione, oggi voglio parlarvi di un argomento che mi sta particolarmente a cuore e su cui ho lavorato intensamente: come possiamo usare l’intelligenza artificiale per migliorare la diagnosi del cancro alla prostata, in particolare attraverso il sistema di classificazione di Gleason. Sembra complicato? Tranquilli, vi guiderò passo passo in questa avventura affascinante!

Il Cancro alla Prostata e il “Mistero” del Gleason Score

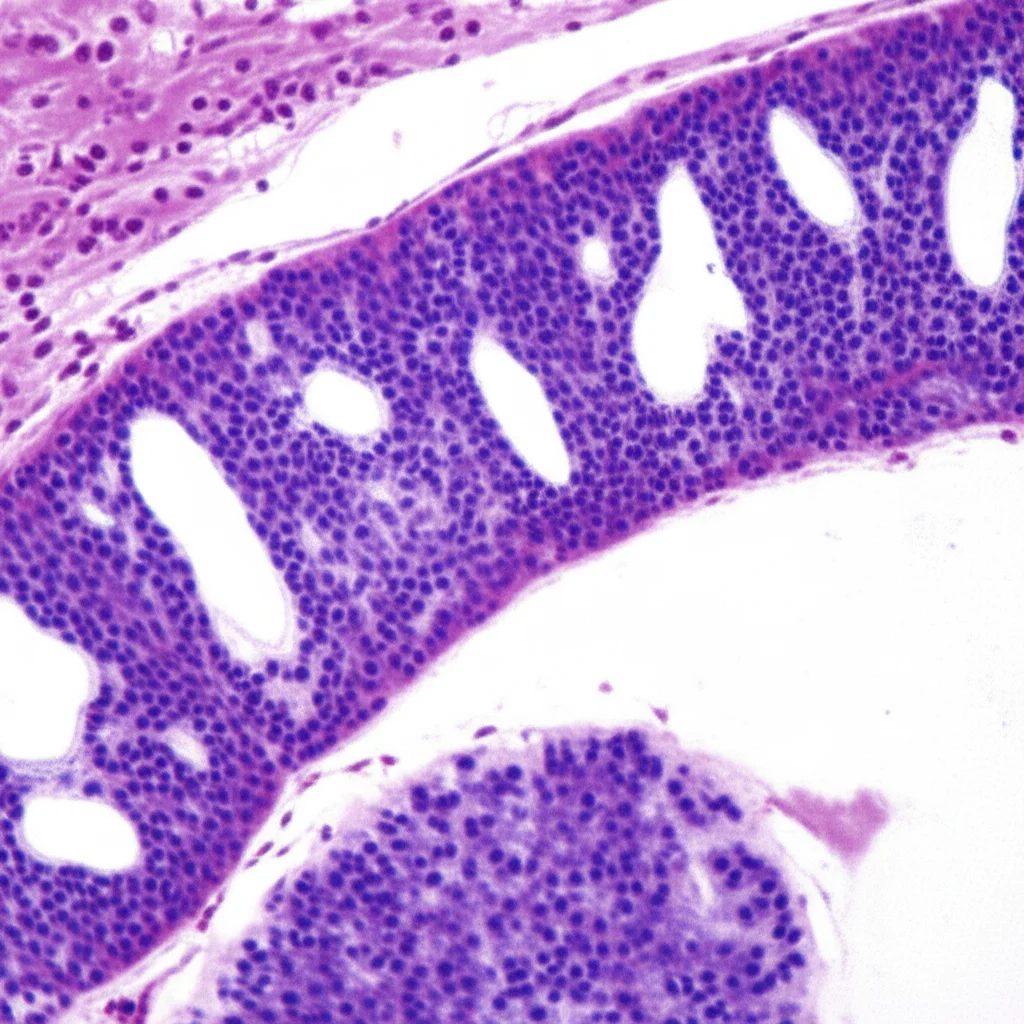

Partiamo dalle basi. Il cancro alla prostata è, purtroppo, il secondo tumore più diffuso tra gli uomini a livello globale. Capire quanto sia aggressivo è fondamentale per decidere la terapia migliore e prevedere come evolverà la malattia. Qui entra in gioco il sistema di grading di Gleason. Immaginatelo come l’ “impronta digitale” del cancro. Analizzando al microscopio la morfologia delle cellule tumorali, i patologi le dividono in 5 gradi: più alto è il numero, più il cancro è invasivo e la prognosi peggiore. Il Gleason score, poi, si ottiene sommando i due pattern di Gleason più comuni nel campione. Ad esempio, un 3+4 dà uno score di 7.

Nella pratica clinica, però, i pattern 1 e 2 sono rari e difficili da distinguere da tessuto prostatico normale o iperplasia benigna. Quindi, di solito ci si concentra sui gradi Benigno (assenza di cancro), GG3 (invasività moderata), GG4 (invasività più alta) e GG5 (morfologia anomala, prognosi peggiore). La biopsia è il test d’elezione, e i campioni vengono digitalizzati in immagini ad alta risoluzione (WSI o TMA).

Il problema? Annotare queste immagini è un lavoro lunghissimo, costoso e spesso le etichette sono a livello dell’intera immagine (slide-level) o solo per alcune aree (instance-level), e non sempre precisissime. Immaginate la fatica e il tempo che richiede!

L’Intelligenza Artificiale ci dà una Mano: il Multiple Instance Learning (MIL)

Qui entra in gioco l’IA, e in particolare un approccio chiamato Multiple Instance Learning (MIL). Pensate a un’immagine istologica intera (WSI) come a un “sacco” (bag) e alle piccole aree al suo interno (ad esempio, superpixel) come a “istanze” (instances). Il MIL è bravo a capire quali istanze dentro al sacco sono quelle “chiave” per fare una diagnosi a livello dell’intero sacco, anche se non tutte le istanze sono etichettate singolarmente o se alcune etichette sono “rumorose” (cioè imprecise).

Negli anni sono stati proposti vari modelli MIL, come ABMIL, AdditiveMIL, CLAM, DSMIL, TransMIL. Molti di questi si basano su meccanismi di attenzione per pesare l’importanza delle diverse istanze. Però, spesso si concentrano solo sulle caratteristiche globali dell’immagine o faticano a gestire contemporaneamente dettagli locali e contesto globale, soprattutto quando le etichette a livello di istanza sono scarse o inaffidabili. E se le etichette delle istanze sono derivate da quelle globali, possono portarsi dietro un bel po’ di “rumore”: aree non tumorali etichettate come positive, per esempio. Questo può confondere il modello e ridurne l’accuratezza.

La sfida, quindi, era: come possiamo creare un sistema che usi al meglio sia le etichette globali (slide-level) sia quelle locali (instance-level), riducendo l’impatto del rumore e gestendo la classificazione di Gleason come un problema multi-etichetta (più pattern di Gleason possibili nella stessa immagine) e multi-task (localizzare il cancro e classificarne il grado)?

La Nostra Soluzione: Un Meccanismo di Attenzione Gerarchica Potenziato!

Ed eccoci al cuore del mio lavoro! Abbiamo sviluppato un meccanismo di attenzione gerarchica potenziato all’interno di un modello MIL “misto”, cioè che usa entrambi i tipi di etichette. L’idea è semplice ma potente: vogliamo che il modello impari a “prestare attenzione” in modo intelligente.

Ecco i punti chiave della nostra innovazione:

- Superpixel e Informazioni Multi-Scala: Per prima cosa, usiamo l’algoritmo SLIC per dividere l’immagine in “superpixel”, cioè piccole regioni omogenee. Questo ci aiuta a catturare informazioni contestuali più ricche e a generare etichette a livello di istanza più affidabili partendo da quelle dei superpixel, riducendo il rumore.

- Attenzione Gerarchica a Doppio Ramo: Il nostro meccanismo di attenzione ha una struttura gerarchica. Un ramo (SlideAtt) si occupa del contesto globale, usando le etichette a livello di slide. L’altro ramo (InsAtt) si concentra sulle caratteristiche discriminative locali, usando le etichette a livello di istanza. Questa architettura a due rami permette di modellare il contesto globale e contemporaneamente estrarre feature locali distintive. La magia sta nel fatto che l’attenzione gerarchica sopprime dinamicamente le etichette “rumorose” a livello di istanza e amplifica le caratteristiche davvero importanti. È come avere un supervisore intelligente che dice al modello: “Guarda qui, questo è importante! Ignora quello, è rumore.”

- SEPPEG per il Contesto Spaziale: Ispirandoci ad altri lavori, abbiamo introdotto un modulo chiamato SEPPEG (Squeeze-and-Excitation blocks in Position-Encoding Pyramid Pooling Module). Questo modulo aiuta il modello a capire le correlazioni contestuali tra le istanze nello spazio, codificando la loro posizione. In pratica, il modello non solo vede “cosa” c’è in un’istanza, ma anche “dove” si trova rispetto alle altre, il che è cruciale per capire, ad esempio, le zone di transizione tra diversi gradi di Gleason.

- Gestione Multi-Etichetta e Multi-Task: Il nostro sistema è pensato per il Gleason grading, che è intrinsecamente un problema di classificazione multi-etichetta (ad esempio, un campione può avere pattern primario 4 e secondario 3) e multi-task (localizzare le aree cancerose e assegnare il grado di Gleason). I due rami del modello vengono addestrati congiuntamente e poi i loro output integrati, ottimizzando sia la localizzazione che la classificazione.

I Risultati? Davvero Promettenti!

Abbiamo testato il nostro modello su due dataset importanti per il cancro alla prostata: SICAPv2 e TMAs. E i risultati sono stati entusiasmanti! Abbiamo ottenuto punteggi AUC (Area Under the Curve, una misura di performance) di 0.9597 su SICAPv2 e 0.8889 su TMAs. Questi punteggi sono allo stato dell’arte e dimostrano la superiorità del nostro approccio rispetto ad altri metodi MIL esistenti come ABMIL, CLAM, TransMIL e MixedMIL.

Il nostro modello non solo converge più velocemente durante l’addestramento, ma raggiunge anche una maggiore accuratezza. Questo perché sfrutta simultaneamente le informazioni morfologiche e spaziali tra le istanze. Abbiamo anche condotto esperimenti di “ablazione” (togliendo parti del modello per vedere il loro contributo) e analisi di sensibilità (variando i parametri) che hanno confermato la robustezza e l’efficacia dei componenti chiave, come la codifica posizionale SEPPEG.

![]()

È interessante notare che le performance sono state diverse tra i due dataset. Su SICAPv2, che ha annotazioni a livello di pixel molto dettagliate, il modello ha imparato meglio. Su TMAs, con annotazioni più “deboli” e campioni più piccoli, è stato un po’ più difficile catturare la complessità. Questo evidenzia l’importanza della qualità delle annotazioni e della capacità di sfruttare informazioni spaziali ampie.

Cosa Significa Tutto Questo e Quali Sono i Prossimi Passi?

Questo lavoro non è solo un avanzamento tecnico nel campo del Gleason grading automatico, ma sottolinea anche il grande potenziale dei meccanismi di attenzione gerarchica nei modelli MIL misti per l’analisi di immagini mediche in generale. Immaginate un futuro in cui l’IA può assistere i patologi fornendo analisi più rapide, precise e consistenti, aiutandoli a concentrarsi sui casi più complessi.

Certo, c’è ancora strada da fare. Il nostro prossimo obiettivo sarà migliorare ulteriormente l’accuratezza delle etichette su campioni con annotazioni imprecise o incomplete, magari combinando il nostro approccio con tecniche di apprendimento semi-supervisionato o usando input a multi-risoluzione per simulare meglio la struttura gerarchica delle immagini WSI, specialmente per i dataset come TMA.

In conclusione, sono davvero entusiasta dei progressi che stiamo facendo. Sfruttare la potenza dell’attenzione gerarchica per “insegnare” ai modelli a vedere come un esperto, distinguendo il segnale dal rumore nelle complesse immagini istologiche, è una frontiera incredibilmente promettente. E spero che questo possa tradursi, un giorno, in un aiuto concreto per i pazienti e per i medici che lottano contro il cancro alla prostata.

Fonte: Springer