Emozioni Sotto la Lente: Vi Svelo GAT-CRESA, l’IA che Capisce Davvero le Nostre Chat!

Ciao a tutti, appassionati di tecnologia e curiosi del futuro! Oggi voglio parlarvi di qualcosa che mi sta davvero a cuore e che, credetemi, sta per cambiare il modo in cui le macchine ci capiscono: il riconoscimento delle emozioni nelle conversazioni (ERC, per gli amici). Sembra fantascienza, vero? Eppure, è un campo di ricerca caldissimo, fondamentale per creare servizi di empatia intelligente. Pensate a un assistente virtuale che non solo risponde alle vostre domande, ma capisce se siete felici, tristi o frustrati!

Per anni, noi ricercatori ci siamo scervellati su come fare. I primi tentativi si basavano su una singola modalità, tipo solo testo o solo audio. Ma la verità è che noi umani comunichiamo usando un mix di cose: parole, tono della voce, espressioni facciali (anche se quest’ultima non la tocchiamo oggi). Quindi, l’approccio multimodale è la via da percorrere per avere risultati più robusti e accurati.

Il Problema: Contesto Sfuggente e Montagne Russe Emotive

Ok, ma qual è il vero inghippo? Beh, capire il contesto di una conversazione è un bel rompicapo. E non è tutto: le nostre emozioni non sono mica statiche! C’è quella che chiamiamo inerzia emotiva – tendiamo a mantenere uno stato d’animo per un po’ – ma poi, zac! Qualcosa o qualcuno ci influenza e la nostra emozione cambia. Questo è l’emotion-shift, un cambio di emozione. Se un sistema non se ne accorge, addio accuratezza.

Molti studi esistenti, purtroppo, o non colgono appieno la complessità del contesto, faticando a estrarre e integrare gli indizi emotivi, oppure si concentrano troppo sull’inerzia emotiva, trascurando questi importantissimi “salti” emotivi da diverse prospettive. Immaginate una discussione: all’inizio siete neutrali, poi il vostro interlocutore dice qualcosa che vi fa innervosire. Ecco un emotion-shift! Se il sistema non lo capisce, continuerà a pensare che siate neutrali. Un bel problema, no?

La Nostra Soluzione: Vi Presento GAT-CRESA!

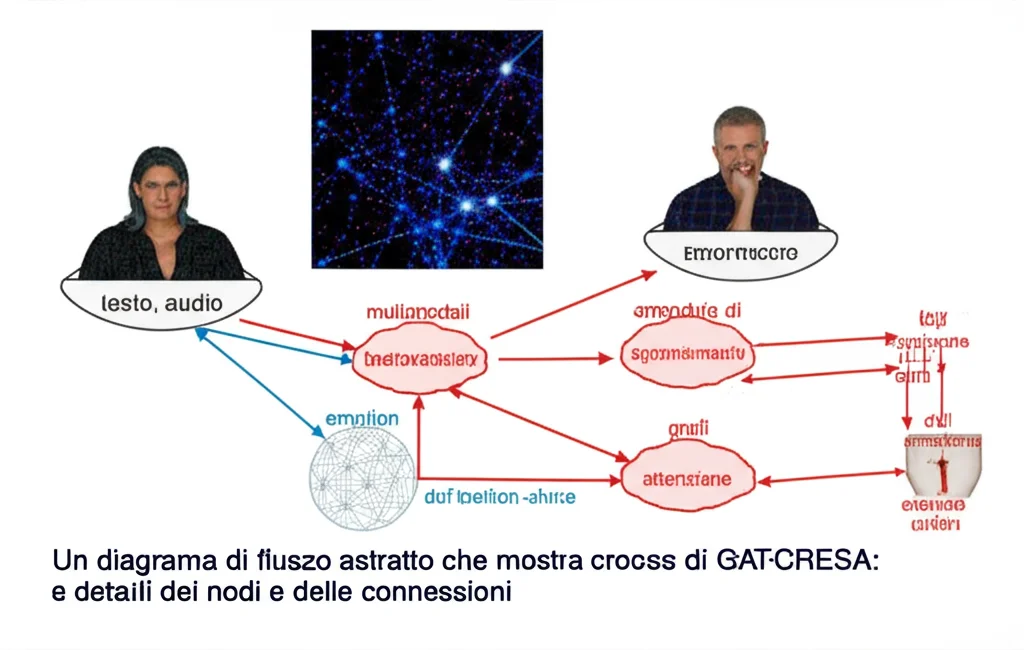

Ed è qui che entriamo in gioco noi, con un approccio che abbiamo chiamato GAT-CRESA (che sta per Graph ATtention based on Contextual Reasoning and Emotion-Shift Awareness). Un nome un po’ tecnico, lo so, ma lasciate che vi spieghi in parole povere cosa fa di così speciale.

Fondamentalmente, GAT-CRESA è un sistema multimodale (per ora usa testo e audio) che affronta le limitazioni di cui parlavo prima. Come?

- Ragionamento Contestuale Globale Multi-Turno: Abbiamo progettato un modulo che, un po’ come fa il nostro cervello, esegue cicli iterativi di percezione contestuale e ragionamento cognitivo. Questo ci permette di capire mooolto meglio il contesto globale della conversazione, andando a pescare indizi da una “memoria” statica e integrandoli in modo logico. Non ci limitiamo a guardare le frasi in sequenza, ma cerchiamo le connessioni profonde.

- Apprendimento dell’Emotion-Shift Multi-Prospettiva: Qui sta una delle chicche! GAT-CRESA impara a riconoscere i cambi di emozione non da una sola, ma da due prospettive: quella dipendente dal parlante (come le emozioni di un singolo individuo cambiano) e quella basata sul contesto globale (come l’intera conversazione influenza i cambi emotivi). Questo ci dà una visione molto più completa.

- Grafi di Attenzione Consapevoli dell’Emotion-Shift: Una volta che abbiamo “etichettato” questi cambi di emozione, costruiamo dei grafi (immaginate delle reti di frasi interconnesse). La cosa furba è che le connessioni (gli “archi” del grafo) tra le frasi sono determinate proprio da queste etichette di emotion-shift. Questo aiuta il sistema a concentrarsi sul contesto locale più significativo, specialmente quando avviene un cambio emotivo. Usiamo una versione ottimizzata delle reti attentive su grafo (GATv2) per pesare queste connessioni.

Infine, mettiamo insieme gli output di questi grafi per il riconoscimento finale dell’emozione. E non è finita: durante l’allenamento del modello, combiniamo la “perdita” (un modo per misurare l’errore) del compito di predizione dell’emozione con quelle dell’apprendimento dell’emotion-shift dalle due prospettive. Un allenamento a tutto tondo!

Ma Funziona Davvero? I Numeri Parlano Chiaro!

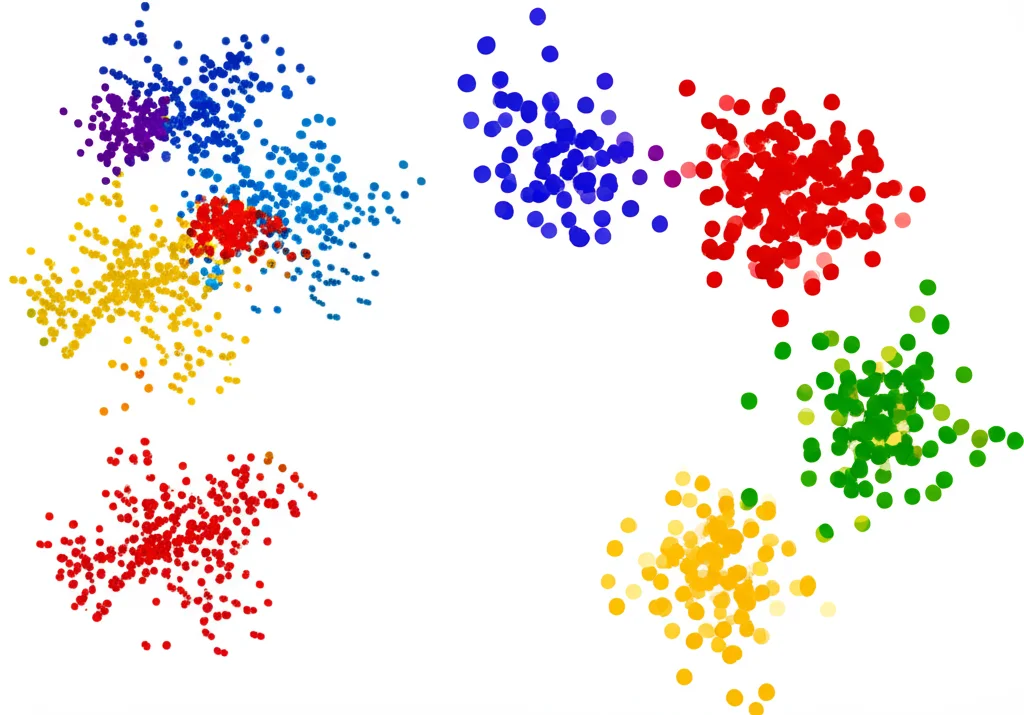

Ebbene sì, ragazzi, funziona alla grande! Abbiamo testato GAT-CRESA su due dataset di riferimento molto usati nella comunità scientifica: IEMOCAP (conversazioni diadiche, cioè tra due persone) e MELD (conversazioni multi-party, prese dalla serie TV Friends, quindi più complesse).

I risultati? GAT-CRESA ha stabilito nuovi record di stato dell’arte! Su IEMOCAP abbiamo raggiunto un’accuratezza (ACC) del 72.77% e un wa-F1 (una metrica che bilancia precisione e richiamo) del 72.81%. Su MELD, i numeri sono 65.44% di ACC e 65.04% di wa-F1. Questi potrebbero sembrarvi solo numeri, ma nel nostro campo sono miglioramenti significativi rispetto ai modelli precedenti, sia quelli basati su sequenze che quelli basati su grafi, e persino quelli che già tentavano di considerare l’emotion-shift.

Abbiamo anche fatto un sacco di “ablation studies”, cioè esperimenti in cui toglievamo un pezzetto del nostro sistema alla volta per vedere cosa succedeva. E indovinate? Ogni componente di GAT-CRESA ha dimostrato di essere importante e di contribuire al risultato finale. Per esempio, senza il modulo di ragionamento contestuale globale, le performance calano parecchio. Lo stesso vale per l’apprendimento dell’emotion-shift da entrambe le prospettive: è cruciale! Anche il modo in cui costruiamo i grafi, tenendo conto dei cambi emotivi, fa una bella differenza.

Perché GAT-CRESA è Diverso?

Vi chiederete, cosa rende GAT-CRESA superiore?

- Comprensione del contesto globale: Il nostro modulo MGCR scava più a fondo rispetto ai metodi sequenziali che pescano da una memoria statica.

- Focus sull’emotion-shift: A differenza di molti modelli che si concentrano sull’inerzia, noi diamo peso ai cambiamenti, e lo facciamo da più angolazioni (parlante e contesto). Questo è fondamentale quando le emozioni prendono una piega inaspettata.

- Grafi “intelligenti”: I nostri grafi non hanno solo connessioni “intra-parlante” o “inter-parlante”. Le relazioni tra i nodi (le frasi) sono arricchite dall’informazione sull’emotion-shift, permettendo una propagazione dell’informazione più mirata.

Pensate a una scena di IEMOCAP: una donna inizia neutra, poi l’uomo dice qualcosa e lei diventa frustrata. Molti modelli, basandosi sull’inerzia, potrebbero sbagliare. GAT-CRESA, grazie alla sua “consapevolezza” del cambio emotivo, ha più chance di azzeccarci.

Uno Sguardo al Futuro (e Qualche Piccola Sfida)

Certo, non è tutto oro quello che luccica e ci sono ancora sfide da affrontare. Una è la gestione di dataset con forte squilibrio tra le classi emotive. Su MELD, per esempio, ci sono tantissime frasi neutre e pochissime etichettate come “paura” o “disgusto”. In questi casi, GAT-CRESA (come molti altri modelli) fa un po’ più fatica e tende a confondere le emozioni minoritarie con quelle maggioritarie.

Un’altra sfida è distinguere emozioni simili, tipo “arrabbiato” e “frustrato”, o “felice” ed “eccitato”. GAT-CRESA migliora anche qui rispetto ad altri, ma c’è ancora margine.

Cosa bolle in pentola per il futuro? Beh, per ora GAT-CRESA usa testo e audio. Ma il canale visivo (espressioni facciali, gesti) porta un sacco di informazioni emotive! Integrare efficacemente anche questa modalità, specialmente in contesti di conversazione complessi, è uno dei nostri prossimi obiettivi. Questo potrebbe aiutarci molto con le emozioni simili.

E poi ci sono i Large Language Models (LLM), i giganti del linguaggio che stanno spopolando. Stiamo esplorando come sfruttare le loro incredibili capacità di ragionamento testuale per migliorare ulteriormente il riconoscimento delle emozioni, specialmente su dataset sbilanciati.

Infine, il vero sogno è andare oltre il semplice riconoscimento: usare queste emozioni identificate per generare risposte empatiche, per migliorare davvero la qualità dell’interazione uomo-macchina. Immaginate un chatbot che non solo capisce che siete giù di morale, ma sa anche come tirarvi un po’ su!

Insomma, il viaggio è appena iniziato, ma con approcci come GAT-CRESA, stiamo facendo passi da gigante verso un’intelligenza artificiale più empatica e, diciamocelo, più umana. Spero di avervi trasmesso un po’ del mio entusiasmo per questo campo affascinante!

Fonte: Springer