Dati in Movimento? La Regressione Lineare Adattiva è la Tua Arma Segreta!

Ciao a tutti! Oggi voglio parlarvi di un argomento che mi sta particolarmente a cuore e che, credetemi, sta diventando sempre più cruciale nel mondo dei dati: la regressione nei data stream. Immaginate fiumi di informazioni che scorrono incessantemente, come notizie in tempo reale, dati finanziari, misurazioni da sensori IoT… un vero e proprio diluvio! In molti casi, non ci basta “classificare” questi dati, ma abbiamo bisogno di prevedere valori numerici: il prezzo di un’azione tra un minuto, il consumo energetico di domani, il numero di biciclette che verranno noleggiate nella prossima ora. Ecco, questa è la regressione.

Il bello (e la sfida!) dei data stream è che sono vivi, cambiano continuamente. Quello che era vero ieri potrebbe non esserlo più oggi. Questo fenomeno, che noi addetti ai lavori chiamiamo concept drift, è una bella gatta da pelare. Come facciamo a costruire modelli predittivi che siano non solo veloci e accurati, ma anche capaci di adattarsi a questi cambiamenti senza andare in tilt o richiedere risorse computazionali da capogiro?

Ma cos’è questo Filtraggio Lineare Adattivo?

Qui entra in gioco la mia proposta, o meglio, la riscoperta di un classico: il filtraggio lineare adattivo. Se avete una formazione in ingegneria dei segnali, probabilmente vi si è accesa una lampadina. Per gli altri, pensatela così: abbiamo un “filtro” che prende in ingresso i dati (le nostre variabili, o features) e cerca di produrre un’uscita che sia il più vicino possibile al valore reale che vogliamo prevedere. La parte “lineare” significa che il modello che costruiamo è, fondamentalmente, una combinazione lineare delle features – semplice ma incredibilmente potente. E “adattivo”? Beh, significa che questo filtro non è statico, ma aggiusta continuamente i suoi “pesi” (i coefficienti) man mano che arrivano nuovi dati. È come un musicista che accorda costantemente il suo strumento per suonare al meglio in un’orchestra che cambia continuamente musicisti e spartiti!

Il grande vantaggio? Possiamo ottenere modelli generali molto accurati senza dover ricorrere a sistemi complessi come gli ensemble learners (che sono come mettere insieme tante piccole orchestre, ognuna con il suo direttore). E soprattutto, l’adattamento ai cambiamenti (il famoso drift) avviene in modo implicito, continuo, senza bisogno di “rilevatori di drift” esterni che dicano al modello: “Ehi, qualcosa è cambiato, resettati!”. Il nostro filtro lo “sente” e si adegua.

I Nostri Algoritmi di Punta: RLS e LMS

Nel nostro lavoro, ci siamo concentrati sulle versioni ricorsive di questi metodi, perché sono quelle che si sposano perfettamente con la natura “uno alla volta” dei data stream. Due sono i protagonisti principali:

- Recursive Least Squares (RLS): Questo algoritmo è un vero campione. Cerca di minimizzare la somma dei quadrati degli errori, dando più peso ai dati recenti grazie a un “fattore di dimenticanza” (forgetting factor, (lambda)). È molto bravo ad adattarsi rapidamente, ma può essere un po’ esigente in termini di calcoli. Pensatelo come un pilota di Formula 1: velocissimo, ma consuma parecchio!

- Least Mean Squares (LMS): Più leggero e snello del RLS. L’LMS aggiusta i coefficienti del filtro muovendosi nella direzione che minimizza l’errore quadratico istantaneo. È come un ciclista agile: meno potente del pilota di F1, ma molto più efficiente e meno costoso computazionalmente. Ha diverse varianti, come l’NLMS (Normalized LMS) che ne migliora la velocità di convergenza, o le versioni “sign” (Sign-Error, Sign-Data, Sign-Sign LMS) che semplificano ulteriormente i calcoli, a volte a scapito di un po’ di precisione.

La bellezza di questi approcci è che trasformano il problema della regressione in un problema di stima continua dei coefficienti di un filtro. Ogni nuovo dato che arriva ci aiuta a raffinare questa stima. Se i dati iniziano a cambiare “sotto i nostri piedi”, il filtro se ne accorge perché l’errore di previsione inizierà ad aumentare, e lui si riadatterà di conseguenza.

L’Innovazione: Aggiornamenti Intelligenti per Massima Efficienza

Ora, parlando di RLS, abbiamo detto che è potente ma costoso. E se potessimo renderlo più “furbo”? Ecco la nostra idea: perché aggiornare i coefficienti del filtro ad ogni singolo nuovo dato, se l’errore di previsione è già molto piccolo? Se il filtro sta già facendo un buon lavoro, forse non vale la pena spendere risorse per micro-aggiustamenti. Così, abbiamo proposto un RLS “parzialmente aggiornato”. In pratica, stabiliamo una soglia di errore ((zeta)):

- Se l’errore tra la previsione e il valore reale è inferiore a questa soglia, il filtro non viene aggiornato. Risparmiamo calcoli!

- Se l’errore è superiore, allora sì, procediamo con l’aggiornamento completo.

È un po’ come dire: “Non disturbare il manovratore se la nave è già sulla rotta giusta”. Questo approccio ci permette di mantenere la velocità di convergenza del RLS nei momenti critici (quando il drift è forte o il modello è ancora in fase di apprendimento), ma di ridurre drasticamente il carico computazionale quando il sistema è stabile o i cambiamenti sono minimi. Un bel compromesso tra accuratezza e velocità!

La Prova del Nove: I Risultati Sperimentali

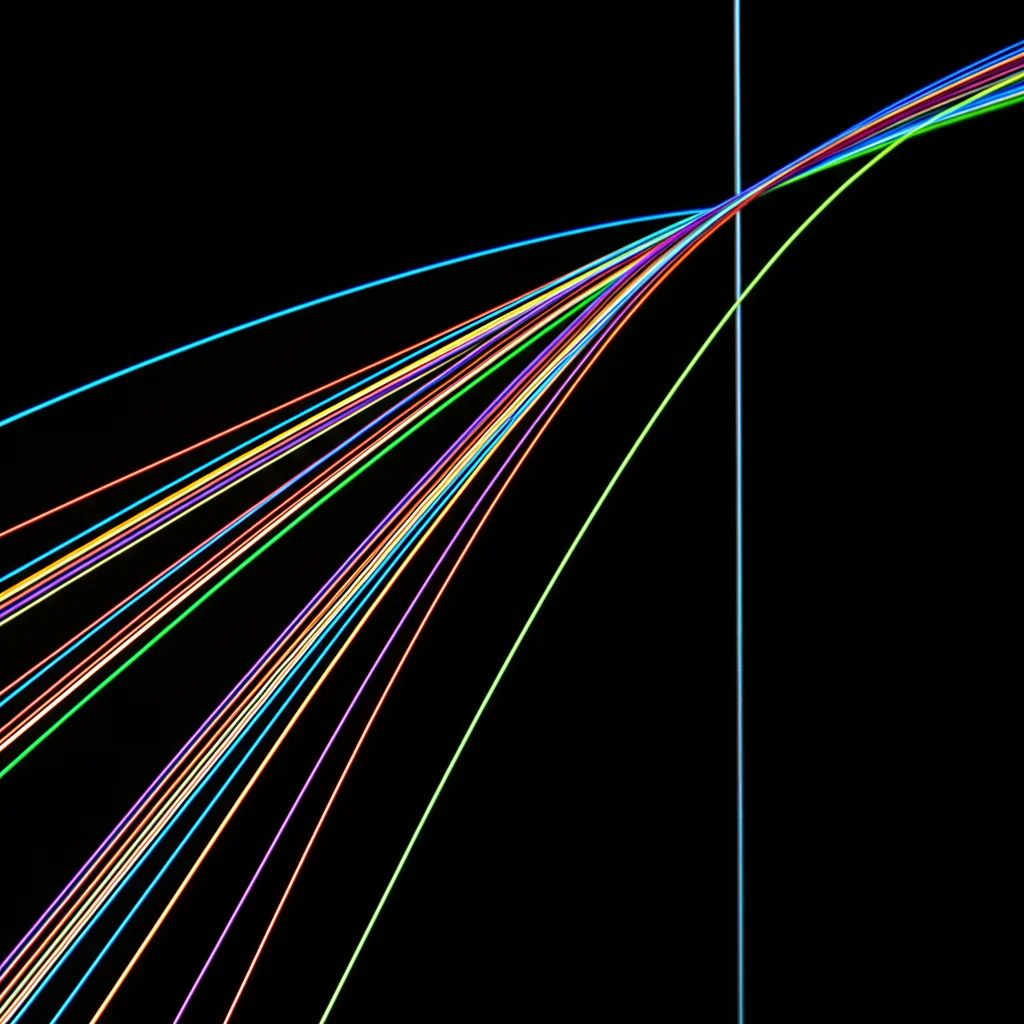

Naturalmente, non ci siamo fidati solo delle nostre intuizioni. Abbiamo messo alla prova i nostri algoritmi di filtraggio lineare adattivo (LMS base, LMS con bias, NLMS, le varianti Sign, RLS e il nostro RLS parzialmente aggiornato) su un bel po’ di dataset, sia sintetici (creati apposta per simulare diversi tipi di drift: improvviso, graduale, incrementale) sia reali (dal prevedere l’età degli abaloni al traffico nelle metropolitane o il noleggio di biciclette).

E li abbiamo confrontati con alcuni pezzi da novanta della regressione su data stream, come ARF-Reg (Adaptive Random Forest for Regression), AMRules (Adaptive Model Rules), FIMT-DD (Fast and Incremental Model Trees) e SOKNL (Self-Optimizing K-Nearest Leaves). Per misurare le performance, abbiamo usato principalmente il coefficiente di determinazione (R² aggiustato), che ci dice quanta varianza dei dati il nostro modello riesce a spiegare, tenendo conto anche della complessità del modello stesso.

I risultati? Beh, sono stati molto incoraggianti! In generale, i nostri algoritmi di filtraggio, specialmente l’RLS, si sono comportati egregiamente. Su diversi dataset, l’RLS ha ottenuto performance paragonabili o addirittura superiori ai metodi più complessi basati su alberi o ensemble, soprattutto in scenari con drift. Ad esempio, sui dataset sintetici Hyper(A) (drift improvviso) e Hyper(G) (drift graduale), l’RLS è stato il migliore. Anche l’LMS e le sue varianti hanno brillato su alcuni dataset specifici.

Una cosa che ci ha colpito è stata la velocità di adattamento. Quando si verificava un drift, i filtri lineari erano in grado di “recuperare” e riadattarsi molto più rapidamente rispetto, ad esempio, agli ensemble di alberi, che magari dovevano resettare intere porzioni del loro modello. Il filtro, invece, aggiorna continuamente i suoi coefficienti, quindi l’adattamento è intrinseco.

E i tempi di calcolo? Qui i filtri lineari hanno letteralmente sbaragliato la concorrenza! L’RLS, pur essendo il più “pesante” tra i nostri, è risultato essere da uno a due ordini di grandezza più veloce degli ensemble come ARF-Reg o SOKNL. Questo è un vantaggio enorme nelle applicazioni real-time. L’LMS e le sue varianti sono ancora più fulminei.

Il nostro RLS parzialmente aggiornato si è dimostrato una chicca: su molti dataset, siamo riusciti a ridurre significativamente il numero di aggiornamenti (e quindi il tempo di calcolo, a volte anche del 50-70%) senza perdere quasi nulla in termini di accuratezza (R²). Anzi, in alcuni casi, non aggiornare su errori piccoli ha persino evitato un “overfitting” sul rumore, mantenendo performance stabili. È la dimostrazione che a volte, fare meno è fare meglio!

Limiti e Orizzonti Futuri

Certo, nessun metodo è perfetto. Il limite principale del filtraggio lineare è, beh… la linearità! Se la relazione tra le features e l’output è fortemente non-lineare, un modello lineare farà fatica. L’abbiamo visto su dataset come House8L, dove i metodi basati su alberi hanno fatto meglio. In questi casi, l’assunzione lineare è troppo forte.

Ma non ci arrendiamo! Stiamo già esplorando come estendere questi modelli. Ad esempio, si possono includere dipendenze temporali (l’output di oggi dipende dagli input o output di ieri) o introdurre non-linearità controllate (come nelle strutture di Hammerstein, dove una funzione non-lineare viene applicata agli input prima del filtro lineare). L’obiettivo è sempre lo stesso: mantenere la velocità e l’adattabilità dei filtri, aggiungendo la flessibilità necessaria per affrontare problemi più complessi.

Perché il Filtraggio Lineare Adattivo è una Svolta

In conclusione, credo fermamente che il filtraggio lineare adattivo sia un approccio estremamente promettente e, sorprendentemente, ancora poco esplorato per la regressione nei data stream. Offre un mix fantastico di semplicità, efficienza computazionale, e una capacità innata di adattarsi ai cambiamenti. Richiede meno risorse, si adatta velocemente ai drift, e come abbiamo visto, può essere ulteriormente ottimizzato per ridurre i calcoli senza sacrificare troppo le performance.

È un po’ come riscoprire un attrezzo classico nella cassetta degli attrezzi del data scientist, lucidarlo e vedere che funziona ancora alla grande, a volte meglio di strumenti più moderni e complicati, specialmente quando il gioco si fa veloce e i dati non stanno mai fermi. E voi, siete pronti a dare una chance a questi “vecchi” ma potenti filtri?

Fonte: Springer