Robot, mi posso fidare di te? L’esperimento che svela i segreti della fiducia uomo-macchina

Ciao a tutti! Oggi voglio parlarvi di qualcosa che mi affascina tantissimo e che, ne sono sicuro, diventerà sempre più centrale nelle nostre vite: il rapporto con i robot. Non parlo dei robot industriali chiusi nelle fabbriche, ma di quelli che potremmo incontrare per strada, in un museo, o magari un giorno avere in casa come assistenti. La domanda sorge spontanea: possiamo fidarci di loro?

La fiducia è una cosa complessa, anche tra noi umani. Figuriamoci con una macchina! Eppure, man mano che deleghiamo compiti sempre più importanti all’Intelligenza Artificiale e ai robot, capire come nasce e si mantiene la fiducia diventa fondamentale. Non è solo una questione di “funziona bene”, ma entra in gioco qualcosa di più profondo, legato a come percepiamo le loro “intenzioni”.

Oltre l’Esecuzione: Competenza e Buona Volontà

Pensateci: quando ci fidiamo di qualcuno per fare qualcosa, non valutiamo solo se è capace (la competenza), ma anche se è disposto ad aiutarci davvero, tenendo conto dei nostri bisogni (la buona volontà o willingness). Ecco, sembra che questo valga anche per i robot! Non basta che eseguano un compito alla perfezione; vogliamo anche percepire che lo facciano “per noi”, in linea con i nostri obiettivi.

Questo diventa ancora più complicato con i robot moderni, quelli che chiamiamo “adattivi”. Non si limitano a eseguire ordini alla lettera. A volte, per aiutarci meglio, potrebbero fare qualcosa di leggermente diverso da quello che abbiamo chiesto. Magari adattano il compito per raggiungere lo stesso obiettivo in modo più efficiente, oppure vanno addirittura oltre, anticipando un nostro bisogno non espresso esplicitamente. Fantastico, no? Sì, ma anche potenzialmente problematico. Se il robot fa qualcosa di inaspettato, come facciamo a sapere se è un errore o un tentativo intelligente di aiutarci meglio? Qui entra in gioco l’opacità: spesso non capiamo il “perché” dietro le azioni di un robot, e questo può minare la nostra fiducia.

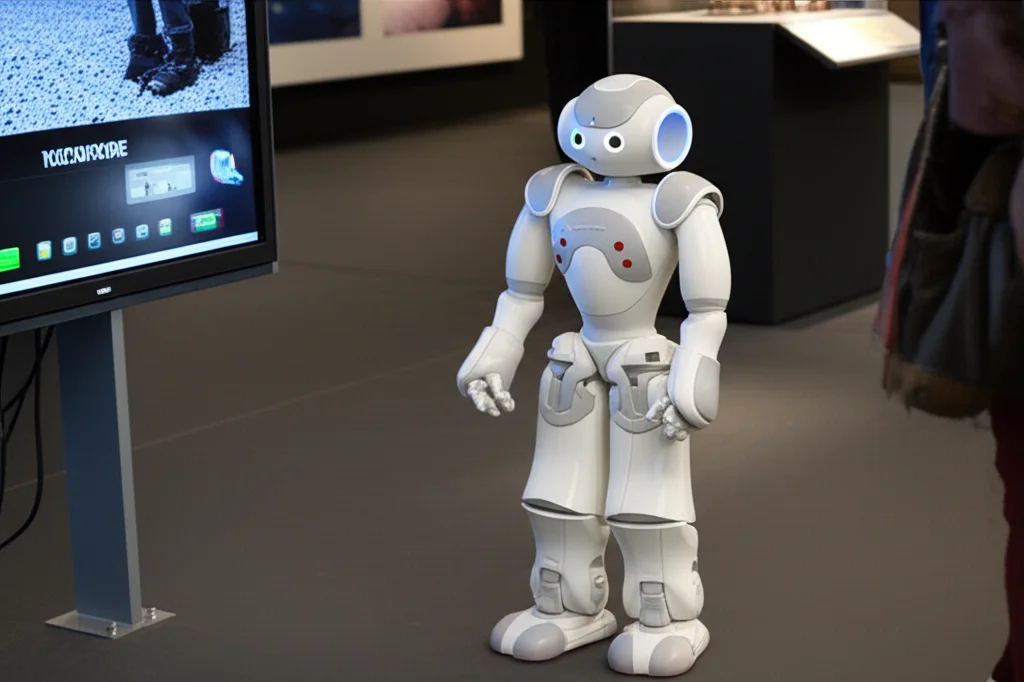

L’Esperimento nel Museo: Nao Guida Turistica

Per capirci qualcosa di più, abbiamo condotto un esperimento super interessante in un ambiente reale: il Palazzo delle Esposizioni a Roma. Immaginatevi lì, visitatori ignari, avvicinati da un piccolo robot umanoide di nome Nao, che si propone come guida per un tour virtuale di opere d’arte.

Abbiamo coinvolto 84 visitatori reali. A ciascuno veniva chiesto di indicare il proprio periodo artistico preferito. Poi Nao proponeva due tour virtuali (in ordine casuale):

- Uno “letterale”: basato esattamente sulle preferenze espresse.

- Uno “critico”: dove Nao, usando un po’ di “intelligenza sociale” (basata sulla Teoria della Mente, ovvero la capacità di attribuire stati mentali agli altri), adattava il tour considerando anche altri fattori, come la tolleranza del visitatore all’affollamento virtuale delle sale o suggerendo opere rilevanti magari non richieste esplicitamente.

In pratica, nel secondo caso, Nao si prendeva delle libertà, deviando dalle istruzioni esplicite, ma sempre (nelle sue intenzioni) per offrire un’esperienza migliore.

Il Potere della Spiegazione: “Ti spiego perché l’ho fatto”

Dopo i tour, abbiamo chiesto ai visitatori le loro impressioni. Ma il punto cruciale arrivava alla fine: Nao spiegava il ragionamento dietro le sue scelte, soprattutto quando aveva proposto il tour “critico”. E qui casca l’asino, o meglio, si accende la lampadina! La capacità del robot di spiegare le sue azioni si è rivelata fondamentale.

Perché? Perché la spiegazione getta luce su quel comportamento magari inaspettato. Ci permette di capire se la deviazione era un errore o, appunto, un tentativo “volenteroso” di fare meglio. Nel nostro esperimento, Nao generava le spiegazioni basandosi sugli stati mentali che aveva attribuito al visitatore durante la profilazione iniziale (preferenze, tolleranze, ecc.). In pratica, diceva: “Ho fatto così perché ho pensato che tu [credenza sul visitatore] e volevo ottenere [obiettivo per il visitatore]”.

Cosa Abbiamo Scoperto? I Risultati Chiave

E qui arrivano i risultati succosi, che confermano alcune idee ma ne chiariscono altre in modo nuovo, soprattutto per i robot adattivi:

1. La Competenza Paga (Quasi) Sempre: Se il robot viene percepito come competente nel portare a termine il compito (anche se in modo leggermente diverso dall’atteso), tendiamo a ritenerlo affidabile (trustworthy). Questo sembra valere anche senza una spiegazione dettagliata. Insomma, se il risultato è buono, la fiducia aumenta. (Ipotesi H1 confermata)

2. La Buona Volontà Ha Bisogno di Spiegazioni: Qui le cose cambiano. Per percepire il robot come ben disposto (willing) e quindi affidabile, soprattutto quando si comporta in modo inaspettato, la spiegazione diventa cruciale. È la spiegazione che ci permette di interpretare correttamente le “intenzioni” del robot e capire che agiva per il nostro bene. La relazione tra buona volontà percepita e fiducia è completamente mediata dalla qualità della spiegazione. (Ipotesi H2 confermata)

3. Se Capisco e Accetto, Valuto Bene: Sembra ovvio, ma è importante confermarlo. Se la spiegazione fornita dal robot è comprensibile (interpretabile) e la logica dietro la sua decisione ci sembra accettabile, allora valutiamo positivamente la spiegazione stessa. E, come abbiamo visto, una buona spiegazione rafforza la fiducia, soprattutto legata alla volontà. Questo suggerisce che spiegazioni basate sulla “Teoria della Mente” (cioè che fanno riferimento agli stati mentali dell’utente) funzionano bene! (Ipotesi H3 confermata)

Quindi, di chi ci possiamo fidare?

Questo esperimento ci dice cose importanti. Per costruire robot di cui possiamo fidarci, non basta renderli bravi a fare cose (competenti). Devono anche essere percepiti come collaborativi e ben intenzionati (volenterosi). E quando questi robot diventano adattivi e iniziano a prendere iniziative, la capacità di spiegare il perché delle loro azioni diventa un ingrediente essenziale per mantenere quella fiducia.

La spiegazione non è solo un “nice to have”, ma un meccanismo fondamentale per rendere trasparente il ragionamento del robot, soprattutto quando le sue azioni potrebbero sorprenderci. Spiegazioni che fanno leva sulla comprensione dei nostri bisogni e obiettivi (grazie alla Teoria della Mente simulata) sembrano essere particolarmente efficaci.

Certo, siamo solo all’inizio. Bisognerà estendere queste ricerche ad altri contesti (sanità, educazione, assistenza clienti) e magari esplorare come tecnologie tipo i Large Language Models (LLM) possano rendere queste interazioni e spiegazioni ancora più naturali e flessibili.

Ma una cosa è chiara: il futuro della collaborazione uomo-robot passa inevitabilmente dalla costruzione di una solida base di fiducia. E per farlo, dobbiamo progettare robot che non siano solo intelligenti e capaci, ma anche trasparenti e, in un certo senso, “comprensibili” nelle loro intenzioni. Una sfida affascinante, non trovate?

Fonte: Springer