Svelare i Legami Nascosti nel Testo: La Mia Avventura con Dipendenze a Distanza e Rumore

Ciao a tutti! Oggi voglio portarvi con me in un viaggio affascinante nel mondo dell’estrazione di relazioni tra entità nei testi. Sembra una cosa da cervelloni, vero? In parte lo è, ma pensate a quanto sia fondamentale per compiti come l’elaborazione del testo o la costruzione di quei giganteschi archivi di conoscenza chiamati knowledge graph. Immaginate di poter insegnare a una macchina a capire non solo le parole, ma come queste si legano tra loro per formare significati complessi. È un po’ come fare il detective linguistico!

La Sfida: Quando le Parole Giocano a Nascondino

Il problema è che gli algoritmi attuali, anche i più furbi, a volte fanno cilecca. Soprattutto quando le entità che vogliamo collegare sono separate da un sacco di altre parole (le cosiddette dipendenze a lunga distanza) o quando il testo è “sporco”, pieno di interferenze e rumore. È come cercare di sentire una conversazione importante in una stanza affollata e rumorosa, dove i due interlocutori sono ai lati opposti della stanza. Frustrante, no?

Molti approcci si basano sulla sequenza delle parole, usando modelli potenti come CNN, LSTM o i famosissimi BERT e GPT. Questi sono bravi a catturare le relazioni fino a un certo punto, ma quando la frase si allunga, si perdono i pezzi per strada. Altri metodi sfruttano gli alberi di dipendenza, che sono come mappe della struttura grammaticale della frase. Questi aiutano a vedere connessioni dirette anche tra parole lontane, ma c’è un tranello: questi alberi sono generati da strumenti esterni (parser) che non sono perfetti e possono introdurre rumore, informazioni sbagliate che confondono il nostro modello. E più le entità sono distanti, più questo rumore diventa un problema.

La Mia Proposta: Unire Semantica e Sintassi con un Pizzico di Magia

Di fronte a queste sfide, mi sono chiesto: come possiamo fare meglio? E così è nata l’idea di un nuovo metodo che, modestia a parte, credo sia piuttosto ingegnoso. Ho pensato di combinare il meglio di due mondi: le caratteristiche semantiche (il significato profondo) estratte dal potentissimo BERT e le caratteristiche sintattiche (la struttura grammaticale) derivate dai grafi di dipendenza. L’obiettivo? Affrontare di petto sia le dipendenze a lunga distanza che il fastidioso rumore.

Gli Ingredienti Segreti del Mio Metodo

Per rendere il tutto più robusto, ho introdotto un paio di assi nella manica:

- Self-Attention-based Graph Convolutional Network (SA-GCN): Sembra un nome da film di fantascienza, ma in pratica è un modo intelligente per “pesare” l’importanza dei nodi vicini nel grafo sintattico. Immaginate un filtro che elimina i nodi irrilevanti e permette al modello di concentrarsi sulle connessioni che contano davvero, anche quelle più lunghe e nascoste in mezzo al rumore.

- Residual Shrinking Network: Questo è il mio “spazzino” personale per i grafi sintattici. Lavora per rimuovere dinamicamente il rumore dal grafo, preservando le informazioni cruciali e rendendo il modello più resistente alle interferenze.

- Calcolo della Loss con Interpolazione Predittiva: Per far dialogare al meglio le informazioni semantiche e sintattiche, ho ideato un metodo di calcolo della “perdita” (loss) che bilancia dinamicamente il contributo di entrambe le fonti. È come un direttore d’orchestra che assicura che tutti gli strumenti suonino in armonia per un risultato finale impeccabile.

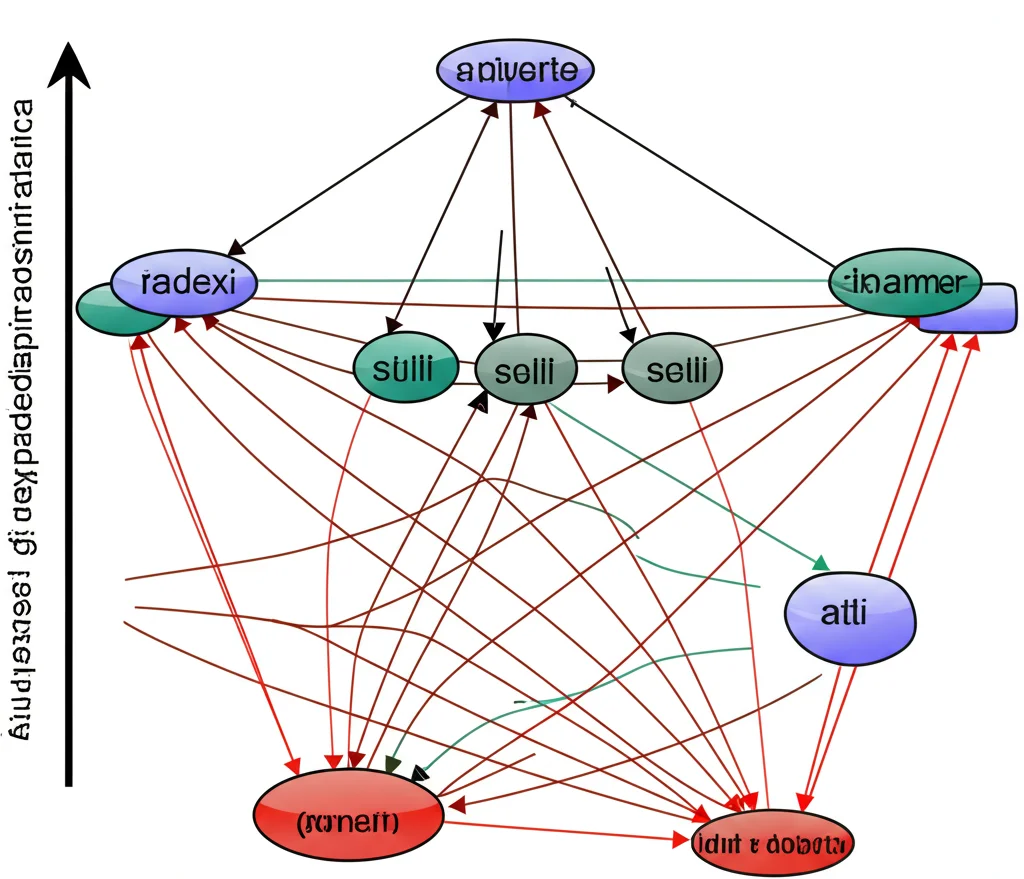

In pratica, il mio sistema prima codifica il testo con BERT, trasformandolo in vettori numerici. Parallelamente, costruisce un grafo di dipendenza sintattica. Poi, entra in gioco l’SA-GCN per modellare le dipendenze a lunga distanza e il residual shrinking network per ripulire il grafo dal rumore. Infine, le informazioni semantiche e sintattiche vengono fuse e passate a un classificatore per predire la relazione tra le entità. Semplice, no? Beh, forse non proprio semplicissimo da implementare, ma l’idea di fondo è quella!

Le principali contribuzioni del mio lavoro, quindi, si possono riassumere così: catturare le dipendenze a lunga distanza con l’SA-GCN, sopprimere il rumore con i grafi sintattici residui-dipendenti e ottimizzare l’estrazione di relazioni tramite l’interpolazione predittiva. Quest’ultima, in particolare, aiuta BERT e SA-GCN a interagire efficacemente durante l’addestramento, potenziando la capacità del modello di cogliere le sfumature delle relazioni a distanza.

Un Tuffo nei Dettagli Tecnici (ma non troppo!)

Senza annoiarvi con formule matematiche complesse, vi basti sapere che il processo inizia con la codifica del testo e l’estrazione dei vettori delle entità tramite BERT. Poi, costruiamo il grafo di dipendenza sintattica. Qui è cruciale gestire bene la tokenizzazione, per evitare che il parser esterno e BERT “vedano” le parole in modo diverso. Il grafo viene poi “ripulito” e analizzato dall’SA-GCN, che grazie a un meccanismo di auto-attenzione e a operazioni convoluzionali, identifica e scarta i nodi meno rilevanti (come virgole o punti che possono confondere le idee), migliorando la rappresentazione delle dipendenze, soprattutto quelle lunghe.

Il Residual Shrinkage (RS) network interviene ulteriormente: impara una soglia per “ammorbidire” i vettori dei nodi, eliminando dinamicamente le interferenze nel grafo sintattico. È come avere un equalizzatore intelligente che filtra le frequenze indesiderate. Alla fine, i vettori delle entità, arricchiti sia dalle informazioni di BERT che da quelle del grafo sintattico ripulito, vengono combinati e usati per classificare la relazione. Un dettaglio importante è che, per evitare che BERT e il GCN non “convergano” bene a causa delle loro diverse nature (uno globale, l’altro locale; uno ad alta dimensionalità, l’altro a bassa), l’interpolazione predittiva nella funzione di loss aiuta a sincronizzare i loro aggiornamenti. Inoltre, per gestire lo squilibrio delle classi (spesso le relazioni tra entità sono rare), ho introdotto un meccanismo di mascheramento basato sui tipi di entità, che aiuta il modello a concentrarsi sulle relazioni plausibili.

Alla Prova dei Fatti: I Risultati Sperimentali

Ovviamente, le belle parole non bastano. Ho messo alla prova il mio metodo su due dataset pubblici molto usati in questo campo: Baidu DUIE 2.0 (in cinese, con oltre 30.000 campioni) e SemEval 2010 Task 8 (in inglese, con circa 8.000 campioni per il training). Ho confrontato le performance con modelli di riferimento come R-BERT, BERT-LSTM, BERT-GAT, GP-GNN e AGGCN. Ebbene, i risultati sono stati più che incoraggianti! Il mio modello ha superato la maggior parte dei modelli esistenti, ottenendo un F1 score del 93.28% su DUIE 2.0 e dell’88.41% su SemEval 2010 Task 8. Questo dimostra che l’approccio funziona davvero!

Un aspetto interessante è emerso analizzando le performance al variare della lunghezza delle frasi. Per frasi corte, la differenza con un BERT “semplice” (senza la parte sui grafi) era minima. Ma all’aumentare della lunghezza, specialmente per frasi con 100-256 token, il mio modello ha mostrato miglioramenti significativi (ad esempio, +1.34% in F1 sul dataset DUIE). Questo conferma che l’integrazione dei grafi di dipendenza sintattica aiuta tantissimo a gestire le relazioni a lunga distanza.

Ho anche condotto esperimenti di “ablazione”, cioè ho provato a togliere i vari componenti del mio sistema (come l’SA-GCN o il Residual Shrinkage network) per vedere quanto contribuissero al risultato finale. I risultati hanno confermato che ogni pezzo del puzzle è importante. Ad esempio, sul dataset DUIE, aggiungere solo l’albero di dipendenza sintattica senza i meccanismi di riduzione del rumore ha addirittura peggiorato leggermente le performance, a causa del rumore introdotto dal parser. Ma una volta attivati i miei “filtri” (SA-GCN e RS), le performance sono schizzate in alto! Questo dimostra quanto sia cruciale non solo usare informazioni sintattiche, ma anche saperle “pulire” a dovere.

Infine, ho verificato l’impatto della mia funzione di loss basata sull’interpolazione predittiva rispetto a una cross-entropy loss standard. I grafici di training hanno mostrato che la mia soluzione converge più velocemente e raggiunge valori di loss inferiori, migliorando le metriche finali. Questo perché facilita l’interazione tra BERT e GCN, ottimizzando l’apprendimento delle feature e stabilizzando gli aggiornamenti dei parametri.

Cosa ci Riserva il Futuro?

In conclusione, questo lavoro propone un modello di estrazione di relazioni che, combinando la potenza di BERT con parser sintattici esterni e reti neurali su grafo, riesce a fondere informazioni semantiche e sintattiche in modo efficace. L’uso di SA-GCN e del residual shrinking network si è rivelato vincente per mitigare l’impatto del rumore e delle dipendenze a lunga distanza. I risultati sperimentali sono lì a dimostrarlo!

Credo che questo studio apra la strada a ulteriori ricerche sull’integrazione di BERT con le reti neurali su grafo e sulla fusione di informazioni semantiche e sintattiche. C’è ancora tanto da esplorare, ma ogni passo avanti ci avvicina a macchine che comprendono il linguaggio in modo sempre più profondo e umano. E per me, questa è la parte più entusiasmante!

Fonte: Springer