Occhi di Falco Digitali: Come Rendiamo i Droni Più Precisi e Comprensibili con Ensemble Learning e XAI

Ciao a tutti! Oggi voglio portarvi con me in un’avventura affascinante nel mondo dell’intelligenza artificiale applicata ai droni. Avete mai pensato a quanto sia incredibile (e complicato!) per un computer “vedere” e capire cosa c’è in un’immagine scattata dall’alto, magari da un drone in volo? Questa capacità si chiama Object Detection (OD), ovvero Rilevamento Oggetti, ed è fondamentale in un sacco di campi: dalla sorveglianza all’agricoltura di precisione, dall’ispezione di infrastrutture alle operazioni di ricerca e soccorso.

Negli ultimi anni, grazie al deep learning e alle reti neurali convoluzionali (CNN), abbiamo fatto passi da gigante. Modelli come YOLO e SSD, o quelli basati su proposte di regione come Faster R-CNN, sono diventati potentissimi. Ma c’è un “ma”, anzi, ce ne sono parecchi quando si parla di immagini da drone.

Le Sfide del Volo: Perché Vedere da un Drone è Difficile

Immaginate la scena: il drone vola ad alta quota, l’angolazione della telecamera cambia continuamente, gli oggetti a terra appaiono piccolissimi, magari si sovrappongono o sono parzialmente nascosti (occlusi). Aggiungeteci il possibile mosso dovuto al movimento, la scarsità di dati etichettati specifici per i droni, la necessità di elaborare tutto in tempo reale con risorse limitate a bordo… insomma, un bel rompicapo! Anche un piccolo spostamento di pixel può mandare in tilt il rilevamento, confondendo sfondo e primo piano. Rilevare oggetti piccoli, poi, è una vera impresa che spesso costringe a scegliere tra precisione e velocità.

Il Mistero della “Scatola Nera” e la Magia dell’XAI

C’è un altro aspetto cruciale. Questi modelli di deep learning, pur essendo potentissimi, sono spesso percepiti come delle “scatole nere”. Funzionano, ma capire *perché* prendono una certa decisione, perché identificano un oggetto proprio lì e in quel modo, è difficilissimo. Questo è un problema serio, specialmente in ambiti critici come la sicurezza, la guida autonoma o le operazioni di soccorso con droni, dove la fiducia nel sistema è fondamentale. Qui entra in gioco l’Explainable AI (XAI), l’Intelligenza Artificiale Spiegabile. L’XAI è quel campo di ricerca che cerca proprio di aprire queste scatole nere, di rendere i modelli più trasparenti e le loro decisioni comprensibili per noi umani. Pensateci: poter capire *come* ragiona l’AI ci permette di fidarci di più dei risultati, di identificare eventuali errori o bias, e di migliorare continuamente le prestazioni. È essenziale per validare le decisioni dell’AI, soprattutto quando collaboriamo con essa in compiti delicati.

La Nostra Ricetta: Ensemble Learning + XAI per Droni Super Intelligenti

Di fronte a queste sfide, nel nostro lavoro abbiamo cercato di colmare un vuoto: applicare l’XAI specificamente al rilevamento oggetti nelle immagini da drone, un’area ancora poco esplorata. E come l’abbiamo fatto? Combinando due ingredienti potenti:

- Ensemble Learning: L’unione fa la forza! Invece di affidarci a un solo modello, ne abbiamo usati diversi (in particolare varianti di YOLO, come YOLOv5 e YOLOv8) e abbiamo combinato le loro previsioni. È come chiedere il parere a più esperti: si riducono gli errori e si ottiene una visione più robusta e accurata. Abbiamo sperimentato diverse strategie per “mettere ai voti” le previsioni dei modelli, scoprendo che una strategia chiamata “affirmative voting” (voto affermativo) dava i risultati migliori.

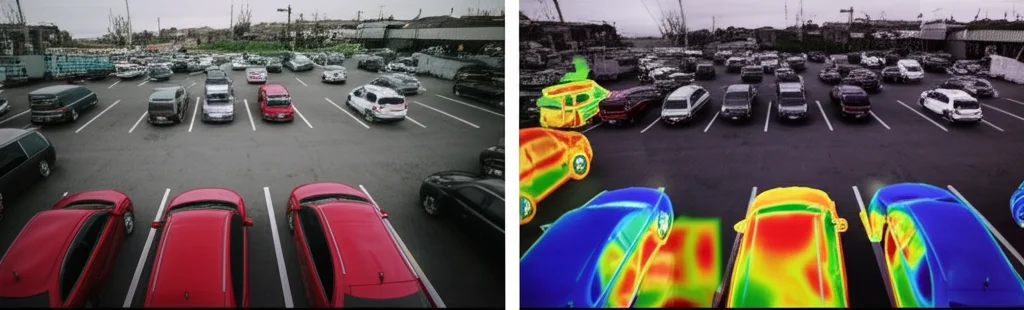

- Explainable AI (con EigenCAM): Per la parte “spiegabilità”, abbiamo scelto una tecnica chiamata EigenCAM. Senza entrare in dettagli troppo tecnici, EigenCAM ci permette di generare delle “mappe di calore” sull’immagine originale. Queste mappe evidenziano le zone che il modello ha ritenuto più importanti per identificare un certo oggetto. È un po’ come se l’AI ci dicesse: “Ho visto una macchina qui, e ho guardato soprattutto *questi* pixel per capirlo”. E il bello è che EigenCAM funziona senza dover modificare o riaddestrare il modello!

Mettiamo alla Prova le Idee: L’Esperimento con AU-AIR

Per testare il nostro approccio, abbiamo usato un dataset pubblico chiamato AU-AIR. È un dataset interessante perché è stato creato apposta per la sorveglianza aerea autonoma usando un drone DJI Phantom 4. Contiene video ripresi a diverse altezze e angolazioni, con annotazioni per 8 categorie di oggetti (persone, auto, furgoni, camion, moto, bici, bus, rimorchi) e include anche dati dai sensori di bordo del drone (GPS, altitudine, velocità, ecc.). Certo, abbiamo dovuto affrontare qualche sfida anche qui, come lo sbilanciamento tra le classi (molte auto, poche moto, per esempio) e qualche imprecisione nelle annotazioni, ma le abbiamo gestite con tecniche di data augmentation e un attento allineamento manuale.

I Risultati: Più Precisione e Finalmente Capiamo il Perché!

E i risultati? Beh, sono stati davvero incoraggianti!

Innanzitutto, abbiamo confrontato il nostro modello base (una versione custom di YOLOv5) con altri modelli usati in precedenza sullo stesso dataset (YOLOv3-Tiny, MobileNetV2-SSDLite). Il nostro modello si è comportato decisamente meglio su tutte le classi di oggetti.

Poi è arrivato il bello: l’ensemble learning. Combinando YOLOv5 e YOLOv8 con la strategia del voto affermativo, abbiamo ottenuto un aumento del 3% nella mAP (mean Average Precision, una metrica standard per valutare l’OD) rispetto al solo YOLOv5. Può sembrare poco, ma nel campo dell’object detection ogni punto percentuale guadagnato è importante, specialmente in condizioni difficili come quelle delle immagini da drone. L’ensemble ha ridotto i falsi positivi e le incertezze, rendendo le rilevazioni più robuste.

Ma la vera ciliegina sulla torta è stata l’aggiunta di EigenCAM. Le mappe di calore generate ci hanno mostrato chiaramente quali parti dell’immagine erano cruciali per il rilevamento. Vedere che le aree “calde” corrispondevano perfettamente agli oggetti rilevati e delimitati dai bounding box ci ha dato una grande conferma: il modello stava guardando le cose giuste! Questo non solo aumenta la nostra fiducia, ma rende l’intero processo trasparente e interpretabile.

Validazione Extra: Mettiamo alla Prova la Spiegazione

Non ci siamo fermati qui. Volevamo essere sicuri che le spiegazioni fornite da EigenCAM fossero affidabili. Come? Con una tecnica di perturbazione/ablazione. In pratica, abbiamo preso le immagini e abbiamo “cancellato” o “mascherato” le caratteristiche che EigenCAM aveva identificato come importanti. Poi abbiamo rieseguito il rilevamento. Il risultato? La precisione del modello crollava drasticamente, e le nuove mappe di calore mostravano che l’AI cercava indizi altrove, spesso in zone irrilevanti. Questo ci ha confermato che il modello faceva davvero affidamento su quelle caratteristiche specifiche per il rilevamento corretto. È stata la prova definitiva che il nostro sistema non solo era più preciso grazie all’ensemble, ma anche genuinamente spiegabile e affidabile grazie a EigenCAM e alla validazione.

A volte abbiamo notato che le mappe di calore si attivavano sui bordi dell’immagine o nel cielo, specialmente se un oggetto era nascosto. Questo può dipendere da vari fattori: artefatti ai bordi presenti nel dataset, il modello che cerca indizi contestuali quando l’oggetto principale manca, o effetti di contrasto. È un’ulteriore dimostrazione di quanto sia complesso il “ragionamento” visivo dell’AI!

Conclusioni e Prossimi Passi: Verso Droni Sempre Più Affidabili

Quindi, cosa abbiamo imparato da questa avventura? Che combinare l’ensemble learning per migliorare le prestazioni e l’XAI (con EigenCAM) per garantire trasparenza e interpretabilità è una strada vincente per il rilevamento oggetti nelle immagini da drone. Il nostro approccio integrato ha dimostrato di poter rendere i sistemi di OD più robusti, affidabili e spiegabili. Questo è fondamentale per poter impiegare queste tecnologie con fiducia in scenari reali, specialmente quelli critici.

Certo, il lavoro non finisce qui. Ci sono ancora margini di miglioramento. Pensiamo a come ridurre la complessità dei modelli per renderli ancora più veloci (architetture “lightweight”), a come includere ancora più modelli nell’ensemble, o a sperimentare altre tecniche XAI per ottenere spiegazioni ancora più ricche e consistenti. L’obiettivo è rendere questi “occhi digitali” sempre più performanti, ma soprattutto sempre più trasparenti e degni della nostra fiducia.

Spero che questo viaggio nel mondo dell’AI per droni vi sia piaciuto! È un campo in continua evoluzione, pieno di sfide ma anche di enormi potenzialità.

Fonte: Springer