EE-YOLOv8: La Rivoluzione nella Stima della Posa Umana è Qui!

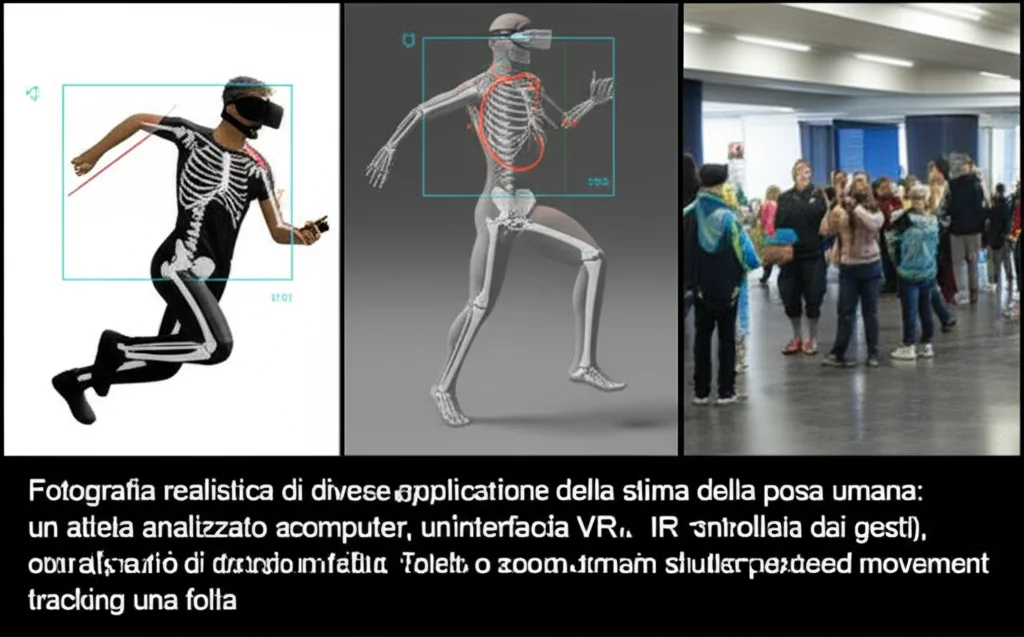

Ciao a tutti! Oggi voglio parlarvi di qualcosa che mi appassiona tantissimo nel mondo della computer vision: la stima della posa umana (o Human Pose Estimation – HPE, se vogliamo fare i fighi). In pratica, si tratta di insegnare ai computer a capire come siamo messi, identificando le posizioni delle nostre articolazioni (punti chiave) da immagini o video. Pensate a quante cose pazzesche si possono fare!

Ma cos’è esattamente la Stima della Posa Umana?

Immaginate un modello scheletrico digitale sovrapposto al vostro corpo. L’HPE fa proprio questo: individua punti chiave come il naso, gli occhi, le spalle, i gomiti, i polsi, le anche, le ginocchia e le caviglie (di solito 17 punti in totale) e capisce come sono collegati tra loro. Sembra facile? Beh, non proprio! Le sfide sono tante: cambi di luce, persone parzialmente nascoste (occlusioni), pose strane e, soprattutto, la necessità di essere super precisi e veloci, magari in tempo reale.

Le applicazioni sono davvero sbalorditive e toccano tantissimi campi:

- Interazione Uomo-Macchina Intelligente: Pensate ai visori VR come il Meta Quest Pro che tracciano i vostri movimenti, o ai sistemi ADAS nelle auto che capiscono la postura del guidatore per migliorare la sicurezza. Si possono creare persino interfacce controllate con lo sguardo per persone con disabilità motorie!

- Sport e Salute: Analizzare la tecnica degli atleti con precisione millimetrica, valutare l’andatura nei pazienti con Parkinson, o sviluppare sistemi che rilevano le cadute degli anziani in casa.

- Sicurezza Intelligente: Riconoscere comportamenti anomali in luoghi pubblici (risse, intrusioni) analizzando i movimenti del corpo, o monitorare il flusso di persone negli aeroporti.

- Intrattenimento Digitale: I camerini virtuali che vi permettono di provare i vestiti online con un’accuratezza sorprendente? Merito anche dell’HPE!

- Sicurezza Industriale: Valutare i rischi ergonomici per i lavoratori analizzando la loro postura e ottimizzare le linee di produzione.

Il Problema: Persone Ammassate e Dettagli Nascosti

Negli ultimi anni, il deep learning ha dato una spinta incredibile all’HPE. Ci sono principalmente due approcci:

- Top-down: Prima trova la persona nell’immagine, poi cerca i punti chiave all’interno del suo “riquadro”. È molto preciso quando c’è una sola persona, ma va in crisi se ci sono tante persone vicine (potrebbe non vederne qualcuna o confondersi) e richiede molta potenza di calcolo.

- Bottom-up: Prima trova tutti i punti chiave nell’immagine (caviglie, polsi, nasi, ecc.), poi cerca di capire a quale persona appartengono e li collega. È più veloce e gestisce meglio le folle, ma è generalmente meno preciso, soprattutto con persone piccole o parzialmente nascoste.

Noi cercavamo un modo per avere la botte piena e la moglie ubriaca: alta precisione anche in scene affollate, senza però appesantire troppo i calcoli.

La Nostra Soluzione: EE-YOLOv8

Siamo partiti da una base solida: YOLOv8. YOLO è famoso per essere un framework di object detection super efficiente, veloce e relativamente facile da usare. Già esisteva una versione per la stima della posa (YOLOv8-Pose), ma sentivamo che si poteva fare di più, specialmente per migliorare la precisione senza sacrificare la velocità.

Così è nato EE-YOLOv8! “EE” sta per “Efficient Multi-scale Receptive Field” ed “Expanded Feature Pyramid Network”, che sono due dei nostri ingredienti segreti. Ma andiamo con ordine. Cosa abbiamo migliorato?

Ingrediente #1: EMRF – Vedere Meglio a Diverse Scale

Per capire bene una posa, devi poter vedere sia i dettagli (la posizione esatta di un polso) sia la visione d’insieme (la postura generale del corpo). Le persone e le loro parti del corpo appaiono a scale diverse nell’immagine a seconda della distanza, della posa, ecc. Il modulo C2f originale di YOLOv8 era buono, ma non eccellente nel gestire questa multi-scalarità in modo adattivo per i punti chiave.

Abbiamo quindi introdotto l’EMRF (Efficient Multi-scale Receptive Field) nel “backbone” della rete (la parte che estrae le caratteristiche iniziali dall’immagine). L’EMRF usa un meccanismo intelligente chiamato EMA (Efficient Multi-scale Attention) che permette alla rete di “prestare attenzione” alle caratteristiche rilevanti a diverse scale contemporaneamente, un po’ come se potesse mettere a fuoco contemporaneamente dettagli vicini e lontani. Questo migliora la capacità di rappresentare le feature e di generalizzare.

Ingrediente #2: EFPN – Un Flusso di Informazioni Potenziato

Dopo il backbone, c’è il “collo” (neck) della rete, dove le informazioni estratte a diversi livelli di profondità vengono combinate per fare previsioni migliori. YOLOv8 usa una struttura chiamata PAN (Path Aggregation Network). È buona, ma noi abbiamo pensato: “Possiamo fare di meglio!”.

Abbiamo progettato l’EFPN (Expanded Feature Pyramid Network). Immaginatela come un’autostrada dell’informazione con più corsie e più svincoli rispetto alla PAN. L’EFPN migliora lo scambio di informazioni tra i diversi livelli della rete (dal più superficiale, ricco di dettagli, al più profondo, ricco di semantica) e integra meglio i dati multi-scala. Abbiamo aggiunto più connessioni, includendo anche livelli con risoluzione più alta (come il P2) che PAN trascurava, permettendo di catturare dettagli ancora più fini, cruciali per localizzare con precisione i punti chiave.

Ingrediente #3: Wise-IoU – Giudicare l’Overlap con Saggezza

Quando la rete “disegna” un riquadro attorno a una persona (bounding box), dobbiamo dirle quanto è andata bene. Di solito si usa l’IoU (Intersection over Union) o sue varianti come CIoU. Ma queste metriche a volte hanno dei limiti, specialmente con dati “difficili” (oggetti occlusi, di diverse proporzioni, ecc.) e possono rallentare l’apprendimento o renderlo instabile.

Abbiamo sostituito la funzione di perdita standard con Wise-IoU (WIoU). WIoU è più furba: usa un meccanismo di “focalizzazione dinamica non monotona”. Detta semplice, significa che riesce a dare il giusto peso agli esempi durante l’addestramento, concentrandosi sugli esempi di qualità “normale” senza farsi troppo influenzare da quelli molto facili o estremamente difficili (outlier), che potrebbero portare la rete fuori strada. Questo non solo migliora la precisione finale, ma accelera anche la convergenza del modello (impara più in fretta!).

I Risultati: Precisione da Campioni con Meno Sforzo!

Abbiamo messo alla prova EE-YOLOv8 sul famoso dataset MS COCO 2017, un banco di prova standard per l’HPE. I risultati ci hanno entusiasmato!

- Rispetto a YOLOv8-Pose standard, il nostro EE-YOLOv8 ha ottenuto un AP50 dell’89.0% (un miglioramento del 3.3%) e un AP50-95 del 65.6% (un miglioramento del 5.8%). L’AP (Average Precision) è una metrica chiave per valutare l’accuratezza, e questi sono salti notevoli!

- La cosa incredibile? EE-YOLOv8 ha raggiunto questa precisione con il minor numero di parametri e la minore complessità computazionale tra tutti gli algoritmi che abbiamo confrontato, inclusi metodi molto noti come HigherHRNet, DEKR e varianti di YOLO. Praticamente, fa di più con meno!

- Abbiamo fatto anche esperimenti “smontando” EE-YOLOv8 (ablation studies) per vedere il contributo di ogni pezzo. Wise-IoU accelera l’allenamento, EMRF dà un piccolo boost alla precisione, ma è l’EFPN a fare davvero la differenza, migliorando significativamente le performance. Ovviamente, la combinazione di tutti e tre dà il risultato migliore.

- Abbiamo anche confrontato EFPN con altre architetture “neck” (PAN, BiFPN, GFPN) e ha vinto a mani basse. Lo stesso vale per Wise-IoU rispetto ad altre funzioni di perdita (CIoU, DIoU, SIoU).

- Visivamente, la differenza si nota soprattutto nelle scene con più persone: dove YOLOv8-Pose a volte perdeva dei punti chiave o li assegnava male, EE-YOLOv8 è molto più robusto e preciso.

Cosa Significa Tutto Questo? E Prossimi Passi

In sintesi, abbiamo creato un modello, EE-YOLOv8, che spinge più in là i limiti della stima della posa umana basata su YOLO. È più accurato, specialmente in scenari complessi con più persone, ed è incredibilmente efficiente in termini di risorse computazionali. Questo apre le porte a implementazioni più potenti su dispositivi con meno capacità di calcolo o per applicazioni che richiedono altissima velocità.

Certo, c’è sempre spazio per migliorare. Finora abbiamo testato a fondo su COCO 2017, ma sarebbe interessante vedere come si comporta su altri dataset. Inoltre, abbiamo notato che anche EE-YOLOv8 può avere qualche incertezza con pose veramente anomale o occlusioni molto severe. Saranno queste le sfide per il futuro!

Ma per ora, siamo davvero soddisfatti di aver sviluppato una soluzione che offre un eccellente equilibrio tra accuratezza ed efficienza. EE-YOLOv8 è la dimostrazione che si può innovare anche partendo da framework esistenti, combinando idee intelligenti per ottenere risultati superiori. Spero che questo piccolo viaggio nel mondo dell’HPE vi sia piaciuto!

Fonte: Springer