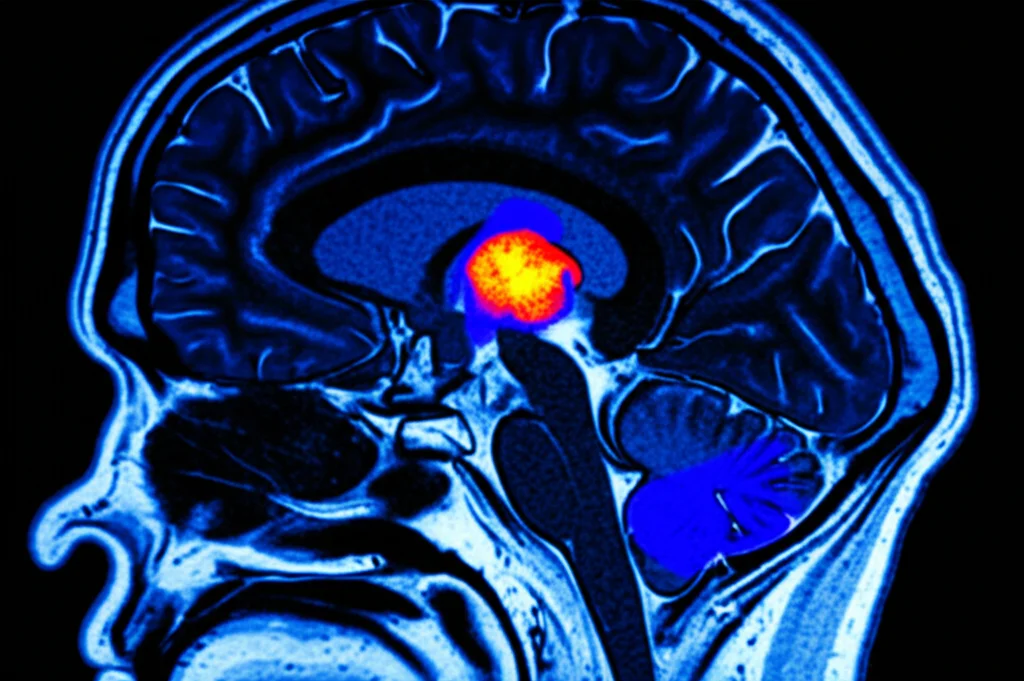

DSIT-UNet: L’IA che Vede i Tumori Cerebrali Come Mai Prima d’Ora

Ciao a tutti! Oggi voglio parlarvi di una cosa che mi appassiona tantissimo: come l’intelligenza artificiale sta rivoluzionando il campo medico, in particolare la diagnosi dei tumori cerebrali. Sembra fantascienza, vero? Eppure, stiamo facendo passi da gigante.

La segmentazione dei tumori cerebrali, cioè l’identificazione precisa dei loro confini nelle immagini mediche, è una bella gatta da pelare. Immaginatevi di dover disegnare il contorno esatto di una nuvola in continuo cambiamento: i tumori sono così, complessi, diversi l’uno dall’altro per forma, dimensione, posizione, e spesso si confondono con il tessuto sano circostante. Questo rende difficile per i medici pianificare terapie efficaci e riabilitazione.

La Risonanza Magnetica FLAIR: Un Aiuto Prezioso ma Non Perfetto

Per visualizzare questi “intrusi” nel cervello, la risonanza magnetica (MRI) è lo strumento d’elezione, specialmente una sequenza chiamata FLAIR (Fluid-Attenuated Inversion Recovery). Questa tecnica è fantastica perché “spegne” il segnale del liquido cerebrospinale, facendo risaltare meglio l’edema (il gonfiore) attorno al tumore. Tuttavia, anche con la FLAIR, distinguere precisamente il tumore, specialmente le parti non attive, dal tessuto sano rimane complicato.

L’Era del Deep Learning: U-Net e i Suoi Limiti

Negli ultimi anni, il deep learning (DL), e in particolare le reti neurali convoluzionali (CNN), hanno fatto faville nella segmentazione di immagini mediche. Un’architettura famosissima è la U-Net, che con la sua struttura encoder-decoder e le “scorciatoie” (skip connections) riesce a catturare dettagli fini. Però, c’è un “ma”: le CNN sono bravissime a guardare “localmente”, ma faticano a capire le relazioni a lunga distanza all’interno dell’immagine. È come guardare un puzzle pezzo per pezzo senza avere una visione d’insieme. E per i tumori cerebrali, capire il contesto globale è fondamentale.

Arrivano i Transformer: Visione Globale, Nuove Sfide

Per superare questo limite, sono entrati in gioco i modelli Transformer, presi in prestito dal mondo del linguaggio naturale. Grazie ai loro meccanismi di auto-attenzione (self-attention), i Transformer sono maestri nel catturare le dipendenze a lungo raggio e il contesto globale. Fantastico, no? Sì, ma anche loro hanno dei contro: richiedono montagne di dati per l’addestramento e non hanno quella “intuizione” spaziale innata delle CNN (località, invarianza alla traslazione) che è tanto utile nelle immagini mediche.

Si è provato a creare architetture ibride, mettendo insieme CNN e Transformer (come TransUNet o Swin-UNet), cercando di prendere il meglio dei due mondi. Hanno ottenuto buoni risultati, ma ancora non erano perfetti, specialmente nel gestire le diverse scale di dettaglio e nel delineare confini tumorali sfumati e complessi.

La Nostra Proposta: DSIT-UNet, l’Evoluzione

Ed è qui che entriamo in gioco noi! Sentivamo che si poteva fare di meglio. Così, abbiamo sviluppato DSIT-UNet (Dual-Stream Iterative Transformer-based U-Net), un’architettura pensata apposta per la segmentazione dei tumori cerebrali da immagini FLAIR. Cosa la rende speciale? Beh, abbiamo combinato un po’ di idee innovative.

Due Flussi Sono Meglio di Uno: L’Encoder Dual-Stream

Innanzitutto, abbiamo pensato: perché usare un solo modo per guardare l’immagine? Il nostro encoder ha due flussi paralleli (Dual-Stream). Uno usa filtri convoluzionali con kernel di dimensione pari, ottimo per catturare strutture continue e il contesto generale. L’altro usa kernel di dimensione dispari, più bravo a identificare i bordi, le transizioni e i dettagli fini. È come avere due paia di occhiali diversi, uno per la visione d’insieme e uno per i particolari. Questo ci aiuta a bilanciare l’omogeneità interna del tumore con la precisione dei suoi confini.

Attenzione Iterativa: Affinare la Visione Passo Dopo Passo

Poi, abbiamo introdotto i moduli Iterative Transformer (IT). Invece di applicare l’attenzione una volta sola, questi moduli la applicano più volte, in modo iterativo. Usiamo diversi tipi di attenzione incrociata (Spatial Cross-Attention, Channel Cross-Attention) e auto-attenzione (Multi-Head Self-Attention). È come se il modello riguardasse l’immagine più volte, affinando la sua comprensione ad ogni passaggio, concentrandosi sempre meglio sulle caratteristiche importanti. I nostri esperimenti (studi di ablazione, li chiamiamo) hanno mostrato che questo approccio iterativo migliora tantissimo i risultati!

TSHAO: L’Ingrediente Segreto per Bilanciare Dettaglio e Contesto

La ciliegina sulla torta è il nostro modulo TSHAO (Transformed Spatial-Hybrid Attention Optimization). Questo componente è fondamentale per fondere in modo intelligente le informazioni che arrivano dai diversi livelli e scale dell’architettura. Spesso, nei modelli basati su Transformer, si rischia di perdere i dettagli locali per catturare il contesto globale, o viceversa. TSHAO riesce a bilanciare queste due esigenze, preservando i dettagli fini dei bordi del tumore senza perdere la visione d’insieme. Questo si è rivelato cruciale per delineare con precisione i tumori, che sono notoriamente eterogenei.

Mettere alla Prova DSIT-UNet: I Risultati Parlano Chiaro

Ovviamente, non basta avere una bella idea, bisogna dimostrare che funziona! Abbiamo testato DSIT-UNet su tre dataset di riferimento molto usati nella comunità scientifica: TCIA (The Cancer Imaging Archive), BraTS2019 e BraTS2020. I risultati sono stati davvero entusiasmanti.

Su TCIA, abbiamo raggiunto un Mean Intersection over Union (mIoU) del 95.21% e un Dice Coefficient medio (mDice) del 96.23%. Su BraTS2020, i numeri sono stati simili, con un mIoU del 95.88% e un mDice del 96.32%. Questi punteggi superano significativamente quelli ottenuti da altri metodi all’avanguardia (SOTA – State-of-the-Art). Ad esempio, rispetto a modelli noti come DoubleU-Net, TransUNet e DS-Trans UNet, abbiamo visto miglioramenti nel mIoU che arrivano fino al 13-15%!

Un altro aspetto importante è l’efficienza. DSIT-UNet, pur essendo potente, richiede molti meno parametri (15.97 milioni) rispetto ad altri modelli basati su Transformer come TransUNet (che ne ha quasi 178 milioni!). Questo lo rende potenzialmente più facile da implementare in contesti clinici reali.

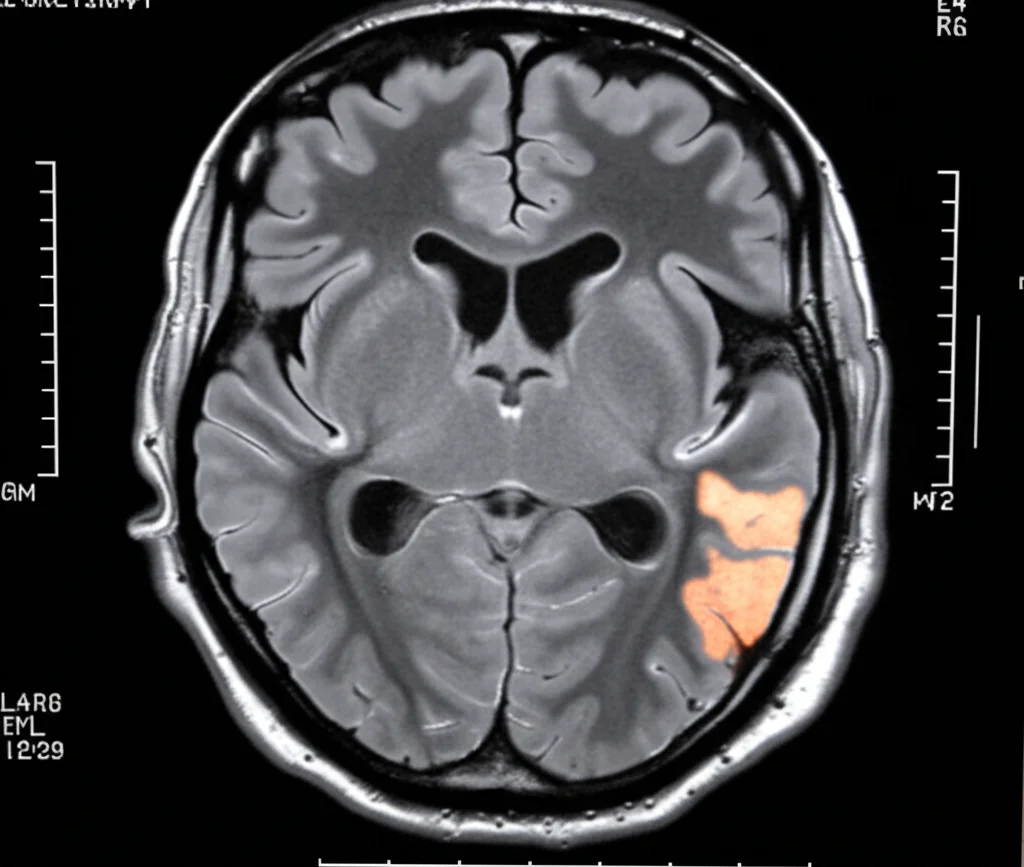

Non Solo Numeri: Vedere per Credere e Capire Come Funziona

I numeri sono importanti, ma a volte un’immagine vale più di mille parole. Abbiamo confrontato visivamente le segmentazioni prodotte dal nostro modello con quelle di altri metodi e con le “verità” annotate dagli esperti. I risultati qualitativi confermano che DSIT-UNet riesce a localizzare i tumori con grande accuratezza e a tracciarne i bordi in modo molto preciso, anche in casi difficili.

Ma volevamo anche capire *perché* funziona così bene. Abbiamo visualizzato le feature estratte dai due flussi dell’encoder (quelli con kernel pari e dispari) e abbiamo visto chiaramente come catturino aspetti complementari dell’immagine. Abbiamo anche osservato come le feature si affinano progressivamente nel decoder grazie all’attenzione iterativa e al modulo TSHAO.

Infine, per rendere il modello meno “scatola nera”, abbiamo usato le mappe di salienza (saliency maps). Queste mappe evidenziano le regioni dell’immagine che il modello considera più importanti per prendere la sua decisione. Abbiamo visto che DSIT-UNet si concentra proprio sui bordi del tumore e sulle sue caratteristiche interne, in modo simile a come farebbe un radiologo esperto. Questo aumenta la fiducia nel modello e la sua interpretabilità.

Limiti e Prossimi Passi: La Strada è Ancora Lunga (ma Promettente)

Siamo molto soddisfatti dei risultati, ma siamo anche consapevoli che c’è ancora lavoro da fare. Ecco alcune riflessioni:

- Generalizzabilità: DSIT-UNet è fantastico sui tumori cerebrali, ma funzionerà altrettanto bene su altri tipi di immagini mediche o altre patologie? Dobbiamo testarlo ulteriormente.

- Complessità Computazionale: Sebbene sia più efficiente di altri Transformer, è comunque più “pesante” delle classiche U-Net. Bisognerà lavorare su tecniche di compressione del modello per renderlo utilizzabile anche su hardware meno potente.

- Spiegabilità: Le mappe di salienza sono un buon inizio, ma potremmo esplorare metodi di Explainable AI (XAI) ancora più avanzati per capire a fondo le decisioni del modello.

- Robustezza: Come si comporta il modello con immagini di qualità diversa o provenienti da scanner differenti? Servono test più approfonditi in condizioni “real-world”.

Stiamo già pensando a come estendere questo lavoro, magari anche alla segmentazione 3D volumetrica, che sarebbe ancora più vicina alla pratica clinica.

Conclusione: Un Passo Avanti per la Diagnosi e la Cura

Insomma, DSIT-UNet rappresenta, secondo me, un passo avanti significativo nella segmentazione automatica dei tumori cerebrali. Combinando in modo intelligente diverse tecniche (dual-stream, kernel misti, attenzione iterativa, TSHAO), siamo riusciti a ottenere prestazioni SOTA con un modello relativamente efficiente e più interpretabile.

Credo fermamente che strumenti come questo possano diventare un aiuto prezioso per i radiologi, migliorando l’accuratezza diagnostica, velocizzando il lavoro e contribuendo a pianificare trattamenti e percorsi di riabilitazione più personalizzati ed efficaci. La strada verso l’implementazione clinica diffusa è ancora in corso, ma le potenzialità sono enormi e il futuro, da questo punto di vista, sembra davvero promettente!

Fonte: Springer