Droni e AI al Servizio della Colza: Vi Racconto Come Contiamo i Fiori dal Cielo con DM_CorrMatch!

Ciao a tutti gli appassionati di tecnologia e agricoltura! Oggi voglio portarvi con me in un viaggio affascinante tra campi dorati di colza, droni volanti e intelligenza artificiale. Parleremo di come stiamo cercando di rendere l’agricoltura più smart e produttiva, concentrandoci su una coltura fondamentale: la colza (Brassica napus L.). Sapete, l’olio di colza è super importante, specialmente qui in Cina dove la domanda è altissima e la produzione interna fatica a tenere il passo. Aumentare la resa per ettaro è la chiave, e per farlo dobbiamo capire meglio come crescono le piante, specialmente durante la fioritura.

La Sfida: Occhi Gialli Difficili da Contare

La fioritura della colza è un momento cruciale. Dura quasi un mese e segna il passaggio dalla crescita vegetativa a quella riproduttiva. Quanti fiori ci sono e per quanto tempo fioriscono sono fattori legati direttamente a quanto raccolto avremo. La copertura fiorale, cioè la percentuale di terreno coperta dai bei fiori gialli, è un indicatore fantastico dello stato di salute della coltura. Tradizionalmente, misurarla significava andare nei campi, osservare, contare… un lavoro lungo, faticoso e pure un po’ soggettivo.

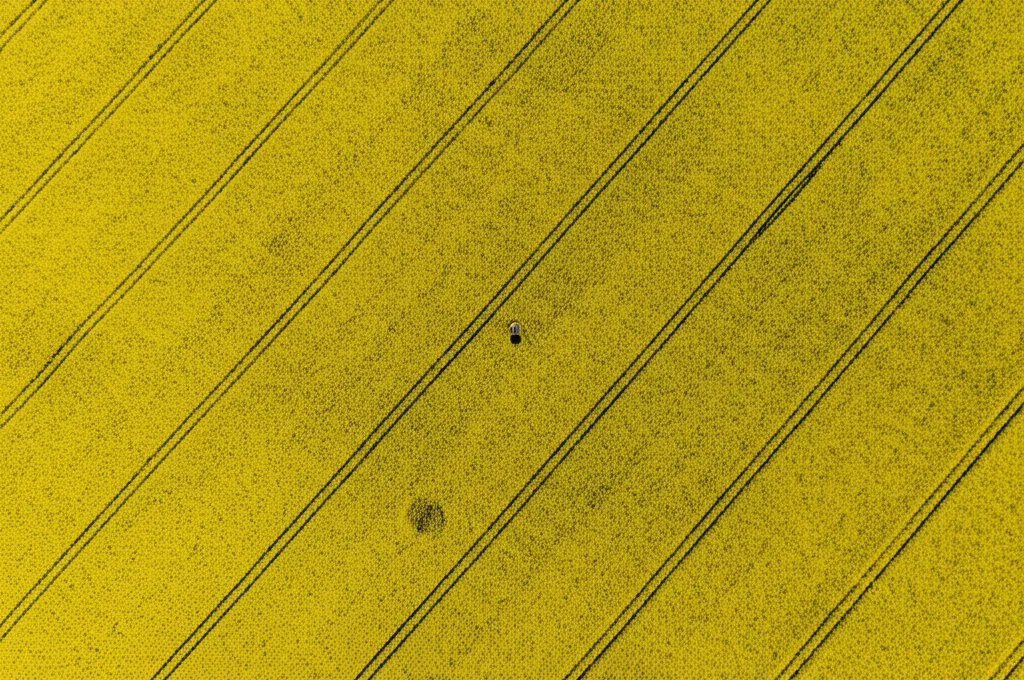

Per fortuna, oggi abbiamo i droni (UAV)! Possiamo farli volare sopra i campi e scattare foto ad alta risoluzione. Fantastico, no? Beh, quasi. Il problema è: come trasformiamo quelle foto in dati utili? Come contiamo *automaticamente* e *precisamente* quanti fiori ci sono? Qui entra in gioco la segmentazione semantica, una tecnica di intelligenza artificiale che insegna a un computer a riconoscere e “colorare” diverse parti di un’immagine. Nel nostro caso, vogliamo che colori solo i fiori di colza.

Sembra facile? Non proprio. I fiori di colza hanno forme irregolari, i bordi spesso non sono netti, si sovrappongono, cambiano colore e dimensione durante la fioritura e sono immersi in uno sfondo complesso fatto di foglie e, più tardi, di baccelli. Insomma, anche per un computer è un bel grattacapo distinguerli perfettamente. E c’è un altro ostacolo: i metodi di deep learning più potenti hanno bisogno di tantissimi dati “etichettati”, cioè immagini dove un umano ha pazientemente disegnato i contorni di ogni singolo fiore. Potete immaginare quanto tempo e denaro richieda!

La Nostra Arma Segreta: DM_CorrMatch

Ed è qui che entriamo in gioco noi con la nostra soluzione: DM_CorrMatch. È un framework di apprendimento semi-supervisionato. Cosa significa? In pratica, siamo furbi: usiamo poche immagini etichettate a mano (quelle costose) e un sacco di immagini non etichettate (che sono facili da ottenere con i droni). Il sistema impara dalle prime e poi sfrutta le seconde per migliorare continuamente, senza bisogno di supervisione umana costante. Un bel risparmio!

Ma come funziona nel dettaglio? Abbiamo messo insieme un po’ di idee innovative.

Innovazione 1: Più Dati, Meno Fatica (con un Pizzico di Magia AI)

Per prima cosa, abbiamo bisogno di dati, tanti dati diversi. Usiamo tecniche di data augmentation “forte” e “debole”: in pratica, modifichiamo le immagini esistenti (cambiando colori, ritagliandole, capovolgendole, ecc.) per creare tante variazioni e rendere il modello più robusto. Ma la vera chicca è l’uso del Denoising Diffusion Probabilistic Model (DDPM). È un modello generativo avanzato che, pensate un po’, può creare immagini sintetiche di fiori di colza quasi indistinguibili da quelle reali! Questo ci permette di aumentare enormemente il nostro set di dati, specialmente quelli non etichettati, senza dover passare ore a etichettare a mano. È come avere un assistente AI che disegna campi di colza per noi!

Innovazione 2: Un Cervello Potenziato (Mamba + CNN)

Poi, serve un “cervello” artificiale capace di vedere sia i dettagli minuti che il quadro generale. Le reti neurali convoluzionali (CNN) sono bravissime a riconoscere pattern locali (come la forma di un petalo), ma a volte perdono la visione d’insieme. I Transformer sono forti nel capire il contesto globale, ma spesso sono pesanti computazionalmente. Noi abbiamo creato un’architettura ibrida chiamata Mamba-Deeplabv3+. Combina la potenza delle CNN (nello specifico, una versione migliorata di DeepLabv3+) con Vision Mamba, una tecnologia più recente ispirata ai modelli State Space (SSM). Mamba è efficiente e bravo a catturare le dipendenze a lungo raggio, un po’ come capire la relazione tra fiori lontani tra loro nel campo. Integrando Mamba nei primi strati della rete, riusciamo a catturare dettagli finissimi e informazioni globali in modo bilanciato, senza appesantire troppo i calcoli. È come dare al nostro sistema degli occhiali super potenti che mettono a fuoco sia da vicino che da lontano contemporaneamente!

Innovazione 3: Imparare dagli Errori (e dai Successi)

Un problema dell’apprendimento semi-supervisionato è che il modello, generando “pseudo-etichette” per i dati non etichettati, potrebbe sbagliare e imparare cose errate. Per evitare questo, abbiamo introdotto una Strategia di Aggiornamento Automatico delle Etichette (AUL). In pratica, dopo un certo numero di cicli di addestramento, il modello valuta la sua “fiducia” nelle pseudo-etichette che ha generato. Solo quelle con un punteggio di fiducia alto (sopra una soglia che abbiamo ottimizzato) vengono aggiunte al set di dati etichettati originali. È un modo per “ripulire” gradualmente il set di allenamento, eliminando le etichette potenzialmente sbagliate (anche quelle fatte a mano all’inizio potrebbero non essere perfette!) e rafforzando l’apprendimento con le previsioni più sicure. Il sistema diventa più bravo e più affidabile col tempo.

Alla Prova dei Fatti: Il Dataset RFSD e i Risultati

Per testare DM_CorrMatch, abbiamo creato il Rapeseed Flower Segmentation Dataset (RFSD), raccogliendo 720 immagini ad alta definizione da droni sopra i campi sperimentali dell’Accademia Cinese delle Scienze Agrarie. Abbiamo etichettato queste immagini (con tanta pazienza!) per avere un riferimento solido.

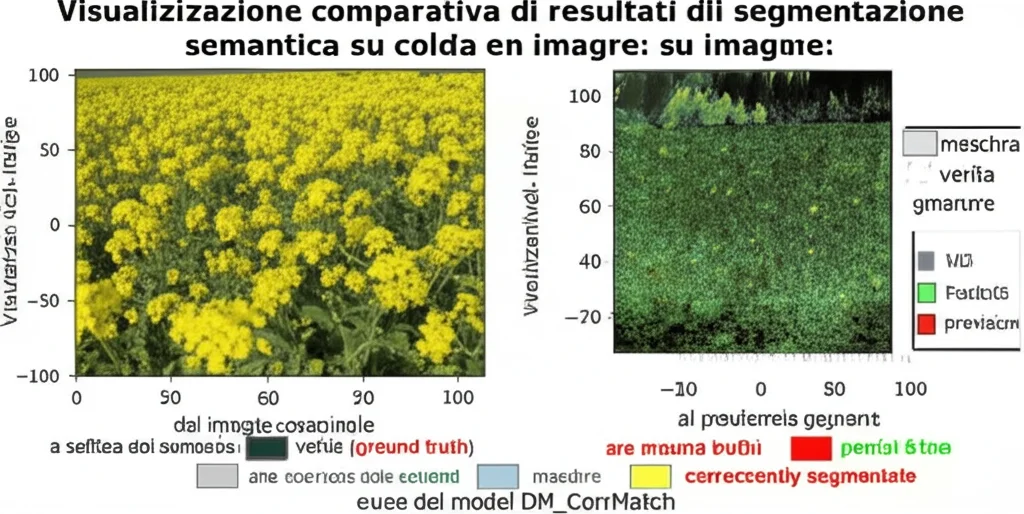

E i risultati? Beh, siamo davvero soddisfatti! Abbiamo confrontato DM_CorrMatch con quattro metodi tradizionali di segmentazione e ben undici altri metodi di deep learning (sia supervisionati che semi-supervisionati). Il nostro approccio ha ottenuto i punteggi migliori su tutti i fronti: Intersection over Union (IoU) di 0.886, Precisione di 0.942 e Recall di 0.940. L’IoU, in particolare, misura quanto le aree segmentate dal modello si sovrappongono a quelle reali: più è vicino a 1, meglio è. Un valore di 0.886 è eccellente per un compito così complesso!

Questo significa che il nostro metodo è bravissimo a riconoscere i fiori di colza anche quando lo sfondo è incasinato, quando le condizioni di luce cambiano o quando i fiori hanno pose strane. Funziona alla grande anche con poche etichette iniziali, grazie alla magia semi-supervisionata e ai dati generati dal DDPM.

Applicazioni Pratiche: Aiutare i Breeder e Ottimizzare i Voli

Ma a cosa serve tutto questo nella pratica? Beh, per i genetisti e i breeder che lavorano per creare varietà di colza ad alta resa, questo strumento è oro colato. Possono monitorare con precisione come e quando fioriscono le diverse varietà nei campi sperimentali, confrontarle e selezionare le migliori. Abbiamo visto che possiamo mappare la curva di copertura fiorale nel tempo per ogni appezzamento, capendo esattamente quando avviene il picco di fioritura. Abbiamo anche usato i risultati della segmentazione per contare i boccioli (usando un altro strumento chiamato RapeNet+), ottenendo dati quantitativi ancora più dettagliati.

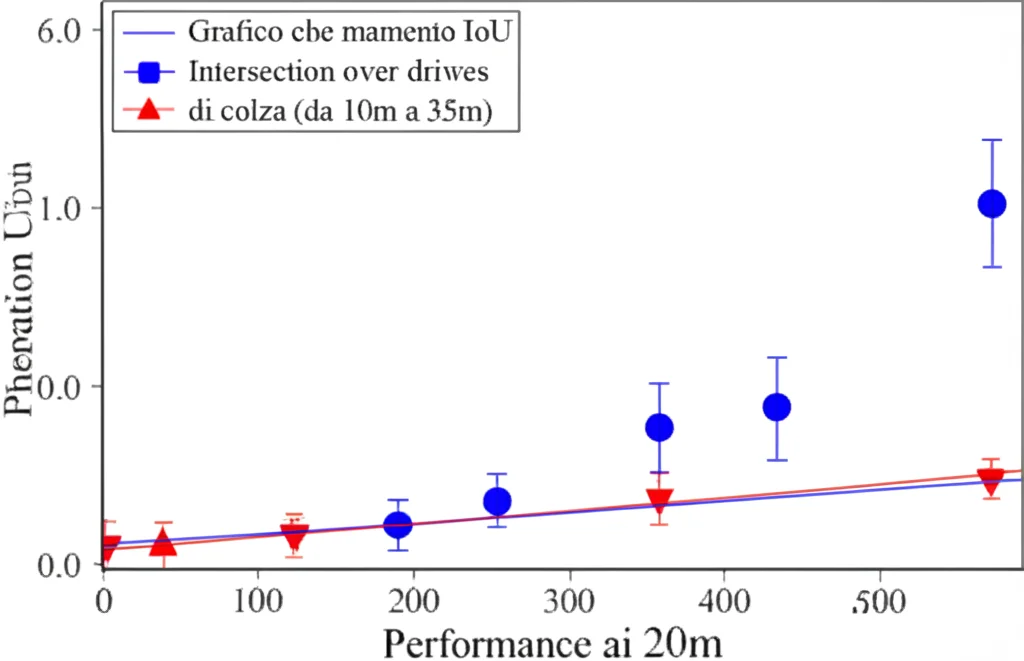

Ci siamo anche posti una domanda pratica: qual è l’altitudine di volo migliore per il drone? Volare più alto significa coprire più area in meno tempo, ma la risoluzione dell’immagine diminuisce. Volare troppo basso dà dettagli incredibili, ma richiede più tempo e più voli. Abbiamo testato il nostro modello con immagini simulate a diverse altitudini (da 10 a 35 metri). I risultati? Fino a 15-20 metri, le prestazioni restano altissime (IoU intorno a 0.885-0.887). Sopra i 20-25 metri, la precisione inizia a calare significativamente perché si perdono troppi dettagli. Quindi, per i nostri campi, volare a circa 20 metri sembra il compromesso ideale tra efficienza e accuratezza.

Guardando al Futuro

Insomma, DM_CorrMatch è un passo avanti notevole per monitorare la colza usando droni e AI. Il nostro approccio semi-supervisionato, potenziato dalla generazione di dati con DDPM, dalla rete Mamba-Deeplabv3+ e dalla strategia AUL, si è dimostrato robusto ed efficace. Abbiamo anche creato un dataset prezioso per la comunità scientifica.

Certo, ci sono ancora sfide. Il modello attuale è abbastanza “pesante” in termini di calcolo e parametri, il che potrebbe renderne difficile l’uso su dispositivi con meno risorse o per analisi in tempo reale. Il nostro prossimo obiettivo è proprio questo: rendere il modello più leggero ed efficiente, magari esplorando tecniche di compressione o architetture più snelle, senza sacrificare troppo la precisione. E poi, perché fermarsi alla colza? Vogliamo estendere questo approccio ad altre colture, per portare i benefici dell’agricoltura di precisione a sempre più agricoltori.

Spero che questo tuffo nel mondo della tecnologia applicata all’agricoltura vi sia piaciuto! È un campo in continua evoluzione, e noi siamo entusiasti di contribuire a renderlo più sostenibile e produttivo.

Fonte: Springer