Incendi Boschivi: E se l’IA Annusasse il Fumo Prima di Noi? La Rivoluzione YOLOv11

Ciao a tutti! Oggi voglio parlarvi di un argomento che, purtroppo, sentiamo nominare sempre più spesso, specialmente durante le torride estati: gli incendi boschivi. Sono disastri ecologici spaventosi, capaci di radere al suolo ettari di natura, mettere in ginocchio economie locali e, cosa più grave, minacciare la biodiversità e la sicurezza di noi esseri umani. E diciamocelo, con i cambiamenti climatici che galoppano, la situazione non fa che peggiorare di anno in anno. Diventa quindi una corsa contro il tempo trovare sistemi di monitoraggio e allerta precoce sempre più efficaci.

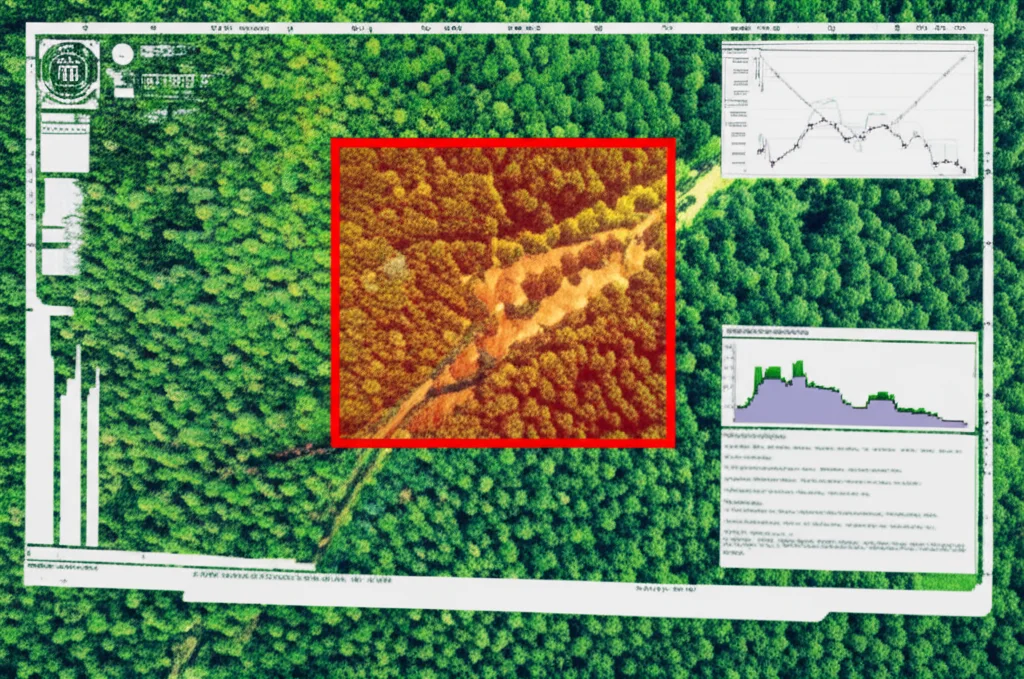

L’Occhio Elettronico che Veglia sulle Foreste

Ed è qui che entro in gioco io, o meglio, la tecnologia che mi appassiona tanto: il deep learning applicato al rilevamento degli oggetti. Immaginate un sistema capace di “vedere” e riconoscere il fumo di un incendio quasi sul nascere. Fantascienza? Non proprio! In questo studio, ci siamo concentrati proprio su questo: abbiamo messo alla prova un algoritmo chiamato YOLOv11x (sì, lo so, i nomi a volte sono un po’ criptici, ma fidatevi, è roba forte!) per sviluppare un modello di rilevamento incendi super efficiente. L’obiettivo? Potenziare la capacità di individuare gli incendi nelle loro primissime fasi, per limitare i danni il più possibile.

Per far sì che il nostro modello fosse un vero asso e non si facesse ingannare facilmente, abbiamo usato due grossi archivi di immagini di incendi disponibili pubblicamente, chiamati WD (Wildfire Dataset) e FFS (Forest Fire Smoke). Pensate a migliaia di foto che mostrano incendi in ogni condizione possibile: scenari complessi, fumo denso, fiamme piccole, incendi diurni e notturni. Un vero e proprio addestramento intensivo!

Dopo ben 501 “epoche” di addestramento (un’epoca è un ciclo completo di apprendimento su tutti i dati), abbiamo tirato le somme. E i risultati? Beh, direi che ci siamo difesi alla grande! Il nostro YOLOv11x ha dimostrato di essere un campione nel minimizzare gli errori, sia nel localizzare con precisione l’incendio (quella che tecnicamente chiamiamo box loss), sia nel classificarlo correttamente (la cls loss), sia in un altro parametro un po’ più tecnico chiamato distribution focal loss (dfl loss). In parole povere, ha imparato a fare il suo lavoro dannatamente bene.

Numeri che Parlano Chiaro: Precisione da Record

Parliamo di numeri concreti? Abbiamo raggiunto una precisione del 0.949 (cioè, quasi il 95% delle volte che ha detto “ecco un incendio!”, aveva ragione), un richiamo del 0.850 (ha beccato l’85% degli incendi reali presenti nelle immagini di test) e delle medie di precisione (mAP50 e mAP50-95) rispettivamente di 0.901 e 0.786. Questi valori ci dicono che il modello non solo è accurato, ma anche stabile e affidabile.

Analizzando la curva Precisione-Richiamo (una specie di pagella del modello), abbiamo confermato un mAP@0.5 medio di 0.901. Ma la cosa più interessante è che per la categoria “fumo”, il mAP@0.5 è schizzato a 0.962! Per le “fiamme”, invece, si è attestato a 0.841. Questo significa che il nostro sistema è un vero segugio quando si tratta di individuare il fumo, un po’ meno (ma comunque bravissimo!) con le fiamme. Perché questa differenza? Semplice: le fiamme hanno colori più vividi e forme più definite, quindi sono più facili da riconoscere. Il fumo, invece, ha texture e forme più ambigue e variabili, il che rende il compito un po’ più arduo. Pensateci: una nuvola bassa o la nebbia potrebbero facilmente essere scambiate per fumo da un occhio inesperto (o da un algoritmo meno evoluto!).

E per darvi un’ulteriore prova della sua affidabilità: nell’insieme di immagini di test, l’86.89% dei campioni ha ottenuto un punteggio di confidenza superiore a 0.85. Insomma, quando YOLOv11x dice la sua, è piuttosto sicuro di sé!

Possiamo dire, quindi, che l’algoritmo YOLOv11x ha un potenziale enorme per il riconoscimento del fumo negli incendi boschivi. Offre un supporto tecnico robustissimo per i sistemi di allerta precoce e apre la strada a sistemi di monitoraggio intelligenti anche in altri campi.

Un Problema Globale e la Risposta della Tecnologia

L’aumento della frequenza degli incendi boschivi a livello mondiale è una minaccia seria per i nostri ecosistemi, per la stabilità climatica e per la nostra sicurezza. Negli ultimi dieci anni, la frequenza e l’intensità sono aumentate notevolmente. Le statistiche ci dicono che tra il 2002 e il 2016, più di 420 milioni di ettari di foreste sono stati distrutti ogni anno dagli incendi nel mondo, con perdite ecologiche ed economiche gigantesche. L’intensificarsi dei cambiamenti climatici e delle attività umane ha ulteriormente aggravato la situazione, mettendo a dura prova la capacità di recupero degli ecosistemi.

I metodi tradizionali di monitoraggio degli incendi, come le ispezioni manuali, i modelli di indice di pericolo incendio e i sensori a terra, faticano a rilevare e localizzare tempestivamente gli incendi in terreni complessi e condizioni climatiche variabili. Hanno tempi di risposta lenti e una precisione limitata, il che rappresenta una sfida enorme per i sistemi di allerta precoce e per l’efficacia degli interventi di spegnimento.

Negli ultimi anni, il deep learning ha mostrato vantaggi notevoli nell’elaborazione delle immagini e nel riconoscimento di pattern, offrendo soluzioni innovative per affrontare la tempestività e la complessità del monitoraggio degli incendi boschivi. A differenza dei metodi tradizionali, il deep learning può elaborare in modo efficiente grandi volumi di dati da telerilevamento e immagini di videosorveglianza, migliorando significativamente l’accuratezza del rilevamento del fumo da incendio, specialmente in scenari di incendi a rapida diffusione. Quindi, esplorare l’applicazione del deep learning nel rilevamento degli incendi boschivi non solo migliora la tempestività e l’accuratezza del monitoraggio, ma fornisce anche nuovi approcci per rafforzare le capacità di risposta alle emergenze incendio.

Le Armi del Deep Learning: Classificazione, Segmentazione e Rilevamento Oggetti

Esistono principalmente tre metodi basati sul deep learning per il rilevamento degli incendi boschivi:

- Classificazione delle immagini: Utilizza reti neurali convoluzionali (CNN) per analizzare le immagini catturate da satelliti o droni, distinguendo le aree colpite da incendio dalle normali regioni forestali. Modelli comuni includono AlexNet, VGGNet, Inception (GoogleNet), DenseNet e MobileNet. Tuttavia, questo metodo si basa tipicamente su caratteristiche globali per la previsione, il che lo rende vulnerabile alla complessità dello sfondo e ai dettagli poco chiari dell’incendio. Di conseguenza, l’accuratezza nel rilevare aree incendiate piccole o frammentate può diminuire.

- Segmentazione semantica: Ottiene un rilevamento e un’analisi degli incendi più precisi classificando ogni pixel di un’immagine come incendio o sfondo, migliorando così il dettaglio del monitoraggio e fornendo informazioni affidabili per la valutazione dell’impatto dell’incendio. Modelli comuni includono U-Net, FCN, DeepLab, SegNet e PSPNet. Tuttavia, i modelli di segmentazione possono produrre tassi di errore più elevati in sfondi complessi, variazioni multi-scala o ambienti dinamici, e il loro riconoscimento dei dettagli dell’incendio potrebbe essere ancora meno flessibile rispetto ai metodi di rilevamento oggetti.

- Rilevamento oggetti: Combina la classificazione e la segmentazione delle immagini identificando le categorie target e fornendo informazioni sui riquadri di delimitazione (bounding box), consentendo una localizzazione accurata degli incendi. Nel monitoraggio degli incendi, la tempestività e l’accuratezza del rilevamento oggetti facilitano l’identificazione precoce dei potenziali pericoli di incendio, riducendo così i danni correlati. Sfrutta i punti di forza sia della classificazione che della segmentazione delle immagini, consentendo un’identificazione accurata della posizione e della categoria dell’incendio, in particolare quando si tratta di target multi-scala, piccoli e sfondi complessi.

A differenza della classificazione e della segmentazione delle immagini, il rilevamento oggetti non solo fornisce informazioni sui riquadri di delimitazione per le regioni colpite da incendio, ma esegue anche la localizzazione dell’incendio in tempo reale, essenziale per risposte rapide. I framework tipici di rilevamento oggetti includono la serie R-CNN a due stadi e la serie YOLO a singolo stadio. I metodi a due stadi offrono generalmente un’elevata precisione, ma la loro intensità computazionale e la velocità di elaborazione più lenta li rendono meno adatti per applicazioni in tempo reale come il monitoraggio degli incendi boschivi.

Al contrario, la serie YOLO è un metodo a singolo stadio che divide un’immagine in griglie ed esegue il rilevamento oggetti su ciascuna griglia, saltando la fase di proposta delle regioni. Ciò riduce significativamente il tempo di calcolo e la complessità del modello, consentendo a YOLO di ottenere un’inferenza più rapida nei sistemi in tempo reale mantenendo un basso tasso di falsi positivi. Ecco perché, per il nostro studio, abbiamo scelto YOLO, in particolare il suo ultimo rampollo, YOLOv11.

YOLOv11: L’Ultima Frontiera del Rilevamento in Tempo Reale

YOLOv11, rilasciato dal team Ultralytics il 30 settembre 2024, rappresenta un significativo passo avanti. Presenta un design architettonico migliorato, tecniche di estrazione delle caratteristiche più sofisticate e metodi di addestramento più raffinati, che gli consentono di catturare dettagli complessi nelle immagini in modo più efficace. Questo modello supporta ampiamente attività come il rilevamento oggetti in tempo reale, la segmentazione di istanze e la stima della posa, e può identificare accuratamente oggetti di varie orientazioni, scale e dimensioni.

Rispetto alle versioni precedenti, YOLOv11 introduce diversi miglioramenti notevoli:

- Miglioramento delle architetture backbone e neck con l’aggiunta dei moduli C3k2 e C2PSA, che aumentano significativamente le capacità di estrazione delle caratteristiche e la precisione del rilevamento.

- Design architettonico e processi di addestramento ottimizzati che raggiungono velocità di elaborazione più elevate mantenendo un forte equilibrio tra accuratezza e prestazioni.

- Adattabilità cross-ambiente che consente l’implementazione su varie piattaforme, inclusi dispositivi edge, piattaforme cloud e sistemi che supportano GPU NVIDIA.

- Supporto completo per molteplici applicazioni di visione artificiale.

Nei benchmark, YOLOv11 ha dimostrato di superare significativamente le serie da YOLOv5 a YOLOv10 in termini di mAP50-95 sul dataset COCO, esibendo anche velocità di inferenza più rapide. Particolarmente nel rilevamento di piccoli oggetti e nel rilevamento multi-scala all’interno di scene complesse, YOLOv11 mostra una precisione superiore.

Sfide nel Riconoscimento del Fumo e Perché YOLOv11 è una Buona Scelta

Nel sistema di allerta precoce per incendi boschivi, il rilevamento del fumo presenta diverse sfide:

- Spesso appare con forme sfocate e irregolari con confini poco chiari.

- Il fumo può essere di piccola scala e distribuito in modo non uniforme, rendendolo facile da confondere con fenomeni naturali come nuvole o nebbia.

- L’ambiente forestale è complesso, con sfondi diversi e condizioni di illuminazione variabili che possono influire sulle prestazioni di rilevamento.

Quantitativamente, YOLOv11 si distingue per le sue prestazioni in tempo reale, offrendo un’elevata velocità di inferenza (80–150 FPS) e bassa latenza (7-12ms), rendendolo ideale per risposte rapide nei sistemi di allerta incendio. È adatto per il rilevamento in tempo reale su telecamere di sorveglianza e droni. Tuttavia, la sua capacità di rilevare piccoli target, come fumo distante, e gestire sfondi complessi è limitata, il che potrebbe portare a mancate rilevazioni nella fase iniziale dell’incendio. Per questo, una strategia multi-modello, che combini YOLOv11 con altri algoritmi come EfficientDet o RetinaNet per migliorare l’accuratezza, o Faster R-CNN per analisi offline ad alta precisione, potrebbe essere la soluzione ottimale.

Dentro YOLOv11: Architettura e Innovazioni Tecniche

L’architettura di rete di YOLOv11 comprende tre componenti principali: il backbone, il neck e l’head.

- Il backbone è responsabile dell’estrazione di ricche caratteristiche dall’immagine di input.

- Il neck fonde le caratteristiche multistrato dal backbone, migliorando la capacità del modello di rilevare oggetti di varie scale con maggiore precisione.

- L’ head converte le mappe delle caratteristiche fuse in risultati di rilevamento effettivi.

Rispetto a modelli precedenti come YOLOv8, YOLOv11 introduce diverse innovazioni tecniche significative, tra cui il modulo C3k2 (che ottimizza l’architettura CSP bottleneck), il meccanismo C2PSA (che incorpora un meccanismo di attenzione multi-testa combinando attenzione spaziale e sui canali, migliorando significativamente la rappresentazione delle caratteristiche e il rilevamento di piccoli oggetti) e un design dell’head disaccoppiato con convoluzioni depthwise (DWConv) che riducono parametri e costi computazionali.

L’Addestramento del Modello: Dati e Parametri

Come accennato, abbiamo utilizzato i dataset WD e FFS. Il FFS è composto da 42.900 immagini, equamente distribuite tra fuoco, fumo e non-fuoco. Il WD contiene 2.700 immagini, categorizzate in modo più granulare. Per migliorare la capacità di generalizzazione del modello, abbiamo applicato una serie di tecniche di aumento dei dati: rotazione, capovolgimento, ridimensionamento, regolazione della luminosità, trasformazione del colore e aggiunta di rumore. Le etichettature sono state fatte manualmente con lo strumento LabelMe e convertite nel formato YOLO.

L’addestramento è stato condotto su un sistema Windows con tre GPU NVIDIA GeForce RTX 2080 Ti. Abbiamo impostato 1000 epoche totali, con un meccanismo di arresto anticipato. La dimensione del batch era 32, e la dimensione dell’immagine di input 640×640 pixel. Abbiamo utilizzato pesi preaddestrati (“YOLOv11x.pt”) e un tasso di apprendimento iniziale di 0.001 con schedulazione a coseno decrescente.

Analisi delle Prestazioni: Le Funzioni di Perdita

Durante l’addestramento, abbiamo monitorato tre funzioni di perdita principali:

- Box loss: Misura la discrepanza geometrica tra il riquadro di delimitazione previsto e quello reale. Le curve di questa perdita hanno mostrato una diminuzione costante, indicando che il modello stava diventando sempre più preciso nel localizzare gli incendi.

- Cls loss (Classification loss): Valuta l’accuratezza delle categorie target previste dal modello. Anche qui, le curve hanno mostrato un trend decrescente, significando che il modello imparava a distinguere sempre meglio tra, ad esempio, fumo e fiamme.

- Dfl loss (Distribution focal loss): Introdotta per aumentare la precisione di previsione dei riquadri di delimitazione modellandoli come distribuzioni di probabilità. Questa perdita ha seguito un andamento simile alle altre due, confermando l’ottimizzazione del modello.

In generale, tutte le funzioni di perdita hanno mostrato una significativa diminuzione e stabilizzazione nel corso dell’addestramento, indicando una buona convergenza e capacità di generalizzazione del modello.

Metriche di Accuratezza: Oltre le Funzioni di Perdita

Abbiamo anche valutato il modello usando metriche standard come precisione, richiamo, mAP50 e mAP50-95.

I grafici di queste metriche hanno mostrato un calo iniziale (fase di assestamento del modello) seguito da un aumento costante e una stabilizzazione a valori elevati, confermando le ottime prestazioni già anticipate dalle funzioni di perdita. L’F1 Score, una media armonica di precisione e richiamo, ha raggiunto un valore finale di 0.8968, un miglioramento notevole che sottolinea l’eccezionale capacità di rilevamento del fumo del modello dopo l’addestramento.

La curva Precisione-Richiamo (PR) ha rivelato un mAP@0.5 medio di 0.901. Come già detto, il fumo ha ottenuto un mAP@0.5 di 0.962, mentre la fiamma 0.841. Nonostante la precisione leggermente inferiore per la categoria fiamma, un mAP@0.5 di 0.841 rappresenta comunque una prestazione eccezionale, data la difficoltà nel rilevare le fiamme a causa delle loro forme variabili e dinamiche.

Infine, l’analisi della confidenza ha mostrato che nell’insieme di test, l’86.89% dei campioni aveva punteggi di confidenza superiori a 0.85. La confidenza media per il rilevamento delle fiamme era 0.90, mentre per il fumo 0.88. Un test statistico ha confermato che il modello è significativamente più confidente nel rilevare il fumo rispetto alle fiamme, probabilmente a causa delle caratteristiche visive più definite del fumo in alcuni contesti rispetto alla natura più eterea e variabile delle fiamme, specialmente se piccole o distanti.

Test sul Campo (Simulato) e Limiti Attuali

Per testare il modello in scenari più “realistici”, abbiamo utilizzato il dataset pubblico “Forest Fire Classifier Dataset”, che include immagini ad alta definizione di una vasta gamma di scenari di incendi boschivi. Anche qui, il modello ha dimostrato buone prestazioni, specialmente nel rilevamento delle fiamme.

Tuttavia, YOLOv11 affronta ancora sfide significative in alcuni scenari complessi.

- Sovrapposizione visiva: Quando le caratteristiche visive di fiamme e fumo si sovrappongono, il modello può fallire nell’identificare correttamente alcune aree di fiamma, specialmente se piccole, sfocate o nelle fasi iniziali di un incendio.

- Basso contrasto e sfondi complessi: In condizioni di basso contrasto, la confidenza del modello nel rilevare il fumo può diminuire. In scenari urbani complessi, elementi di sfondo come edifici o luci possono essere confusi con il fumo.

- Piccoli target dinamici: Le fiamme, essendo target piccoli e dinamici, sono particolarmente difficili da rilevare, specialmente a lunga distanza o nelle fasi iniziali. A volte il modello può anche scambiare oggetti di sfondo (come rami) per fumo (falsi positivi).

Direzioni Future: Come Migliorare Ancora

Nonostante i risultati promettenti, c’è sempre spazio per migliorare. Le direzioni future della ricerca dovrebbero concentrarsi su:

- Fusione di dati multi-modali: Integrare immagini termiche con altre fonti di dati può aiutare a distinguere fiamme e fumo in base alla temperatura, anche con fumo denso o confini sfocati.

- Meccanismi di auto-attenzione: L’integrazione di meccanismi come i Transformer può migliorare la focalizzazione del modello sulle aree chiave.

- Tecniche di miglioramento dell’immagine: Specialmente per il contrasto e la luminosità, per estrarre meglio le caratteristiche da immagini a basso contrasto.

- Separazione dello sfondo: Rafforzare la modellazione dello sfondo per ridurre l’impatto di ambienti complessi.

- Rilevamento multi-scala: Per migliorare la capacità di rilevare piccoli target di fiamma.

- Collaborazione interdisciplinare: Integrare conoscenze da campi come l’ecologia e la climatologia per prevedere meglio la propagazione degli incendi.

- Integrazione con sistemi di monitoraggio intelligenti: Combinare YOLOv11 con droni, telerilevamento satellitare e sensori a terra per sistemi di monitoraggio completi.

L’integrazione di dataset in tempo reale come FLAME e UAVS-FFDB sarà cruciale per validare il modello in scenari di incendi reali e urgenti.

In Conclusione: Un Futuro Più Sicuro Grazie all’IA?

Questo studio ha dimostrato che l’algoritmo YOLOv11 ha prestazioni eccellenti nel riconoscimento del fumo da incendi boschivi. Certo, ci sono ancora dei limiti, specialmente in scenari complessi. Ma le strade per il miglioramento sono chiare e promettenti. L’obiettivo è sviluppare un sistema di monitoraggio degli incendi boschivi intelligente che sia sempre più adattivo, accurato e facilmente implementabile. E chissà, forse un giorno questi “occhi elettronici” diventeranno i nostri migliori alleati nella lotta contro gli incendi, aiutandoci a proteggere le nostre preziose foreste e le nostre comunità. Io ci credo!

Fonte: Springer