Un Tesoro Digitale per la Lingua dei Segni Cinese: Il Nuovo Dataset che Cambia Tutto!

Ciao a tutti! Oggi voglio parlarvi di qualcosa di veramente affascinante che sta succedendo nel mondo dell’intelligenza artificiale e della comunicazione. Immaginate un mondo dove le barriere comunicative tra persone udenti e persone sorde o ipoudenti si assottigliano sempre di più, grazie alla tecnologia. Sembra fantascienza? Beh, ci stiamo avvicinando, e un passo fondamentale è stato appena fatto nel campo della Lingua dei Segni Cinese (CNSL).

Sapete, la lingua dei segni non è universale. Ogni paese, a volte ogni regione, ha la sua. È una lingua visiva complessa, fatta non solo di forme delle mani (che già sono tante!), ma anche di movimenti, pose, espressioni facciali, movimenti della bocca, della testa, delle spalle… insomma, un universo comunicativo ricchissimo. Per chi non la conosce, impararla è una bella sfida. Ecco perché da tempo si cerca di sviluppare strumenti automatici, basati sull’IA, per “tradurre” i video della lingua dei segni in testo o parole (gloss). Questo campo si chiama Sign Language Recognition (SLR).

La Sfida dei Dati: Il Tallone d’Achille dell’IA

Qui entra in gioco il solito problema dell’intelligenza artificiale: per imparare bene, ha bisogno di tantissimi dati. E nel caso delle lingue dei segni, questi dati scarseggiano. Pensateci: raccogliere video di alta qualità, con persone diverse che eseguono migliaia di segni diversi, annotarli correttamente… è un lavoro enorme!

In particolare, per la Lingua dei Segni Cinese (CNSL), i dataset esistenti avevano due grossi limiti:

- Vocabolario Incompleto: Nessuno dei dataset disponibili copriva l’intero vocabolario ufficiale della CNSL. È come cercare di insegnare l’italiano a un’IA usando solo le parole che iniziano per A, B e C! Chiaramente, le applicazioni reali ne risentono.

- Prospettiva Singola: La maggior parte dei dataset offriva video ripresi solo da una prospettiva (di solito frontale). Ma nella lingua dei segni, le mani si muovono nello spazio tridimensionale. A volte una mano può nascondere l’altra, o un dettaglio importante del movimento può non essere visibile da un’unica angolazione. Questo problema, chiamato “occlusione”, è un bel grattacapo per gli algoritmi di riconoscimento.

Queste mancanze hanno frenato parecchio lo sviluppo di sistemi ISLR (Isolated Sign Language Recognition, il riconoscimento di singoli segni isolati) veramente efficaci e pronti per l’uso quotidiano in Cina, dove ci sono circa 30 milioni di persone con disabilità uditive.

La Svolta: Arriva NationalCSL-DP!

Ed ecco la notizia bomba: un team di ricercatori ha creato e reso pubblico un nuovo dataset che promette di cambiare le carte in tavola! Si chiama NationalCSL-DP (National Chinese Sign Language dataset with Dual Perspectives). E lasciate che vi dica perché è così speciale.

Innanzitutto, la dimensione del vocabolario. Questo dataset copre l’intero vocabolario ufficiale della CNSL, filtrato per avere movimenti distinti. Parliamo di ben 6.707 segni unici! Per darvi un’idea, altri dataset famosi come WLASL ne contengono “solo” 2.000. Questo significa che le IA allenate su NationalCSL-DP avranno una conoscenza molto più completa della lingua. In totale, il dataset contiene 134.140 video, per oltre 88 ore di girato!

Ma la vera chicca è la doppia prospettiva. Per ogni segno, eseguito da 10 “segnanti” diversi (persone che usano la lingua dei segni), ci sono video ripresi contemporaneamente da due angolazioni: frontale e laterale (sinistra). Questo è un passo da gigante per affrontare il problema dell’occlusione. A quanto ne so, è il primo dataset per ISLR cinese che offre questa doppia visuale e copre l’intero vocabolario. Fantastico, no?

Dietro le Quinte: Un Lavoro Meticoloso

Creare un dataset del genere non è uno scherzo. C’è stato un lavoro enorme e rigoroso dietro. Hanno reclutato 10 partecipanti (8 studenti sordi e 2 udenti, tutti proficienti in CNSL) dall’Università Normale di Leshan. Hanno ottenuto tutte le autorizzazioni etiche necessarie, cosa importantissima quando si lavora con dati personali e immagini di persone.

Il primo passo è stato “pulire” il vocabolario ufficiale CNSL (che conta oltre 8000 parole):

- Hanno eliminato i segni che, pur avendo significati diversi, avevano esattamente lo stesso movimento (es. “guerra”, “combattimento”, “campagna”). Ne hanno tenuto solo uno per movimento.

- Hanno gestito i casi di parole con lo stesso “gloss” (etichetta) ma movimenti diversi a seconda del contesto (es. “cintura di sicurezza” in aereo vs. in auto), aggiungendo suffissi tipo “1-1”, “1-2”.

- Hanno fatto lo stesso per parole con stesso significato ma movimenti diversi a seconda della regione (es. “governo” nel nord vs. sud della Cina), usando suffissi come “2-1”, “2-2”.

Alla fine, sono rimasti i 6.707 segni unici del dataset.

Poi è iniziata la fase di registrazione. In studi appositi con green screen, ogni partecipante ha eseguito tutti i segni, ripreso simultaneamente dalle due telecamere HD (1920×1080 a 50fps). C’era sempre un esperto di lingua dei segni a supervisionare per garantire la correttezza dei movimenti. Hanno anche standardizzato l’abbigliamento (maglietta nera) e le istruzioni per iniziare e finire il segno. Un lavoro certosino che è durato circa 5 mesi!

Non Solo Mani: L’Importanza del Contesto

Un aspetto interessante sottolineato dai ricercatori è l’importanza delle caratteristiche non manuali. A volte si pensa che per riconoscere un singolo segno basti guardare le mani. Invece, anche per l’ISLR, espressioni facciali, movimenti della testa o del corpo possono essere cruciali. Alcuni segni della CNSL richiedono specificamente certe espressioni o movimenti del capo. Ignorare questi aspetti ridurrebbe l’accuratezza del riconoscimento. Per questo, le riprese hanno catturato i segnanti dalla vita in su, assicurandosi che anche volto e busto fossero sempre ben visibili.

Controllo Qualità: A Prova di Errore (o Quasi!)

Dopo aver registrato tutto, è arrivato il momento dell’annotazione (associare ogni video clip al segno corretto) e del controllo qualità. Immaginatevi 134.140 video clip da controllare! È un lavoro tedioso e facile da sbagliare. Per questo, hanno implementato un processo di verifica incrociata: tutti i partecipanti hanno controllato attentamente i video, identificando ben 7 tipi di problemi:

- Errori di annotazione (errori di battitura o etichette scambiate tra video vicini).

- Errori di movimento (segno eseguito in modo scorretto).

- Errori di editing (contenuto inappropriato nel video, come pause, chiacchiere…).

- Video di bassa qualità (problemi di stabilizzazione, schermo nero, file corrotti).

- Problemi di sfondo (oggetti estranei nell’inquadratura).

- Registrazione inappropriata (es. mano fuori dall’inquadratura perché la telecamera era troppo vicina).

- Video mancanti o duplicati.

Questo controllo ha richiesto circa 45 giorni e ha permesso di identificare e correggere 3.068 problemi. Una dedizione incredibile alla qualità!

Validazione Tecnica: L’IA che Controlla l’IA

Ma non si sono fermati qui. Hanno anche effettuato una validazione tecnica usando… l’intelligenza artificiale stessa! Hanno addestrato modelli di deep learning (come Swin Transformer e SL-GCN) sul dataset per estrarre delle “firme” numeriche (feature vectors) da ogni video, sia dalle immagini RGB che dallo scheletro del movimento.

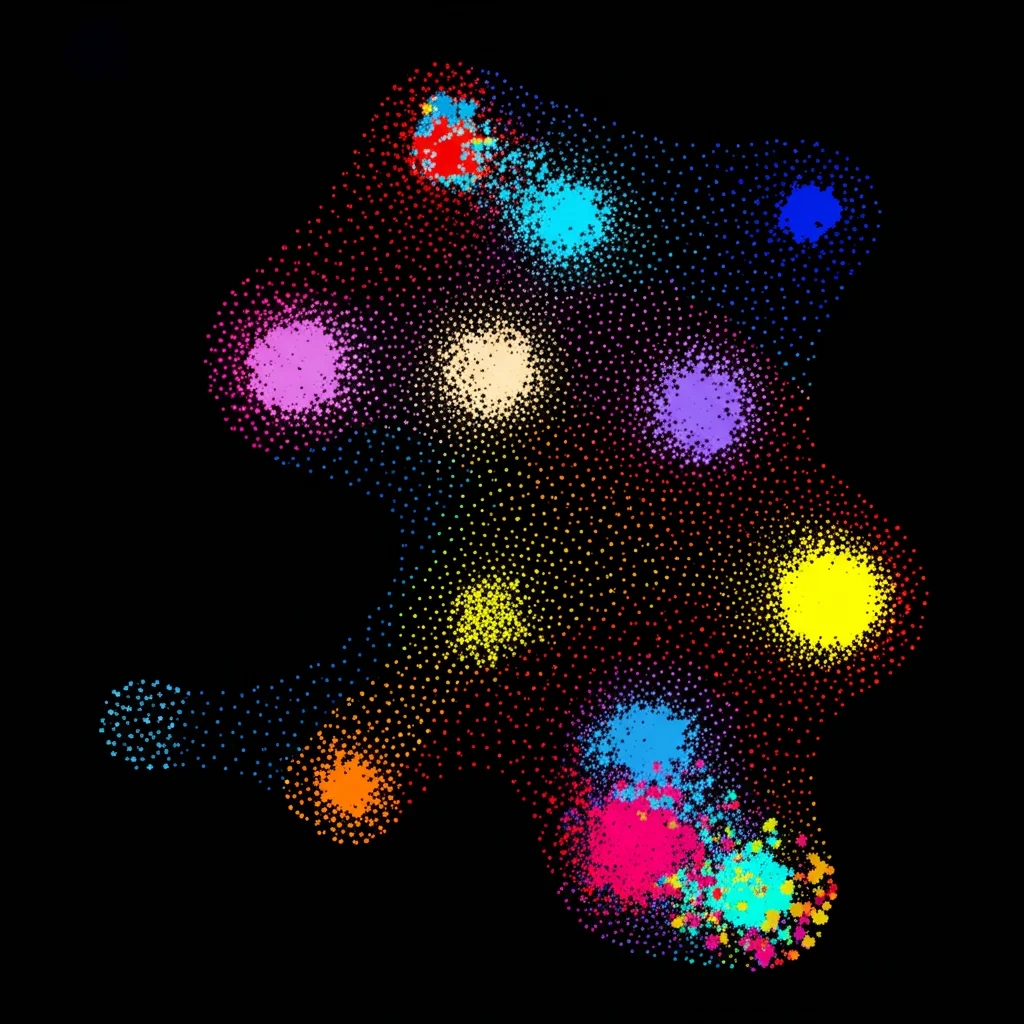

Poi, hanno usato tecniche come t-SNE per visualizzare questi dati in 2D (immaginate una mappa stellare dove ogni stella è un video, e video simili sono vicini) e K-means per raggruppare automaticamente i video simili (clustering). Hanno calcolato varie metriche per vedere quanto bene questi cluster corrispondessero ai segni reali.

Questo processo ha permesso di fare due cose:

1. Confermare la qualità del dataset: La buona separazione dei cluster ha mostrato che i dati sono ben strutturati e distinti.

2. Identificare potenziali errori residui: Analizzando i video che finivano nei cluster “sbagliati” o che erano molto diversi dagli altri video dello stesso segno (bassa similarità intra-classe), hanno individuato 243 campioni “sospetti”. Controllandone a mano una parte (il 5%), hanno scoperto che questo metodo automatico era molto efficace nel trovare errori di etichettatura o problemi nei video (con una precisione del 75% e una recall del 94%!). Un aiuto prezioso per ridurre l’enorme lavoro di controllo manuale.

Cosa C’è Dentro e Dove Trovarlo

Il dataset NationalCSL-DP è disponibile pubblicamente (su Figshare e sul sito dell’università). È organizzato in cartelle:

- Videos: Contiene i video grezzi originali (1920×1080). A causa delle dimensioni enormi (oltre 1.8 TB!), solo una piccola parte è su Figshare, ma i dati completi sono disponibili altrove.

- Pics: Contiene i fotogrammi estratti dai video, già ridimensionati a 256×256 pixel, pronti per essere usati dai modelli di IA. Questa parte è completamente disponibile.

- Code: Fornisce il codice Java per estrarre i fotogrammi e gli script Python usati per la validazione tecnica (estrazione feature, clustering, ecc.).

C’è anche un file `gloss.csv` che mappa i nomi dei file video ai corrispondenti segni in cinese e inglese.

Un Futuro Più Accessibile

Questo nuovo dataset è davvero una risorsa preziosissima. Fornendo una copertura completa del vocabolario CNSL e la fondamentale doppia prospettiva, NationalCSL-DP ha il potenziale per accelerare significativamente la ricerca sull’ISLR e portare allo sviluppo di applicazioni molto più accurate e utili nel mondo reale.

Pensate alle possibilità: sistemi di traduzione istantanea, strumenti di apprendimento per chi vuole imparare la lingua dei segni, interfacce uomo-macchina più accessibili… tutto questo diventa più vicino grazie a un lavoro di raccolta dati così ben fatto e completo. È un passo importante per abbattere le barriere comunicative e rendere il mondo un po’ più inclusivo per la comunità sorda. Non vedo l’ora di vedere cosa riusciranno a creare i ricercatori sfruttando questo tesoro digitale!

Fonte: Springer