Decodificare la Visione: Viaggio nel Cervello con il Nuovo Dataset EEG MSS

Ciao a tutti, appassionati di mente e tecnologia! Oggi voglio parlarvi di qualcosa che mi entusiasma parecchio: un nuovo, incredibile strumento che promette di farci fare passi da gigante nella comprensione di uno dei processi più affascinanti del nostro cervello: il riconoscimento visivo degli oggetti. Sapete, quella capacità quasi magica che ci permette di identificare una mela, un volto amico o un paesaggio in una frazione di secondo? Ecco, studiarla non è affatto semplice, ma grazie a tecniche come l’elettroencefalografia (EEG) – che misura l’attività elettrica del cervello – possiamo sbirciare “sotto il cofano”.

Il problema è che per capire davvero come funziona, servono tanti, tantissimi dati. E non dati qualsiasi, ma dati di alta qualità, raccolti su molte persone e in momenti diversi. Ed è qui che entra in gioco la novità di cui voglio parlarvi: un dataset EEG multi-soggetto e multi-sessione (MSS) appena reso pubblico.

Un Tesoro di Dati Cerebrali

Immaginate di avere a disposizione i segnali EEG di ben 32 persone, registrati mentre osservavano migliaia di immagini. Non una volta sola, ma in diverse sessioni, a distanza di giorni o settimane! Questo dataset, che chiameremo MSS per comodità, è una vera miniera d’oro. Contiene:

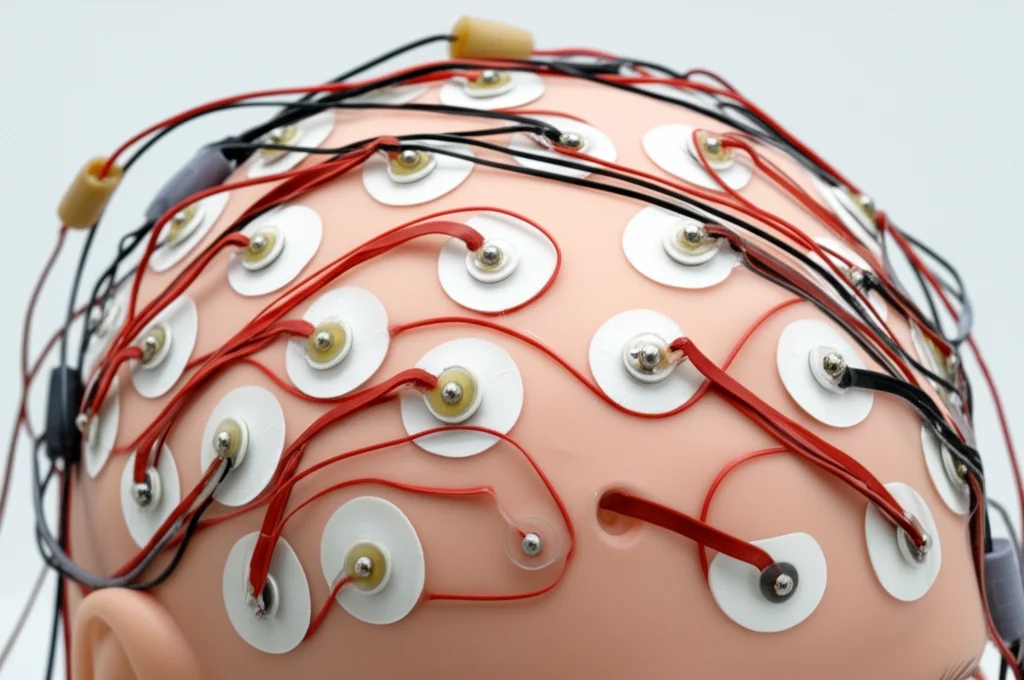

- Segnali EEG a 122 canali (una risoluzione pazzesca!).

- Dati da 32 partecipanti diversi.

- Sessioni multiple per molti partecipanti (fino a 5 sessioni per alcuni!).

- Un set enorme di stimoli: 10.000 immagini divise in 20 categorie (500 immagini per categoria!), selezionate con cura da database famosi come PASCAL e ImageNet.

- Dati raccolti con due diversi “modi” di presentare le immagini (paradigmi sperimentali).

Ma perché tutta questa abbondanza è così importante? Beh, pensateci: ogni cervello è unico, e anche lo stesso cervello può rispondere diversamente in giorni diversi. Avere dati da tanti soggetti e tante sessioni ci permette di studiare questa variabilità, che è una delle sfide più grandi per chi sviluppa, ad esempio, interfacce cervello-computer (BCI) che funzionino per tutti e sempre.

Cosa Rende Speciale il Dataset MSS?

Negli ultimi anni sono stati pubblicati altri dataset EEG legati alla visione, e sono stati importantissimi. Ma il dataset MSS porta qualcosa in più. Rispetto ad alcuni dataset precedenti, offre un numero molto maggiore di immagini per ciascuna categoria (ben 500!). Questo è fondamentale se vogliamo usare tecniche di deep learning per analizzare i dati: più esempi abbiamo, meno rischiamo che i nostri modelli imparino “a memoria” invece di capire davvero i pattern cerebrali (un problema noto come overfitting).

Inoltre, il dataset MSS include dati raccolti con due paradigmi diversi:

- RSVP (Rapid Serial Visual Presentation): Le immagini vengono mostrate molto velocemente, una dopo l’altra (a 5 Hz, cioè 5 immagini al secondo). Questo permette di raccogliere tantissimi dati in poco tempo ed è ottimo per studiare le risposte rapide del cervello.

- Low-speed: Ogni immagine viene mostrata per un secondo intero, dando al cervello più tempo per processarla e permettendo di raccogliere segnali “puliti” senza sovrapposizioni.

Avere entrambi i tipi di dati ci consente di confrontare come il cervello reagisce a diverse velocità di presentazione e di scegliere l’approccio migliore a seconda della domanda di ricerca.

Infine, le immagini usate provengono da sorgenti diverse rispetto ad altri dataset recenti, ampliando la varietà di stimoli visivi studiati con l’EEG. La dimensione complessiva del dataset è paragonabile a quella dei più grandi oggi disponibili per questo tipo di ricerca. Insomma, una risorsa davvero preziosa!

Sbirciare Dentro gli Esperimenti

Come hanno fatto a raccogliere tutti questi dati? I 32 partecipanti (studenti universitari, età media 23.6 anni, quasi tutti maschi – un piccolo limite, forse) si sono seduti comodi in un laboratorio silenzioso, davanti a un monitor, indossando una speciale cuffia con 122 elettrodi bagnati (con un gel conduttivo, per migliorare il contatto). L’impedenza degli elettrodi veniva tenuta sotto controllo per garantire segnali di buona qualità.

Ogni sessione durava circa un’ora e mezza e alternava “run” (blocchi di esperimento) dei due paradigmi: prima una run RSVP, poi una low-speed, e così via, per un totale di 4 run per tipo. Tra una run e l’altra, pause per riposarsi e mantenere alta la concentrazione.

Nel paradigma RSVP, vedevano sequenze rapide di 20-21 immagini della stessa categoria (es. solo gatti, solo macchine…). Ogni tanto, compariva un’immagine “speciale” (un logo BCI) e alla fine della sequenza dovevano segnalare se l’avevano vista. Questo serviva a tenerli attenti e a ridurre i battiti di ciglia durante la presentazione.

Nel paradigma low-speed, ogni immagine restava sullo schermo per 1 secondo. Dopo, comparivano 11 “caselle” con nomi di categorie (una giusta, nove a caso, più una “non so”) e dovevano cliccare su quella corretta usando il mouse. Anche questo aiutava a mantenere l’attenzione e l’engagement.

Le Immagini: Una Selezione Accurata

Le 10.000 immagini non sono state scelte a caso. Provengono dalle 20 categorie semantiche del famoso dataset PASCAL (cose come aereo, bicicletta, uccello, barca, bottiglia, autobus, macchina, gatto, sedia, mucca, tavolo da pranzo, cane, cavallo, moto, persona, pianta in vaso – sostituita poi con una simile da ImageNet perché creava confusione – pecora, divano, treno, monitor TV) integrate con immagini simili da ImageNet quando quelle di PASCAL non bastavano o non erano abbastanza “pulite”.

Il processo di selezione è stato rigoroso: diversi sperimentatori hanno scelto indipendentemente le immagini, tenendo solo quelle selezionate da tutti. Poi, revisioni multiple per eliminare immagini inappropriate o poco chiare e assicurarsi che ogni categoria avesse 500 esempi di alta qualità, con il soggetto ben definito e senza sfondi o scritte strane.

Dati Pronti all’Uso (e Crudi!)

La bellezza di questo progetto è che i dati sono disponibili pubblicamente sulla piattaforma OpenNeuro (dataset ds005589) e organizzati secondo lo standard BIDS (Brain Imaging Data Structure), che rende tutto più facile da capire e utilizzare. Trovate sia i dati grezzi (raw), così come sono stati registrati, sia i dati preprocessati.

Il preprocessing di base include:

- Filtro passa-banda (0.1-100 Hz) per eliminare rumore a frequenze non interessanti.

- Filtro notch a 50 Hz per rimuovere l’interferenza della rete elettrica.

- Divisione dei dati in “epoche” (trials) di 500 millisecondi a partire dalla comparsa dell’immagine.

Non sono state applicate correzioni complesse (tipo rimozione artefatti da movimento oculare), lasciando ai ricercatori la libertà di usare le proprie tecniche preferite. Insieme ai dati, viene fornito anche il codice Python (basato sulla libreria MNE) usato per il preprocessing e per le validazioni tecniche. Massima trasparenza!

Funziona? La Validazione Tecnica

Ok, abbiamo un sacco di dati, ma sono “buoni”? Contengono davvero informazioni utili sul riconoscimento visivo? Per verificarlo, i ricercatori hanno fatto alcune analisi.

Prima di tutto, hanno controllato se i partecipanti erano attenti durante gli esperimenti, guardando le loro performance nei compiti di attenzione (riconoscere l’immagine speciale in RSVP e classificare l’immagine nel low-speed). I risultati sono ottimi: precisione media superiore al 97% in entrambi i casi! Questo ci dice che i partecipanti erano concentrati e i dati sono stati raccolti in condizioni controllate.

Poi, hanno usato un modello di machine learning abbastanza semplice (una rete neurale Fully Connected, FC) per vedere se era possibile classificare la categoria dell’immagine osservata basandosi solo sul segnale EEG di quel singolo trial (ricordate, ogni immagine era vista una sola volta per sessione, quindi non si potevano mediare risposte multiple allo stesso stimolo).

I risultati? Decisamente incoraggianti! Nella maggior parte delle sessioni, l’accuratezza della classificazione era significativamente superiore al caso (che sarebbe il 5%, visto che c’erano 20 categorie). Certo, c’era molta variabilità:

- Tra sessioni dello stesso soggetto: Alcuni partecipanti mostravano prestazioni simili in tutte le loro sessioni, altri avevano alti e bassi.

- Tra soggetti diversi: Alcune persone sembravano “naturalmente portate” per questo tipo di BCI basata sulla visione, ottenendo accuratezze più alte, mentre altre facevano più fatica (un fenomeno noto come “BCI illiteracy”).

- Cross-sessione e cross-soggetto: Quando provavano ad allenare il modello su alcune sessioni/soggetti e testarlo su sessioni/soggetti diversi, le performance calavano drasticamente. Questo conferma che la variabilità del segnale EEG nel tempo e tra persone è una sfida enorme, ma è proprio per studiare e superare questa sfida che dataset come MSS sono fondamentali!

Perché Questo Dataset è Importante per Tutti Noi?

Questo nuovo dataset MSS è una risorsa incredibile per chiunque studi il cervello, la visione, l’intelligenza artificiale o le interfacce cervello-computer. Offre dati ricchi, ben documentati e raccolti con rigore scientifico. Permetterà di:

- Esplorare più a fondo come il nostro cervello processa le informazioni visive.

- Confrontare le risposte EEG in condizioni di presentazione rapida e lenta.

- Sviluppare e testare nuovi algoritmi di machine learning (specialmente deep learning) per decodificare i segnali cerebrali.

- Affrontare la sfida della variabilità inter-soggetto e inter-sessione per creare BCI più robuste ed efficaci per tutti.

È un passo avanti notevole che mette a disposizione della comunità scientifica uno strumento potente per svelare i misteri della nostra mente. Non vedo l’ora di vedere quali scoperte nasceranno dall’analisi di questi dati!

Fonte: Springer