Stampa 3D Metallo: Addio Addestramento! Il Controllo Qualità Diventa Intelligente (e Low-Cost)

Ciao a tutti! Oggi voglio parlarvi di qualcosa che mi appassiona da morire: la stampa 3D dei metalli, o più tecnicamente, la Laser Powder Bed Fusion (PBF-LB/M). È una tecnologia pazzesca, capace di creare oggetti metallici complessi, strato dopo strato, partendo da polvere finissima e usando un laser ad alta potenza. Immaginate le possibilità: pezzi su misura per l’aerospaziale, impianti medici personalizzati, componenti industriali super ottimizzati. Roba da fantascienza diventata realtà!

Però, come in tutte le cose belle, c’è un “ma”. Garantire che ogni pezzo stampato sia perfetto, senza difetti nascosti, con le dimensioni giuste e sempre uguale agli altri… beh, non è una passeggiata. La PBF-LB/M è un processo complesso, pieno di variabili: il laser che fonde, il metallo che si raffredda, la polvere che viene stesa… basta poco per creare imperfezioni. E controllare tutto in tempo reale, mentre la stampante lavora, è una sfida enorme.

La Sfida del Controllo Qualità in Tempo Reale

Negli anni abbiamo provato di tutto: ottimizzare le polveri, regolare finemente i parametri del laser (potenza, velocità), fare trattamenti post-produzione. Ma il vero sogno è avere un sistema che guardi dentro la macchina mentre stampa e ci dica subito se qualcosa non va, magari correggendo al volo.

I sistemi tradizionali, tipo quelli “feedforward” (che prevedono come andrà il processo), faticano con la PBF-LB/M. Simulare in tempo reale cosa succede in ogni strato richiederebbe una potenza di calcolo mostruosa. Allora ci siamo buttati sui sistemi “feedback”: sensori (telecamere, termocamere, ecc.) che raccolgono dati strato per strato e li usano per aggiustare il tiro. Promettente, ma ancora non ci siamo.

Le telecamere ottiche sembrano le più interessanti perché ci danno immagini che possiamo “capire” visivamente. Ma come trasformare queste immagini in dati utili, tipo la geometria esatta del pezzo o la presenza di difetti sulla polvere? Qui entra in gioco l’intelligenza artificiale (AI).

Molti approcci AI, però, hanno un grosso limite: hanno bisogno di TANTE immagini già etichettate da esperti. Immaginatevi passare ore e ore a segnare manualmente su migliaia di foto dove c’è un difetto, che tipo di difetto è, dov’è il contorno esatto del pezzo… Un lavoro immane, costoso e pure soggetto a errori! E se poi cambio materiale, o geometria del pezzo, o parametri di stampa? Spesso bisogna ricominciare da capo con l’addestramento. Non proprio il massimo della flessibilità.

La Nostra Idea: Un Approccio “Training-Free”

E se potessimo fare a meno di tutto questo addestramento? Se potessimo creare un sistema intelligente che impara “al volo”, guardando le immagini senza bisogno di esempi pre-etichettati? È questa la scommessa che abbiamo fatto.

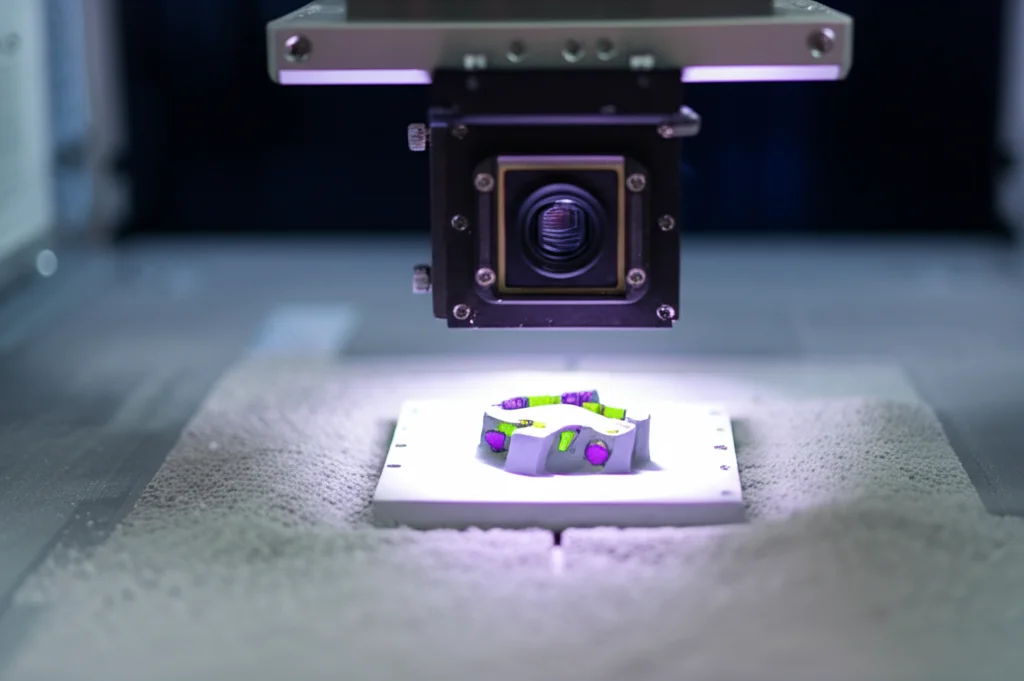

Abbiamo sviluppato un sistema di monitoraggio in situ che non richiede dati sperimentali precedenti e può essere integrato nelle macchine esistenti. Il cuore del sistema è una telecamera CMOS ad alta risoluzione (pensate, 64 Megapixel!) ma sorprendentemente economica (sotto i 100 dollari), accoppiata a un sistema di illuminazione un po’ furbo che abbiamo progettato noi, con luci LED che creano effetti di “campo chiaro” (brightfield) e “campo scuro” (darkfield).

Perché questa doppia illuminazione? Il brightfield ci aiuta a vedere bene il contrasto tra la parte metallica fusa (che riflette la luce in modo diverso) e la polvere circostante. Il darkfield, invece, è fantastico per scovare i difetti sulla superficie della polvere, come piccole irregolarità o striature, perché fa risaltare tutto ciò che non è perfettamente piatto.

Mettere a Fuoco: Correzione e Visione Artificiale

Ovviamente, usare una camera low-cost ha i suoi “contro”. Le immagini possono essere un po’ distorte ai bordi (la famosa “distorsione a barile”) o non perfettamente a fuoco ovunque (aberrazione sferica). E l’illuminazione può non essere perfettamente uniforme. Ma niente paura! Abbiamo messo a punto delle tecniche per correggere automaticamente questi problemi. Usiamo una speciale scacchiera (ChArUco) per calibrare la camera e “raddrizzare” le immagini distorte. Per l’aberrazione sferica, sovrapponiamo due immagini scattate con fuochi leggermente diversi. E per l’illuminazione, usiamo una tecnica chiamata “flat-field correction” che la rende omogenea su tutta l’area di stampa. Risultato? Immagini pulite e affidabili.

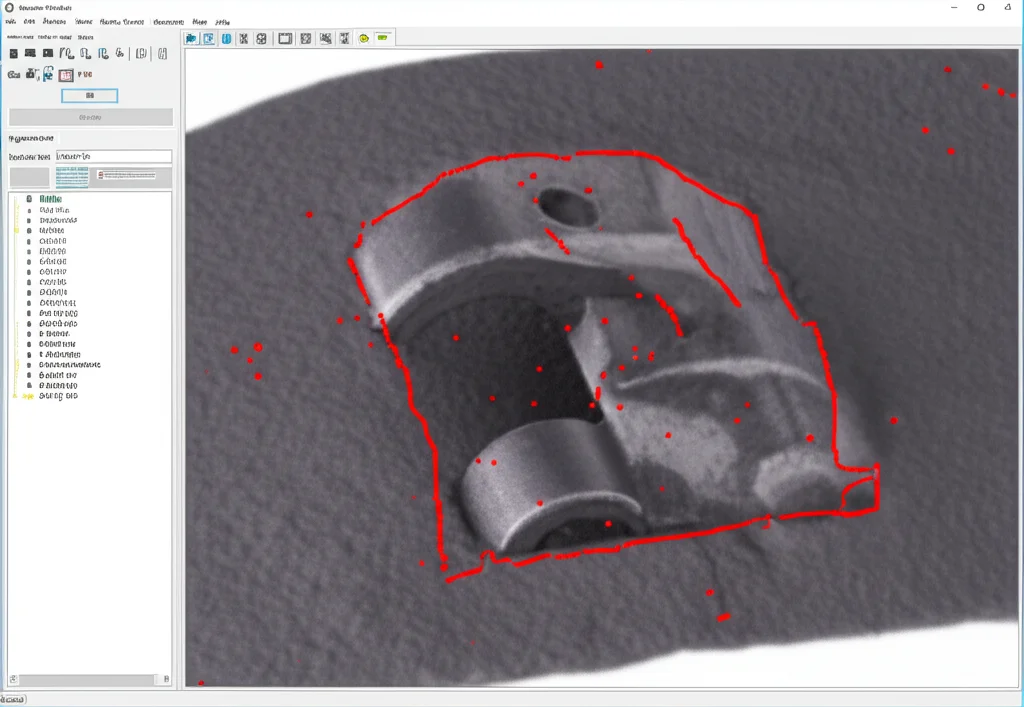

Ora viene il bello: l’analisi. Qui entra in gioco un algoritmo di visione artificiale chiamato GrabCut. È un metodo basato su grafi, originariamente pensato per scontornare oggetti nelle foto con un piccolo aiuto dall’utente. Noi l’abbiamo adattato per funzionare in modo completamente automatico nella PBF-LB/M.

Come? Gli diamo in pasto l’immagine dello strato appena stampato e, come “suggerimento” iniziale, la forma teorica che quello strato dovrebbe avere (presa direttamente dal file CAD 3D). L’algoritmo usa queste informazioni per capire quali pixel appartengono alla parte fusa e quali alla polvere, considerando sia il colore/texture che i bordi/contrasto. Iterazione dopo iterazione, affina la segmentazione fino a trovare il contorno preciso della parte fusa. La cosa fantastica è che non ha bisogno di nessun addestramento preventivo! Si adatta da solo alle variazioni di luminosità, alla texture della superficie (che può cambiare a seconda di come passa il laser), alla forma del pezzo.

Mettendo insieme i contorni segmentati di tutti gli strati, possiamo creare una ricostruzione 3D virtuale del pezzo appena stampato, direttamente dentro la macchina!

Scovare i Difetti: Non Solo Geometria

Ma non ci siamo fermati alla geometria. Il nostro sistema usa le immagini (soprattutto quelle in darkfield) anche per rilevare automaticamente i difetti più comuni sulla superficie della polvere, che possono compromettere la qualità finale del pezzo:

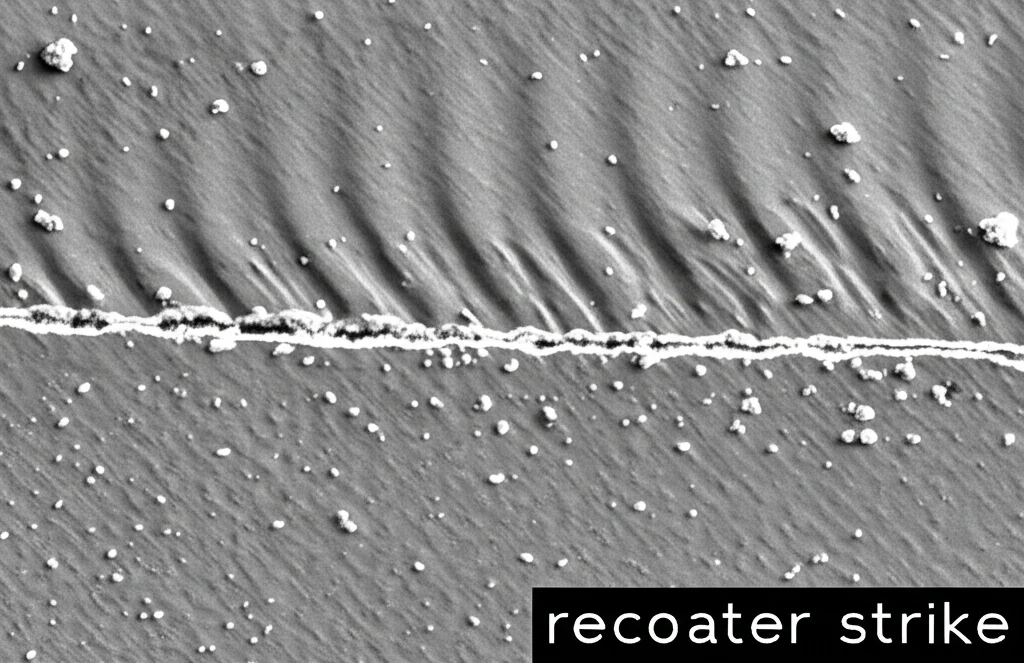

- Recoater Strikes: Sono delle righe lasciate dalla spatola (recoater) che stende la polvere, quando urta contro qualche punto leggermente sollevato. Indicano che la spatola potrebbe essere danneggiata o che qualcosa non va nel processo. Li troviamo analizzando il contrasto e cercando linee nette con specifici algoritmi (tipo Sobel e CLAHE).

- Recoater Hopping: Succede quando la spatola “salta” su un ostacolo, lasciando una zona con meno polvere o distribuita male. Lo becchiamo usando immagini darkfield prese da angolazioni diverse e cercando pattern specifici con tecniche di correlazione.

- Lack of Powder: Semplicemente, zone dove manca polvere. Anche qui, confrontando immagini darkfield e usando filtri particolari (Gabor) e clustering (K-means), riusciamo a identificare queste aree critiche.

E la cosa ancora più bella è che possiamo fare tutto questo contemporaneamente: controllare la geometria E cercare i difetti, strato dopo strato.

La Prova del Nove: Funziona Davvero?

Ok, belle parole, ma funziona? Abbiamo messo alla prova il sistema su una macchina reale (una Aconity Midi+) stampando un cubo di acciaio inossidabile 316L bello grosso (10x10x12 cm). Abbiamo acquisito immagini per 400 strati.

Poi abbiamo fatto i confronti seri:

- Abbiamo confrontato la geometria ricostruita dal nostro sistema con il modello CAD originale (il file STL).

- L’abbiamo confrontata con una scansione a Tomografia Computerizzata (CT) ad altissima risoluzione del pezzo reale stampato (una specie di “verità assoluta” sulla geometria interna ed esterna).

- L’abbiamo confrontata con la segmentazione manuale fatta da 3 esperti diversi su tutte le 400 immagini (un lavoraccio, ma necessario per capire quanto è affidabile l’algoritmo rispetto all’occhio umano).

I risultati? Davvero incoraggianti! La deviazione media tra la nostra ricostruzione e il CAD nominale è stata di soli 15.60 micrometri (µm), e rispetto alla scansione CT di 15.20 µm. Parliamo di precisioni elevatissime! L’indice di Jaccard (una misura di quanto le forme segmentate si sovrappongono a quelle di riferimento) è stato pazzesco: 0.99 in entrambi i casi (1 sarebbe la perfezione assoluta).

Interessante notare che la deviazione rispetto alla segmentazione manuale era un po’ più alta (24.40 µm), simile a quella tra la CT e la segmentazione manuale. Questo suggerisce che il nostro algoritmo automatico potrebbe essere persino più preciso e consistente dell’occhio esperto! Una piccola indagine (Gage ReR) ha confermato che, sebbene gli esperti siano bravi, c’è una certa variabilità tra di loro e anche nello stesso esperto che ripete la misura. Il nostro GrabCut, invece, cade quasi sempre dentro l’intervallo di confidenza degli esperti, ma con meno variabilità.

Anche sul fronte dei difetti, i risultati sono ottimi. Abbiamo misurato precisione, recall (quanto bene trova i difetti veri) e accuratezza bilanciata (importante quando i difetti sono rari). Per la mancanza di polvere abbiamo raggiunto un’accuratezza bilanciata di 0.87, per il recoater hopping 0.84 e per i recoater strikes 0.80. L’indice di Jaccard per la localizzazione dei difetti è stato altissimo (sopra 0.94 per tutti). Questo significa che non solo troviamo i difetti, ma li localizziamo anche molto bene.

Perché Questo Approccio è Speciale?

Quindi, cosa rende questo sistema diverso e, secondo me, molto promettente?

- È training-free: Niente più bisogno di enormi dataset etichettati. Risparmio di tempo, costi e fatica.

- È adattabile: Non dipende dal materiale specifico, dalla strategia di scansione laser o dalla geometria del pezzo. Funziona e basta. Questo lo rende molto più scalabile rispetto agli approcci AI tradizionali.

- È low-cost e retrofittabile: Usa hardware economico e può essere aggiunto a macchine PBF-LB/M esistenti senza stravolgimenti.

- È interpretabile: Fornisce immagini e dati visivi chiari sulla geometria e sui difetti, facili da capire per un operatore.

- È efficiente: Il tempo di calcolo per analizzare un’immagine è inferiore al tempo necessario per stendere un nuovo strato di polvere e fonderlo, quindi è compatibile con il monitoraggio in tempo reale.

Potrebbe questo sistema sostituire un giorno le costose scansioni CT post-produzione per il controllo dimensionale? È una domanda affascinante. Sicuramente offre un’alternativa in situ, strato per strato, molto più rapida ed economica.

Guardando al Futuro

Certo, non è ancora perfetto. La risoluzione attuale della camera non ci permette di vedere difetti piccolissimi come le porosità interne o micro-cricche. Il prossimo passo sarà sicuramente migliorare la risoluzione e testare il sistema su una gamma più ampia di materiali (titanio, alluminio…) e su diverse macchine.

La vera frontiera, poi, sarà integrare questo monitoraggio in un ciclo di feedback in tempo reale. Immaginate: il sistema rileva un principio di difetto e comunica alla macchina di aggiustare i parametri di stampa (potenza laser, velocità) per correggerlo immediatamente, prima che si propaghi. Questo sì che sarebbe rivoluzionario per migliorare la qualità e ridurre gli scarti!

Insomma, penso che questo approccio “training-free” basato sulla computer vision abbia un potenziale enorme per rendere il controllo qualità nella stampa 3D metallica più accessibile, affidabile ed efficiente. È un passo importante verso una produzione additiva davvero industriale e senza sorprese. E il bello è che siamo solo all’inizio!

Fonte: Springer