Computer Ottici nello Spazio: L’Intelligenza Artificiale che Pensa con la Luce

Ciao a tutti! Avete mai pensato a quanto l’Intelligenza Artificiale (IA), o Machine Learning (ML) se preferite i termini tecnici, stia cambiando il nostro mondo? È ovunque, dalle auto che si guidano da sole alla sanità. Ma c’è un posto dove portare l’IA è una sfida enorme: lo spazio.

Immaginate un satellite lassù, in orbita o magari in viaggio verso Marte. Ha bisogno di “cervello” per elaborare dati, prendere decisioni rapide, diventare più autonomo. Pensate a quanto sarebbe utile poter analizzare immagini della Terra in tempo reale per scovare solo quelle senza nuvole, o permettere a un rover su un altro pianeta di identificare rocce interessanti da solo, senza aspettare ore per le istruzioni da Terra. Il problema? I computer tradizionali, anche quelli super potenti con GPU e TPU, consumano un sacco di energia, scaldano tantissimo e soffrono le radiazioni cosmiche. Per un piccolo satellite, queste sono limitazioni enormi.

La Sfida dell’IA in Orbita

Mandare dati su e giù da un satellite è un vero collo di bottiglia. La banda è limitata e la latenza, specialmente per missioni nello spazio profondo, è pazzesca. Avere un’IA a bordo risolverebbe molti problemi: elaborazione in tempo reale, maggiore autonomia, meno dati inutili da trasmettere. Ci sono stati tentativi pionieristici, come il Remote Agent Experiment (RAX) su Deep Space 1 nel ’99 o l’Autonomous Sciencecraft Experiment (ASE) su Earth Observing One nel 2000. Anche i rover marziani come Curiosity e Perseverance usano sistemi IA come AEGIS per scegliere autonomamente cosa analizzare, ma ci mettono comunque decine o centinaia di secondi per riconoscere una scena, proprio a causa delle risorse di calcolo limitate a bordo.

Le Reti Neurali Artificiali (RNA), e in particolare le Reti Neurali Convoluzionali (CNN) usate per la visione artificiale, si basano su tonnellate di calcoli, soprattutto la famosa Moltiplicazione Vettore-Matrice (VMM). Richiedono hardware specializzato che, come detto, nello spazio è difficile da implementare per via dei requisiti stringenti di energia, controllo termico e resistenza alle radiazioni.

Un Raggio di Luce: Il Calcolo Ottico

E se la soluzione fosse… la luce? Qui entra in gioco la nostra idea, un po’ folle ma affascinante: il calcolo ottico. Invece di usare elettroni che sfrecciano nei circuiti, usiamo fotoni, particelle di luce. Il bello è che operazioni complesse come la VMM possono essere realizzate in modo quasi “passivo” manipolando la luce. Immaginate di moltiplicare attenuando un raggio laser in modo controllato e di sommare sovrapponendo più raggi. Sembra fantascienza, ma funziona!

Ci sono già state dimostrazioni, sia con configurazioni “free-space” (con lenti e specchi, un po’ come il vecchio proiettore di diapositive, ma molto più smart) sia con circuiti fotonici integrati, piccolissimi chip dove la luce viaggia in guide d’onda. Un design classico è il “moltiplicatore di Stanford”, che può fare VMM, convoluzioni e trasformate di Fourier quasi istantaneamente.

I vantaggi? Potenzialmente, un’efficienza energetica pazzesca rispetto all’elettronica, velocità altissime (la luce è veloce, no?) e una resistenza naturale alle radiazioni ionizzanti che affliggono i chip tradizionali. Certo, un computer puramente ottico è ancora lontano; probabilmente parleremo per un po’ di sistemi ibridi, dove l’ottica si occupa dei calcoli più pesanti, affiancata dall’elettronica per il controllo e l’interfaccia. Ma per lo spazio, questa potrebbe essere la svolta.

Il Progetto OMLO: La Nostra Scommessa

Qui alla Technische Universität Berlin (TU-Berlin), abbiamo una lunga storia nella costruzione e gestione di satelliti (ben 30 lanciati negli ultimi 33 anni!). Con il progetto OMLO (Optical Computing for Machine Learning in Orbit), stiamo cercando di trasformare questa visione in realtà. L’obiettivo è progettare e concettualizzare un sistema di calcolo ottico per l’IA che possa volare su uno dei nostri piccoli satelliti, come quelli della famiglia TUBiX (che pesano dai 5 ai 20 kg).

Stiamo sviluppando in parallelo anche un’unità di elaborazione IA più tradizionale basata su componenti commerciali (COTS) nel progetto AITHER, ma OMLO rappresenta l’alternativa rivoluzionaria, quella che punta a sostituire il calcolo elettronico “pesante” con l’ottica.

Il nostro caso d’uso dimostrativo? La classificazione di immagini. Ad esempio, potremmo usarlo per rilevare automaticamente le nuvole nelle foto della Terra scattate da un satellite di osservazione. In questo modo, invieremmo a terra solo le immagini utili, ottimizzando la preziosa banda di comunicazione. Per iniziare e avere un confronto facile, stiamo usando il classico dataset MNIST (cifre scritte a mano), ma il concetto è trasferibile ad applicazioni spaziali reali.

Come Funziona (in Teoria e Pratica)

Il cuore del sistema è la capacità di eseguire la Moltiplicazione Vettore-Matrice (VMM) otticamente (OVMM). Inizialmente pensavamo a una Rete Neurale Convoluzionale (CNN) completamente ottica, ma per ragioni pratiche legate all’hardware che avremo a disposizione (ne parlo tra un attimo), ci stiamo concentrando sull’usare l’ottica per accelerare le operazioni VMM all’interno di una CNN gestita in modo ibrido.

Abbiamo in mente due setup sperimentali:

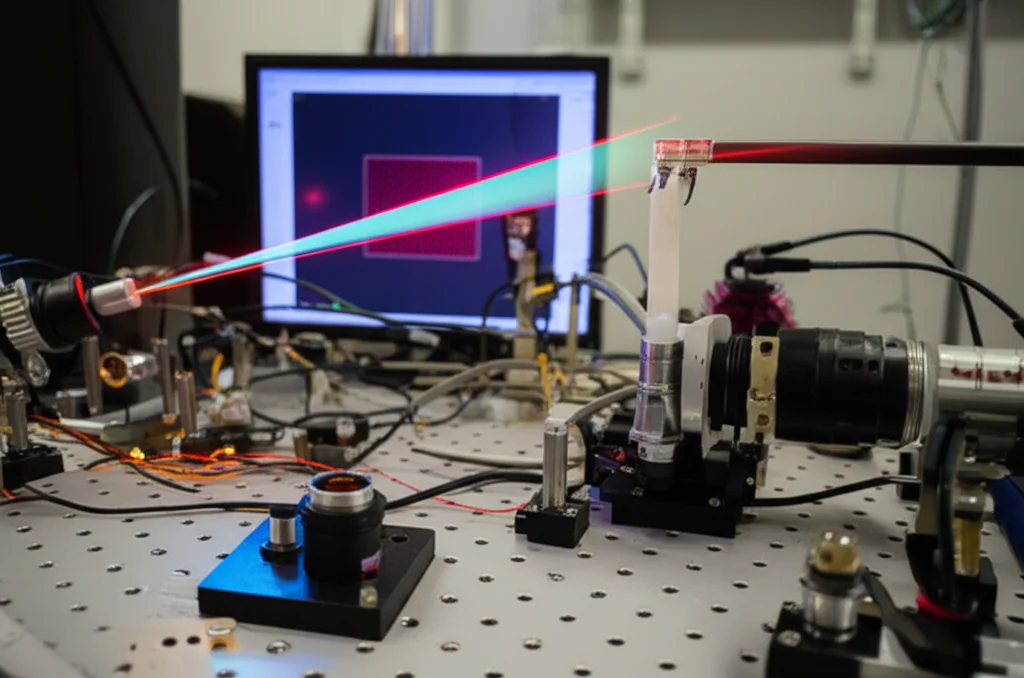

- Setup 1 (Dimostrativo): Usa due Modulatori Spaziali di Luce (SLM). Il primo SLM “codifica” il vettore di input modulando un raggio laser. Il secondo SLM codifica la matrice di trasformazione. La luce che attraversa entrambi viene poi focalizzata da una lente cilindrica su una telecamera (o fotodiodi). La linea di luce catturata è il risultato della moltiplicazione! Semplice ed elegante.

- Setup 2 (Verso l’Integrazione): Qui le cose si fanno interessanti. Sostituiamo il primo SLM (quello per il vettore di input) con dei componenti molto più compatti e adatti allo spazio: dei modulatori ad anello su silicio sviluppati dall’istituto IHP. Questi aggeggi, chiamati ODAC (Optical Digital-to-Analog Converter), convertono un segnale elettrico digitale (3 bit per modulatore nel nostro caso) direttamente in un’intensità luminosa modulata. Ne avremo 4 su un piccolo chip. Questo limita il nostro input a soli 4 valori alla volta, una bella sfida! Il secondo SLM (per la matrice) rimane per ora, ma in futuro cercheremo alternative più integrabili.

Questi ODAC sono una piccola meraviglia: convertono da digitale ad analogico e da elettrico a ottico in un colpo solo, e promettono velocità pazzesche (oltre i 10 GHz!). Per pilotarli serve un’elettronica dedicata, che stiamo progettando come una scheda “payload” compatibile con i nostri bus satellitari TUBiX10. Questa scheda avrà un controller, memoria e un FPGA per gestire i dati ad alta velocità e inviare i segnali agli ODAC.

Adattare l’IA alla Luce (e ai suoi Limiti)

Avere solo 4 canali di input ottici alla volta significa che dobbiamo essere furbi nel gestire i calcoli della CNN.

- Strato Convoluzionale: Invece di processare tutta l’immagine in un colpo solo, usiamo l’approccio classico della “finestra scorrevole”. Prendiamo piccoli blocchi dell’immagine (ad esempio 2×2 pixel), li “appiattiamo” in un vettore di 4 elementi e lo moltiplichiamo otticamente per la matrice dei filtri convoluzionali (che sarà 4×4 nel nostro caso, dove ogni riga è un filtro). Ripetiamo per tutta l’immagine.

- Strato Denso (Fully Connected): Anche qui, se la matrice è grande, dobbiamo spezzettarla. Usiamo un approccio tipo “divide et impera”: dividiamo la grande matrice in sottomatrici 4×4, eseguiamo le OVMM parziali e poi sommiamo i risultati (quest’ultima parte, per ora, la faremo elettronicamente).

Un’altra sfida è la quantizzazione: ogni canale di input degli ODAC accetta solo 3 bit. Questo limita la precisione, ma le nostre simulazioni mostrano che si possono ottenere comunque ottimi risultati.

Primi Risultati e Prospettive Future

Siamo ancora in fase concettuale, ma i primi esperimenti sono incoraggianti. Con un setup simile al primo (due SLM), abbiamo eseguito una OVMM 4×4 con una precisione dell’84.5%. E simulando al computer l’intero processo (con le limitazioni a 4 input e 3 bit) usando TensorFlow sul dataset MNIST, abbiamo raggiunto un’accuratezza del 91.58% dopo poche epoche di addestramento. Non male come punto di partenza!

Certo, la strada è lunga. Dobbiamo costruire e testare i prototipi reali, ottimizzare tutto, affrontare le sfide dell’integrazione tra ottica ed elettronica. L’obiettivo finale è miniaturizzare il più possibile la parte ottica, magari sostituendo anche il secondo SLM con qualcosa di più compatto come array di Interferometri Mach-Zehnder (MZI) e usando fotodiodi veloci al posto della telecamera per catturare il risultato.

Il potenziale, però, è enorme. Sistemi simili hanno già dimostrato velocità nell’ordine dei Tera-MAC al secondo (TMAC/s) con potenze ottiche bassissime. Anche se l’elettronica di contorno consuma, il vantaggio del calcolo ottico cresce esponenzialmente con la dimensione dei problemi (matrici più grandi). C’è un punto in cui, inevitabilmente, l’ottica supererà l’elettronica in termini di efficienza per questi compiti specifici.

Stiamo aprendo una porta su un futuro in cui i satelliti non solo raccolgono dati, ma li capiscono, reagiscono, decidono, grazie a un’intelligenza artificiale che “pensa” alla velocità della luce. È una sfida complessa, ma incredibilmente stimolante. Il futuro dell’esplorazione e dell’utilizzo dello spazio potrebbe essere molto più… luminoso!

Fonte: Springer