Globuli Bianchi e AI: Ho Insegnato alle Macchine a Vedere Come un Esperto!

Ciao a tutti! Oggi voglio parlarvi di qualcosa che mi appassiona da matti: come possiamo usare l’intelligenza artificiale (AI) per dare una mano enorme nel campo medico, in particolare nella classificazione dei globuli bianchi (WBC). Sembra roba tecnica, vero? Ma aspettate, vi racconto tutto in modo semplice e, spero, affascinante!

Perché i Globuli Bianchi sono Così Importanti (e Difficili da Classificare)?

Immaginate i globuli bianchi come i soldati del nostro sistema immunitario. Ce ne sono di diversi tipi (linfociti, neutrofili, eosinofili, monociti, basofili – anche se qui ci concentriamo sui primi quattro) e ognuno ha un compito specifico nel combattere infezioni e malattie. Capire quanti ce ne sono di ogni tipo in un campione di sangue è fondamentale per diagnosticare un sacco di problemi, dalle infezioni alle malattie autoimmuni, fino a cose più serie come la leucemia.

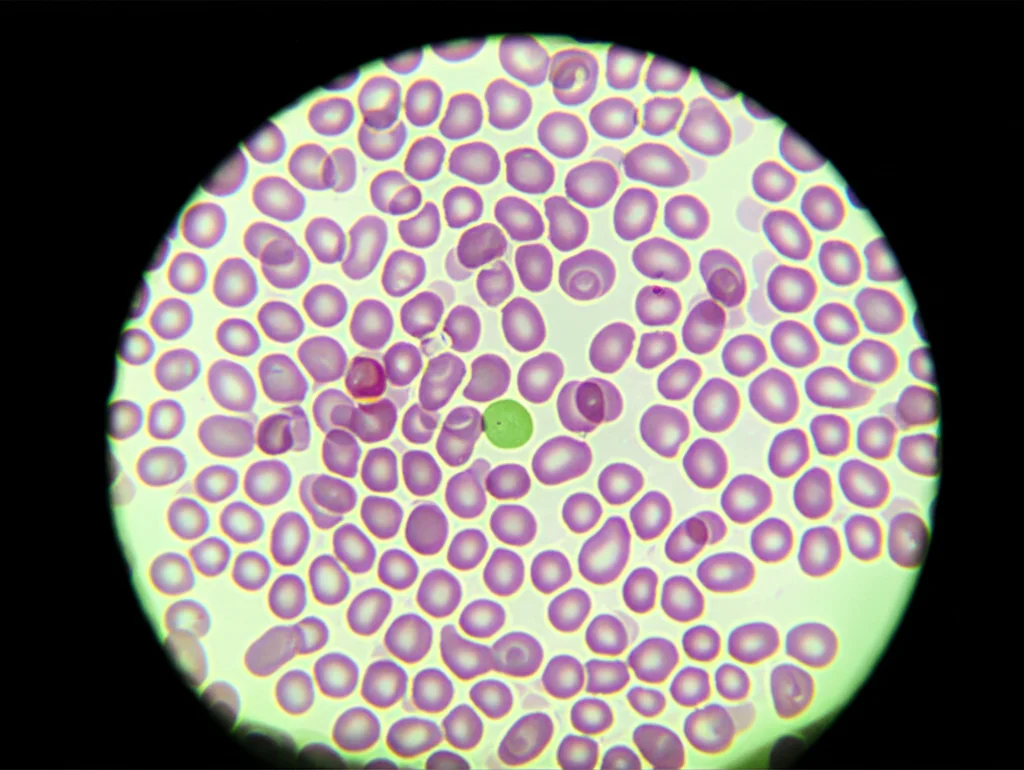

Tradizionalmente, questa analisi la fa un ematologo esperto guardando al microscopio uno striscio di sangue colorato. È un lavoro che richiede occhio, esperienza e… un sacco di tempo! E, diciamocelo, anche l’esperto più bravo può commettere errori o avere giornate no. Qui entra in gioco l’AI.

L’AI ci Prova, Ma Serve un “Boost”

Negli ultimi anni, abbiamo visto tanti tentativi di usare il deep learning – una branca potentissima dell’AI – per automatizzare questa classificazione. Si usano reti neurali convoluzionali (CNN), spesso modelli “pre-addestrati” come Inception V3, DenseNet 121, ResNet 50, MobileNet V2, VGG 16. Questi modelli sono come studenti che hanno già studiato tantissimo su milioni di immagini generiche e poi si specializzano sulle immagini mediche.

Funzionano? Sì, abbastanza bene! Ma c’è un problema comune in medicina: spesso non abbiamo dataset enormi. Aumentare i dati artificialmente (data augmentation) aiuta, ma non migliora la *qualità* dell’informazione. I modelli imparano a riconoscere pattern statistici, ma gli manca qualcosa… la conoscenza del dominio.

La Mia Idea: Insegnare all’AI la “Sapienza” dell’Ematologo

E se potessimo “infondere” nei modelli AI la stessa conoscenza che ha un ematologo? Se potessimo dirgli: “Guarda, un eosinofilo di solito ha dei granuli rosa-arancio e un nucleo bilobato”, oppure “Un linfocita ha poco citoplasma e un nucleo tondo e denso”?

Questa è stata la scintilla! Ho pensato: perché non tradurre queste caratteristiche visive in un formato che l’AI possa capire e usare insieme alle informazioni che estrae dalle immagini?

Abbiamo definito 10 caratteristiche chiave dei globuli bianchi, tipo:

- Presenza di granuli

- Granuli densi rosa

- Granuli densi blu

- Citoplasma sottile

- Citoplasma abbondante

- Nucleo multi-lobato (3-5 lobi)

- Nucleo bilobato

- Nucleo a forma di fagiolo/rene

- Nucleo eccentrico e grande

- Nucleo piccolo/denso/tondo

Per ogni tipo di globulo bianco, abbiamo creato un “vettore di conoscenza”: una sequenza di 1 e 0 (poi trasformati in valori tra 0 e 1 per tenere conto delle variazioni) che indica quali caratteristiche sono presenti. Ad esempio, per l’Eosinofilo è [1,1,0,0,0,0,1,0,0,0] (ha granuli, granuli rosa, nucleo bilobato).

Come Abbiamo Fatto (L’Esperimento)

Ok, l’idea c’è, ma come metterla in pratica? Ecco i passi che abbiamo seguito:

1. Isolare i Globuli Bianchi: Prima di tutto, abbiamo usato una tecnica chiamata “contouring” per “ritagliare” automaticamente i singoli globuli bianchi dalle immagini originali degli strisci di sangue, eliminando i globuli rossi e altri disturbi.

2. Generare la Conoscenza Specifica: Abbiamo addestrato una piccola CNN apposita (l’abbiamo chiamata “knowledge generator”) che, guardando l’immagine del singolo globulo bianco, genera il suo vettore di conoscenza specifico, tenendo conto delle sue peculiarità individuali.

3. Usare i “Cervelloni” Pre-addestrati: Abbiamo preso i nostri modelli famosi (Inception V3, DenseNet 121, ResNet 50, MobileNet V2, VGG 16) e li abbiamo usati per estrarre le caratteristiche “profonde” dall’immagine del globulo bianco. Queste sono le informazioni complesse che l’AI impara da sola guardando tanti dati.

4. Fondere Tutto Insieme: Qui sta il trucco! Abbiamo preso le caratteristiche profonde estratte dal modello pre-addestrato e le abbiamo “concatenate” (unite) con il vettore di conoscenza generato dal nostro “knowledge generator”. Immaginate di mettere insieme due pezzi di un puzzle per avere un quadro più completo.

5. Classificare: Questo vettore “arricchito” è stato poi dato in pasto agli strati finali della rete neurale per decidere a quale classe appartiene il globulo bianco (Eosinofilo, Linfocita, Monocita o Neutrofilo).

Abbiamo testato tutto questo su due dataset: BCCD (più grande, circa 12.500 immagini) e LISC (più piccolo, circa 200 immagini), per vedere come se la cavava il nostro approccio in diverse condizioni.

I Risultati: Ha Funzionato? Eccome!

Ragazzi, i risultati sono stati davvero incoraggianti! Vi do qualche numero per farvi capire.

Prendiamo il dataset BCCD:

- Inception V3: L’accuratezza media è passata da un 82.7% (senza conoscenza) a un incredibile 99.38% (con conoscenza)!

- DenseNet 121: Da 98.8% a 99.05%.

- ResNet 50: Da 98.38% a 99.05%.

- MobileNet V2: Da 98.56% a 98.67%.

- VGG 16: Da 98.5% a 98.75%.

Anche sul dataset LISC (quello piccolo, più difficile) i miglioramenti sono stati netti:

- Inception V3: Da 86.76% a 92.05%.

- DenseNet 121: Da 92.2% a 95.88%.

- ResNet 50: Da 91.76% a 95.58%.

- MobileNet V2: Da 92.8% a 95.2%.

- VGG 16: Da 94.4% a 95.2%.

Non solo l’accuratezza media è migliorata, ma anche altre metriche importanti come precisione, richiamo (recall), specificità e F1-score hanno mostrato miglioramenti significativi, specialmente per i modelli Inception V3 e ResNet 50. Anche le curve AUC-ROC (un modo per misurare quanto bene il modello distingue le classi) sono schizzate verso l’alto, avvicinandosi alla perfezione (valore 1) per molti modelli con conoscenza infusa.

Una cosa super interessante è stata vedere i punteggi di confidenza. A volte, i modelli senza conoscenza aggiuntiva erano poco sicuri o addirittura sbagliavano clamorosamente (tipo classificare un linfocita come neutrofilo con bassa confidenza). Con l’infusione di conoscenza, invece, i modelli diventavano molto più sicuri e precisi nelle loro classificazioni, raggiungendo spesso confidenze vicine al 100%!

Abbiamo anche fatto dei test statistici (t-test) per essere sicuri che i miglioramenti non fossero dovuti al caso. Per Inception V3 e ResNet 50, i risultati hanno confermato con alta probabilità (95% di confidenza) che l’aggiunta di conoscenza ha fatto davvero la differenza. Per DenseNet 121, MobileNet V2 e VGG 16, i miglioramenti c’erano ma non erano statisticamente così marcati, probabilmente a causa delle loro architetture specifiche (DenseNet è già bravo a riutilizzare le feature, MobileNet è pensato per essere leggero, VGG 16 ha altri vincoli).

Infine, abbiamo confrontato i nostri risultati con altri studi recenti che usano tecniche diverse sugli stessi dataset. Beh, i nostri modelli “potenziati” dalla conoscenza si sono dimostrati altamente competitivi, spesso superando gli altri in termini di accuratezza complessiva e bilanciamento tra le varie metriche.

Perché Tutto Questo è Importante?

Ok, tanti numeri e tecnicismi, ma alla fine della fiera, che significa? Significa che abbiamo trovato un modo promettente per rendere i sistemi automatici di classificazione dei globuli bianchi più efficienti, accurati e affidabili. Questo può tradursi in:

- Diagnosi più rapide e precise per i pazienti.

- Minore carico di lavoro per gli ematologi, che possono concentrarsi sui casi più complessi.

- Riduzione degli errori umani.

- Un aiuto concreto nella diagnosi precoce di malattie importanti.

Cosa Ci Riserva il Futuro?

Ovviamente, questo è solo l’inizio! Ci sono tante direzioni da esplorare:

- Includere altre caratteristiche dei globuli bianchi nel nostro vettore di conoscenza (texture, morfologia più avanzata…).

- Rendere il nostro “knowledge generator” più efficiente dal punto di vista computazionale.

- Creare un modello “decision fusion” che combini le previsioni dei nostri cinque modelli potenziati per essere ancora più robusto.

- Usare questi modelli potenziati non solo per classificare, ma anche per estrarre feature “intelligenti” da dare in pasto ad altri algoritmi di machine learning.

Insomma, la strada è aperta e le possibilità sono tante. Credo fermamente che combinare la potenza bruta del deep learning con la conoscenza specifica del dominio sia la chiave per sbloccare il vero potenziale dell’AI in medicina e in tanti altri campi. È stato un viaggio affascinante finora e non vedo l’ora di vedere dove ci porterà!

Fonte: Springer