AI Detective della Natura: Come Reti Neurali e Modelli Ecologici Svelano i Segreti degli Animali

Ciao a tutti! Oggi voglio parlarvi di qualcosa che mi affascina tantissimo: l’incontro tra tecnologia all’avanguardia e il mondo selvaggio che ci circonda. Immaginate di poter usare l’intelligenza artificiale non solo per riconoscere volti o consigliare film, ma per aiutare a proteggere la biodiversità del nostro pianeta. Sembra fantascienza? Eppure, è proprio quello che sta succedendo grazie alla combinazione di due strumenti potentissimi: le reti neurali profonde (DNN) e i modelli di distribuzione delle specie (SDM). Recentemente mi sono imbattuto in una revisione sistematica che esplora proprio questo connubio, e voglio condividere con voi le scoperte più interessanti.

Identikit Digitale: Le Reti Neurali Riconoscono gli Animali

Partiamo dalle basi. Classificare automaticamente le specie animali è una sfida enorme, ma di fondamentale importanza ecologica. Pensateci: sapere esattamente quale specie si trova in una determinata area ci permette di monitorare animali a rischio estinzione, individuare specie invasive prima che facciano troppi danni, o persino capire dove reintrodurre specie protette dopo disastri ambientali. Non solo, monitorare gli animali selvatici è cruciale anche per la nostra salute, per identificare potenziali malattie zoonotiche (come la febbre gialla) che potrebbero passare all’uomo.

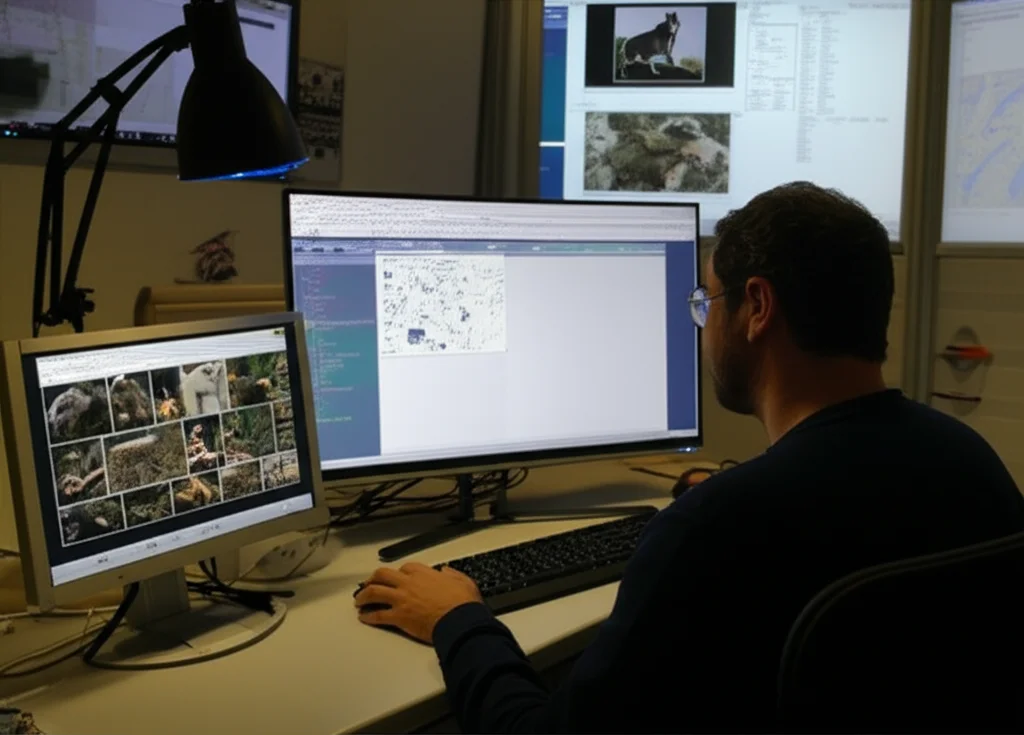

Qui entrano in gioco le reti neurali profonde, in particolare le Reti Neurali Convoluzionali (CNN). Se avete uno smartphone che riconosce oggetti nelle foto, state già usando una tecnologia simile. Le CNN sono diventate incredibilmente brave a classificare immagini. Grazie all’enorme quantità di foto scattate da fototrappole, ricercatori e persino cittadini comuni con i loro smartphone (la cosiddetta citizen science!), abbiamo a disposizione una mole gigantesca di dati per “addestrare” queste reti a riconoscere un animale da una semplice foto. È come insegnare a un computer a diventare un esperto naturalista! Le CNN imparano a riconoscere pattern, forme, colori, texture… tutti quei dettagli che un occhio esperto userebbe per identificare una specie.

Dove Vivono? I Modelli di Distribuzione delle Specie

Ma identificare l’animale è solo una parte della storia. Altrettanto importante è capire dove vive, quali sono le sue aree di distribuzione e le condizioni ambientali ideali per la sua sopravvivenza. Qui intervengono i Modelli di Distribuzione delle Specie (SDM), noti anche come modelli di nicchia ecologica (ENM). Questi modelli sono un classico dell’ecologia. Prendono le coordinate geografiche dove una specie è stata avvistata e le combinano con una miriade di dati ambientali: clima (temperatura, precipitazioni), altitudine, tipo di suolo, copertura vegetale, profondità dell’acqua… tutto ciò che può influenzare la presenza di un animale.

Il risultato? Una mappa di probabilità che ci dice quanto è probabile trovare quella specie in una determinata area. Gli SDM sono fondamentali per prevedere gli effetti dei cambiamenti climatici sulla fauna, identificare aree a rischio di invasione da specie aliene, capire la storia evolutiva delle specie e guidare decisioni cruciali per la conservazione.

L’Unione Fa la Forza: Integrare Immagini e Contesto

E se vi dicessi che possiamo rendere entrambi questi approcci ancora più potenti mettendoli insieme? È questa l’idea rivoluzionaria che sta emergendo. Pensateci: una CNN può essere bravissima a riconoscere un uccello da una foto, ma potrebbe confondersi tra due specie molto simili. Un SDM, d’altro canto, sa che una certa specie di uccello vive solo in alta montagna. Se combiniamo le informazioni, il quadro diventa molto più chiaro! Se la foto è stata scattata in pianura, il modello integrato “saprà” che è molto più probabile che si tratti della specie A (che vive in pianura) piuttosto che della specie B (che vive solo in montagna), anche se visivamente sono quasi identiche.

Questa revisione sistematica ha analizzato proprio gli studi che tentano questa integrazione. Sorprendentemente, anche se sia le CNN per immagini che gli SDM sono campi in crescita esponenziale dagli anni 2000, i lavori che li combinano specificamente per la classificazione animale sono ancora pochi (solo 13 studi identificati su oltre 700 iniziali!). Questo ci dice che siamo agli albori di un campo con un potenziale enorme.

Come Funziona l’Integrazione?

Ma come avviene concretamente questa fusione? I metodi visti finora sono relativamente semplici, ma efficaci.

- Alcuni approcci prendono le probabilità fornite dalla CNN (quanto è sicura che l’immagine sia della specie X, Y o Z) e le combinano con le probabilità fornite dall’SDM (quanto è probabile trovare la specie X, Y o Z in quel luogo specifico). Ad esempio, si possono moltiplicare le probabilità o assegnare dei pesi diversi a seconda dell’affidabilità di ciascun modello.

- Altri utilizzano l’output di entrambi i modelli come input per un ulteriore strato di rete neurale, che impara a prendere la decisione finale basandosi su entrambe le fonti di informazione.

L’idea di fondo è sfruttare i punti di forza di ciascun approccio mitigandone le debolezze. Le CNN eccellono nei dettagli visivi, ma non conoscono il contesto geografico. Gli SDM conoscono il contesto, ma non vedono l’animale. Insieme, offrono una visione molto più completa e accurata.

Dati, Dati Ovunque… Ma con Qualche Problema

Ovviamente, tutto questo funziona solo se abbiamo i dati giusti. E qui iniziano le sfide. Le fonti di dati sono incredibilmente varie:

- Citizen Science: Piattaforme come iNaturalist o eBird raccolgono milioni di osservazioni da appassionati di natura in tutto il mondo, spesso complete di foto e coordinate GPS precise. Una risorsa preziosissima!

- Fototrappole: Dispositivi automatici che scattano foto quando un animale passa davanti, fondamentali per monitorare la fauna selvatica in modo non invasivo.

- Musei e Archivi: Contengono dati storici, a volte vecchi di decenni, che possono includere esemplari fisici, foto e note sulla località.

- Social Network e Web: Anche Flickr o altre piattaforme possono contenere immagini georeferenziate utili, anche se richiedono più lavoro di filtraggio.

- Dati Satellitari: Forniscono informazioni sulla copertura del suolo, vegetazione, altitudine, clima, essenziali per gli SDM.

Tuttavia, questi dati presentano delle sfide comuni:

- Squilibrio (Imbalance): Spesso abbiamo tantissime foto di specie comuni e pochissime di specie rare. Questo può “ingannare” i modelli, rendendoli bravissimi a riconoscere le specie comuni ma pessimi con quelle rare (che magari sono proprio quelle che ci interessano di più per la conservazione!).

- Qualità e Rumore: Le foto possono essere sfocate, scattate di notte, l’animale può essere parzialmente nascosto. Le coordinate GPS possono essere imprecise. Le identificazioni fatte dai cittadini potrebbero essere errate. Serve un grande lavoro di pulizia e pre-elaborazione dei dati.

- Dati Mancanti: Molte foto non hanno coordinate GPS associate, rendendole inutilizzabili per i modelli integrati. Spesso mancano dati sull'”assenza” di una specie, che sarebbero utili agli SDM.

- Informazioni Biologiche Limitate: Dati su interazioni tra specie, competizione, o dettagli fisiologici sono rari ma potrebbero migliorare notevolmente i modelli.

Quali Informazioni Contestuali Contano Davvero?

La bellezza dei modelli integrati sta proprio nell’usare il contesto. Ma quale contesto? Gli studi analizzati ne usano di diversi tipi:

- Coordinate Geografiche: La base di tutto. Latitudine e longitudine.

- Dati Climatici: Temperatura media, precipitazioni annuali, stagionalità (spesso dalle banche dati WorldClim).

- Altitudine: Fondamentale per specie che vivono solo a certe quote.

- Copertura del Suolo/Habitat: Informazioni derivate da mappe o immagini satellitari (foresta, prateria, area urbana, corpo idrico…).

- Dati Biologici/Tassonomici: Alcuni studi usano la tassonomia (relazioni di parentela tra specie) o caratteristiche anatomiche per distinguere specie molto simili (es. pesci con pattern quasi identici).

- Metadati delle Osservazioni: Specialmente da citizen science, si può usare la data/ora dell’osservazione, l’esperienza dell’osservatore, note testuali associate all’immagine.

- Semantica: Estrarre informazioni testuali associate alle immagini (es. tag o commenti su Flickr che descrivono l’ambiente: “spiaggia”, “foresta”, “città”).

Ad esempio, uno studio sulle coccinelle nel Regno Unito ha usato, oltre alle immagini e alla posizione, informazioni sull’habitat, la temperatura giornaliera e persino l’esperienza della persona che ha caricato la foto! Un altro studio sulle libellule giapponesi ha combinato foto da web scraping, scansioni da libri e dati museali. Lavori sui Galliformi cinesi hanno evidenziato l’importanza dell’altitudine. Ogni contesto aggiunge un pezzo al puzzle.

Le Sfide da Superare

Nonostante i progressi entusiasmanti, la strada è ancora lunga. La revisione evidenzia alcune sfide chiave:

- La Scarsità di Dati Completi: Trovare dataset che abbiano contemporaneamente immagini di buona qualità, coordinate precise e informazioni ambientali dettagliate è difficile, limitando spesso gli studi a regioni specifiche.

- Metodi di Integrazione Semplici: Le attuali tecniche di combinazione dei modelli sono spesso basilari e potrebbero non sfruttare appieno le potenzialità di ciascun approccio. Serve ricerca su metodi di integrazione più sofisticati.

- Gestione dello Squilibrio e del Rumore: Continuano a essere problemi centrali che richiedono tecniche avanzate di pre-processing e data augmentation (creare artificialmente nuove immagini variando quelle esistenti: rotazioni, zoom, cambi di luminosità…).

- Mancanza di Informazioni Biologiche Dettagliate: Integrare dati su dieta, comportamento, interazioni tra specie potrebbe fare un salto di qualità, ma questi dati sono difficili da ottenere su larga scala.

Uno Sguardo al Futuro

Cosa ci riserva il futuro? Le prospettive sono davvero stimolanti!

- Banche Dati Integrate: La creazione di grandi database pubblici che combinino immagini, geolocalizzazione e dati ambientali/biologici standardizzati sarebbe un enorme passo avanti per la comunità scientifica.

- Integrazione più Profonda: Sviluppare architetture di deep learning che possano processare nativamente sia i dati visivi che quelli contestuali (geografici, ambientali, biologici) in modo più organico.

- Sfruttare la Semantica e la Tassonomia: Utilizzare tecniche di Natural Language Processing (NLP) per estrarre informazioni da note testuali e integrare la conoscenza tassonomica e biologica (magari tramite knowledge graphs) direttamente nei modelli.

- Citizen Science Potenziata: Continuare a coinvolgere il pubblico, migliorando gli strumenti per la raccolta dati e la validazione delle osservazioni.

- Nuove Tecnologie AI: Esplorare il potenziale di tecniche emergenti come i Large Language Models (LLM) anche per l’analisi contestuale delle immagini naturalistiche.

In conclusione, l’integrazione tra classificazione di immagini tramite deep learning e modellistica ecologica della distribuzione delle specie è un campo di ricerca giovane ma incredibilmente promettente. Sta aprendo nuove strade per comprendere e proteggere la straordinaria biodiversità del nostro pianeta. Certo, le sfide non mancano, soprattutto legate alla disponibilità e qualità dei dati, ma i progressi tecnologici e il crescente contributo della citizen science ci fanno ben sperare. È affascinante vedere come l’intelligenza artificiale, spesso vista come qualcosa di astratto, possa diventare uno strumento concreto e potente nelle mani di ecologi e conservazionisti per studiare e salvaguardare il mondo naturale. E io non vedo l’ora di scoprire cosa ci riserveranno i prossimi sviluppi!

Fonte: Springer