ChatGPT in Corsia? La Mia Verità sull’Apprendimento dell’Urologia (e Non Solo!)

Ragazzi, parliamoci chiaro. Da quando l’intelligenza artificiale ha fatto capolino nelle nostre vite, e in particolare da quando ChatGPT è diventato il fenomeno che tutti conosciamo, una domanda mi ronza in testa: ma questi strumenti possono davvero rivoluzionare il modo in cui impariamo, specialmente in campi complessi come la medicina? E se sì, come? Beh, da curioso quale sono, ho voluto vederci più da vicino, e quello che ho scoperto sull’apprendimento dell’urologia potrebbe sorprendervi.

L’Esperimento: Mettere alla Prova ChatGPT e la Vecchia Scuola

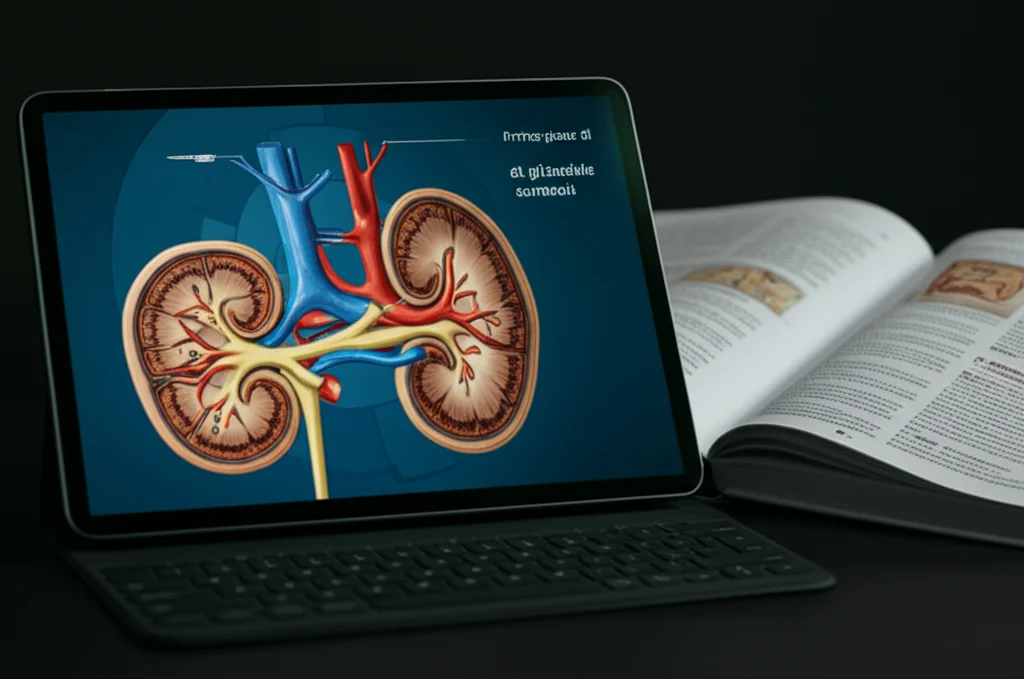

Immaginatevi un gruppo di 121 studenti di medicina, tutti al terzo o quarto anno, belli freschi e senza una precedente infarinatura formale di urologia. Li abbiamo presi e, un po’ come si fa con gli esperimenti seri, li abbiamo divisi a caso in tre “classi” con metodi di apprendimento diversi. Il tema? Le ghiandole surrenali, estratto a sorte da un tomo sacro dell’urologia, il “Campbell-Walsh Urology”. Mica pizza e fichi!

Ecco i tre gruppi:

- Team ChatGPT Puro: 41 studenti hanno avuto 90 minuti per studiare l’argomento ponendo domande direttamente a ChatGPT 3.5. Un’esplorazione autonoma, un po’ come perdersi nei meandri di internet, ma con una guida AI.

- Team Lezione Tradizionale: 39 studenti si sono goduti (si fa per dire!) una classica lezione frontale di 90 minuti, con slide e spiegazioni preparate da un professore associato di urologia. Il buon vecchio metodo, insomma.

- Team Ibrido (ChatGPT + Lezione): Gli ultimi 41 fortunati hanno iniziato con ChatGPT e poi hanno consolidato il tutto con la lezione frontale, sempre per un totale di 90 minuti. Il meglio dei due mondi? Vedremo!

Per rendere le cose ancora più “scientifiche”, lo studio era in triplo cieco: né gli studenti, né chi valutava i test, né l’analista statistico sapevano chi fosse in quale gruppo fino alla fine. E il professore? Ha saputo l’argomento solo due settimane prima, giusto il tempo per preparare la lezione. Ah, un dettaglio succoso: il prof ha provato a usare ChatGPT 4.0 per creare immagini e materiale multimediale per la sua lezione. Tenete a mente questo particolare, perché ci torneremo.

Il Momento della Verità: I Risultati del Test

Dopo la fase di apprendimento, tutti sotto con un test da trenta domande, pescate da un altro testo di riferimento, il “Campbell-Walsh-Wein Urology Twelfth Edition Review”. Domande che spaziavano dall’anatomia alla fisiologia, dalle patologie ormonali a quelle neoplastiche, fino alla chirurgia e ai casi clinici. Un bel frullato di urologia!

E qui viene il bello. Chi pensate abbia fatto meglio?

I risultati parlano chiaro: il punteggio mediano più alto lo hanno ottenuto gli studenti del Team Ibrido (ChatGPT + Lezione), con una media di 12 risposte corrette, significativamente meglio di quelli del Team ChatGPT Puro, fermi a 10 (p=0.007). Questa differenza è rimasta solida come una roccia anche considerando l’anno di corso, il genere e la precedente esperienza con ChatGPT. Anzi, l’analisi multivariata ha stimato un vantaggio di 2.6 punti per il gruppo combinato rispetto al solo ChatGPT.

Non solo: per circa il 70% delle domande, la percentuale di risposte corrette era più alta nel gruppo ChatGPT + Lezione rispetto agli altri due. Interessante, no? Sembra che ChatGPT, da solo, perda un po’ del suo smalto se non c’è una base di conoscenza pregressa o una guida.

Perché l’Unione Fa la Forza (e ChatGPT da Solo Arranca)

Questi risultati, amici miei, sono una vera chicca, perché è la prima volta che si testa formalmente questa ipotesi. Molti studi hanno messo alla prova ChatGPT con domande di esami universitari o test di abilitazione medica, e spesso ne è uscito bene, rispondendo con accuratezza. Ma una cosa è rispondere a domande, un’altra è *imparare* un argomento da zero.

Il nostro studio ha mostrato che, sebbene ChatGPT abbia un potenziale enorme per lo studio autodiretto e per stimolare il pensiero critico, la lezione tradizionale, quando si tratta di costruire una base solida, sembra ancora più efficace del solo chatbot. E questo è in linea con altre analisi critiche.

Il punto cruciale, che anche altri studi recenti stanno evidenziando, è la distinzione tra conoscenza fattuale e pensiero clinico critico. I modelli linguistici attuali, per quanto avanzati, faticano ancora con il ragionamento basato sul contesto. Questo rafforza un’idea chiave emersa anche dal nostro lavoro: ChatGPT è uno strumento promettente, ma la sua efficacia educativa resta limitata senza una guida strutturata o una solida base teorica.

Quando abbiamo combinato ChatGPT con la lezione tradizionale, abbiamo visto un decollo. Perché? Probabilmente perché l’approccio ibrido sfrutta la motivazione intrinseca dello studente e i metodi di apprendimento indipendente (come l’uso di ChatGPT) ma li incanala e li consolida grazie alla struttura e alla guida della lezione tradizionale. È come avere una mappa e una bussola (ChatGPT) e poi una guida esperta (il docente) che ti aiuta a interpretare il terreno.

I Limiti dell’AI: Quando ChatGPT “Allucina”

E qui torniamo al tentativo del nostro professore di usare ChatGPT 4.0 per creare materiale didattico. Ricordate? Beh, è stato un mezzo disastro. Nonostante il prompt dettagliato per generare illustrazioni anatomicamente accurate, i risultati sono stati deludenti: immagini prive di validità scientifica, con testi pieni di errori grammaticali o contenuti senza senso. ChatGPT stesso descriveva le immagini come “scientificamente accurate”, ma la realtà era ben diversa.

Questo fenomeno, noto come “allucinazione” (quando l’AI inventa informazioni false), è un limite ben conosciuto. E sottolinea una cosa fondamentale: la supervisione umana e la capacità di analisi critica sono ancora imprescindibili. Non possiamo fidarci ciecamente.

Altri studi confermano questa variabilità nell’affidabilità e nella qualità delle risposte dei chatbot, evidenziando la necessità di conoscenze pregresse o di una supervisione. C’è ancora molta strada da fare per capire appieno il ruolo dei chatbot nell’autoapprendimento e l’impatto dell’accuratezza e della chiarezza delle loro risposte.

Cosa ci Portiamo a Casa?

Il nostro studio, pur con i suoi limiti (una fase di apprendimento breve e la mancanza di un test ripetuto a distanza), ci dice cose importanti.

Primo: ChatGPT ha un potenziale altissimo nell’apprendimento, sia per chi insegna sia per chi impara.

Secondo: Usato da solo, senza una base di conoscenze o una guida, mostra i suoi limiti. La affidabilità scientifica non è sempre garantita e il ruolo del docente resta cruciale.

Terzo, e più importante: L’apprendimento “misto” (blended learning), che combina ChatGPT e la lezione tradizionale, non solo è possibile, ma è auspicabile! Porta a risultati più efficaci rispetto al metodo tradizionale da solo e, soprattutto, permette un uso più critico e consapevole del chatbot.

Insomma, non si tratta di scegliere tra l’uomo e la macchina, ma di trovare il modo migliore per farli collaborare. L’AI può essere un assistente formidabile, uno strumento per personalizzare l’apprendimento, per esplorare, per stimolare la curiosità. Ma la guida, l’esperienza e il pensiero critico di un buon insegnante, quelli, amici miei, non credo che verranno sostituiti tanto presto. E forse è un bene così.

Fonte: Springer