L’Inganno dei Campioni Negativi: Come il Machine Learning Può Sbagliare nelle Reti Biomolecolari (e Come Possiamo Aiutarlo!)

Amici scienziati e appassionati di biologia computazionale, sedetevi comodi perché oggi vi racconto una storia che ha dell’incredibile, ma che è cruciale per chiunque lavori con il machine learning (ML) nel nostro campo. Parliamo di come, a volte, i nostri sofisticati modelli di ML possano essere tratti in inganno, soprattutto quando cercano di predire le interazioni nelle complesse reti biomolecolari. E, cosa più importante, vi svelerò come abbiamo cercato di rimettere le cose in carreggiata!

Il Fascino (e le Insidie) del Machine Learning in Biologia

Non c’è dubbio: il machine learning ha rivoluzionato il modo in cui affrontiamo problemi biologici complessi. Dalla predizione delle interazioni tra proteine e lncRNA, tra proteina e proteina, fino alle interazioni farmaco-bersaglio, l’ML sembrava la bacchetta magica. Pubblicazioni su pubblicazioni mostravano performance strabilianti sui dati di test. Ma, diciamocelo francamente, quanti di questi risultati si traducevano poi in un reale successo negli esperimenti “wet-lab”, quelli in laboratorio per intenderci? Pochi, troppo pochi. E allora una domanda sorge spontanea: abbiamo forse sovrastimato le capacità di questi metodi computazionali? E se sì, perché?

Studi precedenti avevano già sollevato qualche sopracciglio, suggerendo che le performance mirabolanti, specialmente nella predizione delle interazioni proteina-proteina, potessero essere un po’ gonfiate. Si era notato, ad esempio, che strategie diverse di campionamento dei dati “negativi” (cioè, coppie di molecole che non interagiscono) portavano a risultati molto diversi. Nonostante questi campanelli d’allarme, molti lavori recenti continuavano a riportare stime eccessivamente ottimistiche. Era chiaro che bisognava scavare più a fondo.

Il Nocciolo del Problema: il Campionamento Negativo e le Reti “Scale-Free”

Nel nostro lavoro, abbiamo esaminato attentamente l’intero processo di sviluppo dei modelli ML che prendono in input coppie di molecole. E indovinate un po’? Abbiamo scoperto che gran parte della sovrastima delle performance deriva proprio dalle procedure di campionamento negativo. Vedete, per addestrare un modello ML supervisionato, servono sia esempi positivi (interazioni reali) sia negativi. Ma in biologia, mentre gli esempi positivi sono spesso verificati sperimentalmente, quelli negativi scarseggiano. Quindi, che si fa? Si campionano casualmente coppie di molecole che non risultano interagire nel nostro network conosciuto.

Qui entra in gioco una caratteristica intrinseca di molte reti biologiche: la proprietà “scale-free”. Immaginate un social network: ci sono poche persone con tantissimi amici (gli “hub”) e tantissime persone con pochi amici. Le reti biologiche sono simili! Alcune molecole (nodi) hanno una miriade di connessioni, mentre la maggior parte ne ha pochissime. Quando campioniamo casualmente i negativi, finiamo per avere una distribuzione del “grado” (numero di connessioni) molto diversa tra campioni positivi e negativi. I positivi tendono ad avere gradi più alti. E il modello ML, furbetto, cosa impara? Impara questa differenza basata sul grado, invece di concentrarsi sulle reali caratteristiche intrinseche delle molecole! In pratica, il modello dice: “Ah, questa coppia ha nodi con tanti collegamenti? Allora probabilmente interagiscono!”. Un po’ troppo semplicistico, non trovate?

Questo significa che i modelli ML ben addestrati con campionamento casuale tendono a predire le interazioni basandosi quasi esclusivamente sul grado dei nodi. Diventa quindi difficile per loro imparare rappresentazioni molecolari uniche o caratteristiche del grafo, che sono spesso il fulcro delle nuove metodologie proposte. Un bel problema, perché ci illudiamo che il modello stia capendo la “chimica” dell’interazione, quando in realtà sta solo contando le connessioni!

La Nostra Indagine: Mettere alla Prova i Modelli

Per vederci chiaro, abbiamo preso in esame tre tipi comuni di interazioni proteina-molecola: lncRNA-proteina, proteina-proteina e farmaco-bersaglio. Abbiamo usato diversi dataset e tre metodi di ML:

- Noise-RF: un modello “ingenuo” in cui le molecole sono rappresentate da rumore casuale, per vedere quanto la topologia di rete da sola influenzi le predizioni.

- Seq-RF: un modello che usa caratteristiche estratte dalle sequenze molecolari, simile a molti approcci tradizionali.

- Seq-Deep: un modello basato su deep learning, che estrae automaticamente le feature dalle sequenze.

Inizialmente, abbiamo usato il campionamento casuale per generare i negativi. I risultati della validazione “transduttiva” (dove i nodi del set di test possono essere presenti anche nel set di training) erano ottimi, persino per Noise-RF! Questo confermava i nostri sospetti: i modelli stavano sfruttando la disparità nella distribuzione del grado. Le coppie con gradi alti ricevevano punteggi di interazione alti, quelle con gradi bassi, punteggi bassi. Un confine netto che il modello imparava facilmente.

Ma la vera prova del nove è la validazione “induttiva”. Abbiamo diviso i dati in modo più stringente, creando set di test (chiamati C1, C2, C3) con diversi livelli di “novità” rispetto al training set. C1 conteneva coppie i cui componenti erano entrambi già visti nel training; C2 coppie con un solo componente visto; e C3 coppie completamente nuove. E qui, le cose sono cambiate drasticamente! Le performance crollavano passando da C1 a C3. Per Noise-RF su C3, le predizioni erano praticamente casuali. Questo ci diceva che, tolta l’informazione sulla topologia di rete, il modello non sapeva che pesci pigliare. Anche per Seq-RF e Seq-Deep, la capacità di generalizzare su dati completamente nuovi (C3) era molto inferiore a quanto suggerito dalla validazione transduttiva. Era evidente: l’addestramento era dominato dalla distribuzione implicita del grado della rete, non dalle rappresentazioni molecolari.

Una Soluzione Semplice ma Efficace: il Campionamento DDB

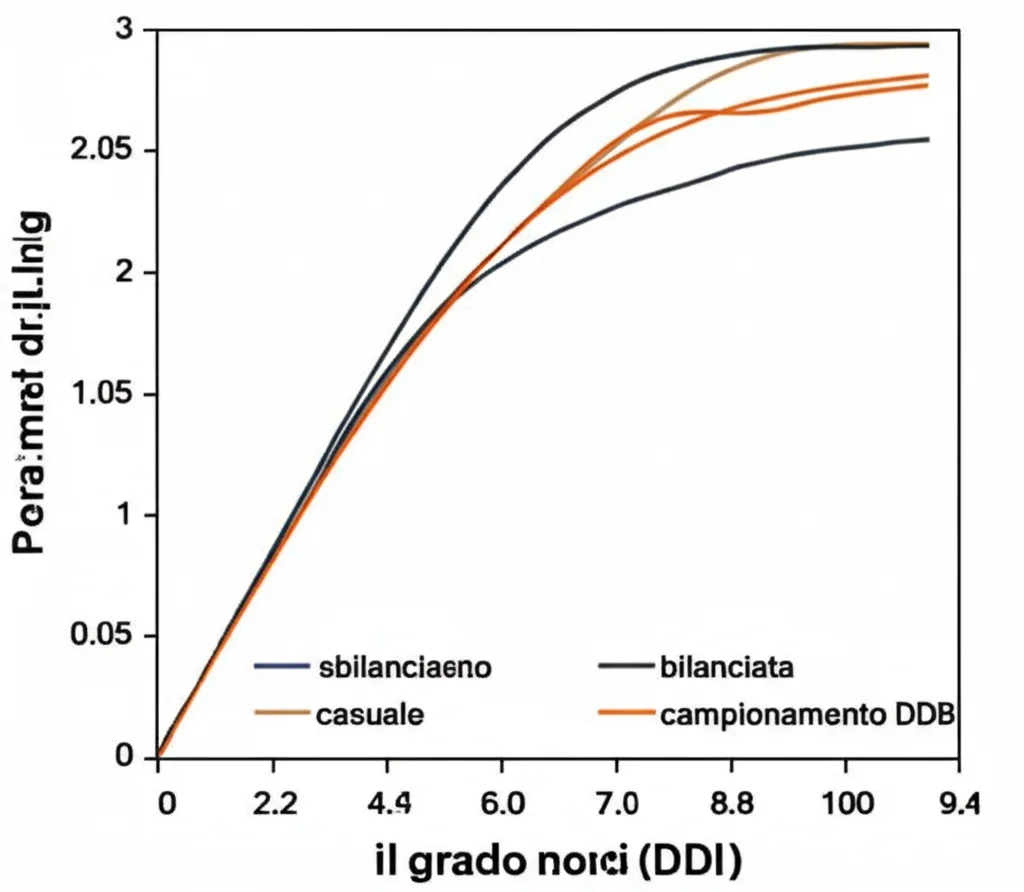

Se il problema è la disparità nella distribuzione del grado, la soluzione potrebbe essere… bilanciarla! Abbiamo quindi proposto una strategia di campionamento negativo semplice ma potente, che abbiamo chiamato Degree Distribution Balanced (DDB). L’idea è di generare campioni negativi in modo che la loro distribuzione del grado sia il più simile possibile a quella dei campioni positivi. In pratica, per ogni coppia positiva, cerchiamo una coppia non interagente che abbia una somma dei gradi dei suoi nodi simile.

E cosa succede quando usiamo il DDB per addestrare i modelli? La correlazione tra i punteggi predetti e il grado dei campioni si riduce significativamente! Fantastico! Però, c’è un “ma”: anche le performance generali dei modelli, misurate con metriche classiche come l’AUC, tendono a diminuire. Questo non è necessariamente un male. Anzi! Il vincolo DDB aiuta i modelli ML a concentrarsi sui pattern interattivi molecolari intrinseci, piuttosto che sulla topologia di rete. Rivela la loro “vera” capacità di apprendere dalle caratteristiche molecolari, come le informazioni di sequenza.

Infatti, confrontando i modelli addestrati con DDB sui set C1, C2 e C3, abbiamo notato che il divario di performance tra i modelli basati su sequenza (Seq-RF, Seq-Deep) e il modello “topologico” (Noise-RF) si allargava. Questo dimostra ulteriormente che il vincolo DDB smaschera la capacità dei modelli di apprendere realmente le relazioni di interazione dalle caratteristiche intrinseche delle molecole. Certo, le performance generali calano perché, diciamocelo, la topologia di rete, pur non essendo una feature molecolare intrinseca, contiene informazioni che aiutano il modello a ottenere risultati migliori, anche se in modo “superficiale”. Dipende da cosa vogliamo: se l’obiettivo è predire interazioni basandosi esclusivamente sulle proprietà molecolari, allora escludere l’influenza della topologia è fondamentale per una valutazione più oggettiva.

Altre Caratteristiche e l’Effetto DDB

Oltre al grado, ci sono altre informazioni che possono influenzare la selezione dei campioni negativi o l’addestramento del modello. Alcune derivano dalla struttura topologica della rete (come la distanza del cammino minimo tra due nodi), altre dalle caratteristiche funzionali delle biomolecole (come la localizzazione subcellulare o la similarità Gene Ontology – GO).

Abbiamo osservato una forte correlazione tra il grado di un campione e la distanza del cammino minimo tra i due nodi che lo compongono. Invece, né la localizzazione subcellulare né la similarità GO mostravano un legame chiaro con la distribuzione del grado. Il metodo DDB, influenzando il grado dei campioni nei dati di training, distruggeva la forte correlazione tra le predizioni del modello e la distribuzione del grado nel set di test (quando si usava campionamento negativo casuale per il test). Questo effetto si rifletteva anche sulla distanza del cammino minimo tra i nodi del campione.

Cosa Abbiamo Imparato e Dove Andiamo Ora?

Il nostro studio mette in luce una sfida cruciale: l’impatto della topologia di rete sulle predizioni dei modelli ML. I modelli, specialmente quelli che usano campionamento negativo casuale, spesso imparano a predire le interazioni basandosi sulla struttura della rete piuttosto che sulle caratteristiche molecolari intrinseche. Questo introduce un bias sostanziale che distorce la valutazione dei modelli.

L’introduzione del metodo di campionamento DDB offre una soluzione per mitigare questo bias. Allineando la distribuzione del grado dei campioni negativi con quella dei positivi, riduciamo la correlazione tra punteggi predetti e grado del nodo. Questo rivela la vera capacità dei modelli ML di apprendere pattern di interazione dalle feature intrinseche. Tuttavia, questa “pulizia” può portare a una diminuzione delle performance predittive generali, perché si rimuove informazione topologica che, seppur confondente, i modelli sfruttavano.

Quindi, che fare? Se l’obiettivo è capire se un modello sta veramente imparando la “biologia” dell’interazione dalle sequenze o da altre proprietà molecolari, allora il DDB è uno strumento prezioso per una valutazione più equa. Se invece la topologia di rete è considerata una feature valida per un compito specifico, allora la sua esclusione potrebbe non essere desiderabile.

Per il futuro, ci sono diverse strade promettenti:

- Integrare dataset più ampi e di qualità superiore.

- Incorporare feature molecolari aggiuntive (modifiche post-traduzionali, affinità di legame, ecc.).

- Considerare le dinamiche temporali delle interazioni.

Queste direzioni potrebbero non solo migliorare le performance predittive, ma anche estendere l’applicabilità della nostra strategia DDB.

In conclusione, amici, quando valutiamo modelli per la predizione di legami, è imperativo selezionare meticolosamente la pipeline di valutazione. Il campionamento negativo casuale può introdurre bias, rendendo necessario un set di test indipendente per una stima accurata. Speriamo che le nostre scoperte stimolino l’attenzione della comunità bioinformatica e contribuiscano positivamente al progresso del campo. Lo sviluppo di metodi ML avanzati che possano catturare meglio le relazioni di interazione dalle feature molecolari intrinseche, eludendo l’influenza della topologia di rete, sarà fondamentale per migliorare l’accuratezza e l’applicabilità di questi modelli nella ricerca biologica reale.

Un piccolo dettaglio tecnico per i più curiosi: nel nostro studio, abbiamo definito il “grado della coppia” come la somma dei gradi dei due nodi nella coppia. Il DDB cerca di creare campioni negativi selezionando coppie di nodi la cui somma dei gradi combinati si avvicini molto a quella delle coppie positive reali. Se non si trova una corrispondenza esatta, l’algoritmo espande gradualmente la ricerca a gradi “vicini”. Abbiamo testato questo approccio su interazioni lncRNA-proteina, proteina-proteina e farmaco-bersaglio, usando dataset come NPInter, HURI, DrugBank, e modelli come Random Forest e reti neurali profonde (autoencoder + MLP, CNN, GCN).

Fonte: Springer