Cloud Intelligente: Addio Sovraccarichi con Apprendimento Federato e Ottimizzazione Coati

Ciao a tutti! Oggi voglio parlarvi di qualcosa che usiamo tutti i giorni, spesso senza nemmeno rendercene conto: il Cloud Computing (CC). Pensateci: le vostre foto, le serie TV in streaming, i documenti di lavoro condivisi… gran parte della nostra vita digitale passa da lì. Il cloud ci offre risorse virtualizzate (server, storage, reti) accessibili via internet, con una flessibilità e scalabilità impensabili fino a qualche anno fa. Fantastico, no?

Però, come in tutte le cose belle, c’è un “ma”. Gestire queste immense risorse non è una passeggiata, specialmente quando migliaia, o milioni, di utenti vi accedono contemporaneamente. Uno dei problemi più spinosi è il bilanciamento del carico (Load Balancing – LB). Immaginate una festa affollatissima: se tutti si accalcano all’ingresso, si crea il caos. Il LB fa un po’ da “buttafuori” intelligente: distribuisce il “traffico” (le richieste degli utenti, i calcoli da fare) in modo equilibrato tra i vari server disponibili. L’obiettivo? Evitare che qualche server scoppi per il troppo lavoro mentre altri se ne stanno lì a girarsi i pollici. Un buon bilanciamento significa prestazioni migliori, risposte più veloci e un utilizzo ottimale delle risorse.

La Sfida: Un Cloud Sempre Più Dinamico

Il vero problema è che il cloud è un ambiente incredibilmente dinamico. I carichi di lavoro cambiano continuamente, a volte in modo imprevedibile. I metodi tradizionali di LB, spesso basati su regole statiche, faticano a tenere il passo. È come cercare di dirigere il traffico di punta con un semaforo che ha solo tempi fissi: un disastro annunciato! Serve qualcosa di più intelligente, di più adattivo, capace di reagire in tempo reale ai cambiamenti della rete.

Inoltre, con la crescente preoccupazione per la privacy e la sicurezza dei dati, non possiamo semplicemente raccogliere tutte le informazioni in un unico posto per analizzarle. E qui entra in gioco la nostra idea.

La Nostra Proposta: Intelligenza Distribuita e Ottimizzazione Naturale

Abbiamo pensato: e se potessimo creare un sistema che non solo prevede in modo super accurato le risorse necessarie, ma lo fa rispettando la privacy dei dati e distribuendo il carico in modo ottimale usando un pizzico di… ispirazione dalla natura?

Ecco la nostra ricetta:

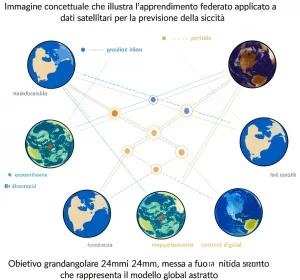

- Apprendimento Federato (Federated Learning – FL): Una tecnica di intelligenza artificiale che permette di allenare modelli su dati distribuiti (ad esempio, sui server locali) senza mai spostare i dati grezzi. Solo i “riassunti” dell’apprendimento (i parametri del modello) vengono condivisi e aggregati centralmente. Privacy garantita!

- Un Modello Predittivo Avanzato (DA-DBL): All’interno dell’apprendimento federato, usiamo un modello potente chiamato DA-DBL. È un mix di Reti Neurali Convoluzionali 1D Dilatate e basate sull’Attenzione (DA-1DCNN) e Reti Neurali Ricorrenti Bidirezionali a Memoria Lunga-Breve (Bi-LSTM). Sembra complicato, ma in pratica significa che il modello è bravissimo a capire quali informazioni sono importanti (grazie all’attenzione), a guardare al contesto più ampio (grazie alla dilatazione) e a considerare sia il passato che il futuro dei dati (grazie al Bi-LSTM) per prevedere con precisione le risorse necessarie (tempo di elaborazione, tempo di reazione, disponibilità).

- Ottimizzazione Ispirata ai Coati (RO-COA): Una volta previste le risorse, dobbiamo distribuire il carico. Qui usiamo un algoritmo di ottimizzazione chiamato RO-COA (Random Opposition Coati Optimization Algorithm). È una versione migliorata di un algoritmo (COA) che si ispira al comportamento dei coati (animaletti sudamericani simili a procioni) quando cacciano le iguane in gruppo. Il nostro “RO” aggiunge un meccanismo di “opposizione casuale” che rende la ricerca della soluzione ottimale ancora più efficiente e flessibile, adattandosi in tempo reale ai cambiamenti della rete.

Come Funziona il Tutto? Vi Spiego Meglio

Immaginate tanti “agenti intelligenti” (i nostri modelli locali di FL) che imparano continuamente dalle condizioni dei singoli server o gruppi di server, senza spifferare i dati sensibili. Questi agenti inviano le loro “scoperte” (aggiornamenti del modello DA-DBL) a un coordinatore centrale (che può anche essere distribuito e sicuro, magari usando la blockchain, come accennato nello studio).

Il coordinatore aggrega queste informazioni per creare un quadro globale e aggiornato delle esigenze della rete. A questo punto, entra in gioco il nostro “stratega”, l’algoritmo RO-COA. Basandosi sulle previsioni accurate del DA-DBL, RO-COA decide come distribuire i nuovi compiti o spostare quelli esistenti tra i server, proprio come i coati si coordinano per circondare la preda. L’obiettivo è trovare la configurazione migliore che minimizzi i tempi di attesa, massimizzi l’uso delle risorse, garantisca la qualità del servizio (QoS) e riduca il consumo energetico.

I Risultati? Parliamo di Numeri!

Bello sulla carta, direte voi, ma funziona davvero? Assolutamente sì! Abbiamo messo alla prova il nostro sistema confrontandolo con diversi approcci esistenti, sia per la parte di previsione che per quella di bilanciamento del carico. Abbiamo usato algoritmi noti come Tuna Swarm Optimization (TSO), Forest Optimization Algorithm (FOA), Cuckoo Search Algorithm (CSA) e persino la versione base del Coati Optimization Algorithm (COA). Per la previsione, abbiamo confrontato il nostro DA-DBL con modelli come CNN standard, 1DCNN e Bi-LSTM presi singolarmente.

I risultati sono stati entusiasmanti! Abbiamo misurato tutto il misurabile:

- Server Attivi: Il nostro metodo ne richiede meno per gestire lo stesso carico, riducendo sprechi e costi.

- Makespan: Il tempo totale per completare tutte le attività è significativamente inferiore. Meno attese per gli utenti!

- Qualità del Servizio (QoS): Migliorata grazie a una gestione più fluida e reattiva.

- Utilizzo delle Risorse: I server vengono sfruttati meglio, né troppo né troppo poco.

- Consumo Energetico: Bilanciare il carico in modo intelligente significa anche consumare meno energia, un vantaggio non da poco!

Ad esempio, analizzando la funzione di costo (un indicatore di quanto “lontana” è la soluzione dall’ottimo), il nostro RO-COA converge verso soluzioni migliori molto più rapidamente degli altri algoritmi. Anche nelle metriche di errore della previsione (come RMSE e MAE), il nostro DA-DBL ha mostrato una precisione superiore. In pratica, il nostro sistema combinato (RO-COA + DA-DBL con Apprendimento Federato) ha dimostrato di essere una soluzione robusta ed efficiente per la gestione delle risorse cloud.

Un Futuro Più Efficiente e Sicuro per il Cloud

Insomma, combinando l’intelligenza distribuita e rispettosa della privacy dell’apprendimento federato con modelli predittivi all’avanguardia e un’ottimizzazione ispirata alla natura (ma potenziata!), siamo riusciti a creare un meccanismo di bilanciamento del carico che fa davvero la differenza.

Questo approccio non solo migliora le prestazioni e l’affidabilità delle reti cloud, ma apre anche la strada a una gestione delle risorse più sostenibile ed economica. In un mondo sempre più dipendente dal cloud, soluzioni come questa sono fondamentali per garantire che tutto funzioni al meglio, senza intoppi e nel rispetto dei nostri dati. Un bel passo avanti, non trovate?

Fonte: Springer