Nuvole di Punti e Apprendimento Intelligente: Vi Svelo il Segreto del Mascheramento Parziale!

Ciao a tutti, appassionati di tecnologia e futuri innovatori! Oggi voglio portarvi con me in un viaggio affascinante nel mondo tridimensionale delle nuvole di punti e dell’apprendimento automatico. Preparatevi, perché stiamo per scoprire come rendere le macchine ancora più intelligenti, quasi come se avessero un sesto senso per la geometria!

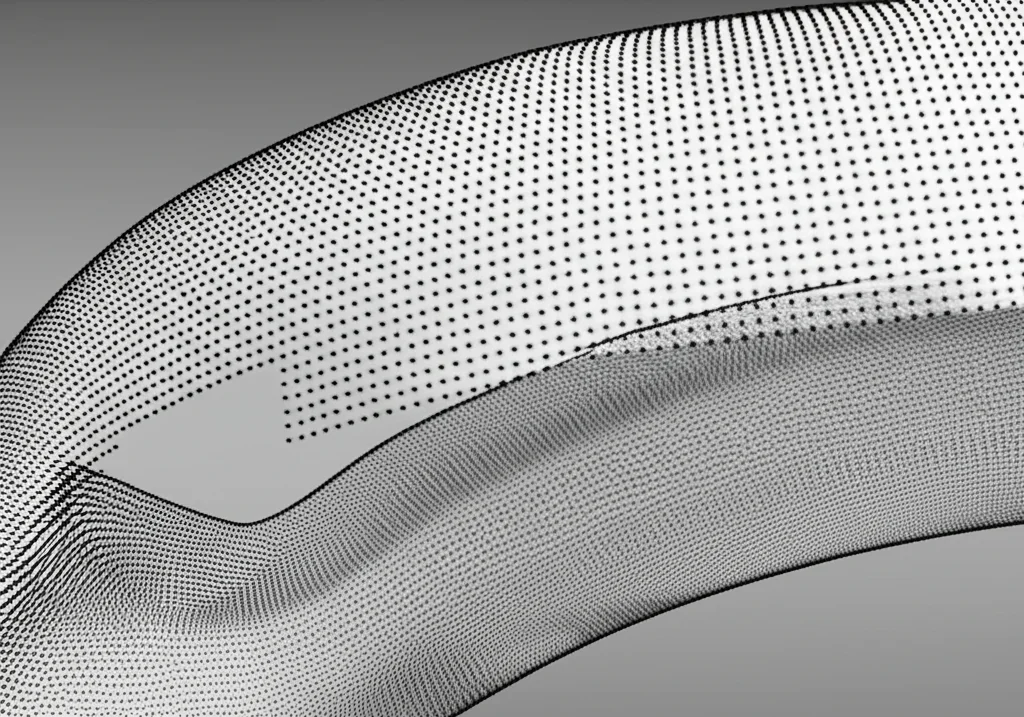

Avete presente le nuvole di punti? Sono insiemi di dati che rappresentano oggetti o ambienti in 3D. Pensate a come i sensori LiDAR delle auto a guida autonoma “vedono” il mondo, o a come possiamo digitalizzare oggetti reali per la realtà virtuale. Fantastico, vero? Però c’è un “ma”. Per insegnare a un computer a capire davvero cosa sta “vedendo” in queste nuvole di punti, tradizionalmente servono montagne di dati etichettati a mano. Un lavoro immenso, ve lo assicuro, e spesso costoso. Immaginate di dover dire a un computer, punto per punto, “questo è un pezzo di sedia”, “questo è un angolo di tavolo”… un’impresa titanica!

La Magia dell’Apprendimento Auto-Supervisionato

Qui entra in gioco l’apprendimento auto-supervisionato (o self-supervised learning, per gli amici anglofoni). È un po’ come insegnare a un bambino a riconoscere gli oggetti mostrandogliene tanti esempi, senza dirgli ogni volta “questa è una palla”. Il bambino, osservando, impara da solo le caratteristiche distintive. Allo stesso modo, l’apprendimento auto-supervisionato permette ai modelli di intelligenza artificiale di imparare rappresentazioni utili dei dati sfruttando la struttura intrinseca dei dati stessi, senza bisogno di etichette manuali. Una vera svolta, soprattutto per le nuvole di punti!

Tuttavia, le nuvole di punti hanno le loro bizze. Sono dati sparsi, a volte incompleti, ma incredibilmente ricchi di informazioni sulla forma e sulla struttura geometrica degli oggetti. Questa loro natura le rende più ostiche da “digerire” per l’apprendimento auto-supervisionato rispetto, ad esempio, alle immagini 2D, specialmente quando parliamo di apprendimento contrastivo.

L’apprendimento contrastivo è una tecnica furba: si insegna al modello a riconoscere cosa rende un oggetto simile a se stesso (magari visto da un’altra angolazione o con lievi modifiche) e diverso dagli altri. Si creano coppie “positive” (due versioni dello stesso oggetto) e “negative” (oggetti diversi). Il modello impara ad avvicinare le rappresentazioni delle coppie positive e ad allontanare quelle delle coppie negative. Semplice ed efficace, no?

Il Problema con le Nuvole di Punti e l’Approccio Tradizionale

Molti approcci recenti hanno provato ad applicare l’apprendimento contrastivo alle nuvole di punti usando semplici “aumentazioni” dei dati, come ruotare leggermente l’oggetto o aggiungere un po’ di rumore. Il problema? Queste modifiche spesso non sono abbastanza significative da creare delle vere “sfide” per il modello. La struttura geometrica di base dell’oggetto rimane pressoché invariata. È come mostrare a qualcuno la stessa foto con una luminosità leggermente diversa e pretendere che impari qualcosa di profondamente nuovo. Il risultato? Rappresentazioni apprese non ottimali.

Pensateci: se prendo una nuvola di punti di una tazza e la ruoto un po’, è sempre chiaramente una tazza. La sua essenza strutturale non cambia. Questo rende difficile per il modello capire veramente la geometria profonda, perché le coppie contrastive non sono poi così… contrastanti!

La Nostra Idea Rivoluzionaria: il “Partial Contrastive Learning”

Ed è qui che, con un pizzico di audacia e tanta ricerca, abbiamo pensato: e se, invece di limitarci a piccole modifiche, andassimo a “disturbare” la struttura geometrica in modo più incisivo? Nasce così il nostro approccio, che abbiamo battezzato Partial Contrastive Learning (Apprendimento Contrastivo Parziale).

L’idea di base è semplice ma potente: prendiamo un campione di nuvola di punti e ne creiamo due versioni. Su una di queste applichiamo una sorta di “maschera”, nascondendo una porzione della sua struttura. L’altra, invece, la lasciamo intatta, completa. Poi, chiediamo al nostro modello di confrontare queste due versioni: quella parziale e quella completa. È un po’ come chiedere al modello di “immaginare” la parte mancante, o meglio, di capire la struttura globale partendo da un’informazione incompleta. Confrontando le variazioni strutturali, il modello è spinto a codificare l’informazione geometrica in modo molto più profondo ed efficace nelle sue rappresentazioni auto-supervisionate. L’obiettivo è massimizzare la somiglianza tra le caratteristiche che esibiscono strutture simili, anche quando una è incompleta.

Questo paradigma, ispirato anche dai recenti progressi nel “masked image learning” (dove si mascherano porzioni di immagini), è simile ai compiti di ricostruzione delle nuvole di punti, ma con il “boost” dell’approccio contrastivo. Il modello non solo impara le somiglianze tra nuvole di punti della stessa classe, ma estrae anche informazioni strutturali interne cruciali.

Come Funziona nel Dettaglio?

Vi spiego brevemente il flusso. Prendiamo una nuvola di punti in input. Per prima cosa, applichiamo delle aumentazioni standard (rotazioni, traslazioni, scaling) per generare due nuvole di punti distinte ma correlate. Poi, il colpo di genio: una di queste nuvole aumentate viene ulteriormente processata applicando un mascheramento casuale a una sua porzione. Per farlo in modo intelligente, prima raggruppiamo i punti in “patch” (piccole zone) e poi mascheriamo alcune di queste patch. In questo modo, otteniamo una nuvola di punti con informazioni strutturali incomplete (la chiameremo (p_{m1}^i)) e l’altra che rimane completa ((p_{a2}^i)).

Queste due nuvole (la parziale e la completa) vengono poi date in pasto a due reti neurali: un estrattore di caratteristiche (encoder) e un estrattore di caratteristiche “momentum” (che si aggiorna più lentamente, per stabilizzare l’apprendimento, un trucchetto preso da metodi come MoCo). Le caratteristiche estratte vengono poi proiettate in uno spazio normalizzato dove avviene il vero e proprio apprendimento contrastivo, utilizzando una funzione di perdita chiamata InfoNCE, che incoraggia il modello ad avvicinare le rappresentazioni della nuvola parziale e di quella completa (che derivano dallo stesso oggetto originale) e ad allontanarle da quelle di altri oggetti.

Per essere ancora più robusti, applichiamo anche una perdita contrastiva simmetrica: una volta mascheriamo la prima nuvola e la confrontiamo con la seconda completa, e un’altra volta mascheriamo la seconda e la confrontiamo con la prima completa. La perdita finale è la somma di queste due.

I Risultati Parlano da Soli!

Abbiamo messo alla prova il nostro metodo pre-addestrandolo sul dataset ShapeNet (una vasta collezione di modelli 3D sintetici) e poi valutando la sua capacità di trasferire quanto appreso su compiti specifici come la classificazione di forme, la segmentazione di parti di oggetti e la classificazione “few-shot” (cioè con pochissimi esempi per categoria). I dataset usati per la valutazione includono ModelNet40, ShapeNetPart e ScanObjectNN (quest’ultimo particolarmente interessante perché contiene scansioni di oggetti reali, con tutte le imperfezioni del caso).

Ebbene, i risultati sono stati entusiasmanti! Il nostro metodo ha raggiunto un’accuratezza del 90.94% nella classificazione con SVM lineare usando solo l’addestramento contrastivo, superando metodi precedenti come ToThePoint dello 0.91% (e addirittura dell’1.72% secondo una metrica più specifica citata nel paper originale). Ma non solo: abbiamo dimostrato prestazioni superiori anche nella segmentazione e nella classificazione few-shot rispetto a Point-BERT, un altro pezzo da novanta nel campo.

Abbiamo anche condotto esperimenti di “ablazione” per capire cosa rendesse il nostro metodo così efficace. Ad esempio, abbiamo confrontato tre scenari: confrontare completo con completo (“c-c”), parziale con parziale (“p-p”) e il nostro approccio, parziale con completo (“p-c”). Indovinate un po’? “p-c” ha stravinto, superando “c-c” del 15.34% e “p-p” del 7.31% nell’accuratezza SVM lineare. Questo dimostra che la discrepanza geometrica introdotta dal mascheramento parziale è cruciale per un apprendimento efficace. Curiosamente, “c-c” (completo con completo) ha dato risultati molto peggiori, suggerendo che confrontare strutture complete identiche (a parte le aumentazioni standard) non fornisce abbastanza “sfida” al modello.

Anche la visualizzazione t-SNE delle caratteristiche apprese (una tecnica per visualizzare dati ad alta dimensionalità in 2D o 3D) ha mostrato che solo il nostro approccio “p-c” produceva pattern chiaramente discriminativi tra le diverse classi di oggetti. Un’ulteriore conferma della bontà della nostra intuizione!

Abbiamo anche investigato l’impatto del “tasso di mascheramento” (quanta parte della nuvola nascondere). Abbiamo scoperto che un tasso di mascheramento troppo alto (es. 80%) riduce le prestazioni, mentre un valore intorno al 50% sembra essere ottimale. Trovare il giusto equilibrio è fondamentale!

Cosa Significa Tutto Questo?

I nostri contributi principali sono chiari:

- Abbiamo proposto un metodo di apprendimento di rappresentazioni auto-supervisionate per nuvole di punti che si basa sul confronto tra strutture complete e parziali. A differenza di molti metodi esistenti che si affidano solo ad aumentazioni dei dati o al confronto tra patch, il nostro approccio spinge il modello a comprendere la struttura geometrica 3D in modo più profondo.

- I risultati sperimentali dimostrano che il nostro metodo migliora significativamente la capacità di rappresentazione delle caratteristiche delle nuvole di punti sui principali dataset di benchmark e mostra una migliore generalizzazione nei task a valle.

In sostanza, abbiamo trovato un modo più efficace per far sì che i computer “capiscano” la forma degli oggetti 3D imparando da soli, semplicemente osservando esempi parziali e completi. Questo non solo migliora la capacità del modello di catturare caratteristiche locali e globali, ma ne aumenta anche la capacità di generalizzazione.

Guardando al Futuro

Siamo convinti che questo approccio del “Partial Contrastive Learning” apra nuove ed entusiasmanti prospettive. Immaginate le applicazioni: robotica più intelligente, sistemi di riconoscimento 3D più accurati, una migliore comprensione di scene complesse in guida autonoma, e chi più ne ha più ne metta. Riducendo la dipendenza da enormi quantità di dati etichettati, possiamo accelerare lo sviluppo di IA capaci di interagire e comprendere il nostro mondo tridimensionale in modi sempre più sofisticati.

È un campo in continua evoluzione, e noi siamo entusiasti di aver dato il nostro contributo. Chissà quali altre scoperte ci riserva il futuro dell’apprendimento auto-supervisionato per le nuvole di punti! Io, di certo, non vedo l’ora di scoprirlo.

Fonte: Springer