Farmaci Innovativi e Confronti Indiretti: Come Smascherare i “Fantasmi” nei Dati Quando i Rischi Non Giocano Secondo le Regole

Ciao a tutti! Oggi voglio parlarvi di una sfida affascinante e cruciale nel mondo della ricerca medica, soprattutto quando si tratta di valutare l’efficacia di nuove terapie. Immaginate: abbiamo un farmaco promettente, ma per ragioni etiche o logistiche non possiamo fare un classico studio randomizzato controllato (RCT), il “gold standard” per capirci. Che si fa? Spesso ci si affida ai cosiddetti confronti indiretti tra trattamenti (ITC), dove mettiamo a confronto i dati del nostro nuovo farmaco (magari da uno studio a braccio singolo) con dati esterni, come quelli di studi storici o cartelle cliniche elettroniche. Utile, vero? Ma c’è un “però” grande come una casa.

Il Problema dei “Fattori Nascosti” (Unmeasured Confounding)

Quando non c’è randomizzazione, il rischio di bias da confondimento è dietro l’angolo. Cosa significa? Semplice: ci potrebbero essere delle caratteristiche dei pazienti (i “confounder”) che influenzano sia la scelta del trattamento sia l’esito della malattia. Se questi fattori li conosciamo e li misuriamo, possiamo “aggiustare” le nostre analisi statistiche. Ma il vero incubo sono i confounder non misurati: quei fattori che ci sfuggono, che non abbiamo raccolto nei dati, ma che possono distorcere pesantemente i risultati, facendoci credere che un farmaco sia più o meno efficace di quanto non sia in realtà.

Per cercare di capire quanto questi “fantasmi” possano influenzare le nostre conclusioni, usiamo la Quantitative Bias Analysis (QBA). È una specie di “stress test” per i nostri risultati: ci aiuta a capire quanto dovrebbe essere forte un confounder non misurato per ribaltare le conclusioni dello studio. Se scopriamo che servirebbe un confounder con caratteristiche improbabili, allora possiamo dormire sonni più tranquilli.

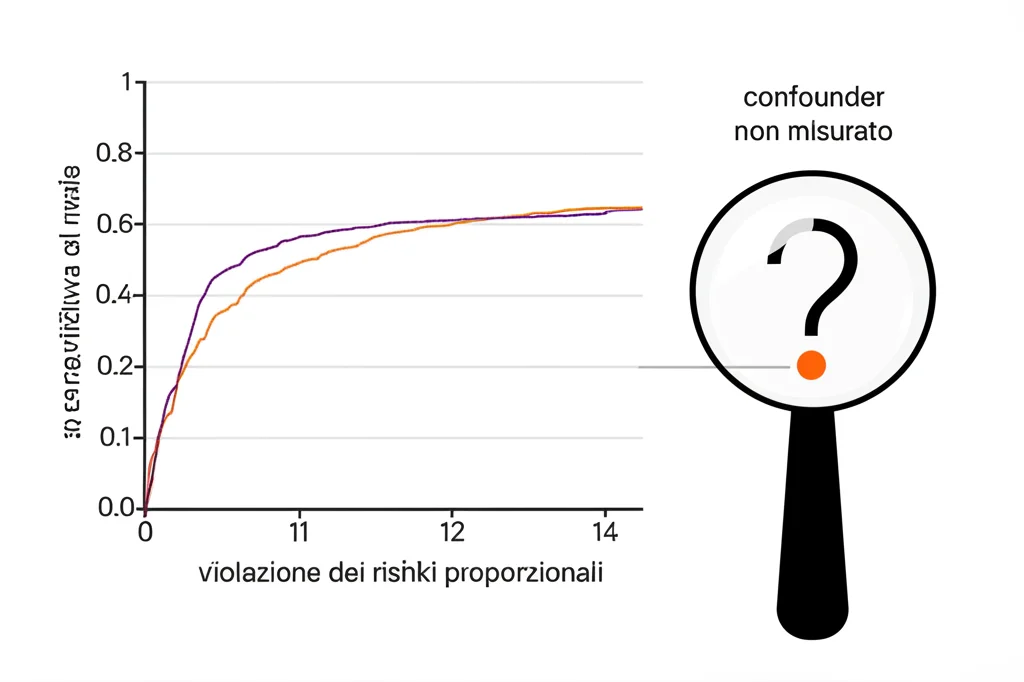

E se i Rischi Non Sono Proporzionali? La Sfida della “PH Violation”

Molti studi, specialmente in oncologia, valutano esiti come il “tempo alla progressione della malattia” o la sopravvivenza. Spesso, per analizzare questi dati, si assume che l’effetto del trattamento sia costante nel tempo (la cosiddetta assunzione dei rischi proporzionali o PH assumption). Ma la realtà è testarda: soprattutto con terapie innovative come le immunoterapie, questa assunzione viene spesso violata. L’effetto di un farmaco potrebbe manifestarsi solo dopo un certo tempo, o svanire. E qui casca l’asino: molte tecniche di QBA tradizionali non funzionano bene se c’è questa violazione dei rischi proporzionali (PH violation).

Ecco perché nel nostro lavoro ci siamo concentrati su questo problema. Come possiamo fare una QBA affidabile quando i rischi non sono proporzionali e ci sono potenziali confounder non misurati? La risposta che abbiamo esplorato si basa su una misura chiamata differenza nel tempo di sopravvivenza medio ristretto (dRMST). Il dRMST è un modo figo per confrontare la sopravvivenza media tra gruppi fino a un certo punto nel tempo, e ha il vantaggio di essere valido anche se l’assunzione PH non regge.

La Nostra Proposta: Un Framework di QBA Flessibile Basato sulla Simulazione

Abbiamo sviluppato un framework di QBA basato sulla simulazione che è pensato proprio per queste situazioni complicate. L’idea di base è trattare il confounder non misurato come un dato mancante. E come si gestiscono i dati mancanti? Con l’imputazione multipla! Nello specifico, usiamo un approccio bayesiano chiamato Bayesian data augmentation. In pratica, “inventiamo” i valori del confounder non misurato basandoci su alcune caratteristiche che noi stessi specifichiamo (quanto è associato al trattamento? quanto all’esito?).

Il processo si svolge in due fasi principali:

- Fase 1: Imputazione del Confounder. Usando la Bayesian data augmentation, generiamo multipli set di dati “completi”, ognuno con valori plausibili per il nostro ipotetico confounder non misurato. Questo processo tiene conto delle associazioni che abbiamo ipotizzato tra il confounder, il trattamento e l’esito.

- Fase 2: Analisi Aggiustata. Per ogni set di dati imputato, calcoliamo il dRMST aggiustato, ad esempio usando tecniche di ponderazione come l’Inverse Probability of Treatment (IPT) weighting. Poi, combiniamo i risultati di tutte queste analisi per ottenere una stima complessiva e il suo intervallo di confidenza, tenendo conto dell’incertezza dovuta all’imputazione.

Iterando questo processo per diverse combinazioni di caratteristiche del confounder (cioè, diverse “forze” di associazione con trattamento ed esito), possiamo fare una tipping point analysis: identifichiamo quali caratteristiche dovrebbe avere un confounder non misurato per rendere non significativi i risultati del nostro studio.

Messo alla Prova: Simulazioni e un Caso Reale

Per essere sicuri che il nostro metodo funzionasse, l’abbiamo testato prima con dati simulati. Abbiamo creato scenari in cui sapevamo esattamente qual era il vero effetto del trattamento e l’impatto di un confounder, anche in condizioni di PH violation (ad esempio, un effetto ritardato del trattamento). I risultati sono stati incoraggianti: il nostro metodo di aggiustamento basato sull’imputazione è riuscito a stimare il vero dRMST aggiustato con un bias minimo, in modo comparabile a quando il confounder era effettivamente misurato. Certo, c’era un po’ più di incertezza (intervalli di confidenza più ampi), il che è normale quando si imputano dati.

Poi, siamo passati a un caso reale: uno studio sull’immunoterapia CAR-T brexucabtagene autoleucel contro terapie standard in pazienti con leucemia linfoblastica acuta (lo studio ZUMA/SCHOLAR-3). Questo studio mostrava una chiara violazione dell’assunzione PH. Applicando il nostro framework QBA, abbiamo potuto esplorare la sensibilità delle conclusioni dello studio alla presenza di un confounder non misurato. Abbiamo identificato le combinazioni di “forza” del confounder (in termini di associazione con il trattamento, misurata come Odds Ratio, OR, e con l’esito, misurata come Hazard Ratio, HR) che avrebbero annullato la significatività dei risultati. Ad esempio, abbiamo visto che per rendere non significativo il dRMST, un confounder non misurato avrebbe dovuto diminuire la mortalità di almeno il 33% (HR ≤ 0.67) con un OR per l’esposizione al trattamento superiore a 1.22, oppure aumentare la mortalità di almeno il 50% (HR ≥ 1.50) con un OR inferiore a 0.82.

La parte cruciale, poi, è valutare la plausibilità di tali associazioni. Un confounder così potente sarebbe potuto passare inosservato? Spesso si confrontano queste soglie con le associazioni osservate per i confounder noti e misurati. Se le associazioni richieste per ribaltare i risultati sono molto più grandi di quelle dei confounder noti, allora lo studio è probabilmente robusto.

Perché Questo Approccio è Utile?

Il nostro framework offre diversi vantaggi. Innanzitutto, è valido anche in presenza di violazione dei rischi proporzionali, un problema sempre più comune. Poi, essendo basato sulla simulazione e sull’approccio bayesiano per l’imputazione, è molto flessibile: possiamo specificare modelli di outcome e di propensione al trattamento complessi, e diverse forme per il confounder non misurato. La trasparenza è un altro punto di forza: modelliamo esplicitamente le assunzioni sul confondimento, rendendole più facili da valutare. E i risultati sono interpretabili, perché riportiamo le associazioni identificate usando misure familiari come HR e OR.

Certo, ci sono delle limitazioni. Il metodo richiede una certa competenza statistica per essere implementato correttamente. Se i modelli di outcome o di propensione sono specificati male, le imputazioni possono essere inaccurate. E, come per tutte le analisi di sensibilità, l’interpretazione dei risultati – soprattutto la plausibilità delle soglie identificate – richiede un’attenta considerazione del contesto clinico.

Conclusioni e Implicazioni

Nonostante le incertezze, i confronti indiretti tra trattamenti sono sempre più utilizzati per prendere decisioni regolatorie e di rimborsabilità. Per questo, è fondamentale disporre di strumenti di analisi di sensibilità e di QBA che siano adatti agli scenari complessi che si incontrano nella pratica, come la violazione dei rischi proporzionali. Il framework che abbiamo proposto va in questa direzione, offrendo un metodo robusto e flessibile per valutare l’impatto potenziale del confondimento non misurato. Speriamo che questo contribuisca a ridurre l’incertezza nel processo decisionale e a garantire che i pazienti ricevano le terapie più efficaci. È un piccolo passo, ma crediamo importante, per rendere l’evidenza derivata da dati non randomizzati sempre più affidabile e utile!

Fonte: Springer