Droni o Uccelli? L’AI che Impara dai Falchi per Vederci Chiaro!

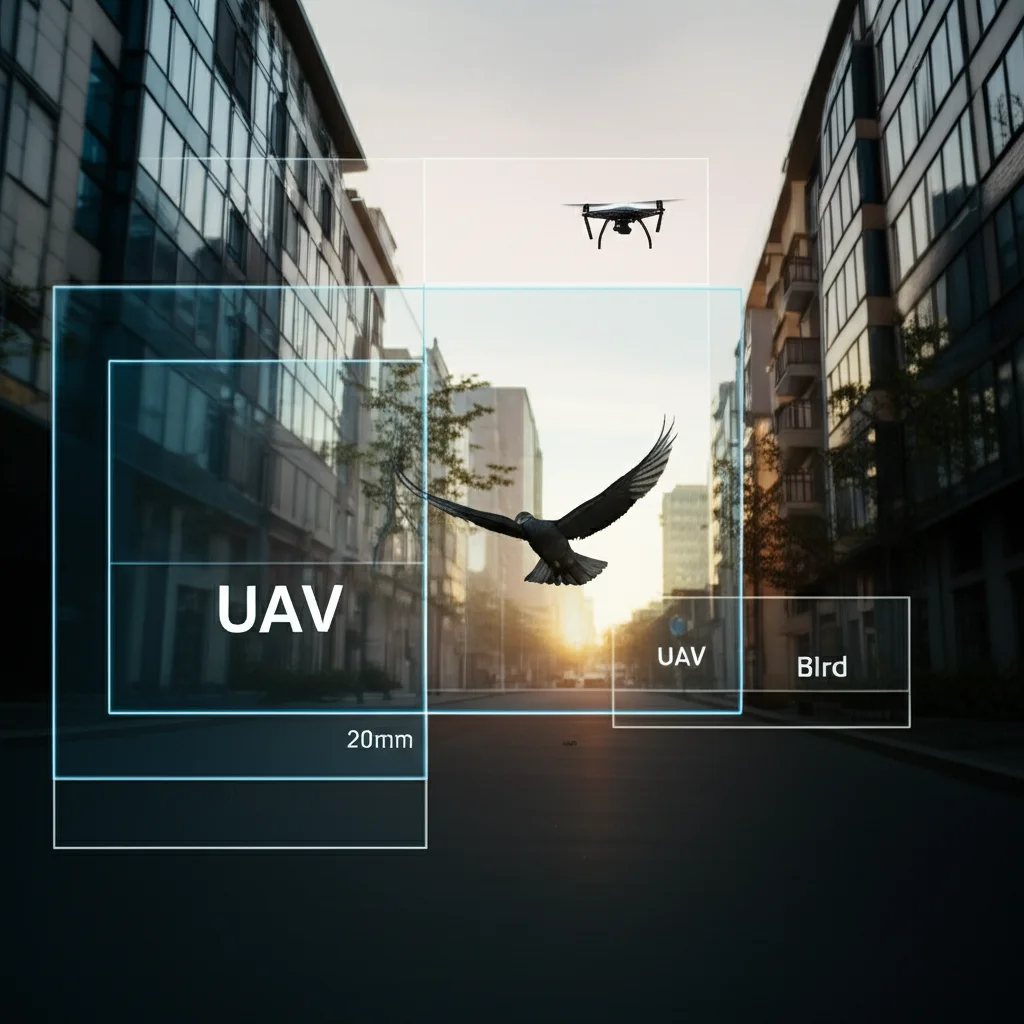

Ciao a tutti! Sono qui per parlarvi di una sfida tecnologica che sta diventando sempre più attuale: distinguere un drone da un uccello. Sembra facile, vero? Eppure, vi assicuro che per i sistemi di rilevamento automatico, specialmente in zone critiche come gli aeroporti, è un bel grattacapo. L’aumento esponenziale dei droni (o UAV, Unmanned Aerial Vehicles) nei nostri cieli porta con sé tante opportunità, ma anche nuove preoccupazioni, soprattutto per la sicurezza aerea e la protezione della fauna selvatica. Immaginate un sistema radar o una telecamera che lancia un allarme per uno stormo di gabbiani scambiandoli per droni ostili, o peggio, che non rileva un drone non autorizzato perché lo confonde con un volatile innocuo. Ecco, questo è il tipo di problemi che vogliamo risolvere. E come? Prendendo ispirazione da chi, in natura, ha una vista eccezionale: i rapaci!

Il Problema: Ali o Eliche?

La questione fondamentale è che droni e uccelli, specialmente a distanza, possono avere dimensioni simili e traiettorie di volo che si sovrappongono. Entrambi possono apparire come piccoli oggetti in rapido movimento nel cielo. I sistemi di rilevamento tradizionali, spesso basati su radar o semplici telecamere, faticano a cogliere le sottili differenze. I droni hanno rotori che girano velocemente, mentre gli uccelli sbattono le ali con un ritmo specifico. I droni possono avere movimenti più erratici e veloci, ma anche gli uccelli possono compiere manovre improvvise. Questa somiglianza porta a due grossi problemi:

- Falsi positivi: Il sistema rileva un uccello e lo segnala come drone, causando allarmi inutili e potenzialmente costosi (pensate a un aeroporto che blocca le operazioni per un falso allarme).

- Mancati rilevamenti (falsi negativi): Il sistema non riconosce un drone, scambiandolo per un uccello, con ovvi rischi per la sicurezza.

Negli ultimi anni, l’intelligenza artificiale (AI) e il deep learning (DL) hanno fatto passi da gigante nel riconoscimento di oggetti, ma anche le reti neurali convoluzionali (CNN) standard, pur bravissime a classificare immagini statiche, mostrano i loro limiti quando si tratta di distinguere oggetti basandosi sul loro movimento specifico. Serviva qualcosa di più.

L’Ispirazione: Occhi di Falco

E se potessimo insegnare a un’AI a “vedere” il movimento come fanno i maestri del cielo, tipo i falchi? Questi uccelli hanno sistemi visivi incredibilmente sofisticati, capaci di tracciare prede piccole e veloci con una precisione sbalorditiva. Si adattano dinamicamente, focalizzando l’attenzione sui dettagli cruciali del movimento. Questa idea non è campata in aria: diversi studi recenti hanno iniziato a esplorare modelli bio-ispirati, cercando di replicare alcuni principi della visione biologica nei sistemi artificiali. Hanno dimostrato che considerare le caratteristiche spazio-temporali (come l’oggetto appare e come si muove nel tempo) è fondamentale. Modelli che usano reti 3D CNN, meccanismi di attenzione, o fondono dati da sensori diversi (visivi e radar) hanno già mostrato miglioramenti significativi. Ma sentivamo che si poteva fare ancora di più, integrando in modo più profondo questa ispirazione biologica.

La Nostra Creazione: Ecco STBRNN!

Partendo da queste premesse, abbiamo sviluppato un nuovo modello di deep learning che abbiamo chiamato STBRNN (Spatiotemporal Bio-Response Neural Network). Lo so, il nome è un po’ tecnico, ma l’idea di base è affascinante. È un sistema progettato specificamente per migliorare la differenziazione tra UAV e uccelli in tempo reale, ispirandosi proprio alla visione dei rapaci.

Il nostro STBRNN si basa su tre componenti principali che lavorano in sinergia:

- Bio-CNN (Bio-Inspired Convolutional Neural Network): Questa è la parte che analizza le immagini, fotogramma per fotogramma. Ma non è una CNN qualunque! Ispirandosi alla visione foveale dei rapaci, è in grado di adattare dinamicamente il suo “campo visivo” (receptive field). Se l’oggetto si muove velocemente, il campo si allarga per non perderlo; se si muove lentamente, si restringe per cogliere dettagli più fini. Inoltre, usa meccanismi di attenzione spaziale per concentrarsi sulle aree dell’immagine dove avviene il movimento più significativo.

- GRU (Gated Recurrent Units): Questa componente si occupa dell’analisi temporale. Le GRU sono un tipo di rete neurale ricorrente molto efficiente nel catturare le dinamiche di movimento attraverso sequenze di fotogrammi. In pratica, “ricordano” come si muoveva l’oggetto nei momenti precedenti e usano questa informazione per capire pattern come il battito d’ali ritmico di un uccello o la rotazione costante delle eliche di un drone. Abbiamo anche introdotto un meccanismo che regola queste GRU in base alla velocità stimata dell’oggetto, rendendole ancora più adattive.

- Bio-Response Layer (Strato di Bio-Risposta): Questa è la vera novità, il cuore bio-ispirato del nostro modello! Questo strato imita i meccanismi di feedback adattivo presenti nei sistemi biologici. In pratica, modula l’attenzione del modello (sia spaziale che temporale) basandosi su tre fattori cruciali calcolati in tempo reale:

- Intensità del movimento: Quanto velocemente si sta spostando l’oggetto?

- Prossimità dell’oggetto: Quanto è grande (e quindi probabilmente vicino) l’oggetto nell’immagine?

- Consistenza della velocità: Il movimento è fluido e costante o erratico e con scatti improvvisi?

Combinando queste informazioni, il Bio-Response Layer permette al modello di focalizzarsi dinamicamente sugli indizi più rilevanti per distinguere un drone da un uccello in quella specifica situazione.

Alla Prova dei Fatti: I Risultati Parlano Chiaro

Ovviamente, non basta avere una bella idea, bisogna dimostrare che funziona! Abbiamo addestrato e testato il nostro STBRNN utilizzando un ampio dataset di immagini e video etichettati contenenti droni e uccelli in diverse condizioni ambientali e di illuminazione (formattato secondo le specifiche YOLOv7, uno standard nel campo). Poi, abbiamo confrontato le sue prestazioni con cinque modelli di rilevamento oggetti considerati allo stato dell’arte: YOLOv5, Faster R-CNN, SSD, RetinaNet e R-FCN.

I risultati sono stati davvero incoraggianti! Il nostro STBRNN ha superato tutti gli altri modelli su diverse metriche chiave:

- Precisione (Precision): 0.984 – Questo significa che quando il nostro modello dice “è un drone” (o “è un uccello”), ha ragione nel 98.4% dei casi. Pochissimi falsi allarmi!

- Richiamo (Recall): 0.964 – Questo indica che il modello riesce a identificare correttamente il 96.4% di tutti i droni e uccelli effettivamente presenti. Non se ne lascia scappare quasi nessuno!

- F1 Score: 0.974 – Questa metrica combina precisione e richiamo, dando un’idea dell’equilibrio generale del modello. Un punteggio così alto conferma l’ottima performance complessiva.

- Intersection over Union (IoU): 0.96 – Misura quanto accuratamente il modello disegna il riquadro attorno all’oggetto rilevato. Un IoU elevato significa localizzazione molto precisa.

Inoltre, un aspetto fondamentale per le applicazioni pratiche è la velocità. STBRNN riesce ad analizzare un fotogramma in soli 45 millisecondi, rendendolo perfettamente adatto per applicazioni in tempo reale. La matrice di confusione ha confermato questi dati, mostrando un numero molto basso di falsi positivi e falsi negativi rispetto ai concorrenti.

Non Solo Basi: Test Avanzati

Per essere sicuri della robustezza del nostro STBRNN, non ci siamo fermati ai test standard. Lo abbiamo messo alla prova in scenari più complessi:

- Formazioni e Stormi: Abbiamo testato la sua capacità di rilevare droni che volano in formazione (sciami) e uccelli in stormo. Ha mantenuto alte prestazioni, anche se la precisione cala leggermente quando gli oggetti sono molto vicini tra loro.

- Piccoli Oggetti: Rilevare oggetti piccoli e distanti è sempre una sfida. STBRNN si è dimostrato superiore ai concorrenti anche in questo, sebbene le prestazioni diminuiscano un po’ con oggetti sotto i 20×20 pixel.

- Generalizzazione: Lo abbiamo testato su un dataset completamente nuovo (Anti-UAV Dataset) che non aveva mai visto prima, con ambienti e condizioni diverse. Ha mantenuto un’ottima accuratezza (oltre il 91%), dimostrando di sapersi adattare.

- Confronto con Nuovi Modelli: Lo abbiamo confrontato anche con modelli ancora più recenti (YOLOv11, YOLOv12, RT-DETR), rimanendo competitivo in termini di accuratezza e velocità.

- Condizioni Avverse: Abbiamo simulato condizioni difficili come scarsa illuminazione, oggetti parzialmente nascosti (occlusioni) e rumore nel sensore (come da telecamere di bassa qualità). STBRNN si è dimostrato abbastanza robusto, specialmente in condizioni di scarsa luce, grazie al suo focus sul movimento. Le occlusioni e il forte rumore rimangono le sfide maggiori.

Abbiamo anche condotto uno studio di “ablazione”, cioè abbiamo provato a togliere o sostituire le componenti chiave del nostro modello (Bio-CNN, GRU, Bio-Response Layer) per vedere quanto ciascuna contribuisse al risultato finale. Questo ha confermato che ogni parte, e in particolare l’innovativo Bio-Response Layer, gioca un ruolo cruciale nel raggiungere le prestazioni elevate osservate.

Perché è Importante? Le Applicazioni Pratiche

Un sistema come STBRNN, capace di distinguere droni e uccelli in modo affidabile e veloce, ha implicazioni enormi. Pensiamo alla sicurezza degli aeroporti, dove un rilevamento accurato può prevenire collisioni pericolose (bird strikes o drone strikes). Oppure alla protezione di aree sensibili (infrastrutture critiche, eventi pubblici) da intrusioni di droni non autorizzati, riducendo al contempo i falsi allarmi causati dalla fauna locale. Anche nel monitoraggio ambientale e nella protezione della fauna selvatica, poter distinguere automaticamente i droni usati per la ricerca dagli animali stessi è fondamentale.

Uno Sguardo al Futuro

Siamo molto soddisfatti dei risultati ottenuti con STBRNN, ma la ricerca non si ferma mai. Ci sono ancora margini di miglioramento. Ad esempio, potremmo lavorare per ridurre ulteriormente il tempo di inferenza per applicazioni che richiedono velocità estreme. Un’altra direzione interessante è quella di integrare dati provenienti da altri sensori, come radar o infrarossi (fusione multi-modale), per migliorare ulteriormente l’affidabilità in condizioni particolarmente difficili (nebbia, notte fonda, occlusioni totali) dove la sola visione potrebbe non bastare. Stiamo anche pensando a tecniche di “domain adaptation” per rendere il modello ancora più generalizzabile a qualsiasi ambiente senza bisogno di riaddestramento specifico.

Insomma, la sfida di distinguere droni e uccelli è complessa, ma guardando alla natura e combinando queste intuizioni con le potenzialità del deep learning, stiamo facendo passi da gigante. È affascinante vedere come l’osservazione del mondo biologico possa ispirare soluzioni tecnologiche così avanzate!

Fonte: Springer